一文了解11種最常見的機器學習算法應用場景 精華

近年來,機器學習的普及率急劇上升。機器學習從數據中創造價值的潛力使其對許多不同行業的企業都具有吸引力。大多數機器學習產品都是使用現成的機器學習算法設計和實現的,并進行了一些調整和微小的改動。

機器學習算法種類繁多,可分為三大類:

- 監督學習算法在給定一組觀察值的情況下對特征(自變量)和標簽(目標)之間的關系進行建模。然后該模型用于使用這些特征預測新觀察的標簽。根據目標變量的特性,它可以是分類(離散目標變量)或回歸(連續目標變量)任務。

- 無監督學習算法試圖在未標記的數據中找到數據規律。

- 強化學習基于行動獎勵原則。代理通過迭代計算其行為的獎勵來學習達到目標。

在這篇文章中,我將介紹前兩類中最常見的算法。具體11種算法如下:

- 線性回歸

- 支持向量機(SVM)

- 樸素貝葉斯

- 邏輯回歸

- k最近鄰(KNN)

- 決策樹

- 隨機森林

- 梯度提升樹(GBDT)

- K-Means

- 層次聚類

- DBSCAN聚類

- 主成分分析(PCA)

1. 線性回歸

線性回歸是一種監督學習算法,它試圖通過對數據擬合線性方程來模擬連續目標變量與一個或多個自變量之間的關系。

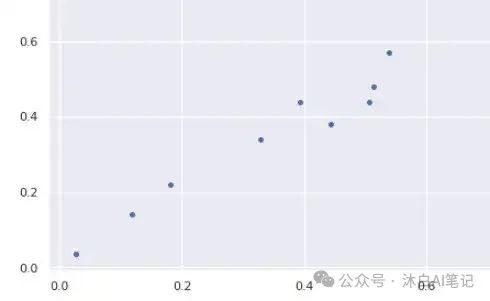

為了使線性回歸成為一個好的選擇,自變量和目標變量之間需要存在線性關系。有許多工具可以探索變量之間的關系,例如散點圖和相關矩陣。例如,下面的散點圖顯示了自變量(x 軸)和因變量(y 軸)之間的正相關關系。隨著一個增加,另一個也增加。

線性回歸模型試圖將回歸線擬合到最能代表關系或相關性的數據點。最常用的技術是普通最小二乘法(OLE)。使用此方法,通過最小化數據點與回歸線之間距離的平方和來找到最佳回歸線。對于上面的數據點,使用 OLE 獲得的回歸線如下所示:

2.支持向量機

支持向量機 (SVM) 是一種監督學習算法,主要用于分類任務,但也適用于回歸任務。

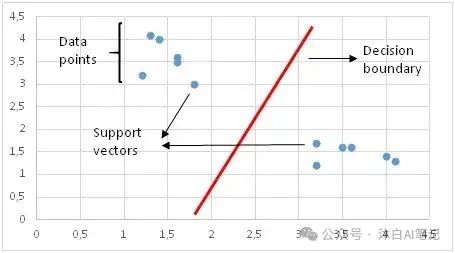

SVM 通過繪制決策邊界來區分類別。 如何繪制或確定決策邊界是支持向量機算法中最關鍵的部分。在創建決策邊界之前,每個觀察值(或數據點)都繪制在 n 維空間中。“n”是使用的特征數。例如,如果我們使用“長度”和“寬度”對不同的“細胞”進行分類,則觀察結果繪制在二維空間中,決策邊界是一條線。如果我們使用 3 個特征,則決策邊界是 3 維空間中的一個平面。如果我們使用超過 3 個特征,決策邊界就會變成一個很難可視化的超平面。

決策邊界以支持向量的距離最大化的方式繪制。 如果決策邊界太靠近支持向量,它將對噪聲高度敏感并且不能很好地泛化。自變量即使非常小的變化也可能導致錯誤分類。

數據點并不總是像上圖那樣線性可分。在這些情況下,支持向量機使用內核技巧來測量高維空間中數據點的相似性(或接近度),以使它們線性可分。

核函數是一種相似性度量。輸入是原始特征,輸出是新特征空間中的相似性度量。這里的相似意味著某種程度的接近。將數據點實際轉換到高維特征空間是一項代價高昂的操作。該算法實際上并沒有將數據點轉換到一個新的高維特征空間。核化 SVM 根據高維特征空間中的相似性度量計算決策邊界,而無需實際進行轉換。我認為這就是為什么它也被稱為kernel trick的原因。

SVM在維數多于樣本數的情況下特別有效。在尋找決策邊界時,SVM 使用訓練點的子集而不是所有點,這使得它具有內存效率。另一方面,大型數據集的訓練時間會增加,這會對性能產生負面影響。

3.樸素貝葉斯

樸素貝葉斯是一種用于分類任務的監督學習算法。 因此,它也被稱為樸素貝葉斯分類器。

樸素貝葉斯假設特征相互獨立,特征之間不存在相關性。然而,現實生活中并非如此。這種特征不相關的樸素假設是該算法被稱為“樸素”的原因。

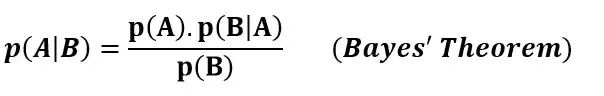

樸素貝葉斯算法背后的直覺是貝葉斯定理:

p(A|B):事件 A 給定事件 B 已經發生的概率

p(B|A):給定事件 A 已經發生的事件 B 的概率

p(A):事件 A 的概率

p(B):事件 B 的概率

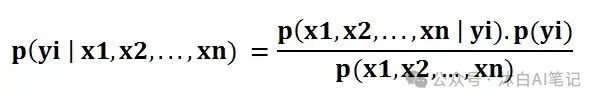

樸素貝葉斯分類器計算給定一組特征值(即 p(yi | x1, x2 , … , xn))的類的概率。 將其輸入貝葉斯定理:

p(x1, x2 , … , xn | yi) 表示給定類別標簽的特定特征組合(數據集中的觀察/行)的概率。我們需要非常大的數據集來估計所有不同特征值組合的概率分布。為了克服這個問題,樸素貝葉斯算法假設所有特征都是相互獨立的。 此外,可以刪除分母 (p(x1,x2, … , xn)) 以簡化等式,因為它僅歸一化給定觀察值的類的條件概率值 ( p(yi | x1,x2, … , xn) ).

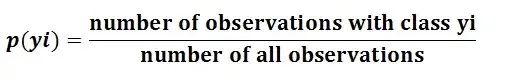

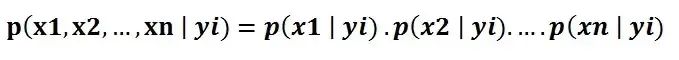

類別的概率 ( p(yi) ) 計算起來非常簡單:

在特征獨立的假設下,p(x1, x2 , … , xn | yi) 可以寫成:

給定類標簽(即 p(x1 | yi) )的單個特征的條件概率可以更容易地從數據中估計。該算法需要獨立存儲每個類別的特征概率分布。例如,如果有 5 個類別和 10 個特征,則需要存儲 50 個不同的概率分布。

將所有這些加起來,對于樸素貝葉斯算法來說,計算觀察給定特征值的類的概率成為一項簡單的任務(p(yi | x1,x2,...,xn))

所有特征都是獨立的假設使得樸素貝葉斯算法與復雜算法相比非常快。 在某些情況下,速度比更高的精度更受歡迎。另一方面,同樣的假設使得樸素貝葉斯算法不如復雜算法準確。速度是有代價的!

4.邏輯回歸

邏輯回歸是一種監督學習算法,主要用于二元 分類問題。雖然“回歸”與“分類”相矛盾,但這里的重點是“邏輯”一詞,指的是在該算法中執行分類任務的邏輯函數。 邏輯回歸是一種簡單但非常有效的分類算法,因此常用于許多二元分類任務。客戶流失、垃圾郵件、網站或廣告點擊預測是邏輯回歸提供強大解決方案的一些領域示例。

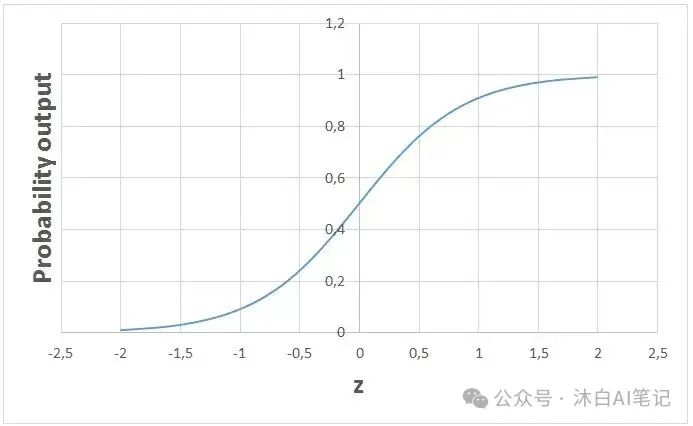

邏輯回歸的基礎是邏輯函數,也稱為 sigmoid 函數,它接受任何實數值并將其映射到 0 到 1 之間的值。

考慮我們要求解以下線性方程:

邏輯回歸模型以線性方程為輸入,使用邏輯函數和對數概率來執行二元分類任務。然后,我們將得到著名的邏輯回歸 s 形圖:

我們可以“按原樣”使用計算出的概率。例如,輸出可以是“此電子郵件是垃圾郵件的概率為 95%”或“客戶點擊此廣告的概率為 70%”。然而,在大多數情況下,概率用于對數據點進行分類。例如,如果概率大于 50%,則預測為正類 (1)。否則,預測為負類 (0)。

并不總是希望為所有高于 50% 的概率值選擇正類。關于垃圾郵件案例,我們必須幾乎確定才能將電子郵件歸類為垃圾郵件。由于被檢測為垃圾郵件的電子郵件直接進入垃圾郵件文件夾,我們不希望用戶錯過重要的電子郵件。除非我們幾乎可以肯定,否則電子郵件不會被歸類為垃圾郵件。另一方面,當健康相關問題的分類要求我們更加敏感時。即使我們有點懷疑某個細胞是惡性的,我們也不想錯過它。因此,作為正類和負類之間閾值的值取決于問題。好消息是邏輯回歸允許我們調整這個閾值。

5. K 最近鄰 (kNN)

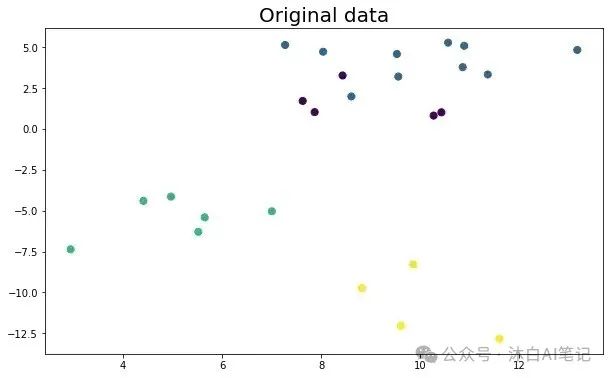

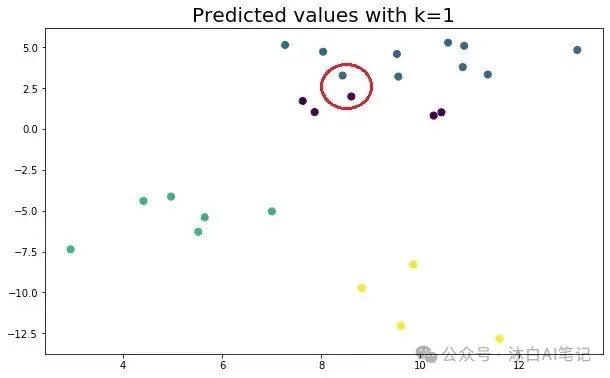

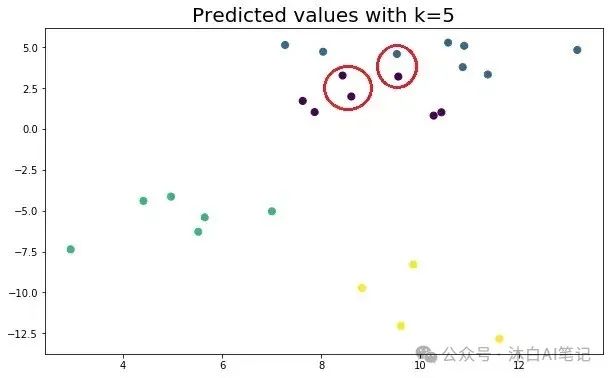

K 最近鄰 (kNN) 是一種監督學習算法,可用于解決分類和回歸任務。kNN 背后的主要思想是數據點的值或類別由它周圍的數據點決定。

kNN 分類器通過多數表決原則確定數據點的類別。例如,如果 k 設置為 5,則檢查 5 個最近點的類別。預測是根據多數類進行的。同樣,kNN 回歸取 5 個最近點的平均值。讓我們來看一個例子。考慮以下屬于 4 個不同類別的數據點:

讓我們看看預測的類別如何根據 k 值變化:

確定最佳 k 值非常重要。如果 k 太低,則模型太具體并且不能很好地泛化。它也往往對噪音敏感。該模型在訓練集上實現了高精度,但對新的、以前未見過的數據點的預測效果不佳。因此,我們很可能會得到一個過度擬合的模型。另一方面,如果 k 太大,則模型過于泛化,在訓練集和測試集上都不是一個好的預測器。這種情況稱為欠擬合。

kNN 簡單易懂。它不做任何假設,因此可以在非線性任務中實現。隨著數據點數量的增加,kNN 變得非常慢,因為模型需要存儲所有數據點。因此,它的內存效率也不高。kNN 的另一個缺點是它對異常值很敏感。

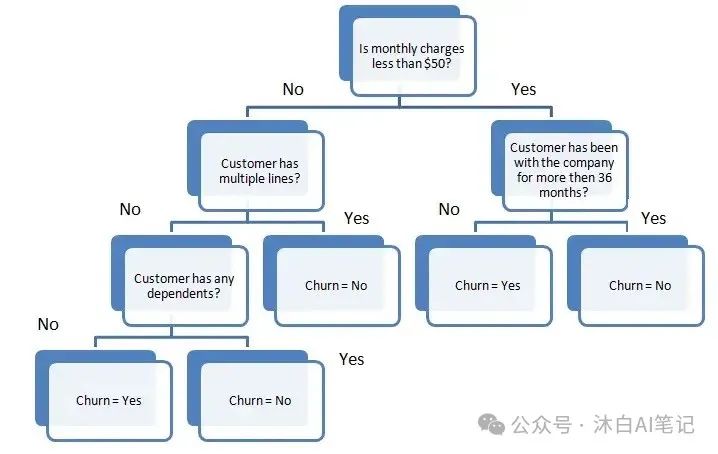

6. 決策樹

決策樹建立在反復提出問題以劃分數據的基礎上。使用決策樹的可視化表示更容易概念化分區數據:

這表示用于預測客戶流失的決策樹。第一個拆分是基于每月的費用金額。然后該算法不斷提出問題以分離類別標簽。隨著樹變得更深,問題變得更加具體。

決策樹算法的目的是在每次分區時盡可能增加預測能力,以便模型不斷獲取有關數據集的信息。隨機拆分特征通常不會給我們提供對數據集有價值的洞察力。增加節點純度的拆分提供更多信息。節點的純度與該節點中不同類別的分布成反比。以增加純度或減少雜質的方式選擇要問的問題。

我們問了多少問題?我們什么時候停止?我們的樹什么時候足以解決我們的分類問題?所有這些問題的答案將我們引向機器學習中最重要的概念之一:過度擬合。該模型可以不斷遍歷,直到所有節點都是純節點。但是,這將是一個過于具體的模型,并且不能很好地概括。它通過訓練集實現了高精度,但在新的、以前未見過的數據點上表現不佳,這表明過度擬合。樹的深度由scikit-learn 中決策樹算法的max_depth參數控制。

決策樹算法通常不需要對特征進行歸一化或縮放。它也適用于混合特征數據類型(連續、分類、二進制)。不好的地方是,它容易過度擬合,需要進行模型集成才能很好地泛化。

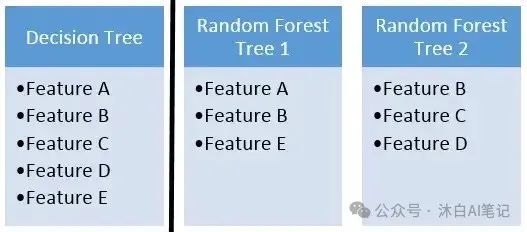

6. 隨機森林

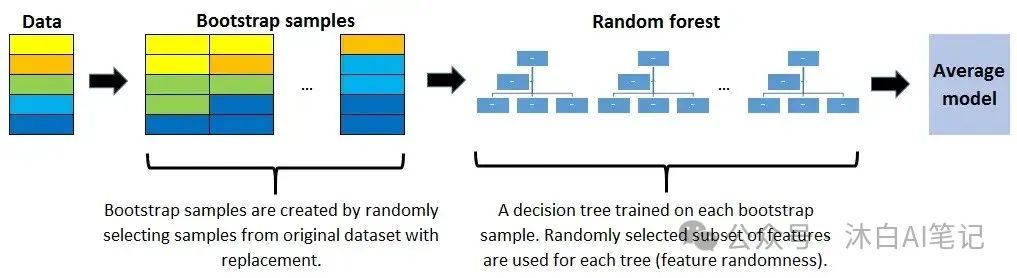

隨機森林是許多決策樹的集合。隨機森林是使用稱為bagging的方法構建的,其中決策樹用作并行估計器。如果用于分類問題,則結果基于從每個決策樹收到的結果的多數投票。對于回歸,葉節點的預測是該葉中目標值的平均值。隨機森林回歸取決策樹結果的平均值。

隨機森林降低了過度擬合的風險,準確率遠高于單個決策樹。此外,隨機森林中的決策樹并行運行,因此時間不會成為瓶頸。

隨機森林的成功在很大程度上取決于使用不相關的決策樹。如果我們使用相同或非常相似的樹,整體結果與單個決策樹的結果不會有太大差異。隨機森林通過引導和特征隨機性實現具有不相關的決策樹。

Bootsrapping 是從訓練數據中隨機選擇有放回的樣本。它們被稱為引導樣本。

特征隨機性是通過為隨機森林中的每個決策樹隨機選擇特征來實現的。可以使用max_features參數控制隨機森林中每棵樹使用的特征數量。

隨機森林是針對許多不同問題的高度準確的模型,不需要歸一化或縮放。然而,與快速線性模型(即樸素貝葉斯)相比,它對于高維數據集(即文本分類)并不是一個好的選擇。

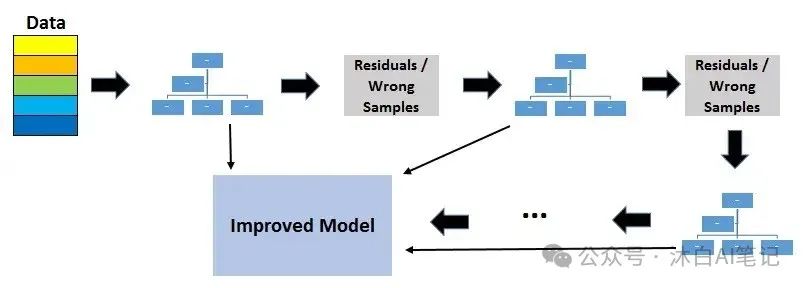

7.梯度提升決策樹(GBDT)

GBDT是一種集成算法,它使用boosting方法來組合單個決策樹。

Boosting 意味著將一個學習算法串聯起來,從許多順序連接的弱學習器中獲得一個強學習器。在 GBDT 的情況下,弱學習器是決策樹。

每棵樹都試圖最小化前一棵樹的殘差。boosting中的樹模型是弱學習模型,但串聯添加許多樹,每棵樹都關注前一棵樹的殘差,從而使 boosting 成為一個高效和準確的模型。與 bagging 不同,boosting 不涉及 bootstrap 采樣。每次添加新樹時,它都適合初始數據集的修改版本。

由于樹是按順序添加的,因此提升算法學習緩慢。在統計學習中,學習緩慢的模型表現更好。

損失函數用于檢測殘差。例如,均方誤差 (MSE) 可用于回歸任務,對數損失(對數損失)可用于分類任務。值得注意的是,當添加新樹時,模型中的現有樹不會改變。添加的決策樹適合當前模型的殘差。

學習率和n_estimators是梯度提升決策樹的兩個關鍵超參數。學習率,表示為 α,僅表示模型學習的速度。每棵新樹都會修改整個模型。修改的幅度由學習率控制。n_estimator是模型中使用的樹的數量。如果學習率低,我們需要更多的樹來訓練模型。但是,我們在選擇樹的數量時需要非常小心。使用過多的樹會產生過度擬合的高風險。

GBDT 在分類和回歸任務上都非常有效,并且與隨機森林相比提供了更準確的預測。它可以處理混合類型的特征,不需要預處理。GBDT 需要仔細調整超參數,以防止模型過擬合。

GBDT 算法非常強大,已經實現了很多升級版本,如 XGBOOST、LightGBM、CatBoost。

關于過擬合的注意事項

隨機森林和梯度提升決策樹之間的一個關鍵區別是模型中使用的樹的數量。增加隨機森林中的樹木數量不會導致過度擬合。在某個點之后,模型的準確性不會因添加更多樹而增加,但也不會因添加過多的樹而受到負面影響。由于計算原因,您仍然不想添加不必要數量的樹,但不存在與隨機森林中的樹數量相關的過度擬合風險。

然而,梯度提升決策樹中樹的數量在過度擬合方面非常關鍵。添加太多樹會導致過度擬合,因此在某個時候停止添加樹很重要。

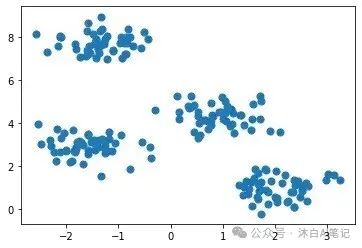

8. K-均值聚類

聚類是一種以類似數據點分組在一起的方式對一組數據點進行分組的方法。因此,聚類算法會尋找數據點之間的相似點或不同點。聚類是一種無監督學習方法,因此沒有與數據點關聯的標簽。聚類算法試圖找到數據的底層結構。

分類任務中的觀察(或數據點)有標簽。每個觀察結果都根據一些測量結果進行分類。分類算法試圖模擬觀測值(特征)與它們分配的類別之間的關系。然后模型預測新觀察的類別。

K均值聚類旨在將數據劃分為k個簇,使得同一簇中的數據點相似,不同簇中的數據點相距較遠。因此,它是一種基于分區的聚類技術。兩點的相似性由它們之間的距離決定。

K 均值聚類試圖最小化集群內的距離并最大化不同集群之間的距離。K-means 算法無法確定聚類的數量。我們需要在創建 KMeans 對象時定義它,這可能是一項具有挑戰性的任務。

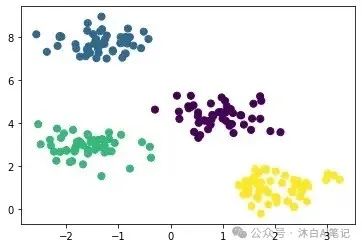

考慮以下數據集的二維可視化:

它可以分為 4 個不同的集群,如下所示:

現實生活中的數據集要復雜得多,其中的集群沒有明確分開。但是,該算法以相同的方式工作。K-means 是一個迭代過程。它建立在期望最大化算法之上。確定集群數量后,它通過執行以下步驟來工作:

- 為每個集群隨機選擇質心(集群中心)。

- 計算所有數據點到質心的距離。

- 將數據點分配給最近的集群。

- 通過取集群中所有數據點的平均值來找到每個集群的新質心。

- 重復步驟 2、3 和 4,直到所有點收斂并且聚類中心停止移動。

K-Means 聚類相對較快且易于解釋。它還能夠以一種智能方式選擇初始質心的位置,從而加快收斂速度。

k-means 的一個挑戰是必須預先確定集群的數量。K-means 算法無法猜測數據中存在多少簇。如果數據中存在分離組的非線性結構,則 k-means 將不是一個好的選擇。

9. 層次聚類

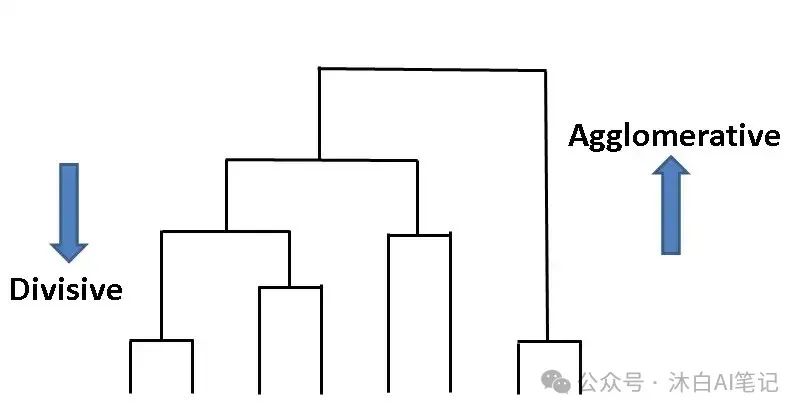

層次聚類意味著通過迭代分組或分離數據點來創建聚類樹。有兩種類型的層次聚類:

- 凝聚聚類

- 分裂聚類

層次聚類的優點之一是我們不必指定聚類的數量。

凝聚聚類是一種自下而上的方法。首先假定每個數據點是一個單獨的集群。然后相似的簇被迭代組合。

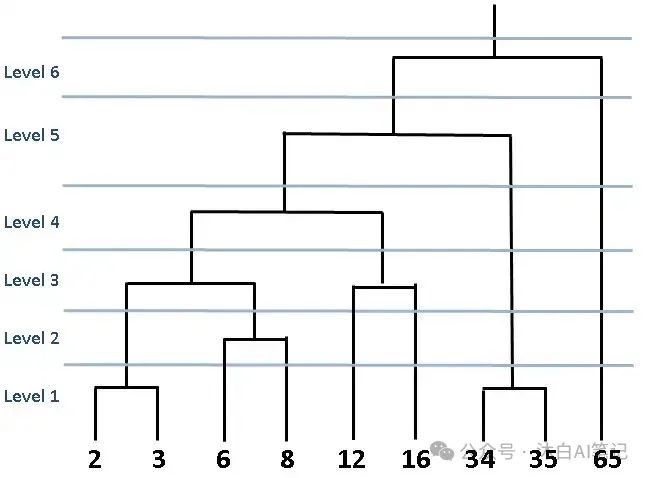

上圖稱為樹狀圖,它是表示基于樹的方法的圖。在層次聚類中,樹狀圖用于可視化聚類之間的關系。

層次聚類的優點之一是我們不必事先指定聚類的數量。但是,將所有數據點合并到一個集群中并不明智。我們應該在某個時候停止合并集群。Scikit-learn 為此提供了兩個選項:

- 達到多個集群后停止 (n_clusters)

- 設置鏈接的閾值 (distance_threshold)。如果兩個簇之間的距離高于閾值,則不會合并這些簇。

分裂聚類在現實生活中并不常用,所以我會簡單地提一下。簡單而明確的解釋是分裂聚類與凝聚聚類相反。我們從一個包含所有數據點的巨型集群開始。然后數據點被分成不同的集群。這是一種自上而下的方法。

層次聚類總是生成相同的聚類。K 均值聚類可能會產生不同的聚類,具體取決于質心(聚類中心)的啟動方式。但是,與 k-means 相比,它是一種較慢的算法。層次聚類需要很長時間才能運行,尤其是對于大型數據集。

10. DBSCAN 聚類

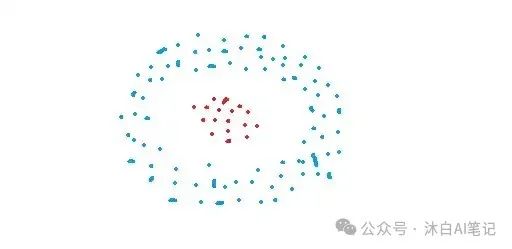

基于分區和層次聚類技術對于正常形狀的聚類非常有效。然而,當涉及到任意形狀的簇或檢測異常值時,基于密度的技術更有效。

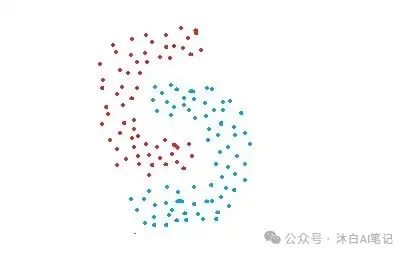

DBSCAN代表具有噪聲的基于密度的空間聚類。它能夠找到任意形狀的簇和帶有噪聲的簇(即異常值)。

DBSCAN 背后的主要思想是,如果一個點靠近該集群中的許多點,則該點屬于該集群。

DBSCAN有兩個關鍵參數:

- eps:指定鄰域的距離。如果兩點之間的距離小于或等于 eps,則認為它們是相鄰點。

- minPts:定義集群的最小數據點數。

基于這兩個參數,點被分類為核心點、邊界點或離群點:

- 核心點:如果一個點在其周圍半徑為eps的區域中至少有minPts個點(包括點本身),則該點是核心點。

- 邊界點:如果一個點可以從核心點到達并且其周圍區域內的點數少于 minPts,則該點是邊界點。

- 離群點:如果一個點不是核心點并且無法從任何核心點到達,則該點是離群點。

DBSCAN 不需要事先指定簇數。它對異常值具有魯棒性并且能夠檢測異常值。

在某些情況下,確定適當的鄰域距離 (eps) 并不容易,它需要領域知識。

11.主成分分析(PCA)

PCA 是一種降維算法,它基本上從現有特征中導出新特征,同時保留盡可能多的信息。PCA 是一種無監督學習算法,但它也被廣泛用作監督學習算法的預處理步驟。

PCA 通過查找數據集中特征之間的關系來導出新特征。

注意:PCA 是一種線性降維算法。也有可用的非線性方法。

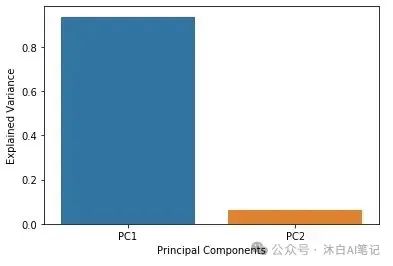

PCA 的目的是通過使用較少的特征(或列)盡可能多地解釋原始數據集中的方差。新的派生特征稱為主成分。主成分的順序是根據它們解釋的原始數據集的方差分數來確定的。

主成分是原始數據集特征的線性組合。

PCA 的優點是使用比原始數據集少得多的特征保留了原始數據集的大量方差。主成分根據它們解釋的方差量排序。

本文轉載自?? 沐白AI筆記??,作者: 楊沐白