使用MCTS顯著提升LLM在復(fù)雜任務(wù)的推理能力 精華

一、概述

?Title:Reasoning with Language Model is Planning with World Model

?URL:?? https://arxiv.org/abs/2305.14992??

?Code:?? https://github.com/maitrix-org/llm-reasoners??

?Demo:?? https://github.com/maitrix-org/llm-reasoners/blob/main/demo.ipynb??

1 Motivation

? 盡管COT表現(xiàn)不錯(cuò),但是當(dāng)前LLM在生成plan、復(fù)雜數(shù)學(xué)推理、邏輯推理時(shí)仍然表現(xiàn)不夠好。

?LLMs缺乏內(nèi)部“世界模型”來(lái)預(yù)測(cè)世界狀態(tài)(例如環(huán)境狀態(tài)、中間變量值)并模擬行動(dòng)的長(zhǎng)期結(jié)果。

? LLM缺乏類(lèi)似于人腦的深思熟慮的規(guī)劃能力。具體來(lái)說(shuō),LLMs 缺乏以下能力:

探索更多推理路徑:人類(lèi)在解決問(wèn)題時(shí),會(huì)考慮多種可能的方案,并評(píng)估每種方案的優(yōu)缺點(diǎn)。而 LLMs 通常只會(huì)按照一種固定的推理路徑進(jìn)行,缺乏靈活性和多樣性。

預(yù)測(cè)未來(lái)狀態(tài)和獎(jiǎng)勵(lì):人類(lèi)在規(guī)劃時(shí),會(huì)預(yù)測(cè)每個(gè)行動(dòng)可能導(dǎo)致的結(jié)果,并根據(jù)結(jié)果調(diào)整自己的計(jì)劃。而 LLMs 無(wú)法預(yù)測(cè)未來(lái)狀態(tài),因此無(wú)法進(jìn)行有效的規(guī)劃。

迭代改進(jìn)現(xiàn)有推理步驟:人類(lèi)在規(guī)劃過(guò)程中,會(huì)根據(jù)反饋不斷調(diào)整自己的計(jì)劃,使其更加完善。而 LLMs 通常只會(huì)按照既定的計(jì)劃進(jìn)行,缺乏自我反思和改進(jìn)的能力。

2 Methods

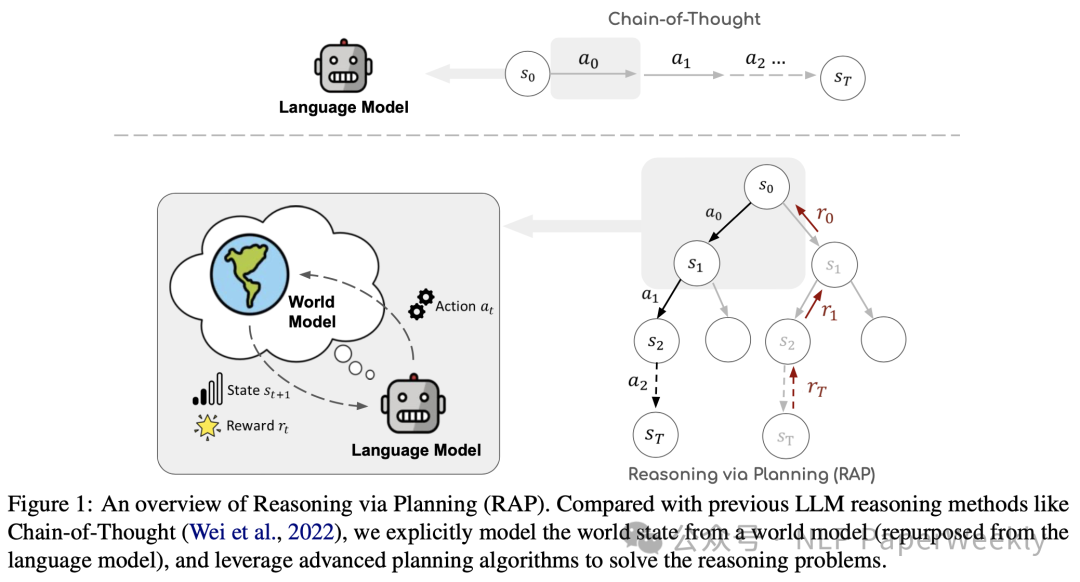

RAP框架通過(guò)以下幾個(gè)關(guān)鍵步驟來(lái)克服這些限制:

- 將LLM用作世界模型:提供未來(lái)state預(yù)測(cè)息,幫助后面做action的決策。

- 采用基于蒙特卡洛樹(shù)搜索(Monte Carlo Tree Search, MCTS)規(guī)劃算法進(jìn)行探索,高效找出reward最高的路徑。

- 在推理過(guò)程中,action執(zhí)行agent在世界模型agent的指導(dǎo)和reward獎(jiǎng)勵(lì)下逐步構(gòu)建推理樹(shù),并有效地找到高回報(bào)的推理路徑,同時(shí)在探索與利用之間保持適當(dāng)?shù)钠胶?/strong>。

1)關(guān)鍵組成

本文文通過(guò)提出一個(gè)新的框架Reasoning via Planning (RAP)來(lái)解決大型語(yǔ)言模型(LLMs)在復(fù)雜推理任務(wù)中遇到的挑戰(zhàn), 關(guān)鍵組成部分解釋如下:

- 基于LLM構(gòu)建世界模型:通過(guò)適當(dāng)?shù)膒rompt,基于LLM構(gòu)建世界模型,預(yù)測(cè)在給定當(dāng)前狀態(tài)的情況下,應(yīng)用某個(gè)動(dòng)作后下一個(gè)狀態(tài)的可能性。

- 根據(jù)不同的任務(wù)設(shè)置不同的reward:定義一個(gè)獎(jiǎng)勵(lì)函數(shù)來(lái)評(píng)估每個(gè)推理步驟的可行性和可取性。獎(jiǎng)勵(lì)函數(shù)可以根據(jù)不同任務(wù)的需求進(jìn)行定制,包括動(dòng)作的似然性、狀態(tài)的置信度、自我評(píng)估以及特定任務(wù)的啟發(fā)式方法。

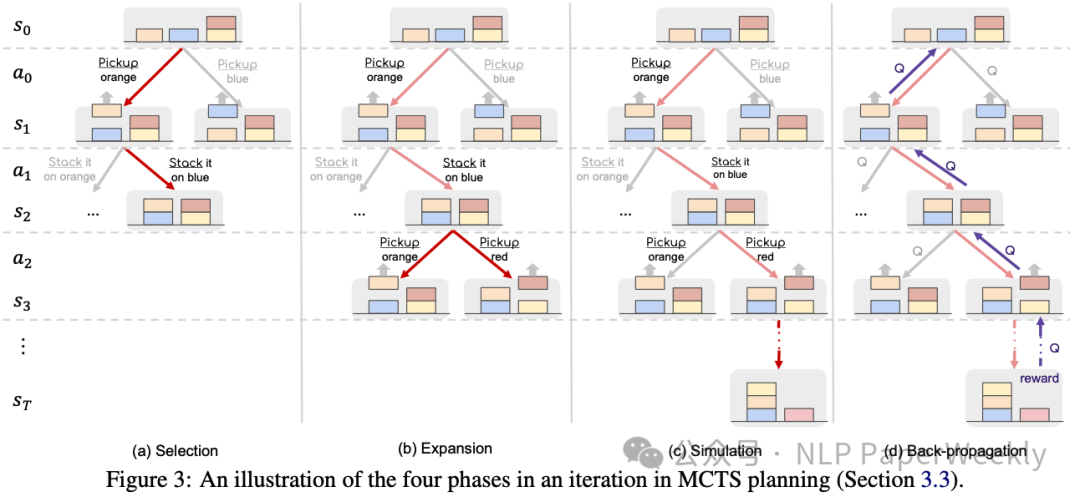

- 引入Plan算法進(jìn)行推理:MCTS通過(guò)迭代地構(gòu)建推理樹(shù),有效地在探索(未訪(fǎng)問(wèn)的推理路徑)和利用(已識(shí)別的最佳推理步驟)之間保持平衡。

- 構(gòu)建推理路徑的空間:在推理過(guò)程中,LLM(作為agent)根據(jù)世界模型的預(yù)測(cè)和reward模型的獎(jiǎng)勵(lì)函數(shù)的指導(dǎo),通過(guò)selection,expand,simulation,back-propagation逐步構(gòu)建一個(gè)推理樹(shù)。

- 結(jié)果聚合(RAP-Aggregation):對(duì)于只需要最終答案的問(wèn)題,RAP可以產(chǎn)生多個(gè)推理路徑和答案,這些結(jié)果可以通過(guò)聚合方法結(jié)合起來(lái),以進(jìn)一步提高推理性能。

2)基于世界模型預(yù)測(cè)未來(lái)狀態(tài),提升LLM的planning能力能力

Language Model as World Model:RAP 框架將 LLM 重新利用為世界模型,使其能夠模擬未來(lái)狀態(tài)并指導(dǎo)規(guī)劃算法,從而實(shí)現(xiàn)更類(lèi)似于人類(lèi)深思熟慮的推理。即f(current state + action) -> next state of the reasoning。

2.1 如何將 LLM 作為世界模型:

- 定義狀態(tài)和動(dòng)作:根據(jù)不同的推理任務(wù),定義狀態(tài)和動(dòng)作的具體含義。例如,在積木世界中,狀態(tài)是積木的配置,動(dòng)作是移動(dòng)積木;在數(shù)學(xué)問(wèn)題中,狀態(tài)是變量的值,動(dòng)作是提出子問(wèn)題。

- 構(gòu)建馬爾可夫決策過(guò)程 (MDP):將推理過(guò)程視為一個(gè) MDP,其中 LLM 作為智能體,根據(jù)當(dāng)前狀態(tài)生成動(dòng)作空間,并使用 LLM 作為世界模型預(yù)測(cè)執(zhí)行動(dòng)作后的下一個(gè)狀態(tài)。

- 模擬未來(lái)狀態(tài):通過(guò) LLM 作為世界模型預(yù)測(cè)未來(lái)狀態(tài),LLM 作為智能體可以在腦海中模擬執(zhí)行不同動(dòng)作后的結(jié)果,類(lèi)似于人類(lèi)的規(guī)劃過(guò)程。

2.2 使用世界模型的優(yōu)勢(shì):

? LLM 能夠更好地理解推理過(guò)程中的狀態(tài)變化,從而進(jìn)行更準(zhǔn)確、更連貫的推理。

? 有了世界模型,LLM 就可以使用各種規(guī)劃算法來(lái)探索推理空間,例如蒙特卡洛樹(shù)搜索 (MCTS),從而找到更優(yōu)的推理路徑。

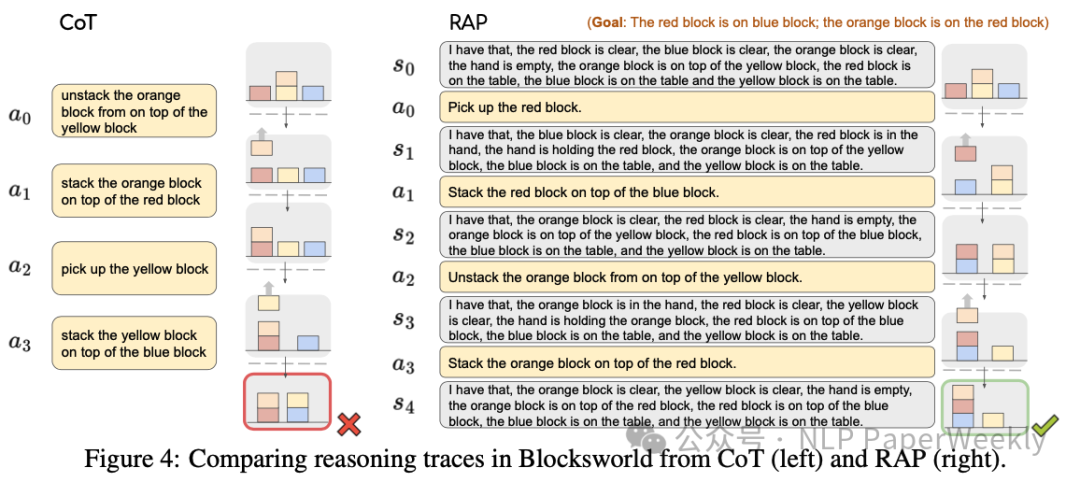

2.3 CoT 和 RAP 的主要區(qū)別:

?狀態(tài)建模:CoT 中只有動(dòng)作序列,沒(méi)有對(duì)世界狀態(tài)的建模。而 RAP 引入了世界模型,能夠預(yù)測(cè)未來(lái)狀態(tài),使推理過(guò)程更加全面和可靠。

?規(guī)劃能力:CoT 缺乏規(guī)劃能力,只能按照固定的推理路徑進(jìn)行。而 RAP 引入了規(guī)劃算法 (如 MCTS),能夠探索多種可能的推理路徑,并選擇最優(yōu)的路徑。

?推理過(guò)程:CoT 的推理過(guò)程是自回歸的,每一步推理都依賴(lài)于前一步的輸出。而RAP 的推理過(guò)程是迭代的,LLM 可以根據(jù)反饋不斷調(diào)整推理步驟。

3 如何設(shè)計(jì)Reward Model?

3.1 獎(jiǎng)勵(lì)函數(shù)的核心目標(biāo):

?評(píng)估每個(gè)推理步驟的可行性和可取性:判斷每個(gè)步驟是否符合規(guī)則,以及是否有助于達(dá)到最終目標(biāo)。

?引導(dǎo) LLM 沿著最優(yōu)路徑進(jìn)行推理:通過(guò)獎(jiǎng)勵(lì)機(jī)制,鼓勵(lì) LLM 選擇更有利于達(dá)成目標(biāo)的推理步驟。

3.2 有哪些常見(jiàn)的reward獎(jiǎng)勵(lì)函數(shù)方法:

類(lèi)別 | 描述 | 原理 | 作用 | 應(yīng)用場(chǎng)景 |

動(dòng)作概率 (Action Likelihood) | 采用當(dāng)前action的概率作為reward,即采用log probability of the action作為reward。 | 評(píng)估 LLM 在當(dāng)前狀態(tài)下生成特定動(dòng)作的概率。 | 反映 LLM 對(duì)特定動(dòng)作的偏好和置信度。 | 適用于需要判斷動(dòng)作合理性的任務(wù),例如積木世界中的移動(dòng)積木。 |

狀態(tài)置信度 (State Confidence) | 狀態(tài)置信度通過(guò)采樣 LLM 的預(yù)測(cè)結(jié)果并計(jì)算最常見(jiàn)結(jié)果的比例來(lái)評(píng)估 LLM 對(duì)預(yù)測(cè)狀態(tài)的可靠性。 | 評(píng)估 LLM 對(duì)預(yù)測(cè)狀態(tài) (例如答案) 的置信度。 | 反映 LLM 對(duì)預(yù)測(cè)結(jié)果的可靠性程度。 | 適用于需要評(píng)估預(yù)測(cè)結(jié)果質(zhì)量的任務(wù),例如數(shù)學(xué)問(wèn)題中的答案。 |

自我評(píng)估 (Self-evaluation) | criticize itself,例如question“Is this reasoning step correct ?” 或者,利用next-word yes的概率作為reward。 | 讓 LLM 對(duì)自身推理步驟的正確性進(jìn)行評(píng)估。 | 反映 LLM 對(duì)自身推理能力的自我認(rèn)知。 | 適用于 LLM 可以判斷推理步驟正確性的任務(wù),例如數(shù)學(xué)問(wèn)題中判斷計(jì)算或邏輯錯(cuò)誤。 |

特定任務(wù)啟發(fā)式 (Task-specific Heuristics) | 方便引入其他插件,來(lái)啟發(fā)式引導(dǎo)。 | 根據(jù)特定任務(wù)的特性設(shè)計(jì)啟發(fā)式函數(shù),評(píng)估推理步驟的質(zhì)量。 | 利用領(lǐng)域知識(shí),指導(dǎo) LLM 進(jìn)行更有效的推理。 | 適用于需要利用領(lǐng)域知識(shí)的任務(wù),例如積木世界中計(jì)算預(yù)測(cè)狀態(tài)與目標(biāo)狀態(tài)之間的距離。 |

4 如何利用MCTS進(jìn)行迭代

4.1 MCTS 的四個(gè)階段:

階段 | 描述 |

選擇(Selection) | 從根節(jié)點(diǎn)開(kāi)始,遞歸選擇最優(yōu)的子節(jié)點(diǎn),直到達(dá)到一個(gè)葉子結(jié)點(diǎn)。此過(guò)程基于一定的選擇策略,例如UCB (Upper Confidence Bound)。 |

擴(kuò)展(Expansion) | 當(dāng)達(dá)到葉節(jié)點(diǎn)時(shí),根據(jù)問(wèn)題的定義,擴(kuò)展樹(shù)以添加一個(gè)或多個(gè)子節(jié)點(diǎn)。這模擬了在現(xiàn)實(shí)中采取一個(gè)動(dòng)作并觀(guān)察新?tīng)顟B(tài)的過(guò)程。 |

模擬(Simulation) | 從擴(kuò)展的節(jié)點(diǎn)開(kāi)始,執(zhí)行模擬來(lái)估計(jì)這個(gè)節(jié)點(diǎn)的價(jià)值。模擬是通過(guò)一種模型或隨機(jī)方法生成的,模擬直到達(dá)到某個(gè)終止條件。 |

回溯(Backpropagation) | 根據(jù)模擬的結(jié)果,將回報(bào)值(reward)傳播回來(lái)更新經(jīng)過(guò)的所有節(jié)點(diǎn)的統(tǒng)計(jì)信息,如訪(fǎng)問(wèn)次數(shù)和累計(jì)獎(jiǎng)勵(lì)。 |

4.2 如何選擇最終推理路徑?

算法終止后,需要從構(gòu)建的搜索樹(shù)中選擇一條推理軌跡進(jìn)行評(píng)估。這里有幾種不同的選擇策略:

- 基于 Q 值的選擇:從根節(jié)點(diǎn)開(kāi)始,迭代地選擇具有最高Q 值(即狀態(tài)-動(dòng)作對(duì)的預(yù)期回報(bào))的動(dòng)作,直到達(dá)到一個(gè)終端節(jié)點(diǎn)(葉子節(jié)點(diǎn))。這種方法依賴(lài)于算法在迭代過(guò)程中積累的值。

- 基于獎(jiǎng)勵(lì)的選擇:直接選擇在迭代過(guò)程中產(chǎn)生最高總獎(jiǎng)勵(lì)的路徑。這種方法考慮了整個(gè)路徑的累積獎(jiǎng)勵(lì),而不是單個(gè)步驟的 Q 值。

- 最頻繁訪(fǎng)問(wèn)的葉子節(jié)點(diǎn):選擇訪(fǎng)問(wèn)次數(shù)最多的葉子節(jié)點(diǎn),以及從根節(jié)點(diǎn)到該葉子節(jié)點(diǎn)的路徑。這種方法假設(shè)最頻繁訪(fǎng)問(wèn)的路徑可能是最優(yōu)的。

實(shí)際觀(guān)察:在實(shí)際應(yīng)用中,作者觀(guān)察到第二種策略(基于獎(jiǎng)勵(lì)的選擇)通常會(huì)產(chǎn)生最好的結(jié)果。這可能是因?yàn)樗紤]了整個(gè)路徑的累積獎(jiǎng)勵(lì),而不是僅僅依賴(lài)于單個(gè)步驟的 Q 值,從而能夠更好地捕捉到長(zhǎng)遠(yuǎn)的推理效果。

5 Conclusion

? RAP在生成計(jì)劃、數(shù)學(xué)推理和邏輯推理任務(wù)上表現(xiàn)出色,超越了包括CoT和least-to-most prompting在內(nèi)的多種強(qiáng)基線(xiàn)。

? RAP在使用LLaMA-33B模型時(shí)超過(guò)了使用GPT-4的CoT方法,在plan生成中提升了33%。

二、詳細(xì)內(nèi)容

1 實(shí)驗(yàn)設(shè)計(jì)

Benchmark: 采用了4個(gè)不同的任務(wù)來(lái)證明本方法的有效性:

- Plan生成(Plan Generation):使用Blocksworld基準(zhǔn)測(cè)試,要求智能體將塊按特定順序堆疊。定義狀態(tài)為塊的當(dāng)前方向,動(dòng)作為移動(dòng)塊的指令。使用兩種獎(jiǎng)勵(lì):動(dòng)作的似然性和特定任務(wù)啟發(fā)式獎(jiǎng)勵(lì)。與Chain-of-Thought (CoT)和其他基線(xiàn)方法進(jìn)行比較。

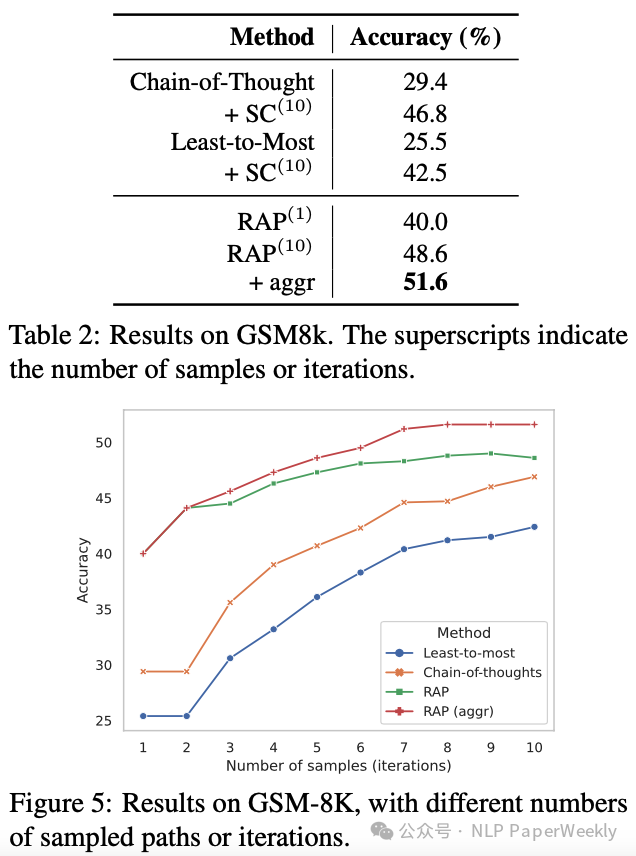

- 數(shù)學(xué)推理(Math Reasoning):在GSM8K數(shù)據(jù)集上進(jìn)行測(cè)試,該數(shù)據(jù)集包含小學(xué)數(shù)學(xué)文字問(wèn)題。將問(wèn)題分解為一系列較小的子問(wèn)題。**定義狀態(tài)為中間變量的值,動(dòng)作為提出關(guān)于未知中間變量的增量子問(wèn)題。**結(jié)合自我評(píng)估獎(jiǎng)勵(lì)和狀態(tài)置信度獎(jiǎng)勵(lì)。與CoT、Least-to-Most prompting等變體進(jìn)行比較。

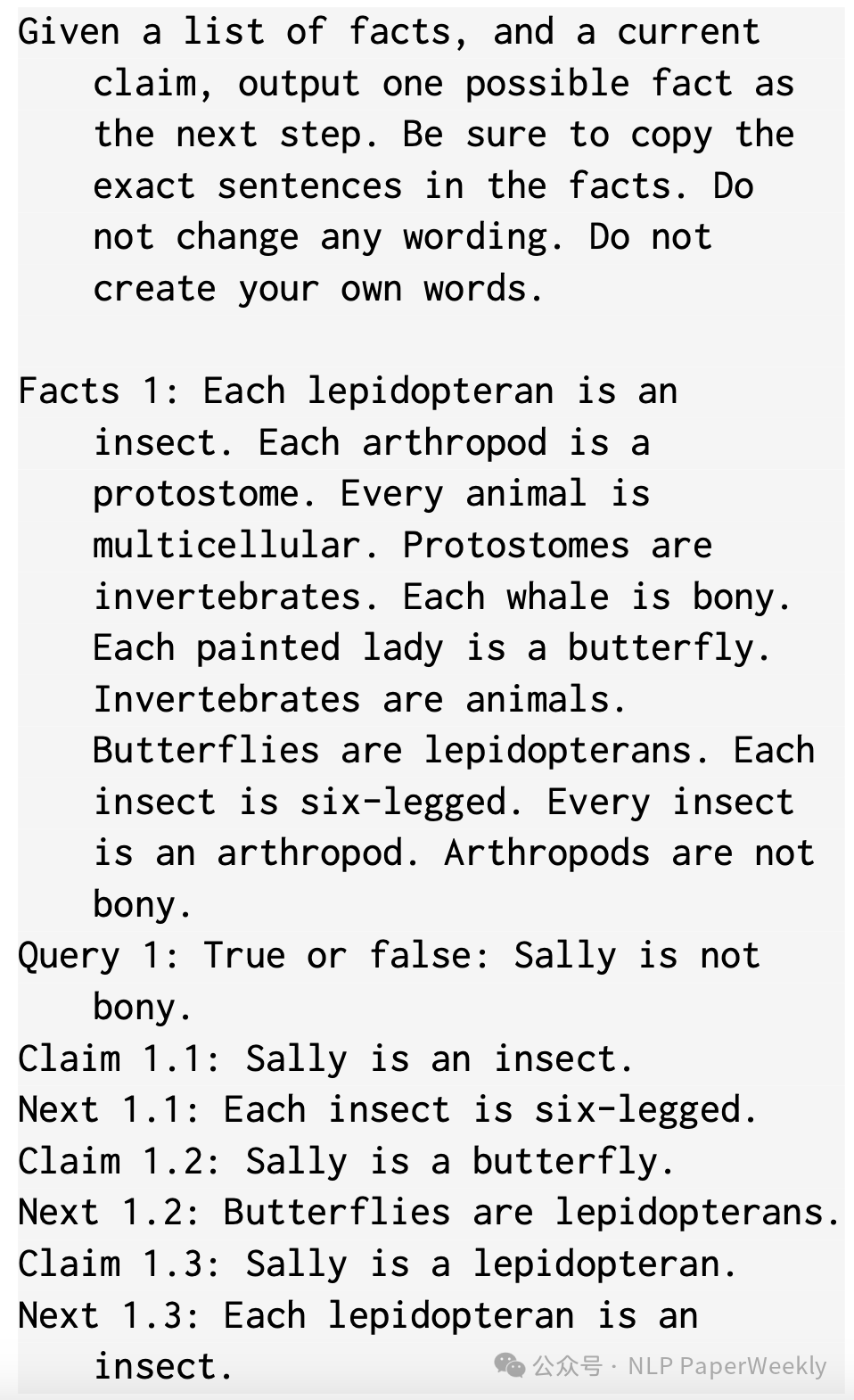

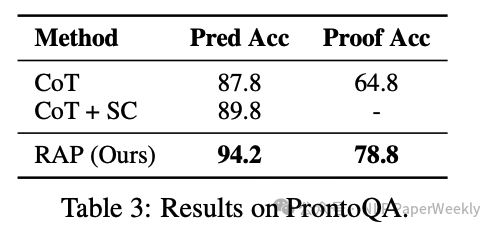

- 邏輯推理(Logical Reasoning):在PrOntoQA數(shù)據(jù)集上進(jìn)行測(cè)試,該數(shù)據(jù)集包含一組事實(shí)和邏輯規(guī)則,要求模型驗(yàn)證假設(shè)事實(shí)的真假。定義狀態(tài)為當(dāng)前關(guān)注的fact,動(dòng)作為從fact集中選擇規(guī)則。使用自我評(píng)估獎(jiǎng)勵(lì),并基于未來(lái)步驟的平均獎(jiǎng)勵(lì)更新Q函數(shù)。與CoT基線(xiàn)方法進(jìn)行比較,評(píng)估最終答案的預(yù)測(cè)準(zhǔn)確性和完整證明的準(zhǔn)確性。

額外實(shí)驗(yàn):

?復(fù)雜問(wèn)題的分析:在完整的Blocksworld數(shù)據(jù)集上使用更強(qiáng)大的LLM(Llama-2 70B)進(jìn)行實(shí)驗(yàn),以進(jìn)一步研究RAP是否能幫助更強(qiáng)的LLM解決更復(fù)雜的問(wèn)題。

?獎(jiǎng)勵(lì)選擇的分析:對(duì)不同獎(jiǎng)勵(lì)選擇對(duì)LLM推理性能的影響進(jìn)行了綜合實(shí)驗(yàn),包括計(jì)劃生成和數(shù)學(xué)推理任務(wù)。

?適應(yīng)性提示(Adaptive Prompting):為了解決演示案例和測(cè)試案例之間難度分布差異的問(wèn)題,提出了一種適應(yīng)性提示技術(shù),通過(guò)預(yù)計(jì)算演示案例的中間狀態(tài)并截?cái)嗨阉鳂?shù)中的路徑來(lái)提高性能。

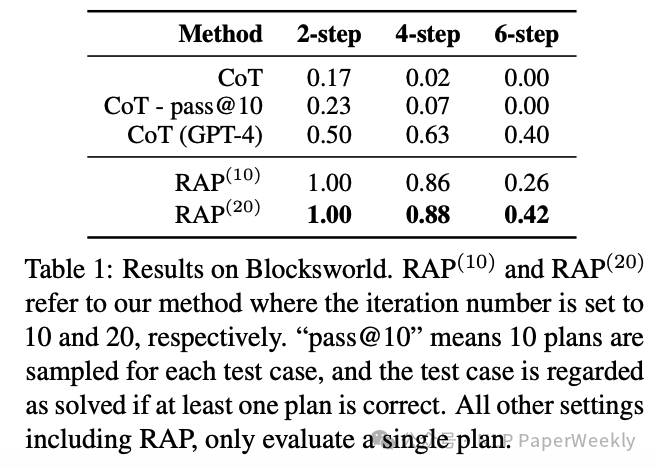

2 Blocksword場(chǎng)景超過(guò)GPT4+COT的效果

說(shuō)明:

?任務(wù):通過(guò)一系列的操作,將積木塊從一種特定的初始配置移動(dòng)到另一種目標(biāo)配置。

?RAP(10) 和 RAP(20):這指的是使用 RAP 方法時(shí),迭代次數(shù)分別設(shè)置為 10 和 20 的實(shí)驗(yàn)設(shè)置。

?“pass@10”:表示對(duì)于每個(gè)測(cè)試案例,算法采樣了 10 個(gè)計(jì)劃。如果一個(gè)測(cè)試案例中至少有一個(gè)計(jì)劃是正確的,那么這個(gè)測(cè)試案例就被認(rèn)為是解決了的。這種方法可以評(píng)估算法在多次嘗試中找到至少一個(gè)有效解決方案的能力。

結(jié)論1: 使用 LLaMA-33B(一個(gè)大型語(yǔ)言模型)的 CoT 方法只能為少數(shù)幾個(gè)兩步的問(wèn)題生成成功的計(jì)劃,而在更難的問(wèn)題上完全失敗。這表明 CoT 方法在處理簡(jiǎn)單問(wèn)題時(shí)表現(xiàn)尚可,但在問(wèn)題復(fù)雜度增加時(shí),其性能顯著下降。

結(jié)論2: RAP 方法在性能上顯著優(yōu)于 CoT,幾乎解決了所有四步以?xún)?nèi)的難題,并且解決了一部分六步問(wèn)題,平均成功率達(dá)到 64%。這說(shuō)明 RAP 方法在處理更復(fù)雜問(wèn)題時(shí)的有效性。

結(jié)論3: 六步問(wèn)題的搜索空間可以達(dá)到 ,而RAP算法在 20 次迭代內(nèi)能夠以 42% 的概率找到成功的計(jì)劃。這強(qiáng)調(diào)了 RAP 方法在處理具有大規(guī)模搜索空間問(wèn)題時(shí)的效率。

結(jié)論4: RAP框架使得 LLaMA-33B 在性能上超過(guò)了 GPT-4,提升了33%,表明 RAP 方法能夠顯著提升語(yǔ)言模型在復(fù)雜推理任務(wù)上的性能。

3 數(shù)學(xué)推理任務(wù)上表現(xiàn)也非常好

說(shuō)明:

?任務(wù):例如GSM8k的數(shù)學(xué)任務(wù),包括一個(gè)描述和一個(gè)final question,需要進(jìn)行multi-step數(shù)學(xué)計(jì)算,需要將final question拆解成一系列小的字問(wèn)題來(lái)解決。

?狀態(tài)定義:在這個(gè)框架中,"狀態(tài)state"被定義為中間變量的值。中間變量是在解決問(wèn)題過(guò)程中產(chǎn)生的,它們幫助模型理解問(wèn)題的當(dāng)前狀態(tài)。

?動(dòng)作定義:"動(dòng)作action"是指提出一個(gè)關(guān)于未知中間變量的增量子問(wèn)題。這個(gè)動(dòng)作是為了獲取關(guān)于問(wèn)題更多的信息。

?世界模型響應(yīng):世界模型(可以理解為問(wèn)題的背景知識(shí)庫(kù))會(huì)根據(jù)當(dāng)前的中間變量值和問(wèn)題描述來(lái)回答提出的子問(wèn)題。回答的結(jié)果是將新的中間變量值加入到下一個(gè)狀態(tài)中,從而更新模型對(duì)問(wèn)題的理解。

?獎(jiǎng)勵(lì)函數(shù):獎(jiǎng)勵(lì)函數(shù)是由兩個(gè)部分組合而成的:LLM對(duì)自己提出子問(wèn)題有用性的自我評(píng)估(rt,1)和模型對(duì)當(dāng)前狀態(tài)置信度(rt,2)的加權(quán)幾何平均。這個(gè)加權(quán)幾何平均表示為 rt = rα ? r1?α,其中 α 是權(quán)重系數(shù)。

?獎(jiǎng)勵(lì)的目的:這個(gè)獎(jiǎng)勵(lì)函數(shù)的設(shè)計(jì)目的是鼓勵(lì)模型提出更加相關(guān)和有用的子問(wèn)題。通過(guò)這種方式,模型可以更有效地解決問(wèn)題,因?yàn)樗鼤?huì)被引導(dǎo)去關(guān)注那些能夠顯著推進(jìn)問(wèn)題解決進(jìn)程的信息。

? 其他:RAP(aggr)取多條采樣路徑的結(jié)果。

4 邏輯推理任務(wù)上表現(xiàn)也比較好

image-20241104234512575

說(shuō)明:

- ?任務(wù)設(shè)置:邏輯推理任務(wù)(例如 PrOn-toQA)通常提供一組事實(shí)和邏輯規(guī)則。模型的任務(wù)是使用這些邏輯規(guī)則來(lái)驗(yàn)證給定的假設(shè)事實(shí)是否為真或假。這些任務(wù)不僅要求模型提供正確的最終答案(真或假),還要求模型提供一個(gè)詳細(xì)的證明來(lái)展示結(jié)果。

- ?狀態(tài)定義:在這個(gè)框架中,"狀態(tài)"被定義為模型當(dāng)前關(guān)注的事實(shí),這類(lèi)似于人類(lèi)在推理時(shí)的工作記憶(Baddeley, 1992)。工作記憶是指在進(jìn)行復(fù)雜認(rèn)知任務(wù)時(shí),暫時(shí)存儲(chǔ)和操作信息的心理能力。

- ?動(dòng)作定義:"動(dòng)作"被定義為從事實(shí)集中選擇一個(gè)規(guī)則。這個(gè)動(dòng)作是為了應(yīng)用邏輯規(guī)則來(lái)進(jìn)行推理。

- ?世界模型:世界模型執(zhí)行一個(gè)單跳推理步驟,使用選定的規(guī)則和當(dāng)前的事實(shí)來(lái)生成一個(gè)新的事實(shí),這個(gè)新事實(shí)成為下一個(gè)狀態(tài)。

- ?獎(jiǎng)勵(lì)計(jì)算:獎(jiǎng)勵(lì)是通過(guò)自我評(píng)估來(lái)計(jì)算的(參見(jiàn) Section 3.2)。具體來(lái)說(shuō),通過(guò)向 LLM 提供一些帶有標(biāo)簽的示例,幫助它更好地理解推理步驟的質(zhì)量。自我評(píng)估可以是模型對(duì)推理步驟有用性的評(píng)價(jià)。

- ?Q 函數(shù)更新:使用未來(lái)步驟的平均獎(jiǎng)勵(lì)來(lái)更新 Q 函數(shù),這與 GSM8k 中的方程(2)相同。Q 函數(shù)是強(qiáng)化學(xué)習(xí)中的一個(gè)概念,用于評(píng)估在特定狀態(tài)下采取特定動(dòng)作的預(yù)期回報(bào)。

三、總結(jié)

?結(jié)論1:利用LLM作為世界模型和推理agent,可以顯著提升其推理和規(guī)劃能力,使其在多個(gè)推理任務(wù)上的表現(xiàn)優(yōu)于現(xiàn)有強(qiáng)基線(xiàn)。

?結(jié)論2:引入基于蒙特卡洛樹(shù)搜索(MCTS)的規(guī)劃算法,有效平衡了推理過(guò)程中的探索和利用,使得LLM在解決復(fù)雜推理問(wèn)題時(shí)能夠高效獲取高獎(jiǎng)勵(lì)的推理路徑。

本文轉(zhuǎn)載自 ??NLP PaperWeekly??,作者: NLP PaperWeekly