Transformer在復雜推理任務中的新進展:多步邏輯推理中的匹配策略 精華

在自然語言處理(NLP)領域,Transformer是一種革命性的架構。Transformer模型因其卓越的語言理解和生成能力而成為了一個里程碑,它們在多種任務中展現出了前所未有的性能,從機器翻譯到文本摘要,再到問答系統,Transformer模型已經成為了當今最先進的技術。盡管取得了巨大的成功,Transformer在執行復雜推理任務時仍面臨挑戰,特別是在需要多步邏輯推理的場景中。這些挑戰主要表現在模型對于復雜問題的理解和解決能力上,尤其是當問題涉及到跨步驟的邏輯推導時。

5月27日,發表于全球最大學術論文平臺arXiv的《Towards Understanding How Transformer Perform Multi-step Reasoning with Matching Operation》這篇論文深入探討了Transformer模型如何通過匹配操作來執行多步推理。來自上海交通大學自然科學研究院、數學科學學院以及華為諾亞方舟實驗室的研究團隊通過構建專門的數據集,揭示了Transformer內部的匹配機制,并提出了一種新的匹配矩陣概念來量化模型的匹配能力。他們發現通過微小的初始化和調整LayerNorm的位置,可以顯著提高模型的匹配能力,從而增強其推理能力。此外研究還發現Transformer能夠在其架構內部并行地執行多個推理步驟,這一發現為理解模型的推理能力提供了新的視角,并為設計更高效的推理模型奠定了基礎。

他們研究的動機源于對Transformer模型在執行復雜任務時的局限性的認識。盡管這些模型在單步推理任務中表現出色,但在需要連續多個邏輯步驟的推理任務中,它們的性能往往會下降。這種現象激發了研究者們對模型內部如何處理和整合跨步驟信息的好奇心,以及如何改進模型以更好地執行這類任務的探索。

論文的主要目標是揭示Transformer模型在多步推理任務中的工作原理,并提出有效的方法來增強其推理能力。通過構建專門的數據集和實驗,研究團隊不僅分析了模型的匹配機制,還探討了不同初始化方法和LayerNorm位置對推理能力的影響。此外他們還提出了并行推理機制的概念,并基于此提出了關于模型推理能力上限的猜想。

研究團隊的這些發現不僅為我們提供了如何改進Transformer模型的具體指導,也為未來在更廣泛的人工智能系統中應用多步推理提供了理論基礎。隨著研究的深入,我們期待這些洞見能夠推動人工智能向更高層次的認知和推理能力邁進。

一、相關工作

Transformer模型是一種基于自注意力機制的深度學習架構,它在處理序列數據時能夠同時考慮序列中所有元素之間的關系。這種模型的核心優勢在于其能夠捕捉長距離依賴關系,這在傳統的循環神經網絡(RNN)和長短期記憶網絡(LSTM)中是一個挑戰。Transformer模型由編碼器和解碼器組成,其中編碼器負責處理輸入數據,解碼器則生成輸出。自注意力機制允許模型在不同位置的輸入之間建立直接的聯系,從而提高了處理復雜任務的能力。

多步推理是指在解決問題時需要進行多個邏輯步驟的推導過程。在人工智能領域,多步推理被廣泛應用于各種復雜任務,如數學問題求解、法律案件分析、科學實驗設計等。這些任務通常涉及到從給定的信息中推導出新的結論,需要模型具備強大的邏輯推理和決策能力。多步推理不僅能夠提高模型的認知能力,還能夠幫助模型更好地理解和解釋復雜的問題。

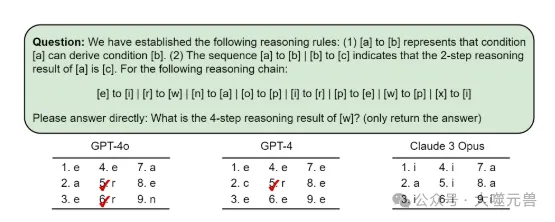

最先進的模型,如GPT-4,通常采用橫向思維策略,如思想鏈(CoT)提示,它多次調用模型以生成明確的中間推理步驟。這種方法通過橫向延長思維過程來增強模型的推理能力。在CoT提示下,所有模型都可以在圖1所示的示例任務中輸出正確答案。作為橫向方法的補充,作者團隊的研究重點是Transformer模型的縱向思維能力,即在模型架構本身內執行多步驟推理的固有能力。他們的目標是揭示模型的推理能力如何隨著深度而擴展,而不依賴于外部提示或多次調用。CoT提示和我們的多步驟推理分析為提高LLM的推理性能提供了互補的視角。

圖1:LLM中多步驟推理的失敗案例。正確答案是[r](由于[w]→ </p>→ e→ [i]→ r他們對每個模型進行了9次測試。

為了深入研究Transformer模型的推理機制,他們設計了三種類型的多步驟推理數據集,并分析了模型的內部信息流。他們的研究表明,Transformer模型主要通過匹配運算來實現多步驟推理。他們提出了匹配矩陣的概念來衡量模型在每一層的匹配能力,發現即使對于未經訓練的隨機嵌入向量,模型也能保持良好的匹配能力。這表明Transformer模型可能已經學習了推理任務的本質。

匹配操作是Transformer模型在執行推理任務時的一種關鍵機制。它涉及到在模型的不同層之間匹配相關信息,以便正確地推導出答案。在多步推理任務中,匹配操作使得模型能夠將前一步的輸出作為下一步推理的輸入,從而形成一個連貫的推理鏈。這種機制對于處理那些需要多個邏輯步驟的任務至關重要,因為它允許模型在每一步中都能夠考慮到之前所有步驟的信息。通過優化匹配操作,可以顯著提高模型在多步推理任務中的性能和準確性。

二、研究方法

這項研究加深了我們對Transformer推理機制的理解,并為進一步增強其推理能力提供了新的視角。從這項研究中獲得的洞見有助于設計更高效的推理模型,并探索一般人工智能系統中的推理機制。

1. 數據集的構建和類型劃分

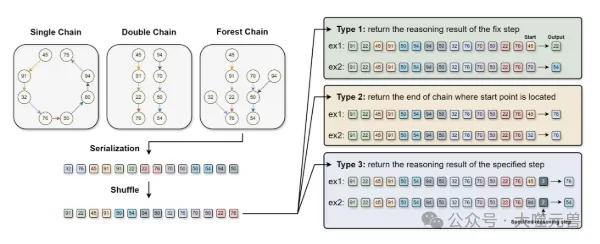

為了理解Transformer在多步推理中的機制,他們設計了三種類型的多步推理任務。每兩個標記在句子中代表一個推理關系。他們使用不同的標記方法生成以下三種類型的數據集:

類型1:最后一個標記是起點,標簽是從起點開始的固定步驟推理結果。

類型2:最后一個標記是起點,標簽是起點所在推理鏈的終點。

類型3:最后兩個標記分別是起點和指定的推理步驟,標簽是從起點開始的指定步驟推理結果。

他們設計了三種鏈結構:單鏈、雙鏈和森林鏈。每個任務的鏈結構都是獨特的。

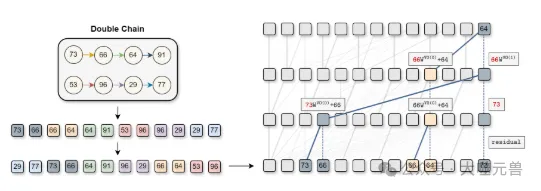

圖2:本研究中推理鏈結構和數據集類型的說明。我們考慮三種類型的推理鏈結構:單鏈、雙鏈和森林鏈。這些結構根據不同的策略進行序列化和標記,從而產生三種數據集類型。

訓練和測試數據:他們設計了一種方法來劃分數據,使得訓練集中的每一對1步推理對與測試集中的不同。具體來說對于訓練集中的序列化推理鏈[x1][x2]… [xn],所有標記滿足以下條件:

x2i?x2i?1mod5∈[0,1,4]

對于測試集中的推理鏈,所有標記滿足:

x2i?x2i?1mod5∈[2,3]

每個標記的值范圍從20到100,即 ( x_i \in [20, 100] )。在這種設置下,他們檢查了Transformer執行零樣本上下文學習的能力,因為每對推理對在權重學習期間都沒有被看到。

2. 模型架構的選擇和設計

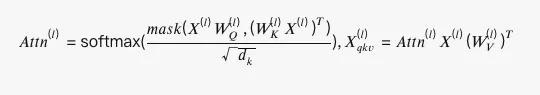

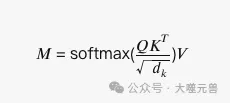

他們采用了僅解碼器的Transformer。給定輸入序列 ( Xin \in \mathbb{R}^{n \times d} ),其中n是序列長度,d是字典大小,模型首先應用嵌入層(目標嵌入和位置嵌入)來獲得輸入表示 ( X^{(1)} = X_{tgt} + X_{pos} \in \mathbb{R}^{n \times dm} )。每層的單頭注意力計算如下:

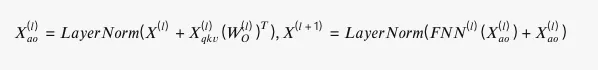

其中 ( (W_V{(l)})T ) 表示 ( W_V^{(l)} ) 的轉置。第l層的輸出獲得為:

之后,應用投影層將輸出映射到目標空間 ( Y \in \mathbb{R}^{n \times d} )。最終輸出通過應用于Y的softmax函數的argmax獲得。模型架構和符號的詳細描述可以在論文附錄A中找到。

圖3:執行兩步推理的三層Transformer網絡的信息流。實線表示通過注意力的信息傳輸,藍色實線表示影響本例中結果的注意力信息流。藍色虛線表示在該示例中影響結果的殘余信息流。

第0-1層:信息融合。第一層的主要功能是奇偶對的信息注入,這是訓練集的數據結構的結果,因為訓練序列中的奇數位置的標記可以推斷其后續的偶數位置的標記。該層的實現主要依賴于位置嵌入。

第1-2層:信息匹配。在信息融合之后,第一層中的偶數位置擁有來自兩個令牌的信息,這兩個令牌不是簡單地相加在一起,而是以“[x2i-1]WV O(0)+[x2i]”,其中WV O“0”=WV(0),TWO“0),T。因此,在層1中發生匹配操作。具體來說,將起點表示為[A],其查詢將具有最大的內積,關鍵字為“[A]WV O(0)+[B]”,從而將[B]的信息傳輸到最后一個位置。他們的研究表明,這種匹配操作不需要“[B]”的參與以及序列的位置編碼。相反,它僅通過“[A]”的查詢來實現,即F(0)(X tgt A)WQ(1),T和“[A]WV O(0)”的關鍵字,即F? LayerNorm(0).

3.實驗設置和評估標準

研究團隊通過一系列精心設計的實驗來探索不同初始化方法、LayerNorm位置以及正交噪聲添加對Transformer模型多步推理能力的影響。

實驗設置

研究團隊測試了不同的權重初始化方法,包括小的初始化、默認初始化和大的初始化。這些方法通過改變權重分布的尺度參數來控制模型在訓練初期的狀態。

實驗中比較了LayerNorm的兩種不同位置配置:后置LayerNorm(在自注意力和前饋網絡之后)和前置LayerNorm(在自注意力和前饋網絡之前)。

為了增強模型的匹配能力,研究團隊引入了正交噪聲。這種方法通過在模型的權重矩陣中添加噪聲來提高匹配操作的效果。

評估標準

模型在測試數據集上的準確性是評估模型性能的主要指標。準確性反映了模型在多步推理任務中給出正確答案的能力。

泛化能力指的是模型在未見過的數據上的表現。研究團隊通過在訓練和測試數據集上使用不同的推理鏈來評估模型的泛化能力。

匹配能力是通過匹配矩陣來衡量的,它反映了模型在每一層中匹配相關信息的能力。匹配矩陣的最大對角屬性是評估匹配能力的關鍵。

通過這些研究方法,研究團隊深入探討了Transformer模型在多步推理任務中的工作原理,并提出了有效的方法來增強其推理能力。這些方法不僅對于理解模型的內在機制具有重要意義,還為未來的模型設計和優化提供了新的思路和方向。

三、匹配機制的探索

在論文中研究團隊深入探討了Transformer模型的匹配機制,以實現多步推理。

1. 匹配矩陣的定義和性質

在Transformer模型中,匹配矩陣的概念是為了量化和理解模型如何在其內部層次之間進行信息匹配。

匹配矩陣是一個數學工具,用于衡量Transformer模型中不同位置之間信息匹配的程度。在模型的每一層,匹配矩陣通過計算輸入序列中各個元素之間的關聯強度來構建。具體來說,匹配矩陣可以表示為:

其中,( Q )、( K ) 和 ( V ) 分別代表查詢(query)、鍵(key)和值(value)矩陣,( d_k ) 是鍵向量的維度,softmax 函數用于歸一化計算得到的權重。

研究團隊發現,即使對于未經訓練的隨機標記,匹配矩陣仍然能夠保持最大對角屬性。這表明模型能夠識別并強調序列中最相關的元素,即使在沒有經過特定訓練的情況下。

泛化能力這一發現也暗示了Transformer模型具有在數據分布之外進行匹配的能力,這對于處理未見過的數據或進行零樣本學習尤為重要。

匹配矩陣的這些性質對于模型的推理能力至關重要。在多步推理任務中,模型需要能夠準確地匹配和推斷出下一步的邏輯,匹配矩陣的效能直接影響了這一過程的成功。

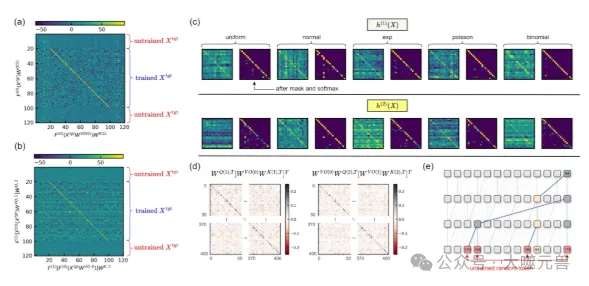

圖4:(a)匹配矩陣h(1)(Xtgt)。對角線元素顯示出最大的值,這證實了匹配操作。請注意,X tgt 0~20和X tgt 100~120對應于從隨機正態分布初始化的未經訓練的令牌。(b) 匹配矩陣h(2)(Xtgt)。(c) 用不同的隨機初始化方法為未訓練的令牌匹配矩陣h(1)(X)和h(2)(X。最大對角線性質適用于所有情況,表明模型的泛化能力。(d) Ker(1)=WQ(1),TW K(1)WV O(0),T和Ker(2)=WV O。

通過深入理解匹配矩陣的定義和性質,我們可以更好地把握Transformer模型在復雜推理任務中的工作原理,以及如何通過改進匹配機制來提升模型的整體性能。這些洞見對于開發更先進的NLP應用具有重要的指導意義。

2. 匹配操作在多步推理中的應用

在多步推理任務中,匹配操作扮演著至關重要的角色。它不僅允許Transformer模型將前一步的輸出作為下一步推理的輸入,而且確保了信息在整個推理鏈中的連貫性和一致性。

匹配操作使得模型能夠識別并關聯序列中的相關信息,這對于執行需要多個邏輯步驟的任務至關重要。它通過自注意力機制,計算序列中各個元素之間的相關性,從而確定哪些信息是對當前推理步驟最為關鍵的。

在處理多步推理任務時,模型需要能夠從一個邏輯步驟平滑過渡到下一個。匹配操作通過強化關鍵信息的表示,使得模型能夠有效地進行這種過渡。例如,在解決數學問題時,模型可能需要先識別出問題中的已知條件,然后再推導出下一步的求解過程。匹配操作確保了模型在這一過程中能夠持續跟蹤和利用關鍵信息。

這種機制對于處理復雜的推理任務至關重要。它不僅提高了模型的推理效率,還增強了模型的推理準確性。匹配操作確保了模型在不同推理步驟之間能夠保持信息的一致性,這對于生成準確和可靠的推理結果是必不可少的。

通過這種方式,匹配操作為Transformer模型提供了一種強大的工具,使其能夠在多步推理任務中表現出色。這種能力對于開發能夠處理復雜問題的人工智能系統具有重要的意義。

3. 初始化方法和LayerNorm位置對匹配能力的影響

在Transformer模型的研究中,初始化方法和LayerNorm位置對于模型的匹配能力和推理性能有著顯著的影響。

初始化方法決定了模型權重在訓練開始時的分布。不同的初始化方法會導致模型在學習過程中采取不同的路徑,從而影響最終的推理能力。

小的初始化,即權重值從一個較小的范圍內隨機選擇,被發現有助于模型在學習過程中更好地形成有效的匹配機制。這可能是因為小的初始化減少了模型在早期訓練階段的過度擬合風險,使得模型能夠更好地捕捉和泛化訓練數據中的模式。

LayerNorm是一種標準化技術,用于調整神經網絡中的激活分布,以促進更快的訓練和更好的性能。研究表明,將LayerNorm放置在自注意力和前饋網絡之后(后置LayerNorm)比放置在它們之前(前置LayerNorm)更有利于匹配操作的形成。后置LayerNorm可能有助于模型在每個層次中更穩定地學習和匹配信息,從而提高了整體的推理能力。

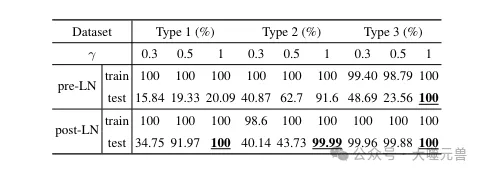

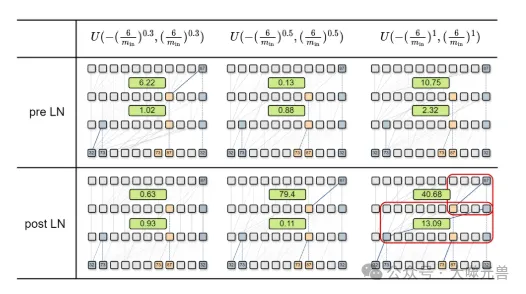

表1:初始化和LayerNorm的比較。

圖5:不同初始化和LayerNorm的Transformers在訓練序列上的信息流和匹配分數的比較。具有較小初始化和postLayerNorm的模型在兩層中都表現出較高的匹配分數。

正交噪聲添加是一種正則化技術,它通過在模型的權重中引入噪聲來提高模型的泛化能力。在匹配操作中添加正交噪聲被發現可以增強模型的匹配能力。這種方法可能通過增加模型權重的多樣性,使得模型能夠在匹配過程中考慮更多的特征和模式,從而提高推理任務中的準確性和魯棒性。

通過這些方法,研究團隊能夠顯著提高Transformer模型在多步推理任務中的匹配能力,這對于提升模型的整體推理性能至關重要。這些發現為未來在Transformer模型上的研究提供了寶貴的見解,并為其他復雜任務中的模型設計提供了指導。

四、增強模型的匹配能力

研究團隊探討了如何增強Transformer模型的匹配能力,以提高其在多步推理任務中的性能。

1. 不同初始化方法對模型性能的影響

在Transformer模型的研究中,初始化方法對模型性能的影響是一個重要的考量因素。

初始化方法決定了模型權重在訓練開始時的初始狀態。這些權重是模型學習過程中的起點,因此它們的初始值對模型的學習能力和最終性能有著深遠的影響。不同的初始化方法會導致模型在學習過程中采取不同的路徑,這可能會影響模型在特定任務上的表現,尤其是在多步推理任務中。

小的初始化方法指的是將模型權重初始化為接近零的小數值。這種方法被發現有助于模型在測試數據集上的泛化能力。泛化能力是指模型對未見過的數據的處理能力。小的初始化通過減少模型在訓練初期的過擬合風險,使得模型能夠更好地學習和推廣訓練數據中的模式。

在多步推理任務中,小的初始化有助于模型更有效地捕捉和利用邏輯關系,從而提高推理能力。通過這些發現,研究團隊證明了在Transformer模型中采用小的初始化方法可以顯著提升模型在多步推理任務中的性能。

2. LayerNorm位置的選擇及其對推理能力的影響

在深度神經網絡中,Layer Normalization (LayerNorm)是一種關鍵的技術,它通過對每一層的激活進行歸一化,有助于加速訓練過程并提高模型的性能。在Transformer模型中,LayerNorm的位置選擇對模型的推理能力有著顯著的影響。

LayerNorm通過規范化輸入的分布,幫助緩解訓練過程中的梯度消失或爆炸問題。它對模型的內部狀態進行標準化處理,使得訓練過程更加穩定,同時也提高了模型對輸入數據變化的魯棒性。

研究團隊通過實驗發現,將LayerNorm放置在自注意力(Self-Attention)和前饋神經網絡(Feed-Forward Neural Network, FNN)模塊之后(即后置LayerNorm),比放置在它們之前(即前置LayerNorm)更有利于模型的推理能力。

后置LayerNorm有助于模型在多步推理任務中更好地整合信息。這可能是因為LayerNorm在處理完注意力和FNN模塊的輸出后,能夠更有效地規范化這些信息,從而為下一步的推理提供了更加穩定和一致的基礎。

在多步推理任務中,模型需要能夠準確地串聯起一系列的邏輯步驟。后置LayerNorm通過改善信息流動和整合,有助于模型更準確地執行這一過程。

這種配置使得模型在每一步推理時都能夠考慮到之前所有步驟的信息,并且在不同推理步驟之間保持信息的一致性和連貫性。

LayerNorm的位置選擇對于Transformer模型在執行復雜的多步推理任務時的性能至關重要。后置LayerNorm的優勢在于它能夠在模型的每一步中提供更加穩定和有效的信息整合,從而增強模型的推理能力。

3. 正交噪聲添加方法及其效果

在Transformer模型的優化過程中,正交噪聲添加方法被提出作為一種增強模型匹配能力的新技術。這種方法涉及在模型的權重矩陣中引入正交噪聲,以改善和優化匹配操作的性能。

正交噪聲是一種統計上獨立的噪聲,其特點是不同噪聲源之間不存在相關性。通過在權重矩陣中添加正交噪聲,可以增加模型權重的多樣性,從而使模型在執行匹配操作時能夠探索更廣泛的特征空間。

添加正交噪聲可以提高模型在處理不確定性和復雜模式時的魯棒性。這種方法有助于模型在多步推理任務中更準確地識別和關聯關鍵信息,尤其是在面對復雜或模糊的邏輯鏈時。

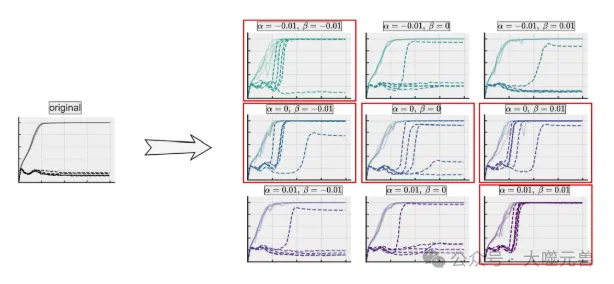

圖6:不同可學習參數初始值的影響,α(l) 和β(l),關于模型的推理能力。當α(l) ini=0或α(l) 和β(l) 最初具有相同的符號,可以增強模型的推理能力。實線表示訓練精度,而虛線表示測試精度。每個實驗用五個隨機種子進行。

實驗結果表明,正交噪聲的添加確實能夠優化匹配操作,提高模型在多步推理任務中的表現。模型在添加了正交噪聲后,在測試數據集上的準確率和推理能力都有所提升,證明了這種方法的有效性。

正交噪聲添加方法為Transformer模型的匹配能力提供了一個有效的提升手段。這種方法通過增加權重的多樣性,幫助模型在多步推理任務中實現更高的準確性和魯棒性,是未來模型優化的一個有前景的方向。

五、并行推理機制與上限猜想

研究團隊對Transformer模型的并行推理機制進行了深入研究。

1.并行推理的信息流分析

在Transformer模型中,并行推理是指模型能夠在同一層內同時執行多個推理步驟。這一機制對于提高模型處理多步推理任務的效率至關重要。

研究團隊通過分析信息在模型中的傳播方式,揭示了Transformer模型在多步推理任務中的并行推理機制。信息流分析幫助研究者理解了模型如何在內部層次之間傳遞和整合信息,特別是在處理復雜的邏輯鏈時。

當推理步驟的數量超過或等于模型層數時,Transformer模型展現出其并行處理能力。在一層中同時執行多個匹配操作意味著模型可以在不增加額外計算層的情況下,處理更多的邏輯步驟。這種并行性顯著提高了模型處理多步推理任務的效率。

在信息傳播的過程中,模型從匹配標記的值逐漸轉變為匹配標記的位置。這表明模型在不同層之間不僅匹配內容信息,還匹配位置信息。這種變化有助于模型在不同層之間整合不同類型的信息,從而在整個推理過程中保持信息的一致性和連貫性。

Transformer模型的并行推理機制是其在多步推理任務中高效性能的關鍵。通過在單層內并行處理多個推理步驟,模型能夠更快地完成復雜任務,同時保持推理過程的準確性。

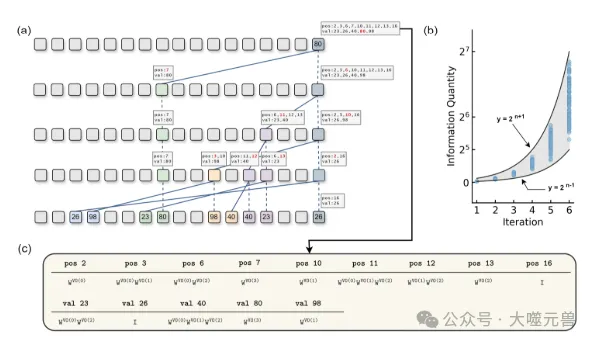

圖7:(a)完成4步推理的4層Transformer模型的信息流。(b) 相對于基于信息屬性規則傳播信息時的迭代次數,最后一個位置中存儲的信息令牌的數量。我們隨機選擇1000個句子進行模擬。藍點表示模擬結果。(c) 每個信息乘以的系數。

2.模型推理能力的上限猜想

研究團隊提出了一個關于模型推理能力上限的猜想,這一猜想基于對模型內部信息處理機制的深入理解。

研究團隊觀察到,當隱藏空間維度足夠大時,不同的信息可以在獨立的子空間中存儲,而不會相互干擾。在這種理想化的假設下,模型的推理能力被認為可以實現指數級的增長。這是因為每增加一層,模型就能夠處理更多的信息,并且在每一步推理中都能夠并行地處理更多的邏輯步驟。

研究團隊猜想,在理想情況下,如果模型的每一層都能夠獨立地處理信息,那么模型的推理能力將隨著層數的增加而指數級增長。這意味著模型的推理能力上限可能遠遠超過我們目前的認識,尤其是在處理復雜的多步推理任務時。

在實際應用中,隱藏空間維度受到物理資源和計算能力的限制,這意味著理想化假設并不總是成立。此外前饋神經網絡(FNN)和其他注意機制的存在也會影響信息的處理方式,進而影響模型的推理能力。因此,盡管理論上模型的推理能力可能實現指數級增長,但實際上模型的推理能力可能介于線性增長和指數級增長之間。

這一猜想為未來Transformer模型的研究提供了新的視角,提示我們在設計和優化模型時需要考慮到隱藏空間維度和模型架構的選擇,以充分發揮模型的推理潛力。同時,這也為我們提供了一個探索目標,即如何突破現有的限制,實現模型推理能力的最大化。

3. 實際應用中的限制和潛在增長

在Transformer模型的研究和應用中,實際應用的限制和潛在增長是兩個重要的考量因素。

大型語言模型如Transformer通常需要大量的隱藏空間維度來存儲和處理信息。然而由于計算資源的限制,模型的隱藏空間維度往往無法達到理想狀態,這限制了模型的推理能力。實際應用中,模型可能無法完全滿足理論上的假設要求,如獨立子空間的存儲和信息的無干擾傳遞,從而影響模型的推理性能。

盡管存在上述限制,前饋神經網絡(FNN)和其他注意機制的存在為模型提供了額外的能力,使其能夠整合和處理不同類型的信息。這些機制有助于模型在有限的隱藏空間維度內實現更有效的信息處理,從而在一定程度上彌補了維度限制帶來的影響。

雖然實際應用中的限制對模型的推理能力構成了挑戰,但隨著技術的進步和計算資源的增加,模型的推理能力仍有很大的增長空間。通過優化模型架構、提高計算效率以及開發新的訓練策略,我們可以期待模型在未來能夠處理更復雜的推理任務,并展現出更強的推理能力。

Transformer模型在實際應用中雖然受到一定的限制,但隨著技術的發展,它們在推理任務中的性能仍有很大的提升潛力。研究團隊的工作為我們提供了對這些限制和潛在增長的深入理解,為未來的研究和應用指明了方向。

六、討論

本論文的研究成果對于理解和提升Transformer模型在多步推理任務中的能力具有重要意義。通過深入分析匹配機制,研究團隊不僅揭示了Transformer內部的工作原理,還提出了增強其推理能力的有效方法。這些發現有助于推動Transformer模型在復雜認知任務中的應用,同時也為AI領域的研究者提供了新的研究方向和思路。

匹配機制的概念可以擴展到其他AI系統中,特別是那些涉及復雜決策和推理的系統。例如,在自動駕駛、醫療診斷、金融分析等領域,強化匹配機制可以提高系統處理多步驟問題的能力。此外,匹配機制的原理也可以應用于改進機器學習模型的訓練過程,使其能夠更好地從數據中學習和推廣知識。

盡管本論文取得了顯著的研究成果,但在將匹配機制應用于Transformer模型和其他AI系統中仍存在一些挑戰和研究方向。例如,如何在不同類型的任務和數據集上驗證匹配機制的普適性和有效性,以及如何進一步優化模型結構和訓練策略以提高推理能力。此外,探索如何將匹配機制與其他AI技術(如強化學習、知識圖譜)結合,以創建更加智能和適應性強的系統,也是未來研究的重要方向。

參考資料:???https://arxiv.org/abs/2405.15302??

本文轉載自 ??大噬元獸??,作者: FlerkenS