測試時訓練(TTT)太強了!

論文筆記分享,標題:The Surprising Effectiveness of Test-Time Training for Abstract Reasoning

測試時訓練(TTT)是個新概念:在推理過程中使用從輸入數據派生的損失暫時更新模型參數

文章的結論:

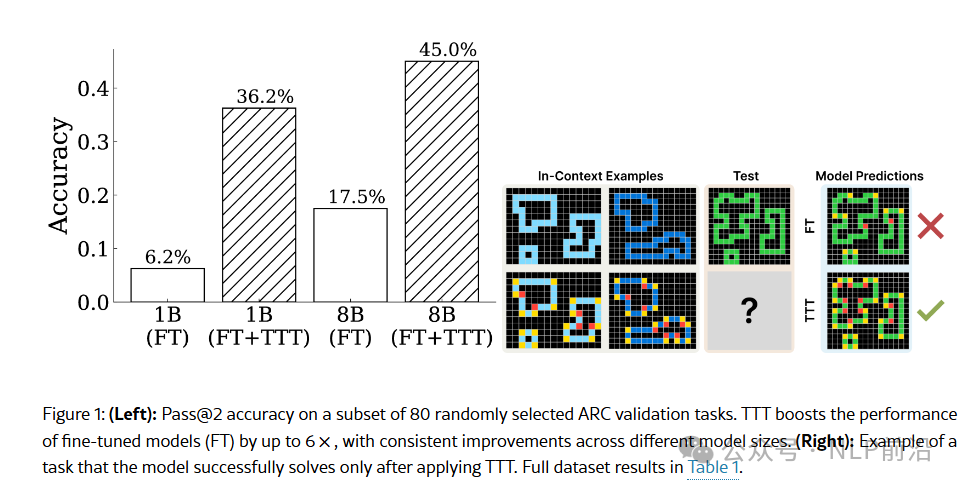

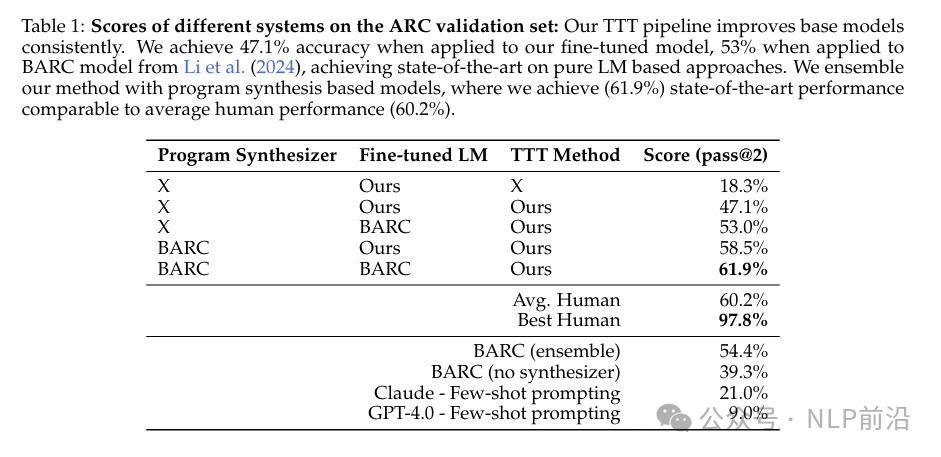

TTT 顯著提高了 ARC 任務上的性能,與基線微調模型相比,準確率提高了高達 6 倍;將 TTT 應用于一個 8B 參數的語言模型,在 ARC 的公共驗證集上達到了 53%的準確率,將公共和純神經網絡方法的最新水平提高了近 25%。通過將我們的方法與最近的程序生成方法相結合,獲得了 61.9%的 SoTA 公共驗證準確率,與人類評分接近。

ARC 任務:一個評估語言模型抽象推理能力的基準測試。通過一系列視覺謎題任務來考驗模型解決新問題的能力。 每個任務由2D網格(大小可達30×30)組成,網格中包含由多達10種不同顏色的形狀或模式。輸出是通過將一個直觀且共同的變換規則或函數應用于輸入網格來獲得的。

算法步驟:

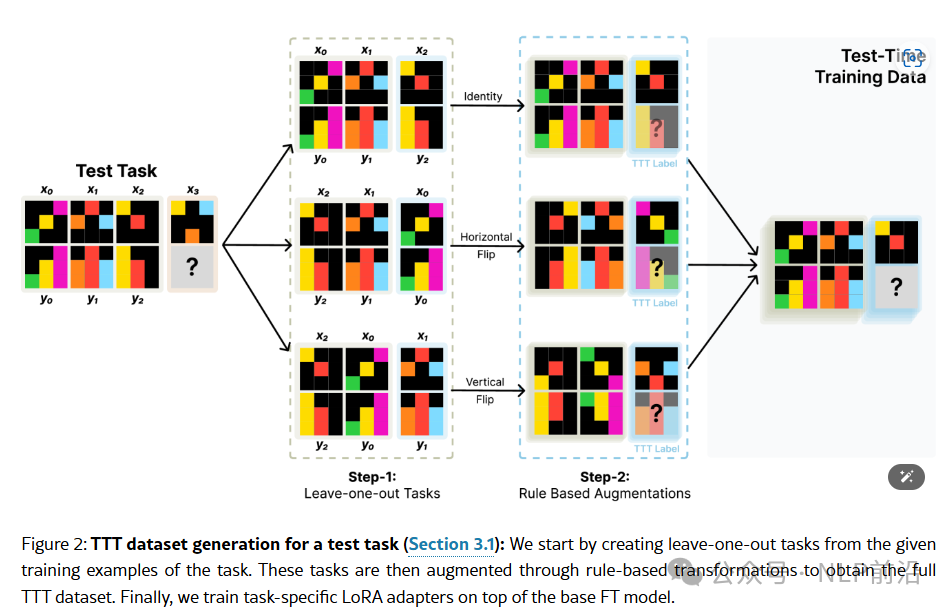

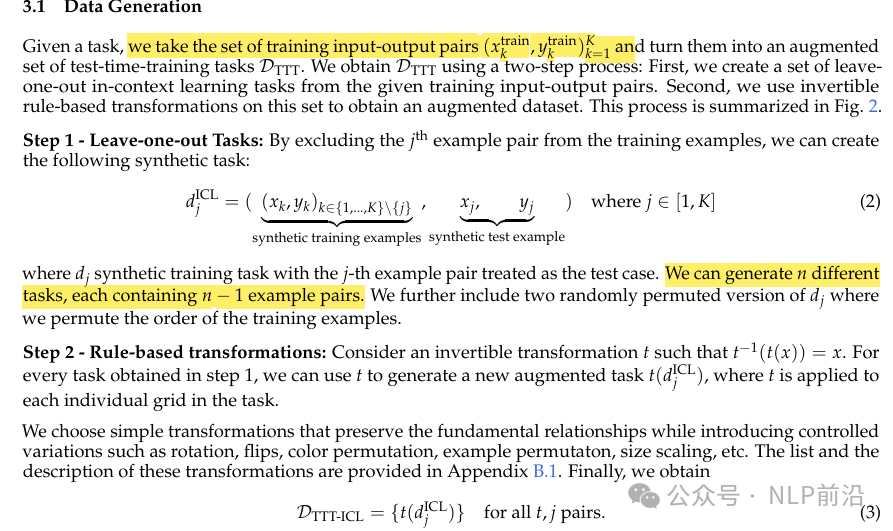

- 從訓練輸入-輸出對中創建留一法任務,然后通過基于規則的變換來增強數據集。

- 在測試時訓練期間,使用LoRA來優化。為每個任務學習一個特定的LoRA適配器,而不是為所有任務學習一個單一的適配器。

- 使用幾何變換生成多個預測候選,然后通過貪婪解碼方案進行預測。采用分層投票策略,首先在每個變換內進行投票,然后對每個變換的候選進行全局投票,以確定最終預測。

本文轉載自??NLP前沿??

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦