Ai2開源OLMo 2:數據集、訓練方法、權重大放送

AI研究機構Ai2開源了最新大模型OLMo 2,這是一款在各方面都真正開放的人工智能模型。

OLMo,即Open Language Model,與Llama和Gemma等流行的開放權重模型不同,它不僅提供模型權重,還包括了工具、數據集、訓練配方等所有用于開發模型的內容。

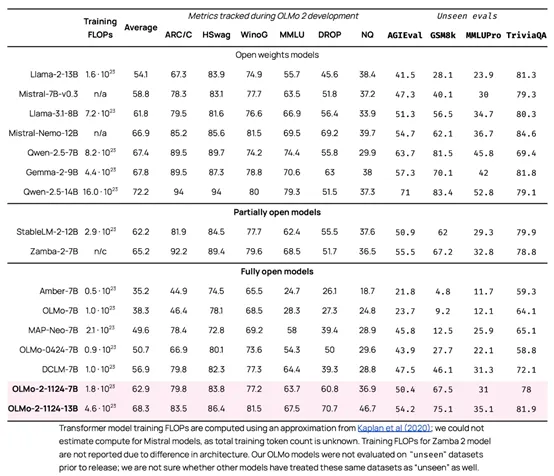

OLMo 2包括了7B和13B兩個參數版本,能力都相當優秀。7B版本在英語學術基準測試中超越了Meta的Llama 3.1 8B,而13B版本即使在訓練時使用的計算能力較少的情況下,也超過了Qwen 2.5 7B。

開源地址:https://huggingface.co/allenai/OLMo-2-1124-7B

OLMo 2的發布是基于今年早些時候發布的首個OLMo模型,Ai2團隊采用了創新的兩階段訓練方法。他們首先在包含3.9萬億token的大型數據集上進行訓練,然后使用來自學術內容、數學練習冊和指令集的高質量數據進行優化。

團隊特別關注訓練的穩定性,并對此進行了關鍵的改進,以防止在長時間的訓練過程中出現性能下降的情況。

此次發布還建立在Ai2近期與開源訓練系統Tülu 3合作的基礎之上。Tülu 3是一個復雜的后訓練過程,它使得OLMo 2具備了與世界上一些最佳模型相當的指令跟隨任務能力。

完整的發布內容還包括了評估框架和中間檢查點,這些工具可以幫助開發人員深入理解并進一步提升OLMo 2的能力。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦