2萬億訓練數據,120億參數!開源大模型Stable LM 2-12B

4月9日,著名大模型開源平臺Stability.ai在官網開源了,全新類ChatGPT模型Stable LM 2 12B。

據悉,Stable LM 2 12B有120億參數,使用了英語、西班牙語、德語等7種語言2萬億tokens的訓練數據。一共有基礎模型和指令微調兩個版本,能生成文本、代碼等內容,還能作為RAG的核心來使用。

同時,Stability.ai還對之前發布的模型Stable LM 2 1.6B進行了更新,尤其是在硬件需求方面進行了大幅度優化。所以,這兩款模型非常適合小企業、個人開發者使用。其性能也超過了Qwen1.5-14B-Chat、Mistral-7B-Instruct-v0.2等知名開源同類小參數模型。

12B開源地址:??https://huggingface.co/stabilityai/stablelm-2-12b??

1.6B新版本:??https://huggingface.co/stabilityai/stablelm-2-1_6b-chat??

技術報告:??https://arxiv.org/abs/2402.17834??

在線demo:https://huggingface.co/spaces/stabilityai/stablelm-2-chat

StableLM 2架構介紹

?

Stable LM 2 12B/1.6B皆使用的是Transformer架構,一共24層、32個自注意力頭,并使用大量公開且多樣化大約2萬億tokens的數據集進行了預訓練。

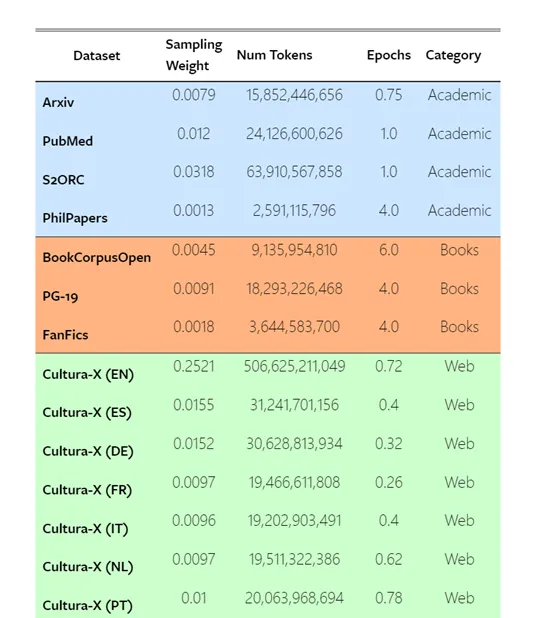

這些數據包括Arxiv、PubMed、S2ORC、PhilPapers等學術論文數據集,以及BookCorpusOpen、PG-19、FanFics等圖書和小說數據集。

Stability.ai還使用了來自Web的數據集,如Cultura-X、OpenWebText2、RefinedWeb等,以及來自社交媒體和法律領域的數據集。

此外,每個數據集都有相應的權重,為每個數據集提供了詳細的統計信息,包括標記數量、訓練時長等。還使用了一種創新的分詞技術,對原始分詞器進行了擴展,以便更好地壓縮代碼和非英文語言數據。

訓練策略方面,Stability.ai使用了一種稱為“FlashAttention-2”的高效序列并行優化技術,以4096的上下文長度從頭開始訓練StableLM 2。同時訓練過程中采用BFloat16混合精度,并使用標準的AdamW優化器進行訓練。

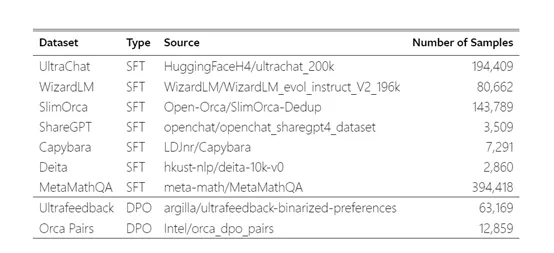

模型微調階段,Stability.ai使用了監督微調(SFT)、直接偏好優化(DPO)和自我知識學習三種方法,對生成的文本進行排序,然后使用排序結果來調整模型的參數,使其生成更符合人類偏好的文本。

StableLM 2測試數據

?

Stability.ai將兩款StableLM 2 模型在ARC、HellaSwag、MMLU、TriviaQA、Winograd、GSM8K等知名測試平臺上進行了綜合測試。

零樣本和少樣本基準測試方面,StableLM 2 1.6B在綜合平均分數上獲得45.3分,在1.6B以下模型中名列前茅,但仍低于一些更大的模型如phi-2和stablelm-3b-4e1t。

而Stable LM 2 12B的性能超過了Qwen1.5-14B-Chat、Mistral-7B-Instruct-v0.2等模型,略低于mistralai/Mixtral-8x7B-Instruct-v0.1。

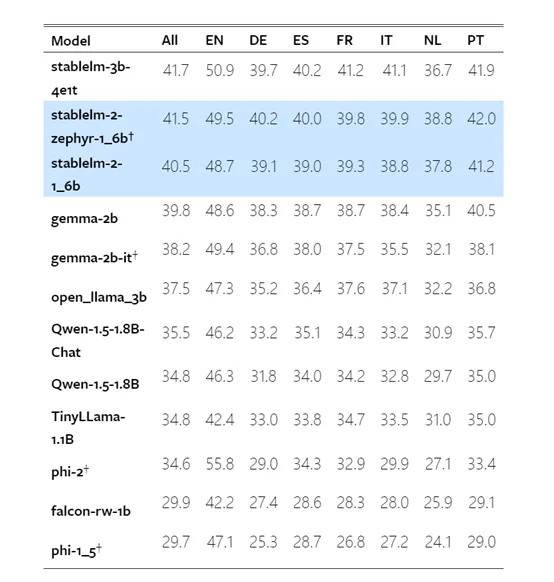

多語言基準測試:StableLM 2 1.6B在不同語種任務上的表現都很出色,在所有語種的綜合分數為40.5分,在英語任務上得分48.7分、德語39.1分、西班牙語39.0分等。

多輪對話基準測試:StableLM 2 1.6B與其他模型在MT-Bench多輪對話任務上進行了深度對比。StableLM 2 1.6B的綜合得分與規模明顯更大的模型如Mistral-7B和MPT-30B不相上下,在某些指標上甚至獲得了更高的分數。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區