大模型技術的重點與難點,以及在實際操作中需要注意的事項 原創

?大模型(Large Model, 如GPT、PaLM、LLaMA等)的重點與難點在于它們的構建、訓練、應用以及部署過程中涉及到的多方面挑戰。以下從技術、資源、應用等角度詳細說明其重點與難點。

1. 大模型的重點

(1) 規模與性能

- 參數規模:大模型的核心是參數量通常達到數十億甚至萬億級別,參數的規模直接影響模型的表達能力和推理能力。

- 多模態擴展:部分大模型支持跨模態輸入(如文本、圖像、音頻等),需要對不同模態的數據進行融合建模。

- 通用性:大模型被設計為在多任務上表現出色,具備較強的通用性,減少了針對特定任務的重新訓練需求。

- 零樣本學習(Zero-shot Learning)與小樣本學習(Few-shot Learning):通過少量上下文信息或提示,就能在新的任務中表現良好。

(2) 訓練方法與優化

- 預訓練:利用大規模無監督數據進行預訓練,獲取通用特征。

- 微調(Fine-tuning):在特定任務上進行微調以優化性能。

- 提示工程(Prompt Engineering):通過設計輸入提示(Prompt)提高模型的表現。

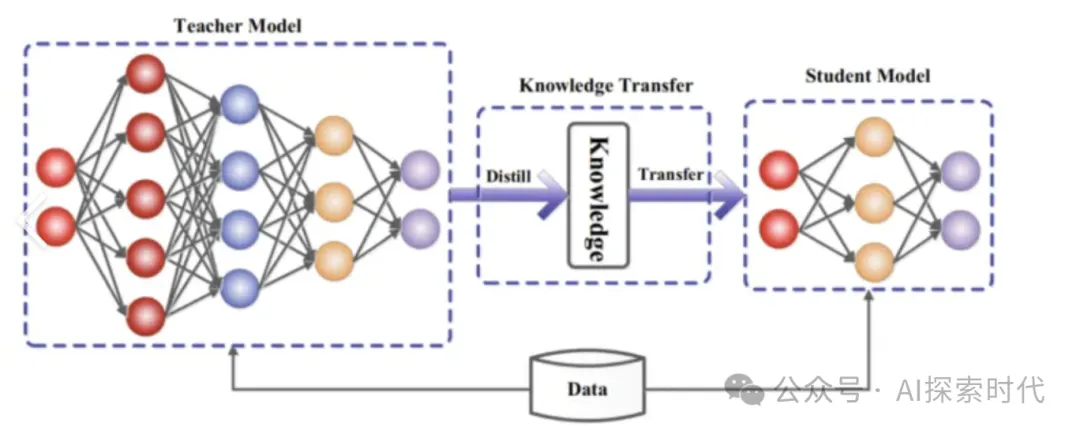

- 蒸餾與剪枝:減少模型的計算復雜度,同時保留性能。

(3) 數據質量與多樣性

- 數據收集與清洗:大模型需要多模態、多語言、大規模的數據作為訓練語料,數據的質量和多樣性直接影響模型性能。

- 數據標注:高質量的標注數據能顯著提升微調任務中的表現。

- 長尾數據處理:解決低頻或邊緣案例的表現問題。

(4) 推理與部署

- 推理速度:大模型需要高效的推理能力,以適應實時應用的需求。

- 可擴展性:支持分布式計算和大規模并發用戶訪問。

- 節能優化:通過模型壓縮、剪枝、蒸餾等手段,降低能耗和部署成本。

2. 大模型的難點

(1) 計算資源消耗

- 計算需求高:訓練大模型需要大規模的 GPU/TPU 集群和高效的分布式訓練框架。

- 能耗問題:大規模訓練和推理的能耗非常高,不僅增加成本,也帶來環保問題。

- 顯存和內存限制:大模型需要巨大的顯存支持,在推理時尤其需要高效的顯存管理。

(2) 數據挑戰

- 數據量需求大:大模型需要 TB 級甚至 PB 級的數據來訓練。

- 數據質量控制:噪聲數據、偏差數據可能會影響模型性能和公平性。

- 隱私與合規問題:使用公共或私人數據訓練模型時,需要遵守相關法律法規(如 GDPR)。

(3) 訓練與優化難題

- 訓練穩定性:大規模模型容易在訓練中出現梯度爆炸、梯度消失等問題。

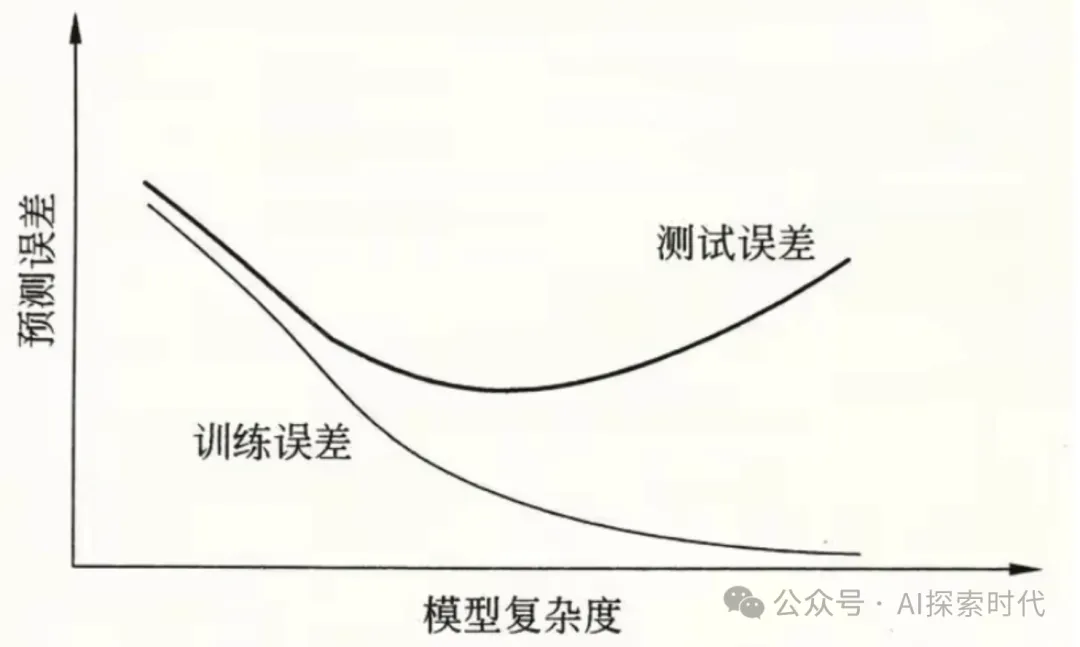

- 模型收斂難:模型規模越大,訓練時間越長,超參數調優的難度也成倍增加。

- 優化難度高:需要結合分布式優化器、混合精度訓練等技術才能完成高效訓練。

(4) 推理效率與延遲

- 實時推理挑戰:大模型推理速度較慢,無法直接用于低延遲場景。

- 硬件依賴強:需要高性能硬件支持(如 A100、H100 GPU),普通設備難以運行。

- 模型壓縮難度:在保證模型性能的同時進行壓縮非常具有挑戰性。

(5) 安全性與可靠性

- 輸出不可控:大模型可能生成錯誤、有害或不適當的內容。

- 魯棒性不足:對對抗樣本、噪聲數據的敏感性較高,容易出錯。

- 公平性與偏見:大模型可能繼承或放大訓練數據中的偏見和歧視,帶來倫理問題。

(6) 多語言與多模態挑戰

- 語言偏向:對于低資源語言(如小語種),模型性能往往較差。

- 跨模態融合:在多模態任務中,如何讓模型有效理解和關聯不同模態的信息是難點。

- 遷移學習難度:多模態數據的特性差異大,如何跨模態遷移知識尚存技術壁壘。

(7) 應用部署難題

- 實時性與并發:如何在高并發下保證低延遲推理是大規模應用的一大挑戰。

- 動態負載:在流量激增的情況下,如何動態分配計算資源。

- 跨平臺支持:需要適配不同設備(如移動端、服務器、嵌入式設備)。

3. 應對重點與難點的技術方向

(1) 計算與優化技術

- 分布式計算:利用分布式框架(如 PyTorch Distributed、DeepSpeed)提升訓練效率。

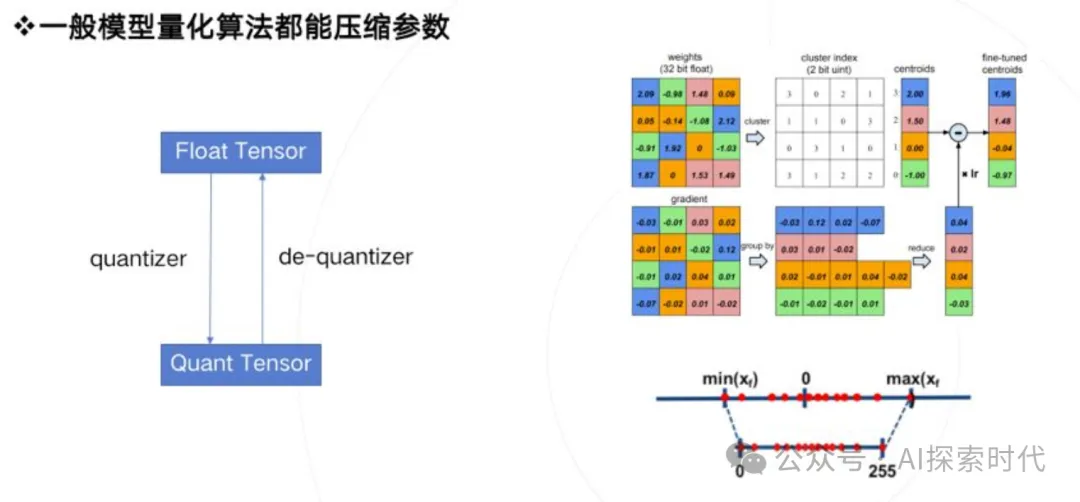

- 量化與蒸餾:通過混合精度訓練、量化和知識蒸餾降低計算需求。

- 分片并行與流水線并行:通過切分模型參數、流水線并行訓練提升訓練效率。

(2) 數據技術

- 高質量數據構建:構建多樣化、高質量的訓練數據集,減少偏差和噪聲。

- 主動學習與自監督學習:降低對人工標注數據的依賴,提升數據效率。

(3) 模型架構優化

- 輕量化模型:設計高效的模型架構(如 MobileBERT、DistilGPT)。

- 新型模型設計:探索如混合專家模型(Mixture of Experts, MoE)等動態架構。

(4) 安全與倫理

- 內容過濾:建立生成內容的監控與過濾機制,避免有害信息傳播。

- 去偏與公平性優化:在訓練數據和模型設計上減少對特定人群的偏見。

4. 實例舉例

重點:GPT-4 的通用性

- GPT-4 在文本生成、代碼編寫、多語言支持等方面表現優異,主要得益于其大規模的預訓練數據和優化的訓練架構。

- 它通過提示工程實現了小樣本學習能力,使得用戶無需微調即可在特定任務中使用模型。

難點:PaLM 的資源需求

- Google 的 PaLM 模型(540B 參數)訓練時使用了 6144 個 TPU v4,耗費了數周時間,展示了大模型在訓練資源上的高需求。

- 為提升推理效率,團隊使用了模型剪枝和蒸餾等技術。

總結

重點:

- 模型規模化和通用性

- 高質量數據與優化技術

難點 :

- 計算資源和能耗的限制

- 推理效率與實時性挑戰

- 數據安全、倫理與公平性問題

在大模型技術的推進過程中,計算、數據、優化、應用場景四個方面始終是關鍵,同時需要平衡技術性能與實際可用性之間的矛盾。

?

本文轉載自公眾號AI探索時代 作者:DFires

?著作權歸作者所有,如需轉載,請注明出處,否則將追究法律責任

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦