大模型在零樣本面部情緒標注中的突破與應用 精華

情緒識別作為人機交互中的關鍵一環,能夠提升智能系統的反應靈敏度和人性化程度。但是傳統的情緒標注方法面臨著諸多挑戰和局限性,人工情緒標注過程既耗時又昂貴,并且標注員可能會因個人主觀性帶來不同的評估標準,從而影響標注的一致性和準確性。

人工標注不僅成本高且效率低下,標注員需要長時間精心標注數據,這不但要求大量人力資源,還會引入人類認知中的固有變異性和潛在偏見。情緒標注任務的主觀性和細微差別增加了標注的復雜性。探索高效、準確的自動化情緒標注方法迫在眉睫,以減輕人工負擔并提高標注質量。

2 月 20 日,arXiv發表的《Benchmarking Zero-Shot Facial Emotion Annotation with Large Language Models: A Multi-Class and Multi-Frame Approach in DailyLife》探索了大型語言模型(LLMs)在零樣本面部情緒標注中的可行性,并評估其在多類和多幀情緒分類任務中的性能。通過采用GPT-4o-mini模型進行快速零樣本標注,研究團隊希望發現一種既能減少標注成本,又能提高標注效率的新策略。研究還將探討多幀整合和情緒分類簡化方法在提高標注準確性方面的作用,為今后大規模情緒標注任務提供指導。

本研究由賓夕法尼亞州立大學信息科學與技術學院的He Zhang和中國清華大學未來實驗室的Xinyi Fu共同完成。He Zhang專注于人工智能、計算機視覺和自然語言處理技術的應用,尤其是情緒識別和人機交互領域。Xinyi Fu則致力于人工智能與多模態交互的應用,特別關注提升大規模數據處理和注釋的效率與準確性。兩位華人研究者結合跨國合作的優勢,旨在探索LLMs在情緒標注中的應用潛力,推動技術進步并為實際應用提供成本效益高且可擴展的解決方案。

相關工作

在情緒標注領域,傳統的人工標注方法一直占據主導地位。標注員通過觀察視頻或圖像,依靠自身的理解和判斷,對人類情緒進行分類和標注。雖然這種方法能提供高度準確的標注,但由于其勞動密集型特性,導致了高成本和低效率。此外,標注員之間的主觀性差異和評估標準的不同,使得標注結果存在一致性問題,這進一步加劇了標注過程的復雜性。

為了提高標注效率和降低成本,研究人員提出了半自動化和自動化的情緒標注方法。半自動化方法結合了人工和自動化標注技術,通過模型初步標注后再由人類標注員進行審核和修改。這種方法在一定程度上提高了效率,但仍無法完全擺脫人工干預。隨著計算機視覺和機器學習技術的發展,全自動化的標注方法逐漸興起。這些方法依賴于訓練好的模型來自動識別人類情緒,大大減少了人工參與,顯著提高了標注效率。

眾包標注是一種加速標注過程的有效手段。通過將標注任務分配給大量的眾包人員,可以快速完成大量數據的標注工作。然而眾包標注在處理需要細致理解和專家判斷的任務時,常常表現不足。眾包標注的質量控制也是一大挑戰,需要設計合理的機制來確保標注結果的準確性和一致性。

大型語言模型(LLMs)的崛起為情緒標注領域帶來了新的機遇。LLMs 在自然語言處理中的成功使其在多模態任務中的應用成為可能。近年來研究人員開始探索LLMs在文本、圖像和音頻等多模態數據中的應用,尤其是在情緒識別和標注任務中的表現。

現有的研究表明,LLMs在情緒識別和標注任務中具備一定的潛力。例如,一些研究評估了LLMs從圖像生成的字幕中預測情緒的能力、進行圖像檢索和生成描述性字幕的能力。值得注意的是,2024年初的一項研究將GPT-4和Bard等LLMs與卷積神經網絡(CNNs)等傳統監督模型在圖像數據情緒識別方面的性能進行了比較。結果表明,專門為此任務訓練的深度學習模型通常比LLMs具有更高的準確性,但LLMs在降低訓練和應用成本方面表現出色。

雖然傳統的監督模型在準確性上仍占據優勢,但LLMs通過優化提示工程和重組標注策略,能夠實現與傳統模型相當的性能,同時具備更高的成本效益和可擴展性。因此,研究人員不斷探索LLMs在情緒標注任務中的應用,特別是在多模態數據處理和零樣本學習方面,LLMs展示出巨大的潛力。

方法

在本研究中,研究團隊探索了大型語言模型(LLMs)在零樣本面部情緒標注中的可行性,并評估了其在多類和多幀情緒分類任務中的性能。

數據集選擇

研究團隊選擇了公開的FERV39k數據集,該數據集包含了豐富的視頻片段,涵蓋多種日常生活中的情緒表達。FERV39k數據集中的DailyLife子集尤為重要,因為它包含了日常活動、互動和情緒表達的場景,是現實條件的代表,增強了研究團隊研究工作的可轉移性和適用性。

在該數據集中,情緒被分為七類:“憤怒”、“厭惡”、“恐懼”、“快樂”、“中立”、“悲傷”和“驚訝”。這些情緒類別為情緒識別任務提供了一個全面的分類框架。研究團隊之所以選擇DailyLife子集,是因為它包含2339個視頻片段,每個片段都被手動標注了明確的情緒標簽,并基于上下文和可見的情緒線索提供了準確的標簽。這為研究團隊的研究提供了一個廣泛認可的基準。

模型選擇

研究團隊選擇了GPT-4o-mini模型,這是GPT-4架構的一個變體,優化了效率和快速推理能力。選擇GPT-4o-mini的理由主要有兩個方面:首先,它具備強大的零樣本學習能力,能夠在無需特定任務訓練的情況下執行任務;其次,它集成了視覺能力,能夠接受圖像輸入并解釋圖形信息,適合多模態處理。

在成本和性能方面,GPT-4o-mini在保證高效性能的同時,能夠平衡操作成本,成為本研究的理想選擇。

標注過程設計

在標注過程中,研究團隊采用了零樣本標注策略,直接應用LLMs進行情緒分類。模型根據簡單的預定義指令對提取的關鍵幀進行標注,無需額外的訓練或微調。這種策略不僅加快了標注速度,還降低了操作成本。

提示工程(Prompt Engineering)

為了有效利用GPT-4o-mini模型進行圖像情緒標注,研究團隊精心設計了提示,以指導模型生成準確的情緒標簽。初始提示設定模型為“專業圖像情緒分析助手”,明確列出了預定義情緒標簽,確保模型在期望的上下文中操作并理解分類框架。每個圖像(或多幀整合圖像)的分析提示中,包括了文本指令和圖像本身,通過這種多模態輸入的方式,使模型能夠同時處理視覺和文本數據。

標注策略

研究團隊采用了多種標注策略,以評估大型語言模型(LLMs)在不同情緒分類任務中的表現。這些策略分為七類情緒分類策略和三類情緒分類策略。

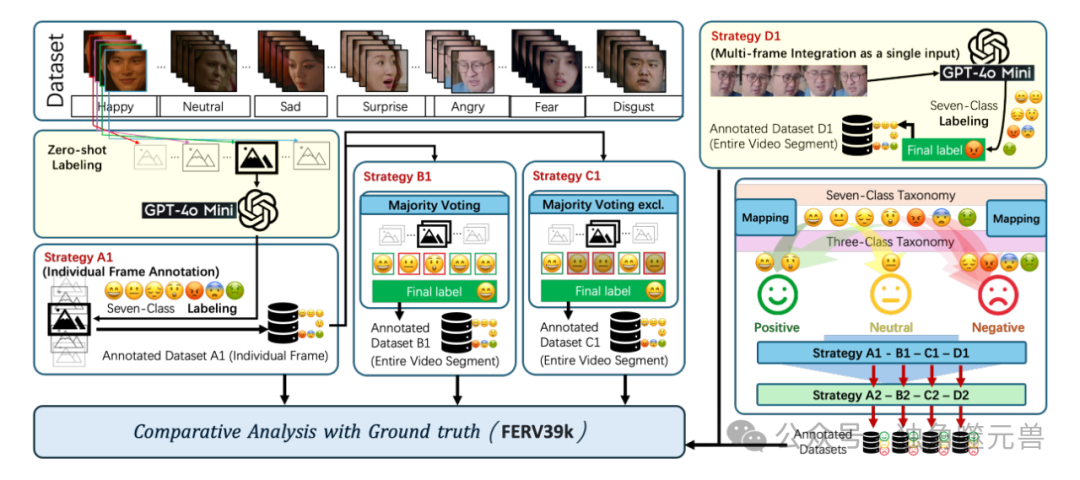

圖1:視頻(圖像/片段)數據中情感識別的多策略注釋框架說明

七類情緒分類策略

策略A1:單幀標注

該策略基于對每個視頻片段中的五個選定幀進行獨立標注。這些選定幀包括初始幀、Q1位置幀、中間幀、Q3位置幀和最終幀。每個幀被獨立地標注為七類情緒中的一種:“憤怒”、“厭惡”、“恐懼”、“快樂”、“中立”、“悲傷”和“驚訝”。每個幀的預測情緒標簽與數據集中提供的真實標簽進行比較,以計算準確性。

策略B1:多數投票決定主要情緒

在策略B1中,所有五個標注幀的情緒標簽進行匯總,以確定整個視頻片段的主要情緒。如果某種情緒在標注幀中占絕對多數,則該情緒標簽被分配給整個視頻片段。在情緒分布平局的情況下,選擇中間幀的情緒標簽作為視頻片段的整體情緒狀態。

策略C1:排除“中立”后的多數投票

策略C1在確定主要情緒時排除“中立”類別。如果在排除“中立”后某種情緒在標注幀中占絕對多數,則該情緒被分配給視頻片段。如果五個幀均被標記為“中立”,則該片段被分配“中立”標簽。在情緒分布平局的情況下,選擇中間幀的情緒標簽代表整個視頻片段的情緒狀態。這一方法旨在通過聚焦更明顯的積極或消極情緒狀態,提高標注準確性,減輕LLMs在分類“中立”情緒時的歧義性。

策略D1:多幀整合后整體標注

策略D1采用多幀整合方法,將五個選定幀連接成一個復合輸入。具體而言,將初始幀、Q1位置幀、中間幀、Q3位置幀和最終幀按順序連接形成統一的圖像輸入,并將其提交給GPT-4o-mini模型進行單步驟標注。通過整合多個幀,該策略利用時間上下文,使模型能夠考慮視頻片段內情緒的進展,提高標注準確性,捕捉單個幀標注可能錯過的情緒過渡狀態。

大模型在零樣本面部情緒標注中的突破與應用-AI.x社區

大模型在零樣本面部情緒標注中的突破與應用-AI.x社區

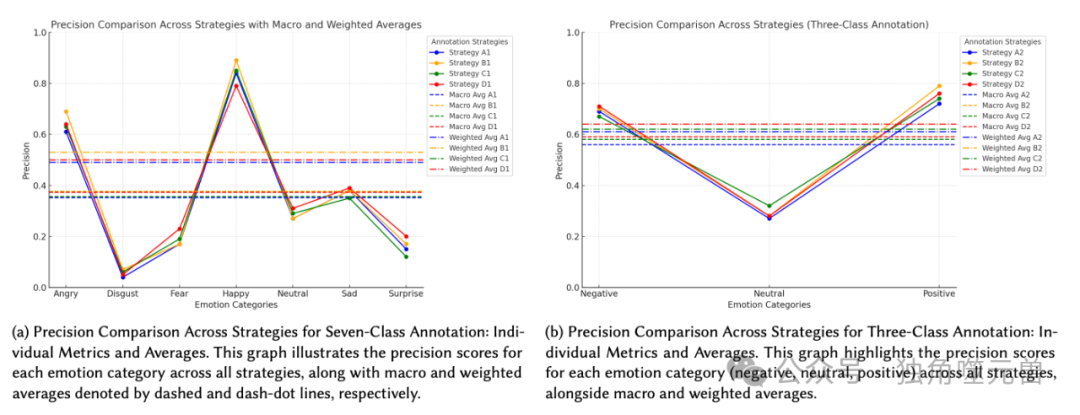

圖2:七類和三類注釋策略的精度比較。這兩張圖都展示了每種策略的單獨指標和總體平均值(宏觀和加權)

三類情緒分類策略

策略A2:將七類映射為三類進行標注

策略A2將策略A1的結果應用于三類情緒分類。在此策略中,策略A1中的每個標注幀直接映射到三個更廣泛的類別之一:“積極”、“中立”或“消極”。具體而言,被分類為“憤怒”、“厭惡”、“恐懼”和“悲傷”的情緒歸類為“消極”,而“快樂”和“驚訝”歸類為“積極”。“中立”標簽保持不變。每個幀的七類標簽根據此映射轉換為相應的三類標簽,然后計算準確性,以評估模型在簡化情緒分類任務中的表現。

策略B2:三類情緒的多數投票

策略B2首先應用策略A2,將七類標簽重新組織為三類。然后采用類似于策略B1的方法,返回占絕對多數的情緒標簽,或在情緒趨勢得分平局時使用中間幀的情緒標簽。

策略C2:排除“中立”后的三類多數投票

策略C2首先應用策略A2,將七類標簽重新組織為三類,然后采用類似于策略C1的方法,減輕LLMs在分類“中立”情緒時的歧義性。

策略D2:多幀整合后的三類情緒標注

策略D2類似于策略D1的多幀整合方法,但使用三類分類方法。在此策略中,五個選定幀被連接成一個復合輸入,并將其提交給GPT-4o-mini模型,為整個視頻片段分配單一的三類情緒標簽(“積極”、“中立”或“消極”)。

這些標注策略為研究團隊提供了全面評估LLMs在零樣本情緒標注任務中的性能的機會,并幫助研究團隊發現最佳的標注方法,以提高準確性和效率。

實驗結果與分析

在評估情緒分類策略時,研究團隊采用了精度、召回率、F1分數、支持度和準確率等指標。精度(Precision)衡量的是模型正確預測的正樣本占所有預測為正樣本的比例。召回率(Recall)反映了模型能識別出所有真實正樣本的能力。F1分數是精度和召回率的調和平均數,平衡了二者,特別適用于類別分布不均的情況。準確率(Accuracy)則是所有正確預測樣本占總樣本的比例。此外,研究團隊還報告了宏平均(Macro Average)和加權平均(Weighted Average)兩個指標。宏平均將每個類別視為同等重要,計算各類別精度和召回率的平均值,而加權平均則根據每個類別的支持度(Support,即每個類別的真實樣本數量)進行加權,以反映類別不平衡的影響。

七類情緒分類結果

對于七類情緒分類,研究團隊采用了四種不同的標注策略(A1、B1、C1和D1)。策略A1的整體準確率為38%,在“快樂”類別的精度達到0.84,但在“厭惡”類別的精度僅為0.04,顯示出模型在某些情緒分類上的顯著挑戰。策略B1通過多數投票的方式,略微提升了整體準確率至41%,尤其在“快樂”類別上精度上升至0.89,而“厭惡”類別也有小幅改善。策略C1通過排除“中立”類別的多數投票,將整體準確率提升至46%,特別是在“悲傷”類別的召回率提高到0.76,顯示出通過專注于更明顯的情緒狀態,可以減輕“中立”分類帶來的不準確性。策略D1采用多幀整合方法,與策略C1達到相同的46%準確率,通過整合多個幀的時間上下文,捕捉到情緒動態變化,進一步提高了模型的情緒識別能力。

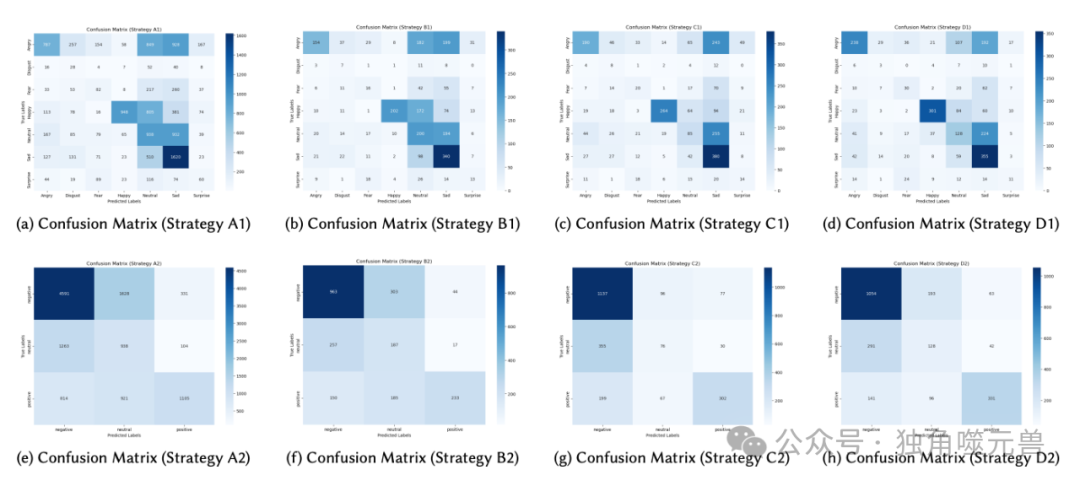

分析混淆矩陣可以發現,各策略在區分“中立”和“快樂”等細微情緒變化時仍存在挑戰,但通過聚合多個幀或排除“中立”類別,可以顯著提升某些類別的識別準確率。

三類情緒分類結果

對于三類情緒分類(A2、B2、C2和D2),策略簡化顯著提高了模型性能。策略A2實現了57%的準確率,“積極”類別精度為0.72,而“中立”類別表現一般,精度為0.27,召回率為0.41。策略B2通過多數投票,準確率提高至65%,“積極”類別精度上升至0.79,“消極”類別表現強勁,精度為0.70,召回率為0.74。策略C2采用排除“中立”類別的多數投票,也達到了65%的準確率,“消極”類別精度為0.67,召回率提升至0.87,而“積極”類別保持一致性能。策略D2采用多幀整合方法,同樣實現了65%的準確率,通過利用時間上下文和簡化情緒類別,確保了高效且準確的標注。

圖3:使用混淆矩陣的分類策略的性能比較。每個混淆矩陣代表數據集上特定策略的分類結果。

通過混淆矩陣分析,可以看到,三類分類策略在“中立”和“積極”情緒之間的混淆情況較多,而對“消極”情緒的識別準確性較高。這表明在簡化情緒分類的情況下,模型能夠更有效地區分主要情緒狀態,從而提升整體性能。

不同策略的性能總結

在七類和三類情緒分類任務中,各種標注策略展現了不同的性能。通過實驗,研究團隊發現策略的聚合和整合方法在提升標注準確性方面尤為有效。策略B1、C1和D1中的多數投票和多幀整合策略在情緒識別中表現出色,通過匯總多個標注幀或整合時間上下文,能夠捕捉到視頻片段內的情緒進展,增強了模型對情緒動態變化的理解。這些策略在處理復雜多變的情緒表達時,顯著提高了模型的表現。

聚合和整合方法的有效性

聚合方法通過匯總多個幀的情緒標注,減少了單一幀標注帶來的誤差和不一致性。在多數投票策略下,通過對視頻片段內多個幀的情緒進行綜合考慮,能夠提高整體標注的準確性。多幀整合策略則通過將多個關鍵幀整合為一個復合輸入,使模型能夠考慮情緒的時間上下文。這種方法不僅提高了標注的準確性,還能夠捕捉到單個幀標注可能錯過的情緒過渡狀態,從而提供更全面的情緒識別。

時間上下文在情緒識別中的作用

在情緒識別中,時間上下文起到了至關重要的作用。情緒的表達往往是一個動態的過程,通過整合多個時間點的情緒信息,模型能夠更好地捕捉到情緒的變化和發展趨勢。多幀整合策略利用時間上下文,通過考慮視頻片段內情緒的進展,顯著提高了模型的情緒識別能力。時間上下文的引入,使模型能夠更準確地識別情緒過渡和細微變化,從而提高整體標注的質量。

與基線的比較

為了驗證研究團隊標注策略的有效性,研究團隊將其與隨機猜測基線和現有訓練模型基線進行了比較。

隨機猜測基線

在七類情緒分類任務中,隨機猜測的預期準確率約為14.3%。在三類情緒分類任務中,隨機猜測的預期準確率為33.3%。研究團隊的實驗結果表明,所有提出的策略均顯著超過了隨機猜測的基線水平。例如,在七類分類任務中,表現最好的策略(C1和D1)達到了46%的準確率,是隨機猜測基線的三倍多。在三類分類任務中,策略B2、C2和D2達到了65%的準確率,幾乎是隨機猜測基線的兩倍。這一顯著的改進表明,研究團隊的聚合和整合方法在基于LLMs的零樣本分類任務中提高了標注準確性。

現有訓練模型基線

為了進一步驗證研究團隊的標注策略,研究團隊將其與FERV39k數據集論文中報告的基線模型進行了比較。基線模型包括ResNet-18(R18)、ResNet-50(R50)、VGG13(VGG13)、VGG-16(VGG16)及其LSTM增強變體。這些模型的性能指標包括加權平均召回率(WAR)和非加權平均召回率(UAR)。其中,VGG13-LSTM和Two VGG13-LSTM模型表現最佳,分別達到46.07%和46.92%的WAR。

相比之下,研究團隊的策略D1(多幀整合)在七類分類任務中實現了46%的WAR,接近這些頂尖基線模型的性能。此外,策略D1還顯著超過了基線模型的平均WAR(約38.98%)。在UAR方面,策略D1在各類情緒的召回率方面表現優異,超過了所有基線模型。這表明研究團隊的策略不僅在整體加權表現上表現出色,還確保了所有情緒類別的公平識別,包括不常見的類別。

成本效益與可擴展性

研究團隊詳細考慮了模型的成本效益和可擴展性,這對于大規模情緒標注任務尤為關鍵。

模型成本考慮

最初,研究團隊測試了全幀率標注方法,即為每秒的視頻片段標注25幀圖像。然而,由于任務量巨大,該方法的財務可行性極低。根據初步估算,這種全幀率標注的API成本大約為每11,000張圖像100美元,顯然這種高成本方法無法在大規模應用中持續進行。因此,他們需要找到一種更具成本效益的解決方案。

全幀率標注的成本估算

對于每秒25幀的全幀率標注,成本快速累積。假設每幀圖像的標注成本為0.01美元,對于一個包含2,339個視頻片段、每個視頻片段時長為1-2秒的數據集,總成本將達到數千美元。這種高昂的成本使得全幀率標注在實際應用中難以維持。

采用關鍵幀和多幀整合策略的成本節約

為了降低成本,研究團隊采用了關鍵幀選擇和多幀整合策略。具體而言,從每個視頻片段中選擇五個關鍵幀(初始幀、Q1位置幀、中間幀、Q3位置幀和最終幀),并將這五個幀整合為一個復合輸入。這種方法不僅減少了標注的幀數,還顯著降低了令牌使用量。通過這種策略,研究團隊大幅度減少了API請求的數量,從而降低了整體標注成本,同時保持了較高的標注準確性。

運營成本與標注效率的權衡

在平衡運營成本與標注效率時,研究團隊的策略顯示出了明顯優勢。通過零樣本標注,研究團隊能夠在無需特定任務訓練的情況下,快速部署和適應各種標注任務,極大地提高了標注效率。與傳統的監督模型相比,零樣本標注不僅減少了訓練成本,還避免了因數據標注需求而產生的額外資源消耗。這使得研究團隊的標注方法在大規模應用中更加經濟可行。

零樣本標注在實際應用中的經濟可行性

本研究中的零樣本標注方法展示了良好的經濟可行性。通過采用GPT-4o-mini模型,研究團隊能夠在不進行特定任務訓練的情況下,快速且準確地進行情緒標注。這種方法不僅降低了模型訓練和應用的成本,還提高了標注任務的擴展性,使其能夠適應不同情緒標注任務的需求。

大規模情緒標注任務的可擴展性

研究團隊的零樣本標注策略在大規模情緒標注任務中展現了極大的可擴展性。通過關鍵幀選擇和多幀整合策略,研究團隊能夠在降低成本的同時,保持較高的標注準確性。這種高效的標注方法為大規模情緒識別任務提供了一種可行的解決方案,適用于各種實際應用場景,如駕駛員注意力檢測、直播平臺內容管理和健康管理系統。

討論

自動化標注的效率和速度是LLMs的顯著優勢。通過利用大型語言模型,研究團隊能夠在零樣本的情況下,快速進行情緒標注,而無需花費大量時間進行特定任務的模型訓練。LLMs能夠根據預定義的指令和提示,在沒有先驗知識的情況下,準確分類和標注情緒,這大大提高了標注效率和速度。

然而,LLMs在辨別細微情緒差異時仍存在挑戰。盡管模型在處理主要情緒類別時表現出色,但在區分類似情緒如“快樂”和“驚訝”時,準確率會有所下降。這主要是因為情緒表達的主觀性和復雜性,加之LLMs在處理多樣化和細微變化的數據時,容易受到模型本身的局限性影響。

聚合技術和時間上下文在情緒識別中的影響非常重要。多幀信息的整合顯著提高了情緒識別的準確率。通過聚合來自多個時間點的情緒數據,模型能夠更全面地捕捉情緒的動態變化,從而提供更準確的標注結果。時間上下文的整合使模型在識別連續變化的情緒時表現更佳,避免了單幀標注可能導致的誤差和不一致性。

排除“中立”類別的策略效果顯著。通過專注于更加明顯的積極或消極情緒狀態,模型在情緒分類任務中的表現得到了提升。這一策略有效地減輕了LLMs在分類中立情緒時的歧義性,增強了情緒標注的準確性。

簡化情緒分類對提升模型性能有顯著作用。三類情緒分類法(“積極”、“中立”和“消極”)通過降低分類的復雜度,使模型能夠更有效地區分主要情緒狀態,提高了整體準確率。在復雜任務中,降低分類復雜度有助于提升模型的表現,同時減少分類錯誤。

任務復雜度與模型性能之間存在顯著關系。通過簡化分類任務,模型能夠更專注于主要情緒類別,減少因多樣化數據帶來的分類挑戰,從而提高標注的準確性和可靠性。

大型語言模型在情緒標注任務中的成功應用,展示了其在其他多模態數據標注任務中的巨大潛力。LLMs可以擴展到更廣泛的應用場景,如駕駛員注意力檢測、直播平臺內容管理和健康管理系統,通過高效的自動化標注,提高各類多模態數據處理的效率和準確性。

在實際應用中,LLMs的高效性和可擴展性對人機交互和情感計算領域有深遠影響。通過自動化情緒識別,智能系統可以更靈敏地響應用戶的情緒變化,提供更人性化和個性化的服務,提升用戶體驗。此外,LLMs在情感計算中的應用,將進一步推動人機交互技術的發展,實現更加自然和流暢的交流互動。(END)

參考資料:https://arxiv.org/pdf/2502.12454

本文轉載自??獨角噬元獸??,作者: FlerkenS