?探索Sora背后秘密:結合OpenAI Sora技術報告來看其能力和技術點 精華

最近被Sora刷屏,今天結合OpenAI Sora的技術報告Video generation models as world simulators來看下Sora具備哪些能力,以及這些能力是怎么來的。功能上除了文生圖,還支持以圖片、視頻作為prompt,極大拓展使用場景。技術上,利用spacetime patches,統一了時空分割語言,為后續模型訓練以及使用場景的拓展打下基礎。數據側在準備高質量的caption數據做了專門的優化。另外模型基礎架構采用Diffusion Transformer,通過Scalling,顯著提升生成質量。

技術:將視頻信息處理成spacetime patches,統一了時空分割的語言,方便支持不同尺寸、時間、分辨率的數據。使用Diffusion Transformer作為主干網絡進行建模,方便對模型規模進行擴展。訓練Video compression network降低視覺數據維度,在壓縮潛在空間訓練生成模型和解碼模型。通過Scalling顯著提升生成質量。

數據工程:通過專門訓練一個高度描述性的標題模型,或利用 GPT4 將簡短的用戶提示轉化成更長、更詳細的標題,來獲取高質量的每一幀圖像的標題;

能力:可以根據文本、圖片或視頻創建視頻,也可以做其他視頻編輯工具,如根據靜態圖片生成動態圖片、在時間上向前或向后拓展視頻、直接通過 prompt 提示詞修改視頻背景、插針融合兩個風格完全不同的視頻等;

涌現3D世界建模能力:能夠模擬物理世界中的人、動物和環境的變化,包括 3D 一致性、有效地模擬物體短程和遠程依賴關系、模擬簡單的動作來影響世界的狀態、模擬數字世界。

ps:為了防止個人理解出現問題,技術報告中英文原文和翻譯都有保留,視頻只截圖處理,原始視頻請看原報告。

一、概述

1.Motivation

- 之前視頻生成技術方案主要包括循環網絡[^1][^2][^3]、生成對抗網絡[^4][^5][^6][^7]、和擴散模型[^8][^9],這些工作主要關注一小部分類別的數據,并且只能生成一些時間長度較短或者時間固定的視頻。

- 能夠生成不同時長、長寬比和分辨率的視頻和圖像,長度達一分鐘的高清視頻的方案還沒出現。

2.Method

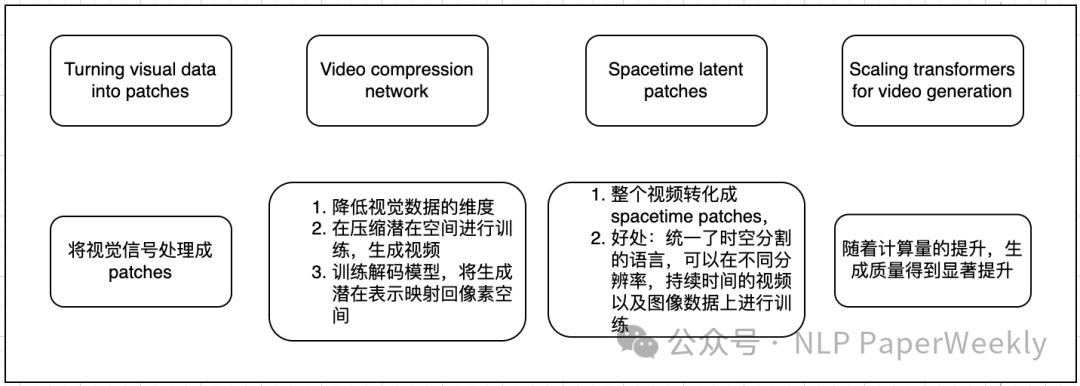

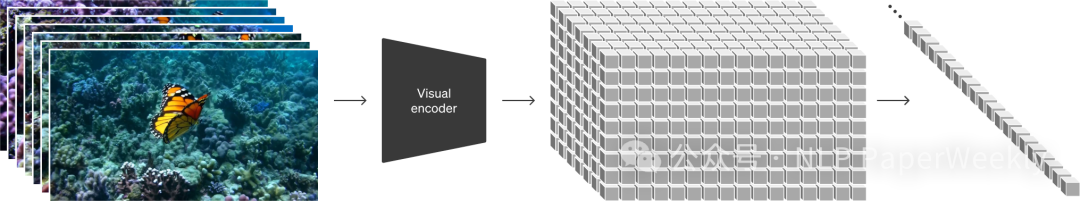

2.1 Turning visual data into patches

We take inspiration from large language models which acquire generalist capabilities by training on internet-scale data.13,14 The success of the LLM paradigm is enabled in part by the use of tokens that elegantly unify diverse modalities of text—code, math and various natural languages. In this work, we consider how generative models of visual data can inherit such benefits. Whereas LLMs have text tokens, Sora has visual patches. Patches have previously been shown to be an effective representation for models of visual data.15,16,17,18 We find that patches are a highly-scalable and effective representation for training generative models on diverse types of videos and images.

我們從大型語言模型中獲得靈感,這些模型通過在互聯網規模的數據上進行訓練來獲得通用能力。LLM 范式的成功在一定程度上是由于使用了令牌Token,這些令牌Token優雅地統一了文本的多種模式——代碼、數學和各種自然語言。在這項工作中,我們考慮視覺數據的生成模型如何繼承這些好處。雖然 LLM 具有文本令牌Token,但 Sora 具有視覺補丁Patches。之前已經表明,補丁Patches是視覺數據模型的有效表示。我們發現補丁Patches是一種高度可擴展且有效的表示形式,可以對不同類型的視頻和圖像進行生成模型的訓練。

2.2 Video compression network

We train a network that reduces the dimensionality of visual data.20 This network takes raw video as input and outputs a latent representation that is compressed both temporally and spatially. Sora is trained on and subsequently generates videos within this compressed latent space. We also train a corresponding decoder model that maps generated latents back to pixel space.

我們訓練了一個網絡來降低視覺數據的維度。這個網絡以原始視頻作為輸入,并輸出一個在時間和空間上都經過壓縮的潛在表示。Sora 在這個壓縮的潛在空間中進行訓練,并隨后生成視頻。我們還訓練了一個相應的解碼器模型,將生成的潛在表示映射回像素空間。

2.3 Spacetime latent patches

Given a compressed input video, we extract a sequence of spacetime patches which act as transformer tokens. This scheme works for images too since images are just videos with a single frame. Our patch-based representation enables Sora to train on videos and images of variable resolutions, durations and aspect ratios. At inference time, we can control the size of generated videos by arranging randomly-initialized patches in an appropriately-sized grid.

給定一個壓縮的輸入視頻,我們提取一系列spacetime patches 作為 Transformer 的tokens。該方案也適用于圖像,因為圖像只是具有單個幀的視頻。我們基于patch的表示使 Sora 能夠在具有不同分辨率、持續時間和縱橫比的視頻和圖像上進行訓練。在推理時,我們可以通過在適當大小的網格中排列隨機初始化的補丁來控制生成視頻的大小。

2.4 Scaling transformers for video generation

Sora is a diffusion model21,22,23,24,25; given input noisy patches (and conditioning information like text prompts), it’s trained to predict the original “clean” patches. Importantly, Sora is a diffusion transformer.26 Transformers have demonstrated remarkable scaling properties across a variety of domains, including language modeling,13,14 computer vision,15,16,17,18 and image generation.27,28,29

Sora 是一種擴散模型;在給定輸入噪聲patches(以及諸如文本提示之類的條件信息)的情況下,它經過訓練以預測原始的“干凈”補丁。重要的是,Sora 是一個擴散 Transformer。Transformer 已經在包括語言建模、計算機視覺、圖像生成等在內的多個領域中表現出了出色的擴展屬性。

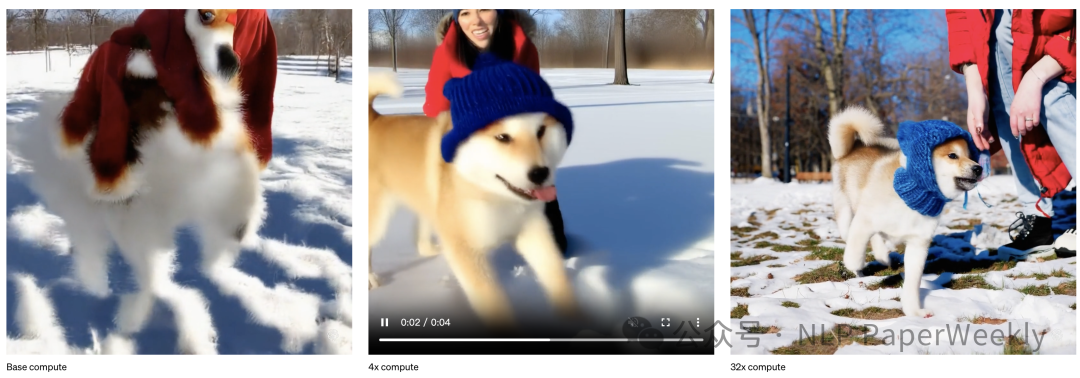

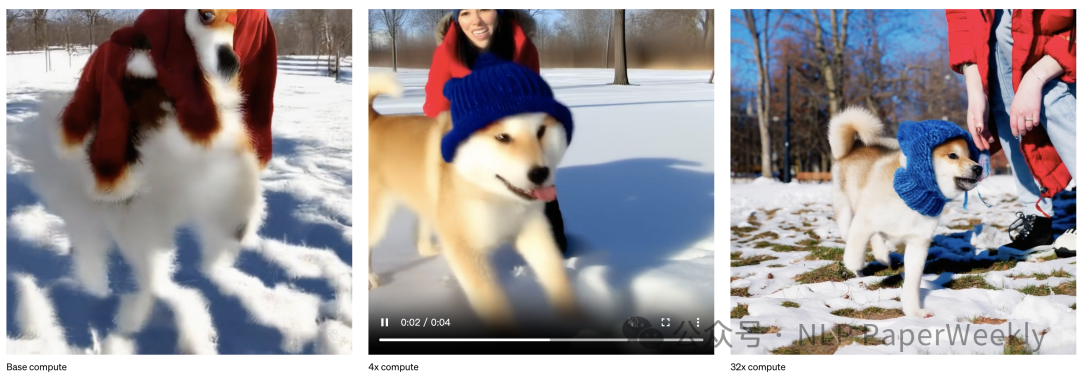

In this work, we find that diffusion transformers scale effectively as video models as well. Below, we show a comparison of video samples with fixed seeds and inputs as training progresses. Sample quality improves markedly as training compute increases.

在這項工作中,我們發現diffusion Transformer 作為視頻模型也具有出色的擴展能力。下面,我們展示了隨著訓練的進行,固定種子和輸入的視頻樣本的比較。隨著訓練計算的增加,樣本質量有了顯著的提高。

2.5 Variable durations, resolutions, aspect ratios

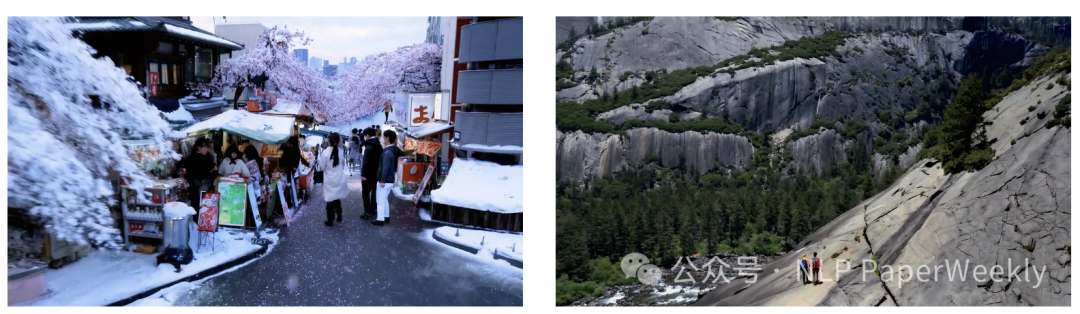

Past approaches to image and video generation typically resize, crop or trim videos to a standard size—e.g., 4 second videos at 256x256 resolution. We find that instead training on data at its native size provides several benefits.

過去的圖像和視頻生成方法通常會調整、裁剪或修剪視頻到標準尺寸——例如,4 秒的視頻,分辨率為 256x256。我們發現,在其原始大小的數據上進行訓練反而有幾個好處。

Sampling flexibility

Sora can sample widescreen 1920x1080p videos, vertical 1080x1920 videos and everything inbetween. This lets Sora create content for different devices directly at their native aspect ratios. It also lets us quickly prototype content at lower sizes before generating at full resolution—all with the same model.

Sora 可以采樣寬屏 1920x1080p 視頻、豎屏 1080x1920 視頻以及介于兩者之間的所有視頻。這使得 Sora 可以直接為不同設備創建與其原始寬高比匹配的內容。它還可以讓我們在生成全分辨率內容之前,先以較小的尺寸快速制作內容原型——所有這些都使用相同的模型。

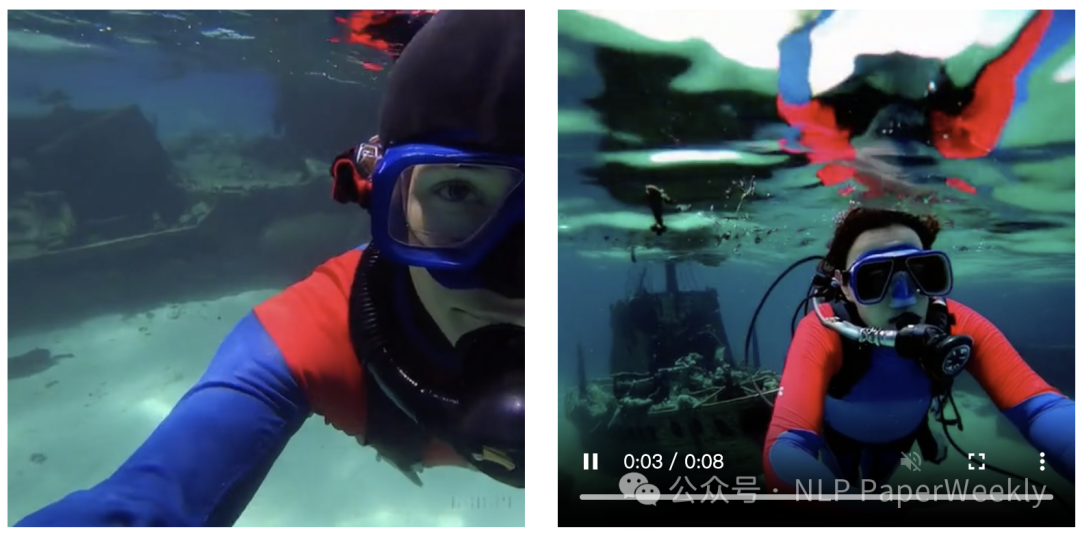

Improved framing and composition

We empirically find that training on videos at their native aspect ratios improves composition and framing. We compare Sora against a version of our model that crops all training videos to be square, which is common practice when training generative models. The model trained on square crops (left) sometimes generates videos where the subject is only partially in view. In comparison, videos from Sora (right) have improved framing.

我們通過實驗發現,以原始寬高比進行視頻訓練可以提高構圖和取景效果。我們將 Sora 與我們的另一個模型進行了比較,該模型將所有訓練視頻都裁剪成正方形,這是訓練生成式模型時常用的做法。經過方形裁剪訓練的模型(左側)有時會生成主體部分只在畫面中出現一部分的視頻。相比之下,Sora 生成的視頻(右側)取景效果更好。

2.6 Language understanding

Training text-to-video generation systems requires a large amount of videos with corresponding text captions. We apply the re-captioning technique introduced in DALL·E 330 to videos. We first train a highly descriptive captioner model and then use it to produce text captions for all videos in our training set. We find that training on highly descriptive video captions improves text fidelity as well as the overall quality of videos.

訓練文本到視頻生成系統需要大量帶有相應文本標題的視頻。我們將 DALL·E 3[^30] 中介紹的重寫標題技術應用于視頻。我們首先訓練一個高度描述性的標題模型,然后使用它為我們訓練集中的所有視頻生成文本標題。我們發現,在高度描述性的視頻標題上進行訓練可以提高文本保真度以及視頻的整體質量。

Similar to DALL·E 3, we also leverage GPT to turn short user prompts into longer detailed captions that are sent to the video model. This enables Sora to generate high quality videos that accurately follow user prompts.

與 DALL·E 3類似,我們還利用 GPT 將簡短的用戶提示轉化為更長、更詳細的標題,然后將其發送到視頻模型。這使得 Sora 能夠生成高質量的視頻,準確地遵循用戶提示。

3.Conclusion

強悍的視頻圖像生成、修改、融合等能力: 可以根據文本、圖片或視頻創建視頻,也可以做其他視頻編輯工具,如根據靜態圖片生成動態圖片、在時間上向前或向后拓展視頻、直接通過 prompt 提示詞修改視頻背景、插針融合兩個風格完全不同的視頻;

涌現3D世界建模能力: 能夠模擬物理世界中的人、動物和環境的變化,包括 3D 一致性、有效地模擬物體短程和遠程依賴關系、模擬簡單的動作來影響世界的狀態、模擬數字世界。

4.Limitation

Sora currently exhibits numerous limitations as a simulator. For example, it does not accurately model the physics of many basic interactions, like glass shattering. Other interactions, like eating food, do not always yield correct changes in object state. We enumerate other common failure modes of the model—such as incoherencies that develop in long duration samples or spontaneous appearances of objects—in our landing page.

Sora 作為模擬器目前存在許多限制。例如,它不能準確模擬許多基本交互的物理特性,如玻璃破碎。 其他交互,如進食,并不總是導致對象狀態的正確變化。我們在登錄頁面中列舉了模型的其他常見故障模式,例如在長時間采樣中出現的不一致或物體的自發出現。

二、相關應用

1.文本可以作為prompt,圖片或者視頻也行!

All of the results above and in our landing page show text-to-video samples. But Sora can also be prompted with other inputs, such as pre-existing images or video. This capability enables Sora to perform a wide range of image and video editing tasks—creating perfectly looping video, animating static images, extending videos forwards or backwards in time, etc.

上述所有結果和我們的登錄頁面均顯示了文本到視頻的示例。但 Sora 也可以使用其他輸入來作為提示,例如現有的圖像或視頻。此功能使 Sora 能夠執行各種圖像和視頻編輯任務-創建完美循環的視頻、為靜態圖像制作動畫、在時間上向前或向后擴展視頻等。

Animating DALL·E images(使用靜態圖生成動態圖片)

Sora is capable of generating videos provided an image and prompt as input. Below we show example videos generated based on DALL·E 231 and DALL·E 330 images.

Sora 可以根據輸入的圖像和提示生成視頻。下面我們展示一些基于 DALL·E 2和 DALL·E 3 圖像生成的示例視頻。

A Shiba Inu dog wearing a beret and black turtleneck.

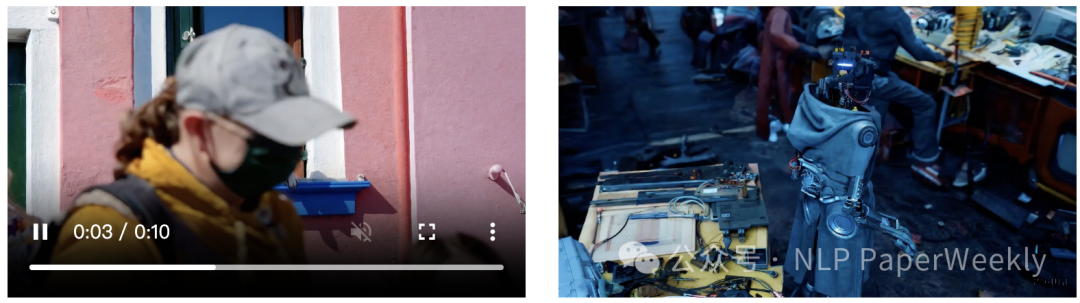

Extending generated videos(拓展視頻)

Sora is also capable of extending videos, either forward or backward in time. Below are four videos that were all extended backward in time starting from a segment of a generated video. As a result, each of the four videos starts different from the others, yet all four videos lead to the same ending.

Sora 還能夠延長視頻,無論是向前還是向后。以下是3個視頻,它們都是從生成的視頻的一個片段開始,然后向回擴展。因此,這四個視頻的起點各不相同,但它們都導向同一個結局。

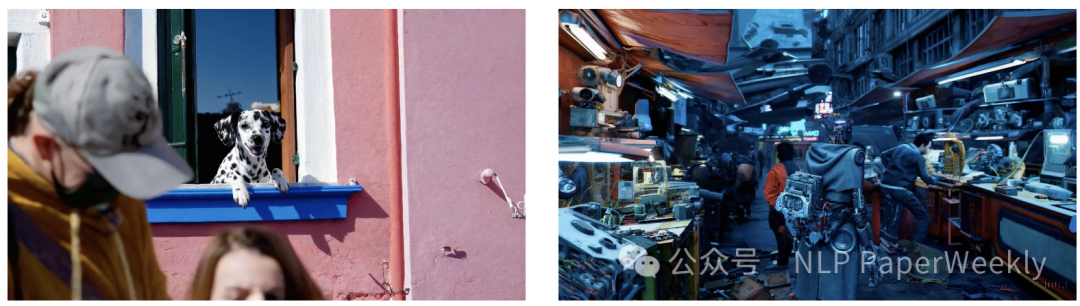

Video-to-video editing(視頻修改和編輯)

Diffusion models have enabled a plethora of methods for editing images and videos from text prompts. Below we apply one of these methods, SDEdit,32 to Sora. This technique enables Sora to transform the styles and environments of input videos zero-shot.

擴散模型使得從文本提示中編輯圖像和視頻的方法大量涌現。下面我們將其中一種方法,即 SDEdit,應用于 Sora。這種技術使得 Sora 能夠對輸入視頻進行零樣本的風格和環境轉換。

Connecting videos(視頻融合)

We can also use Sora to gradually interpolate between two input videos, creating seamless transitions between videos with entirely different subjects and scene compositions. In the examples below, the videos in the center interpolate between the corresponding videos on the left and right.

我們還可以使用 Sora **在兩個輸入視頻之間逐漸插值,從而在主題和場景構圖完全不同的視頻之間創建無縫過渡。**在下面的示例中,中間的視頻在左側和右側的相應視頻之間進行插值。

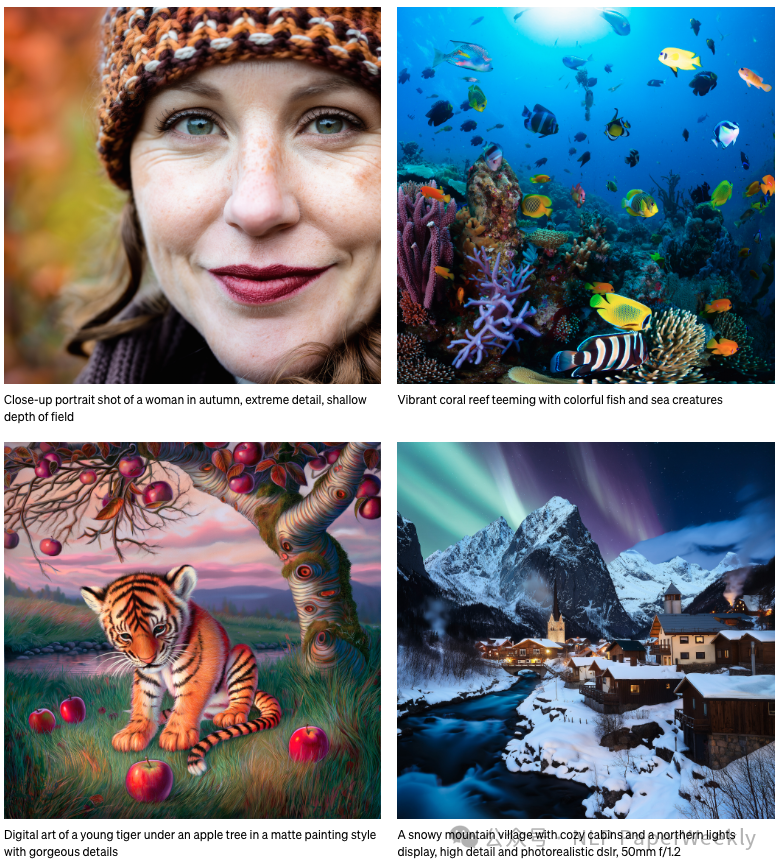

2.Image generation capabilities(單幀圖像生成能力)

Sora is also capable of generating images. We do this by arranging patches of Gaussian noise in a spatial grid with a temporal extent of one frame. The model can generate images of variable sizes—up to 2048x2048 resolution.

Sora 還能夠生成圖像。我們通過在具有一幀時間范圍的空間網格中排列高斯噪聲補丁來實現這一點。該模型可以生成可變大小的圖像,最高可達 2048x2048 分辨率。

3.Emerging simulation capabilities(模擬物理世界)

We find that video models exhibit a number of interesting emergent capabilities when trained at scale. These capabilities enable Sora to simulate some aspects of people, animals and environments from the physical world. These properties emerge without any explicit inductive biases for 3D, objects, etc.—they are purely phenomena of scale.

我們發現,在大規模訓練時,視頻模型表現出許多有趣的新興能力。這些能力使 Sora 能夠模擬物理世界中的人、動物和環境的某些方面。這些屬性是在沒有任何針對 3D、對象等的明確歸納偏差的情況下出現的——它們純粹是規模的現象。

3D consistency(保持3D一致性)

Sora can generate videos with dynamic camera motion. As the camera shifts and rotates, people and scene elements move consistently through three-dimensional space.

Sora 可以生成帶有動態攝像機運動的視頻。隨著攝像機的移動和旋轉,人物和場景元素在三維空間中持續移動。

Long-range coherence and object permanence(保持長時依賴)

A significant challenge for video generation systems has been maintaining temporal consistency when sampling long videos. We find that Sora is often, though not always, able to effectively model both short- and long-range dependencies. For example, our model can persist people, animals and objects even when they are occluded or leave the frame. Likewise, it can generate multiple shots of the same character in a single sample, maintaining their appearance throughout the video.

視頻生成系統面臨的一個重大挑戰是在采樣長視頻時保持時間一致性。我們發現,Sora 通常(盡管并非總是)能夠有效地模擬短程和遠程依賴關系。例如,我們的模型即使在人物、動物和物體被遮擋或離開畫面時也能保持它們的存在。同樣,它可以在單個樣本中生成同一個角色的多個鏡頭,并在整個視頻中保持他們的外觀。

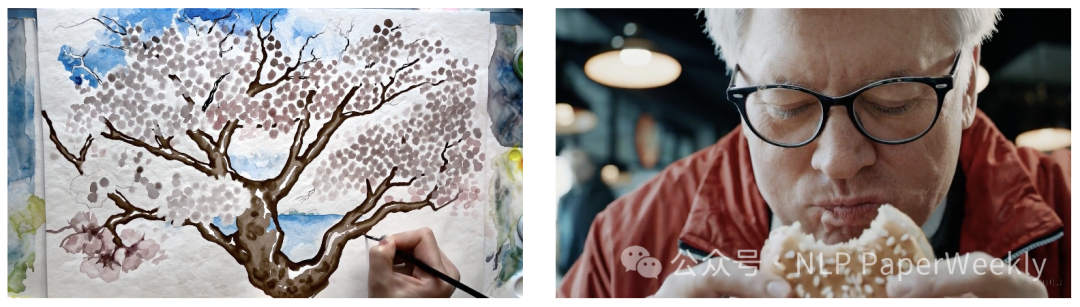

Interacting with the world(模擬與真實世界交互)

Sora can sometimes simulate actions that affect the state of the world in simple ways. For example, a painter can leave new strokes along a canvas that persist over time, or a man can eat a burger and leave bite marks.

Sora 有時可以模擬簡單的動作來影響世界的狀態。例如,畫家可以在畫布上留下新的筆觸,這些筆觸會隨著時間的推移而保留下來,或者一個人可以吃漢堡并留下咬痕。

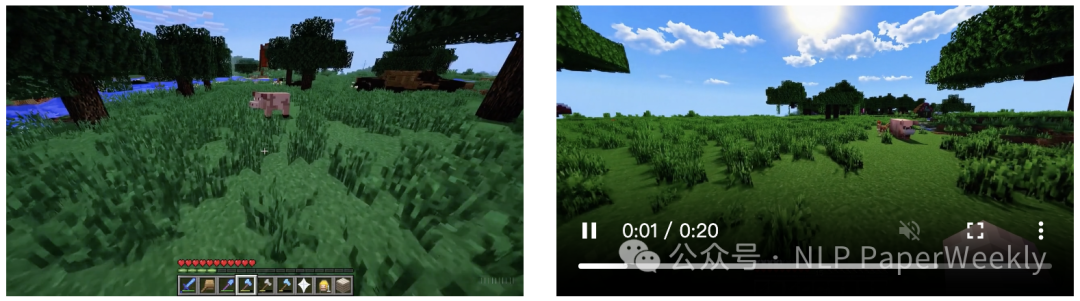

Simulating digital worlds(模擬數字世界)

Sora is also able to simulate artificial processes–one example is video games. Sora can simultaneously control the player in Minecraft with a basic policy while also rendering the world and its dynamics in high fidelity. These capabilities can be elicited zero-shot by prompting Sora with captions mentioning “Minecraft.”

Sora 還能夠模擬人工過程——其中一個例子是電子游戲。Sora 可以在使用基本策略控制 Minecraft 中的玩家的同時,以高保真度渲染世界及其動態。這些功能可以通過提示 Sora 使用提到“Minecraft”的標題來實現零鏡頭。

These capabilities suggest that continued scaling of video models is a promising path towards the development of highly-capable simulators of the physical and digital world, and the objects, animals and people that live within them.

這些能力表明,繼續擴展視頻模型是朝著開發高度能力的物理和數字世界模擬器以及生活在其中的物體、動物和人的有前途的道路。

三、總結

1.相關技術主要包括:1) 將視頻信息處理成spacetime patches,統一了時空分割的語言,方便支持不同尺寸、時間、分辨率的數據。2)使用Diffusion Transformer作為主干網絡進行建模。3) 訓練Video compression network降低視覺數據維度,在壓縮潛在空間訓練生成模型和解碼模型。4)通過Scalling顯著提升生成質量。

- 語言模型與視覺數據建模:大語言模型如ChatGPT通過Embedding技術將人類語言編碼,并利用注意力機制提取知識,生成回應。類似地,Sora項目在視覺數據建模中采用Token Embedding思路,將視頻和圖像壓縮為低維的潛變量空間,即時空碎片(Spacetime Latent Patches),作為統一的時空數據表示。

- spacetime patches(時空碎片)的重要性:時空碎片是Sora項目中的關鍵概念,它不僅有效地表示了視覺數據,而且統一了時空分割的語言,為后續的時空建模提供了基礎。

2.Scaling是有用的:隨著訓練計算量的增加,視頻生成質量有了明顯的提升。

3.數據工程:在原始大小的數據上進行訓練反而有幾個好處。

- 更方便創造不同分辨率的圖片

- 更好的構圖和取景效果

4.數據工程:高度描述性的視頻標題上進行訓練可以提高文本保真度以及視頻的整體質量。

本文采取兩個策略獲取高質量的每一幀圖像的caption。通過這種方式,Sora能夠更精確地關聯GPT4的語言空間和視覺數據,實現了Token(文本)與Patch(視覺數據)之間的統一。

- 專門訓練一個高度描述性的標題模型。

- 利用GPT4將簡短的用戶提示轉化成更長、更詳細的標題。

5.能力展現:文本可以作為prompt,圖片或者視頻也行!

這意味著我們除了根據文本創建視頻,還可以做非常多其他的視頻編輯工具,這在視頻創作,電影等行業都可以帶來非常大的變革。應用方法包括但不限于:

- 根據靜態圖片生成動態圖片

- 在時間上向前或者向后拓展視頻

- 視頻編輯:直接通過prompt提示詞修改視頻背景

- 視頻融合:插針融合兩個風格完全不同的視頻

6.涌現能力:Sora能夠模擬物理世界中的人、動物和環境的變化。

文章提出,沒有對3D數據進行優化,隨著模型規模的變大,發現視頻生成模型能夠涌現出3D世界的模擬能力。主要包括以下幾個方面。

- 3D一致性:場景元素能在在三維空間中持續移動

- 有效地模擬物體短程和遠程依賴關系:狗被遮擋還是能持續保持狀態

- 模擬簡單的動作來影響世界的狀態:畫畫動作反饋,咬東西物體反饋

- 模擬數字世界:模擬游戲玩家,渲染畫面

7.還是存在類似于LLM的幻覺現象。

比如不能準確模擬許多基本交互的物理特性,如玻璃破碎;其他交互,如進食,并不能總是導致對象狀態的正確變化;而且在長時間采樣中會出現不一致或物體的自發出現等問題。

本文轉載自 ??NLP PaperWeekly??,作者: NLP PaperWeekly