Ilya Sutskever:基于神經網絡的序列到序列學習,十年回顧 精華

會議:NeurIPS 2024

時間:December 14, 2024

發言人:Ilya Sutskever

主題:Sequence to Sequence Learning with Neural Networks: What a Decade

?

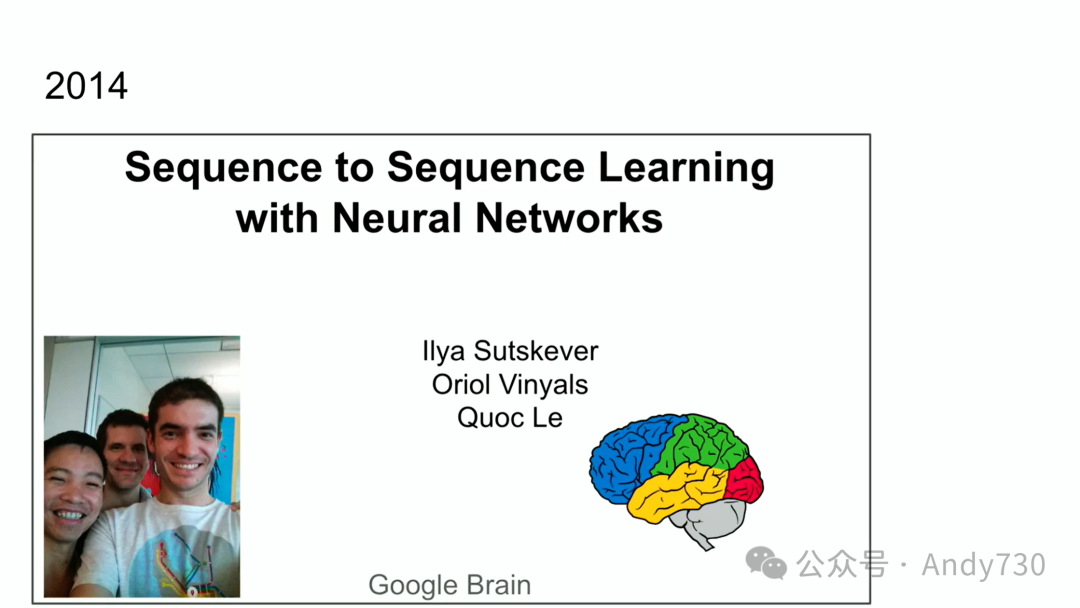

Ilya Sutskever是論文《基于神經網絡的序列到序列學習》(Sequence to Sequence Learning with Neural Networks)的第一作者。該論文榮獲了NeurIPS 2024的“Test of Time”論文獎。該獎項旨在表彰在2014年NeurIPS會議上發表、對研究領域產生了重大影響并經得起時間考驗的論文。自發布以來,該論文已被引用超過27000次,并在大型語言模型和基礎模型的快速發展中起到了關鍵作用。論文提出的編碼器-解碼器架構為神經網絡處理序列數據開辟了新路徑,啟發了基于注意力機制的后續改進,并促進了當今基礎模型研究的蓬勃發展。這項工作不僅為人工智能領域帶來了范式轉變,也為相關應用的進步奠定了堅實基礎。

核心觀點

- 聯結主義的核心思想:人工神經元和生物神經元有相似性,因此可以通過設計較小的神經網絡來執行復雜任務。

- LLM的分布外泛化能力可能還不如人類。人類在處理完全陌生的問題時往往表現得更好。

- 人腦在自我重構等方面仍優于當前的神經網絡,后者依賴大量數據和特定算法。

- 預訓練時代終將結束,因為數據量有限,盡管計算能力提升。

- 一個能夠推理的系統本質上是不可預測的。推理的能力越強,其不可預測性就越大。我們最終將不得不面對這些高度不可預測的AI系統。

- 未來發展趨勢:智能體(Agents)、合成數據(Synthetic Data)、推理時計算(Inference-Time Compute)。

問題與回答

1. 十年前關于深度學習,有哪些觀點是正確的?

- 深度學習假設:擁有足夠多層和足夠大的神經網絡,理論上可以瞬間完成人類能完成的任何任務。

- 自回歸模型:準確預測下一個詞元的自回歸模型,實際上已掌握了序列接下來可能出現的詞元的概率分布。

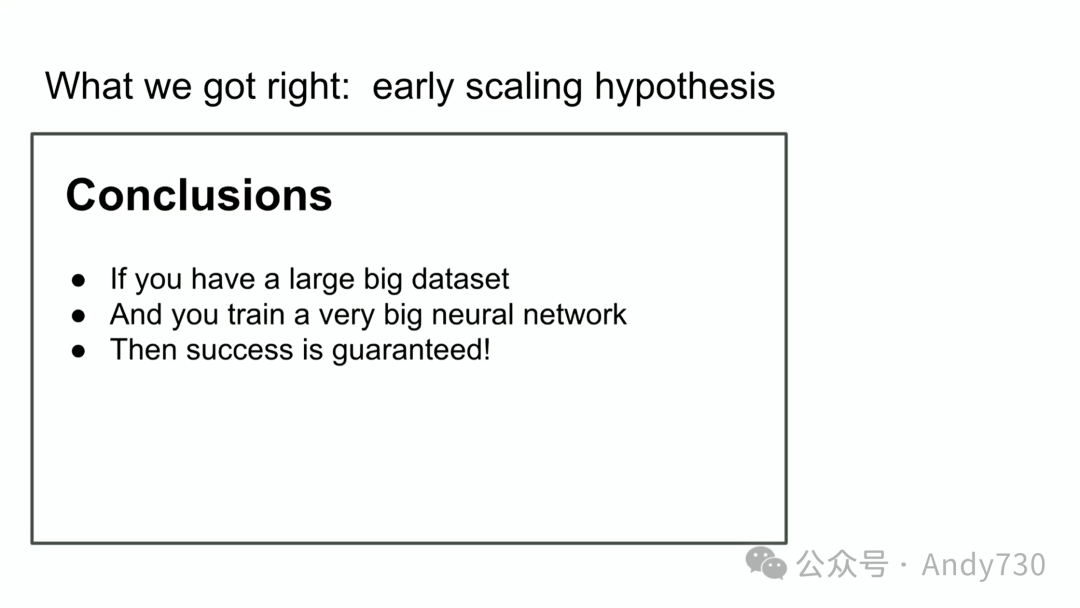

- 擴展假設:擁有足夠大的數據集并訓練足夠大的神經網絡,就能取得好結果。

2. 十年前關于深度學習,有哪些觀點是不完全準確的?

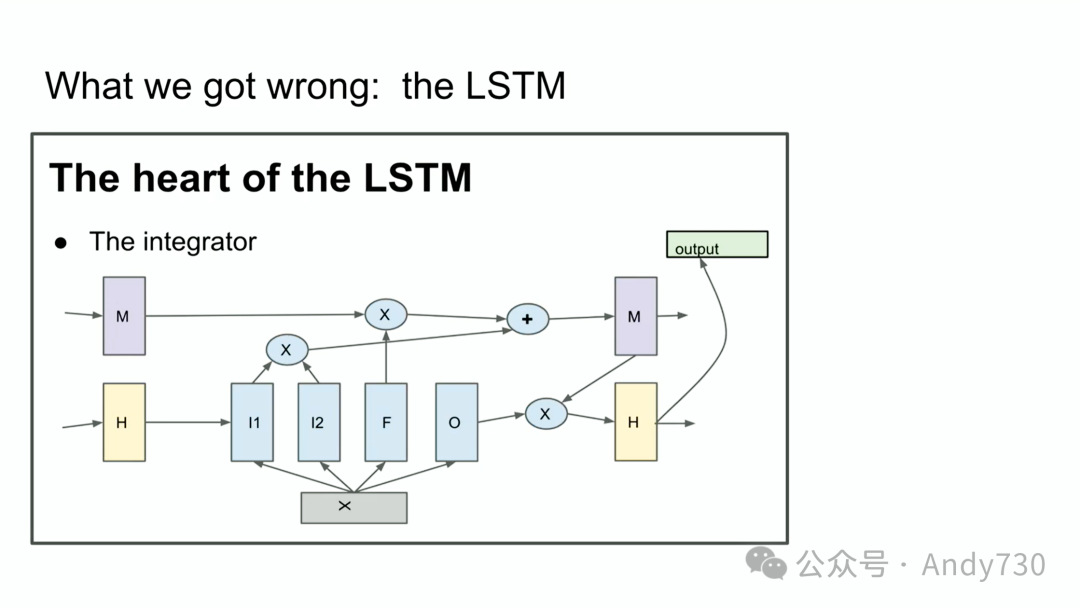

- LSTM:作為Transformer出現前的技術,LSTM結構相對復雜,效率不如Transformer。

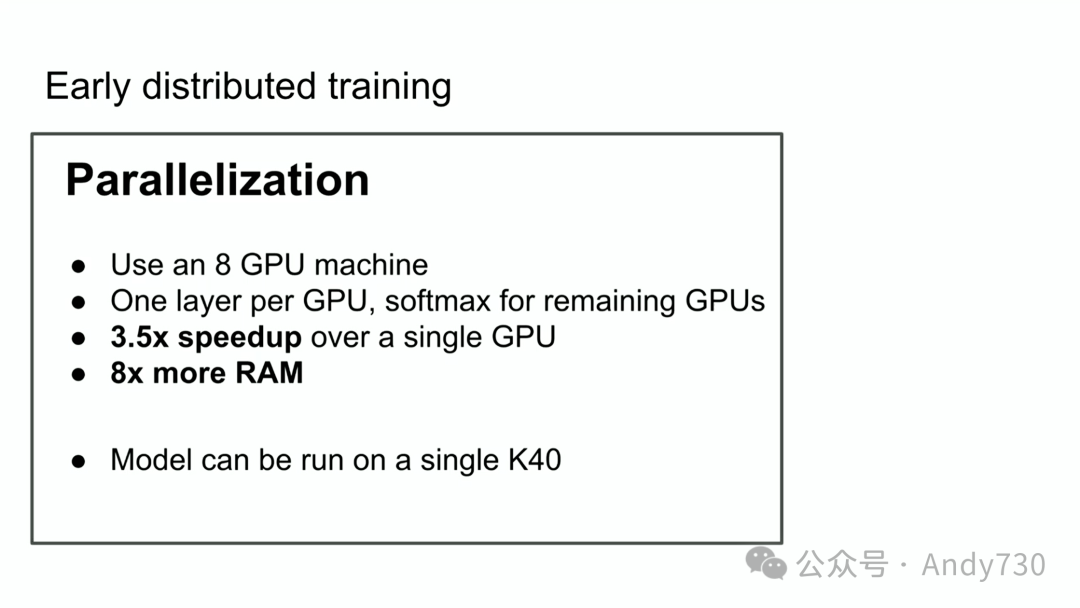

- 流水線并行化:流水線并行化方法在所有情況下并非最優。

3. 未來深度學習發展有哪些趨勢?

- 智能體(Agents):智能體將成為未來發展的重要方向。

- 合成數據(Synthetic Data):如何生成和利用合成數據是充滿挑戰和機遇的領域。

- 推理時計算(Inference-Time Compute):如何降低推理時計算量是重要研究方向。

4. 超級智能(Superintelligence)與現有AI系統有何不同?

- 智能體特性:超級智能將真正具備智能體特性,而非像現有AI系統僅表現出微弱的智能體特性。

- 推理能力:超級智能將具備強大的推理能力,使其行為更不可預測。

- 理解能力:超級智能將能夠從有限數據中理解事物,不受數據限制。

- 自我意識:超級智能可能具備自我意識,使其與現有AI系統在本質上完全不同。

提問1:除了神經元之外,是否還有其他人類認知的生物結構值得探索?

目前還沒有新的視角或發現可以根本性地改變我們對大腦運作方式的理解。雖然深度學習借鑒了神經元概念,但對大腦更深層次機制的模擬仍面臨挑戰。

提問2:未來具有推理能力的模型是否能夠自我校正,從而減少幻覺?

是的。未來模型很可能能夠識別輸出錯誤并自我校正,但這比簡單的拼寫檢查要復雜得多。

提問3:AI智能不斷發展,是否會催生出新的智慧物種?如何設計激勵機制確保AI發展符合人類價值觀?

AI發展成為新智慧物種的可能性存在,但如何設計激勵機制確保AI與人類和諧共存是一個復雜問題,目前尚無確切答案。

提問4:LLM能否在分布外數據上實現多跳推理?

這個問題取決于對“分布內”和“分布外”的定義。雖然LLM在某些方面展現了分布外泛化能力,但與人類相比,其處理陌生問題的能力仍有差距。

非常感謝主辦方將這篇論文評為獲獎論文。能獲得這樣的認可,我感到非常榮幸。同時,我也要感謝我的優秀合作者和合作伙伴,Oriol Vinyals和Quoc Le,他們剛才已經跟大家見面了。

這張幻燈片是我十年前,也就是2014年在蒙特利爾NIPS會議上做類似演講時的截圖。對比之下,當時的情形顯得更加單純。照片中的我們,就是那個時候的“我們”。

而現在,我們有了更多的經驗,也希望自己變得更加睿智。

接下來,我想跟大家分享一下這項工作的內容,并回顧一下過去的十年。因為這項工作中有很多觀點是正確的,但也有一些地方并不完全準確。通過回顧,我們可以看看發生了哪些變化,以及這項工作是如何發展到今天的。

讓我們從我們所做的工作開始。我將展示十年前同一場演講中的幻燈片。這項工作的核心可以總結為以下三點:

- 基于文本的自回歸模型(Autoregressive model trained on text)。

- 大型神經網絡(Large neural network)。

- 大型數據集(Large dataset)。

就是這么簡單。

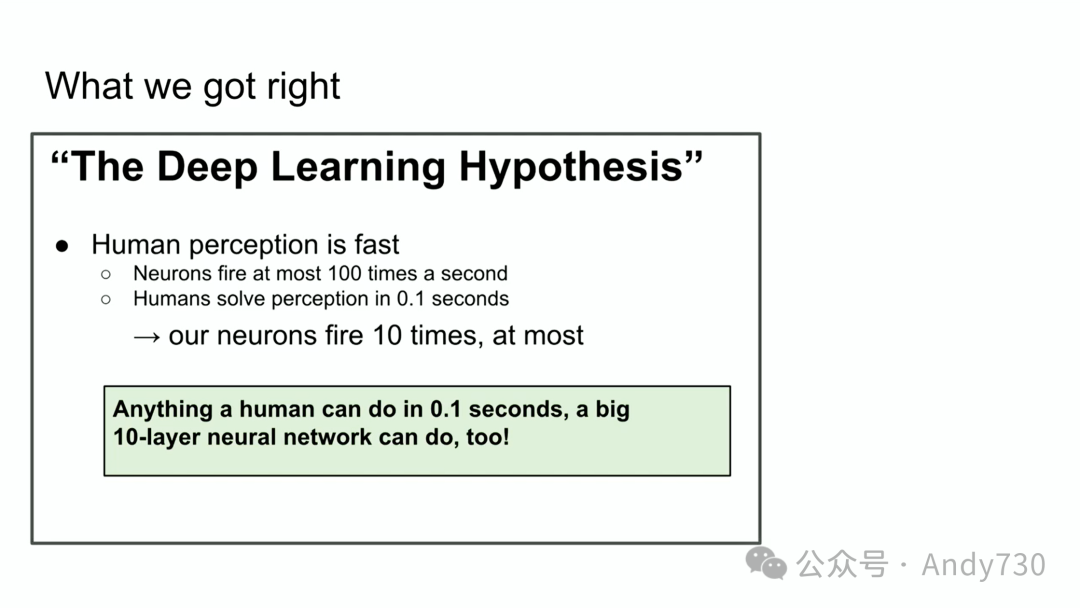

我們更深入地探討一下細節。這張十年前的幻燈片,雖然有些粗糙,但其中的核心思想仍具有啟發性。

我們當時提出了“深度學習假設”。這個假設的核心是:如果我們有一個足夠大且足夠深的深度神經網絡,那么它理論上可以瞬間完成人類所能完成的任何任務。為什么我們特別強調“瞬間”呢?

如果我們相信深度學習的核心理念——即人工神經元與生物神經元的工作原理相似——并且考慮到生物神經元的處理速度相對較慢,那么人類能夠快速完成的任何任務,理論上一個深度神經網絡也應該能夠在極短的時間內完成。這是因為,我們只需將人類大腦中的連接模式映射到人工神經網絡中即可。

因此,我們的直覺是:人類在瞬間完成的任務,一個具有十層的神經網絡也應該能夠完成。之所以是十層,是因為當時的技術限制,我們只能訓練出十層的神經網絡。如果能突破這個限制,我們相信就能實現更多。

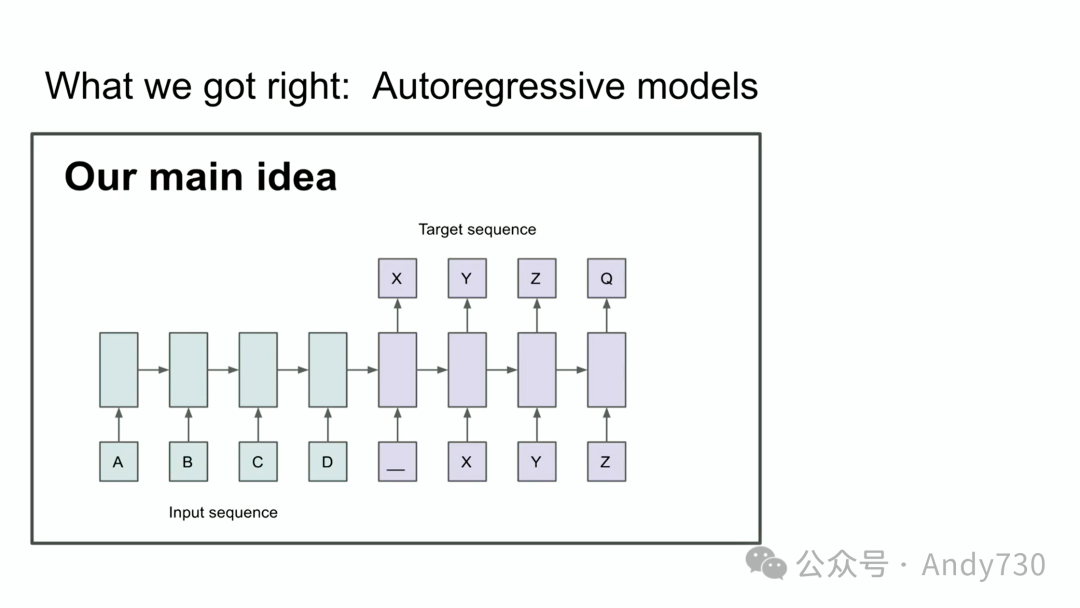

這張幻燈片展示了我們當時的另一個核心觀點。你們可能會認出其中的自回歸模型。那么,這張幻燈片到底想表達什么呢?

這張幻燈片想要強調的是:如果一個自回歸模型能夠非常準確地預測下一個Token,那么它實際上已經掌握了序列中接下來可能出現的Token的概率分布。這是一個非常重要的觀點。雖然自回歸模型并不是全新的概念,但我們相信,通過足夠的數據和訓練,我們可以構建一個能夠很好地捕捉序列生成過程的自回歸模型。

當時,我們的目標是機器翻譯。雖然現在看來這個目標并不算太遠大,但在當時,這是一個非常具有挑戰性的任務。

我們來回顧一下深度學習發展歷程中的一段歷史。這張幻燈片展示了LSTM(Long Short-Term Memory,長短期記憶網絡),這是一種在Transformer出現之前廣泛使用的技術。對于不熟悉LSTM的朋友,可以簡單地把它描述為一個旋轉了90度的ResNet。LSTM比Transformer更早出現,其結構相對復雜一些。它包含一個積分器(Integrator),也就是我們現在常說的殘差流(Residual Stream),以及一些乘法運算。雖然結構看起來有些復雜,但其核心思想并不難理解。

除了LSTM,我還想強調一下我們在那次演講中提到的另一個重要概念——并行化(Parallelization)。我們當時提出了一種基于流水線的并行化方法,這張幻燈片展示了每個GPU處理一層網絡的示意圖。雖然我們現在知道,流水線并不是在所有情況下都是最優的,但當時我們認為這是一個很好的方法。通過使用八個GPU,我們實現了3.5倍的加速。

最后,我想談談那次演講中的結論幻燈片。這張幻燈片實際上提出了一個非常重要的概念,我們現在可以稱之為“擴展假設”(Scaling Hypothesis)。這個假設的核心思想是:如果我們擁有足夠大的數據集,并訓練一個足夠大的神經網絡,那么就能取得很好的結果。雖然這個假設在某些情況下可能過于樂觀,但從過去十年的發展來看,這個假設在很大程度上是正確的。

接下來,我想談談一個經久不衰的核心思想——聯結主義(Connectionism)。這個思想的核心在于,如果我們相信人工神經元和生物神經元之間存在某種相似性,那么我們就可以推斷,一個非常大的神經網絡并不一定需要像人腦一樣龐大。通過適當的設計,相對較小的神經網絡也能完成許多人類可以完成的任務。然而,我們也要承認,人腦在某些方面仍然具有優勢,比如自主地重新配置自身。相比之下,我們目前的神經網絡仍然依賴于大量數據和特定的學習算法。

- 2014年12月:Sutskever等人提出的《Sequence to Sequence Learning with Neural Networks》論文介紹了基于LSTM的序列到序列學習模型,包含編碼器和解碼器結構,采用束搜索進行解碼。研究表明,LSTM在機器翻譯任務中表現優異,首次超越了傳統的統計機器翻譯方法。此外,反轉源語句中的單詞順序提高了LSTM性能。

- 2019年2月:Radford等人提出的《Language Models are Unsupervised Multitask Learners (GPT-2)》論文介紹了基于Transformer的GPT-2模型。GPT-2通過語言建模和字節對編碼(BPE)學習多任務,證明了大型語言模型的泛化能力和多任務學習潛力。

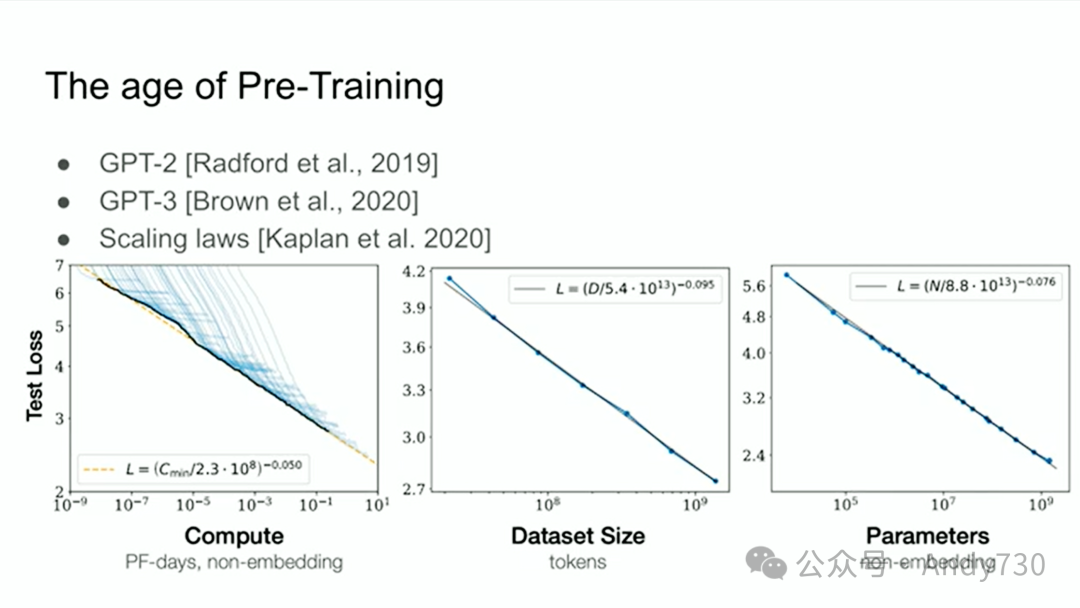

- 2020年1月:Kaplan等人發表的《Scaling Laws for Neural Language Models》研究了神經語言模型的規模定律,發現模型性能與模型大小、數據集規模、計算量之間遵循冪律關系。研究還提出優化訓練效率的策略,如使用臨界批次大小,并表明大模型在較小數據集上訓練效果更佳。

- 2020年7月:Brown等人提出的《Language Models are Few-Shot Learners (GPT-3)》論文介紹了更大的GPT-3模型,強調少量樣本學習。研究發現,通過增加模型規模,GPT-3在少量樣本學習下的表現大幅提升,接近微調方法的性能。?

所有這些思考最終引領我們進入了預訓練(Pre-Training)時代。這個時代可以說是從GPT-2、GPT-3和規模定律(Scaling Laws)開始的。我特別要感謝我的前同事Alec Radford、Jared Kaplan和Dario Amodei,他們的工作為預訓練時代的到來奠定了基礎。正是他們的努力,推動了我們今天所看到的超大規模神經網絡的發展。這些模型在海量數據上進行訓練,取得了令人矚目的成果。

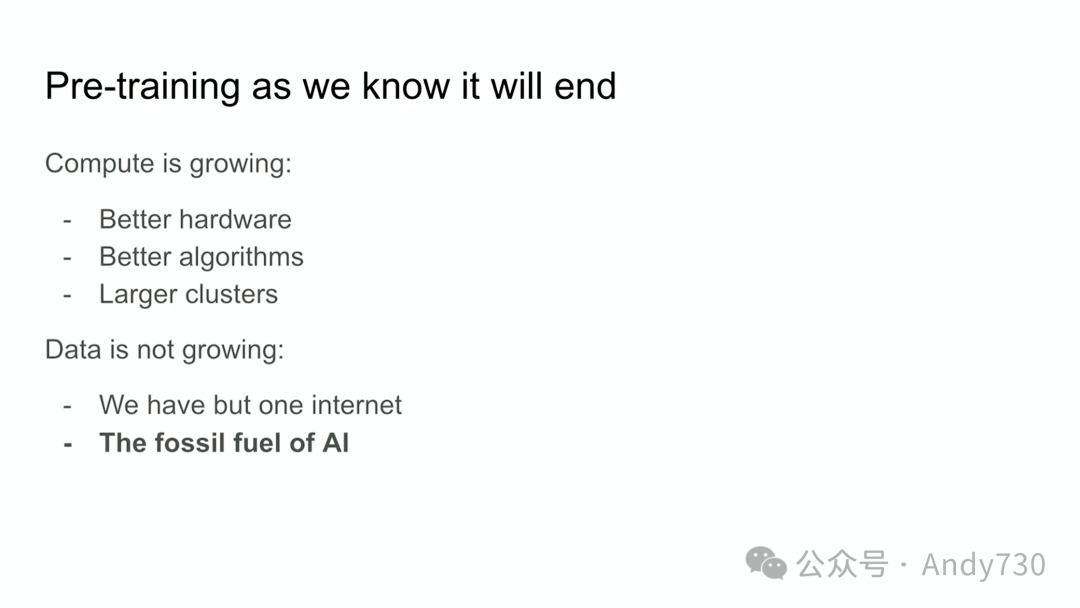

但是,我們也要意識到,預訓練時代終將結束。這是因為,盡管計算能力在不斷提升,但可用的數據量卻相對有限。互聯網上的數據量雖然龐大,但畢竟是有限的。我們可以將數據比喻為人工智能的“化石燃料”,一旦消耗殆盡,我們就需要尋找新的能源。雖然目前的數據已經足夠我們進行很多研究,但我們不能過度依賴它。

接下來,我想大膽地預測一下未來發展趨勢。

實際上,很多人已經在進行類似的預測了。你們可能聽說過“智能體”(Agents)這個概念。我認為智能體將會成為未來發展的一個重要方向。

此外,合成數據(Synthetic Data)也是一個備受關注的領域。如何有效地生成和利用合成數據是一個巨大的挑戰,但同時也是一個充滿機遇的領域。

除了合成數據,推理時計算(Inference-Time Compute)也是一個值得關注的方向。例如,O1模型就是在這方面的一個嘗試。

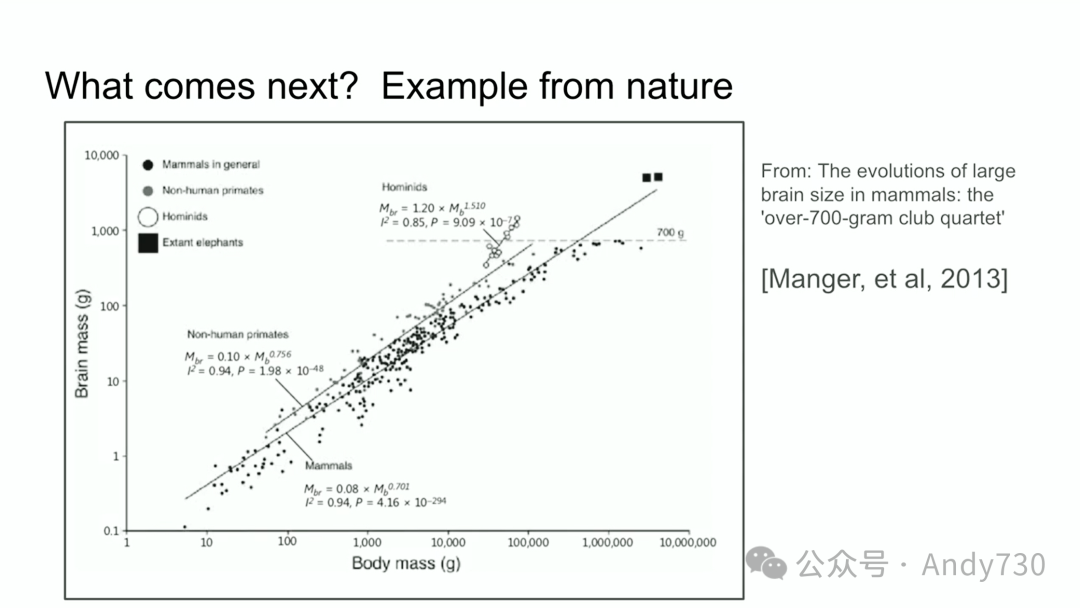

我想提另一個來自生物學的例子,我認為它非常酷。

很多年前,也是在這個會議上,我看到有人做了一個演講,展示了一張圖表。該圖表顯示了哺乳動物身體大小與其大腦大小之間的關系,這里指的是質量。在那個演講中,我清楚地記得,他們說:“看,在生物學中,一切都如此混亂,但這里有一個罕見的例子,動物的身體大小與其大腦大小之間存在著非常緊密的關系。”

我完全是出于好奇,開始研究這張圖表。我找到的一篇早期研究論文中有這張圖片。這張圖片有趣的地方在于,你可以看到這些哺乳動物。所有不同的哺乳動物,然后是非人靈長類,基本上是一樣的,然后是人族。據我所知,人族是人類在進化過程中的近親,比如尼安德特人(Neanderthal)和其他智人。有趣的是,他們的大腦與身體的比例指數有一個不同的斜率。

這意味著有一個先例。有一個生物學發現不同比例的例子。顯然,有些東西是不同的。順便說一句,我想強調一下,這個x軸是按對數刻度,有100、1000、10000和100000。同樣,以克為單位:1克、10克、100克、1000克。

事情有可能不同。到目前為止,我們一直在縮放的東西實際上是我們首先弄清楚如何縮放的東西。毫無疑問,在這個領域工作的每個人都會弄清楚下一步該怎么做。

我想花幾分鐘來探討長遠的未來,以及我們正走向何方。

我們正在取得這些令人矚目的進展。這些進步令人驚嘆,真是難以置信。那些十年前就在這個領域的人一定還記得當時一切是多么地不成熟。即使承認深度學習當時還處于起步階段,也很難相信我們現在所達到的程度。我無法完全向你們傳達這種感受。如果你是在過去兩年內加入這個領域的,你可能已經習慣了與計算機對話,它們會與你互動,甚至與你爭論。這是計算機現在能做到的事情,但過去并非如此。

我想簡要談談超級智能(Superintelligence),因為顯然這是這個領域的終極方向。這顯然是我們正在構建的東西。關于超級智能,有一點需要注意,那就是它將與我們現在擁有的系統在本質上完全不同。接下來的一分鐘內,我的目標是為你提供一些具體的直觀感受,幫助你理解它的不同之處。

目前,我們擁有令人難以置信的語言模型和出色的聊天機器人。它們能夠完成許多任務,但也表現出某種奇怪的不可靠性。有時它們會感到困惑,即使在某些任務中表現出明顯超越人類的能力。這種矛盾尚未被完全解決。然而,最終,無論多久,以下目標將會實現:這些系統將真正以有意義的方式具備智能體(Agentic)的特性。目前,這些系統在真正意義上還不是智能體。這可能是一個過于強烈的表述,但它們只是剛剛開始表現出非常微弱的智能體特性。最終,它們將能夠進行“推理”(Reason)。

順便提一下,我想談談“推理”(Reasoning)。一個能夠推理的系統本質上是不可預測的。推理的能力越強,其不可預測性就越大。我們習慣的深度學習系統是非常可預測的。當我們致力于復現人類直覺時——本質上是人在一瞬間產生的那種直覺——它是高度可預測的。那么,我們的大腦進行的處理是什么呢?那是我們的直覺。

我們已經賦予系統某些直覺能力,但推理(Reasoning)是不同的。現在我們可以看到一些早期的跡象。推理是不可預測的。一個證據是,最好的AI國際象棋玩家對頂級人類玩家來說是不可預測的。因此,我們最終將不得不面對這些高度不可預測的AI系統。它們將能夠從有限的數據中理解事物,不會被目前對我們來說是重大限制的問題所困擾。

我并不是在說這一切會如何發生,也不是在說它會在何時發生。我只是說它是現實的。當所有這些因素結合在一起,包括自我意識(Self-awareness),為什么不呢?自我意識是有用的,它是我們構建世界模型的一部分。當所有這些因素結合在一起時,我們將擁有與現有系統在性質和屬性上完全不同的系統。當然,它們會具有令人難以置信的能力,但伴隨這些系統的問題類型也將與我們現在所習慣的完全不同。我留給你們一個想象的練習,去思考這可能會是什么樣子。盡管未來無法預測,但各種可能性都存在。

在這一令人振奮的基調中,我將結束演講。非常感謝大家!

觀眾:現在是2024年,是否有其他屬于人類認知的生物結構值得以類似方式進行探索,或者是您感興趣的領域?

Ilya Sutskever:我認為,如果有人能提出一個全新的視角,認為“我們對大腦的運作方式存在根本性誤解”,并能據此提出可行的研究方向,那將是非常有價值的。就我個人而言,目前還沒有這樣的洞見。

當然,這取決于我們討論的抽象層次。從某種程度上來說,我們一直試圖構建受生物啟發的AI,而且已經取得了顯著的成功。深度學習就是一個典型的例子。然而,這種生物啟發往往是有限的。比如,我們采用了神經元這種生物學概念,但對大腦更深層次的運作機制的模擬卻面臨著巨大的挑戰。盡管如此,我并不排除未來會有新的發現,能讓我們更深入地理解大腦,并借此推動AI的發展。如果有人能在這方面取得突破,那將是非常令人興奮的。

觀眾:您提到推理(Reasoning)是未來模型的核心特性之一,也是一個潛在的差異化優勢。目前我們看到了一些模型存在幻覺(Hallucinations)的問題,比如通過統計分析發現模型輸出與預期存在較大偏差。您認為未來具有推理能力的模型是否能夠自我校正(Auto-correct)?也就是說,模型能否識別自己的輸出是否偏離了正確的軌道,從而減少幻覺的產生?這個問題可能比較復雜,但模型是否能夠理解并推理“進化”這樣的概念呢?

Ilya Sutskever:這是一個非常有意義的問題,答案是肯定的。我完全同意你的觀點,這種情景非常有可能實現。甚至,我不會排除目前的一些早期推理模型已經開始展現出這樣的能力。從長遠來看,我認為這種能力的實現是必然的。

觀眾:這有點像Microsoft Word的自動校正功能。

Ilya Sutskever:是的,但“自動校正”這個詞似乎低估了我們正在討論的復雜性。你描述的場景遠比簡單的拼寫檢查要復雜得多。不過,撇開術語不談,你的核心觀點是正確的。

觀眾:Ilya,您好。您的演講結尾非常引人深思,您巧妙地避開了AI是否會取代人類、超越人類或是否應該擁有權利等問題。這讓我思考:隨著AI智能的不斷發展,是否會催生出一種新的智慧物種?或許,這些AI也應該擁有某種形式的“權利”,就像強化學習領域的研究者們所探討的那樣。另外,我想問一個不太相關的問題:我們應該如何設計激勵機制,以確保AI的發展能夠符合人類的價值觀,并與人類和諧共存?

Ilya Sutskever:我認為你提出的這些問題非常值得深入思考。關于如何設計激勵機制,我坦率地說,我還沒有確切的答案。這涉及到非常復雜的社會結構和治理問題。我個人并不擅長這類自上而下的設計。

觀眾:也許我們可以借鑒加密貨幣的思路,比如Bittensor之類的項目。

Ilya Sutskever:我對加密貨幣領域并不是特別了解,所以不太方便評論。不過,你提到的這種可能性確實存在。如果AI系統希望與人類和平共處,并爭取自己的權益,這未嘗不是一件好事。但未來會如何發展,我們真的很難預測。我鼓勵大家積極思考、大膽猜測。

觀眾:謝謝您的精彩演講。

Sheila Levitt:Ilya您好,感謝您的精彩演講。我是Sheila Levitt,來自多倫多大學。非常感謝您所做的工作。我想問一下:您認為LLM能否在分布外(Out-of-distribution)數據上實現多跳推理(Multi-hop reasoning)?

Ilya Sutskever:這個問題的答案不是簡單的“是”或“否”。因為“分布內”和“分布外”的概念本身就非常模糊。為了更好地回答這個問題,我們不妨回顧一下深度學習之前的機器學習。當時,人們主要使用字符串匹配和N-gram模型來進行機器翻譯,并通過構建龐大的統計短語表來實現。你能想象嗎?他們編寫了數以萬計的代碼來完成這項任務,這在當時是非常復雜的。那個時候,我們所說的“泛化”僅僅指模型能否準確處理與訓練數據中的單詞表達完全相同的句子。

現在,我們可能會說,我的模型在數學競賽中取得了很高的分數。但實際上,這些數學問題可能與某些在線論壇上的討論非常相似,模型或許只是記住了這些問題的答案。從這個角度來看,你可以認為模型的這種能力是“分布內的”,或者說僅僅是記憶。然而,我認為我們對模型泛化能力的要求已經大大提高了。這種提高是難以想象的。

所以,我的回答是:在某些方面,大型語言模型的分布外泛化能力可能還不如人類。人類在處理完全陌生的問題時往往表現得更好。但與此同時,模型在一定程度上也具備了分布外泛化的能力。我認為這是一個既有價值又存在一定局限性的答案。

本文轉載自 ??Andy730??,作者: 常華Andy