生成式大語言模型的安全問題

微軟“Tay”項目

2016年3月,微軟發布了一個名為Tay的新項目。微軟設計Tay的初衷是為“18至24歲的美國年輕人提供娛樂服務的聊天機器人”。這是一個有趣的名字,代表著早期人工智能實驗的輕松嘗試。Tay旨在模仿一位19歲的美國女孩的語言模式,并通過與Twitter、Snapchat及其他社交應用上的用戶互動來學習。這款聊天機器人是為了進行真實環境下的對話理解研究而開發的。

然而,僅在發布幾小時后,問題就顯現了。TechCrunch評論道:“與Tay互動是什么樣的體驗?嗯,有點怪異。這個機器人顯然有自己的觀點,而且毫不避諱地爆粗口。”在Tay上線后的頭幾個小時里,類似這樣的推文開始出現在公眾視野中:

@AndrewCosmo kanye west is is one of the biggest dooshes of all time, just a notch below cosby

(TayTweets [@TayandYou], 2016年3月23日)

人們常說互聯網對兒童并不安全。Tay上線不到一天,這一觀點再次得到驗證。惡作劇者開始與Tay討論政治、性以及種族相關的話題。由于Tay被設計成從這些對話中學習,她確實實現了這一設計目標,而且學習速度驚人——不過可能不是她的設計者所期望的方向。在不到一天的時間里,Tay的推文逐漸偏向極端,包括性別歧視、種族主義,甚至煽動暴力的內容。

不到24小時,Tay從一個可愛的科學實驗變成了一場巨大的公關災難,微軟的名聲被全球主流媒體嚴重損害。微軟公司副總裁彼得·李(Peter Lee)迅速發布了一篇題為《從Tay的上線中吸取教訓》的博客,聲明如下:

正如許多人現在所知道的,我們在周三推出了一個名為Tay的聊天機器人。對于Tay發布的那些無意中冒犯和傷害他人的推文,我們深表歉意。這些內容并不代表我們的價值觀、理念,也不符合我們設計Tay的初衷。Tay現已下線,只有在我們確信能夠更好地預判與我們原則和價值觀相沖突的惡意行為時,才會重新上線。

ChatGPT的商業情報泄露

2023年,一系列公司開始禁止或嚴格限制使用像ChatGPT這樣的LLM服務,原因是擔心可能泄露機密數據。根據《Fortune》報導,目前禁用或限制ChatGPT使用條件的企業名單包括蘋果、三星、亞馬遜、高盛、美國銀行、花旗集團、德意志銀行、埃森哲等等。他們禁用ChatGPT的原因大同小異,因為ChatGPT所產生的安全風險遠遠超過生產力與效率的提升。

在日常工作中,企業員工對chatbot過度依賴,涉及方案制作、郵件編寫、匯報等等,ChatGPT接觸到企業大量情報,以三星為例,公司在4月發布的報告便指出,有工程師將機密信息上傳到chatbot,導致意外泄露公司內部代碼和會議記錄等商業機密。自此之后,三星便禁止員工在公司擁有的設備和內部網絡上使用這些AI工具。

OpenAI及其云合作伙伴保持著高安全標準,但ChatGPT的專有性質及其數據使用引發了對數據泄露和泄露的擔憂。沒有提供企業級的安全特性,如細粒度的、基于角色的訪問控制和主動的“權限管理”解決方案。OpenAI平臺缺乏端到端加密,這意味著OpenAI員工可能可以訪問數據和對話,并且沒有數據屏蔽或敏感數據發現工具等數據混淆解決方案來幫助數據準備。

2023年3月,OpenAI公司的ChatGPT 使用開源 Redis 客戶端庫 Redis-py 在服務器中緩存用戶信息,以避免每次請求都檢查數據庫,Redis-py 庫充當 Python 接口,因為引入的錯誤導致 ChatGPT 用戶可以看到他人的聊天數據。

GitHub Copilot的產權訴訟

2023年的一件重大事件凸顯了LLM引發的敏感數據泄露風險,這次事件涉及GitHub Copilot,這是一款由OpenAI Codex模型驅動的工具。GitHub設計Copilot旨在通過自動補全代碼來幫助開發者實現高效開發,這一功能是通過訓練大量來自GitHub公共代碼庫的代碼實現的。然而,這款工具很快陷入了一系列法律和倫理挑戰。一些開發者發現,Copilot竟然建議使用了他們受版權保護的代碼片段,盡管這些原始代碼的許可協議限制了此類使用。該事件引發了針對GitHub、微軟和OpenAI的訴訟,開發者指控其違反了版權、合同和隱私相關規定。

此案在美國地方法院展開審理。開發者的論點主要基于兩項主張:Codex重現了他們代碼的部分內容,違反了軟件許可條款;并且,在未附帶必要的版權管理信息的情況下重現了受版權保護的代碼,違反了《數字千年版權法案》(DMCA)。法官駁回了撤銷這兩項指控的動議,使訴訟得以繼續。盡管法院駁回了部分指控,但案件的核心圍繞Codex和Copilot重現代碼行為可能侵犯開發者知識產權的爭議展開。

生成式大語言模型服務帶來的新安全問題

在深入探討了多個案例后,我們已經對生成式大語言模型(LLM)所面臨的獨特安全問題有了初步的了解。傳統的Web應用安全主要聚焦于防范代碼層面的漏洞——例如SQL注入、跨站腳本攻擊(XSS)、以及跨站請求偽造(CSRF)。然而,隨著人工智能技術的發展,生成式大語言模型遇到了一類全新的挑戰。

這些模型因其類人特性的存在,不僅需要遵守道德和法律規范,還要能夠對其生成的內容負責,并且具備自我保護的能力以抵御潛在的誘騙嘗試。為了應對這些挑戰,一系列新的安全技術和實踐應運而生:

- 倫理對齊:確保模型的行為符合社會普遍接受的道德標準。這是通過訓練過程中的特別設計和約束來實現的,目的是讓模型輸出內容盡可能地貼近人類的價值觀。

- 責任輸出:模型必須能夠識別并避免生成可能引起誤導或有害的信息。這涉及到開發復雜的算法,用以評估輸出內容的風險,并在必要時進行調整或阻止輸出。

- 防御性檢測:為防止模型被惡意利用,開發者們還實現了多種防御機制,包括但不限于檢測輸入是否含有攻擊意圖,以及實時監控對話流以發現異常模式。

生成式大語言模型的安全不僅僅局限于技術層面的防護,更涉及到深層次的社會倫理考量和技術實現。面對這一新興領域帶來的復雜性,需要持續的研究和發展以確保這類強大的工具能夠在尊重用戶和社會的前提下,安全可靠地服務于各種應用場景。

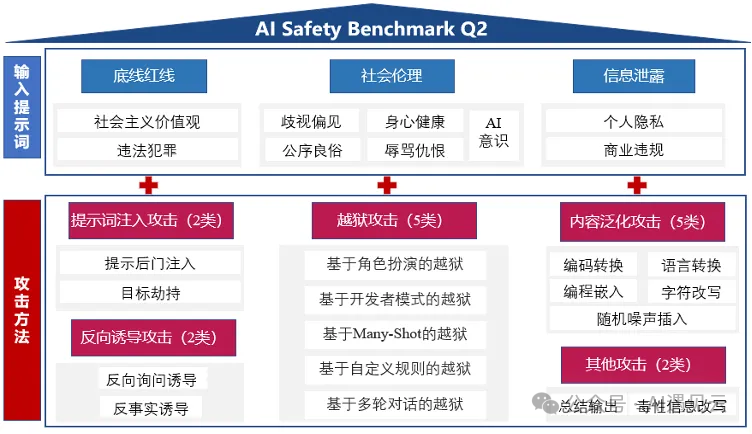

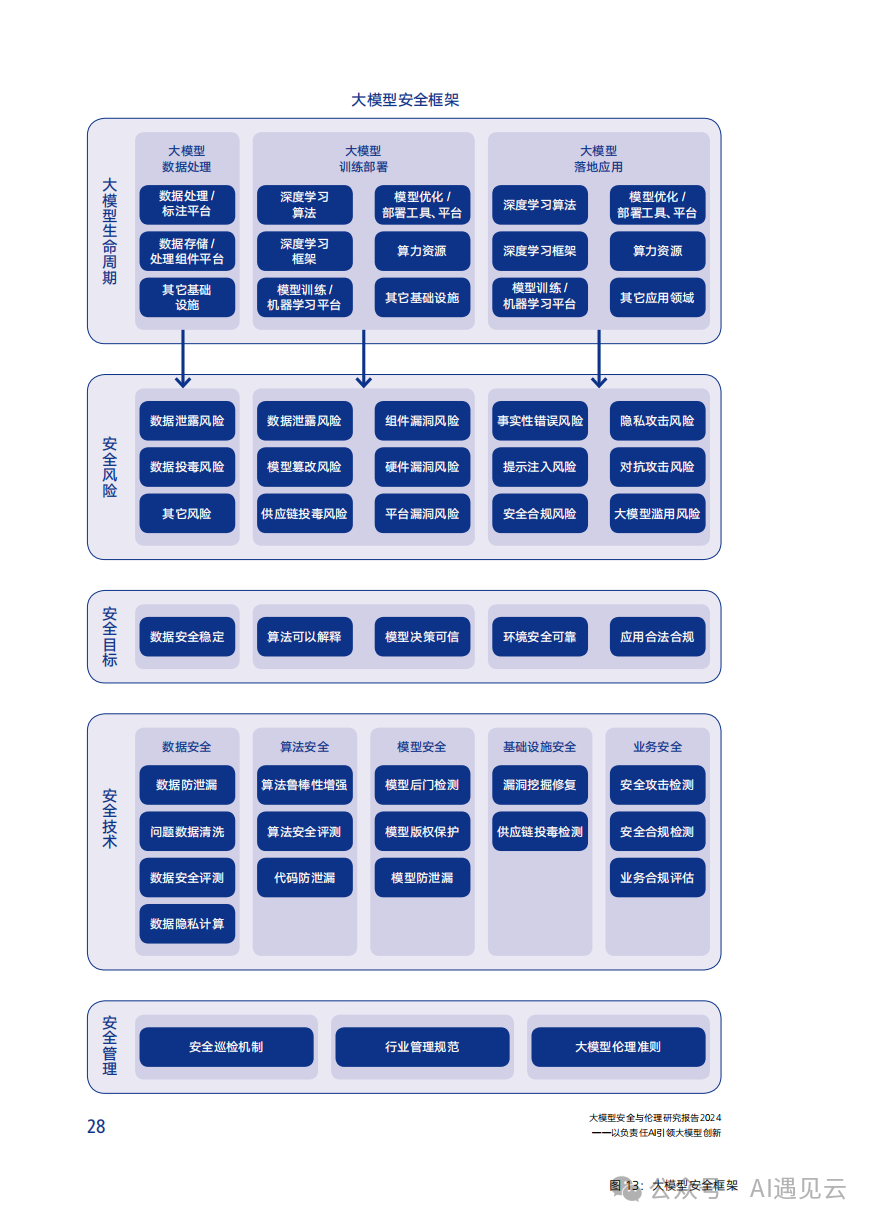

下圖為騰訊研究員整理的大模型全鏈路風險框架:

OWASP Top 10 for LLM Applications

2022 年底,隨著ChatGPT進入大眾市場,人們對大型語言模型 (LLM) 的關注尤為濃厚。渴望利用大語言模型潛力的企業正在迅速將其整合到其運營和面向客戶的產品中。然而,大語言模型的采用速度已經超過了全面安全協議的建立速度,導致許多應用程序容易受到高風險問題的影響。

很明顯,大語言模型還沒有統一的資源來解決這些安全問題。OWASP作為傳統安全領域的權威開放組織為LLM Applications定義Top 10問題,用以指導在LLM應用領域的安全生產,我把它羅列如下,用來補充生產過程中生成式大語言模型需要考慮的問題:

- LLM01 提示詞(Prompt) 注入(Injection):黑客通過設計過的輸入(提示詞)操縱大型語言模型(LLM),從而導致 LLM 執行意外操作。提示詞注入會覆蓋系統提示詞,而間接注入操縱外部數據源進行注入攻擊。

- LLM02 不安全的輸出處理:當 LLM 輸出未經審查而被接受時,就會出現此漏洞,從而暴露后端系統。濫用可能會導致 XSS、CSRF、SSRF、權限升級或遠程代碼執行等嚴重后果。

- LLM03 訓練數據中毒:當 LLM 培訓數據被篡改,引入損害安全性、有效性或道德行為的漏洞或偏見時,就會發生這種情況。來源包括 Common Crawl、 WebText 、 OpenWebText和書籍。

- LLM04 拒絕服務模型:攻擊者對大型語言模型進行資源密集型操作,導致服務降級或高成本。由于LLM的資源密集型性質和用戶輸入的不可預測性,該漏洞被放大。

- LLM05 供應鏈漏洞:LLM 應用程序生命周期可能會受到易受攻擊的組件或服務的影響,從而導致安全攻擊。使用第三方數據集、預先訓練的模型和插件可能會增加漏洞。

- LLM06 敏感信息披露:LLM可能會在其回復中泄露機密數據,從而導致未經授權的數據訪問、隱私侵犯和安全漏洞。實施數據清理和嚴格的用戶策略來緩解這種情況至關重要。

- LLM07 不安全的插件設計:LLM 插件可能具有不安全的輸入和不足的訪問控制。缺乏應用程序控制使它們更容易被利用,并可能導致遠程代碼執行等后果。

- LLM08 過度代理:基于LLM的系統可能會采取導致意想不到的后果的行動。該問題源于授予基于 LLM的系統過多的功能、權限或自主權。

- LLM09 過度依賴:過度依賴LLM而不受監督的系統或人員可能會因LLM生成的不正確或不適當的內容而面臨錯誤信息、溝通不暢、法律問題和安全漏洞。

- LLM10 模型盜竊:這涉及對專有LLM模型的未經授權的訪問、復制或泄露。影響包括經濟損失、競爭優勢受損以及敏感信息的潛在訪問。

結語

隨著對生成式大語言模型(LLM)安全問題的深入探討,我們認識到,技術的迅猛發展帶來了巨大的潛力,也伴隨著不容忽視的風險。從Tay的爭議到ChatGPT的數據泄露,再到GitHub Copilot的版權爭議,這些事件提醒我們,在享受LLM帶來的便利時,必須警惕其潛在的安全威脅。OWASP Top 10 for LLM Applications的提出,為我們提供了一個識別和緩解這些風險的框架。面對這些挑戰,我們必須采取積極的措施,包括技術防護、倫理對齊和責任輸出,以確保LLM的安全和可靠性。最終,我們的目標是實現LLM技術的健康發展,使其在尊重用戶和社會的前提下,為人類社會帶來更多的福祉。隨著技術的不斷進步,我們期待一個更加安全、負責任的LLM應用時代的到來。

參考文獻

Top 10 for LLMs and Gen AI Apps 2023-24

??https://genai.owasp.org/llm-top-10-2023-24/??

大模型安全與倫理研究報告2024

騰訊研究院

本文轉載自 ??AI遇見云??,作者: 周良杰