什么是生成式大模型?大模型與生成式大模型的區別? 原創

?“ 生成式AI或者說AIGC的本質是一種基于概率分布的數據表征技術 ”

最近一段時間一直在做AIGC(人工智能生成內容)方面的應用,而AIGC屬于生成式AI的范疇;剛開始只是把這些生成式AI拿過來用一下,但隨著對大模型了解的加深,突然發現生成式AI好像也沒有那么簡單。

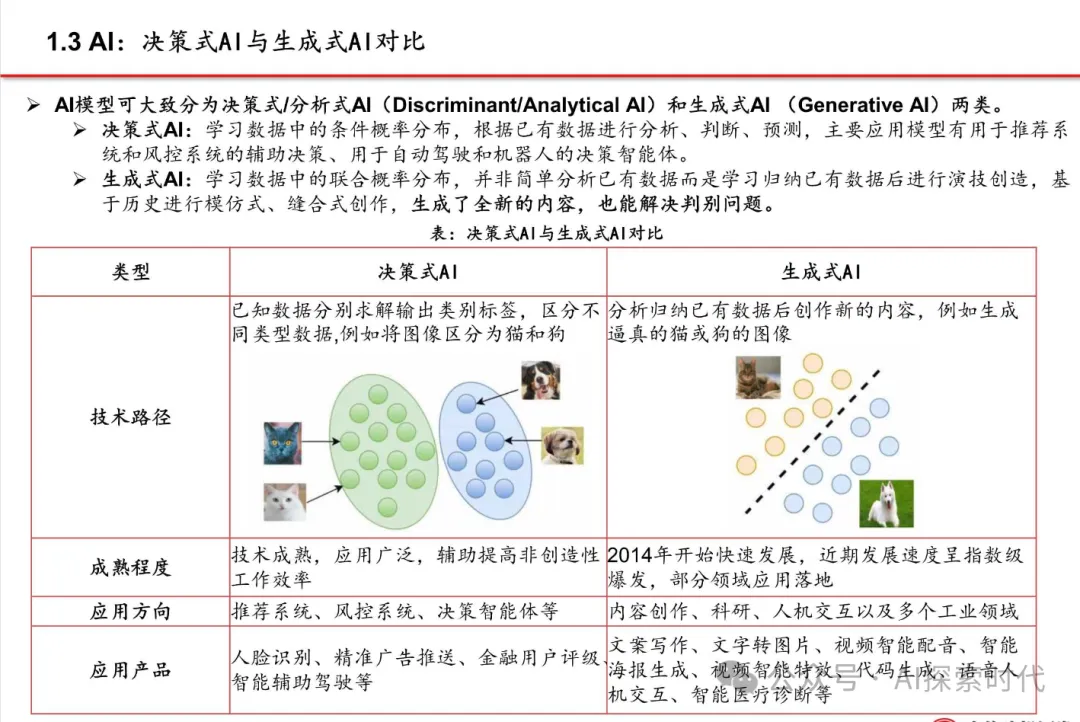

比如說,生成式AI是怎么實現的?可能有人會這么回答,是基于Transformer等架構實現,基于概率分布的一種模型。當然,這么說好像也沒錯,但非生成式AI又是怎么實現的呢?

生成式AI

什么是生成式AI?

簡單來說,能夠根據輸入輸出新的內容的AI就是生成式AI;但生成式AI是怎么做到的呢?

有很多人會把大模型當作生成式AI,但事實上生成式AI和大模型并不是一回事;生成式AI屬于更寬泛的一個范疇,任何能夠實現內容生成的AI技術都屬于生成式AI。

但大模型生成內容只是生成式AI的一種實現方式,除了大模型之外還有其它的方式可以實現生成式AI;比如,隱馬爾可夫模型,生成對抗網絡等。

那生成式AI是怎么實現的呢?它的技術原理是什么?我們都知道模型在設計完成之后,使用訓練數據進行訓練,就可以讓模型生成相關領域的內容;但這個模式是怎么設計實現的呢?

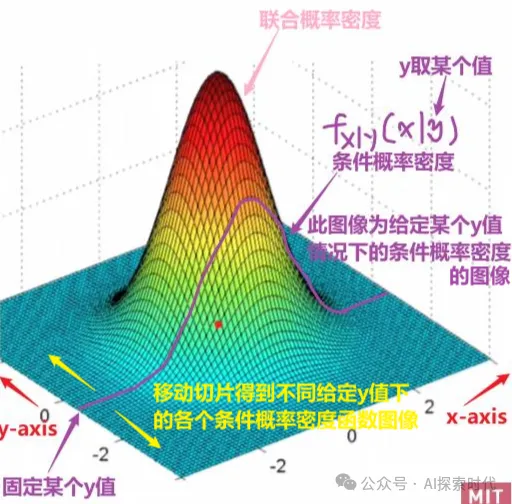

嚴格來說,現在的生成式AI都是基于概率分布實現的;生成式AI主要分為兩個部分:

學習數據分布:通過訓練數據學習輸入特征X和標簽Y的聯合概率分布P(X, Y)

生成新樣本: 通過條件概率P(X|Y)或P(Y|X),生成新的數據樣本

所以,簡單來說生成式AI就做了兩件事,學習舊數據,生成新樣本;大模型的訓練就是學習的過程,而回答問題或生成內容就是在生成新的樣本。

但具體怎么學舊數據,又怎么生成新樣本,這是一個需要解決的問題;而目前的生成式大模型大都是基于Transformer架構,實現的一種數學模型。

所以,生成式AI是一種通過學習聯合概率分布,從而能夠生成新的數據樣本;它不僅能夠分類,而且能生成與訓練數據相似的樣本,而這也是AIGC的基礎,沒有它AIGC就是水中月,鏡中花。

這也解釋了,為什么大模型需要大量的線性運算,原因就在于只有線性的概率分布,才有預測的可能性;畢竟大模型需要就是有跡可循。

ok ,既然前面說了生成式大模型是基于概率進行預測,那怎么才能用概率去表征訓練數據呢?也就是說大模型學習的原理是什么樣的?

大模型訓練或者說學習的過程,就是對訓練數據的表征過程,通過對訓練數據的表征,大模型參數就可以記錄不同數據之間的關系,比如用向量進行表示。

通過計算不同數據之間的向量關系,以此來表示數據之間的概率關系等。

因此,以目前市面上各種各樣的AIGC產品來看,比如文字,圖像,視頻,音樂,代碼生成等模型;都是通過一種數學模型和算法,來表征這些數據之間的關系,也就是空間向量的坐標關系。

通過這些關系,大模型就能夠去理解用戶的輸入,然后根據輸入生成新的數據樣本。

所以,生成式AI的本質或者說AIGC的本質,是通過對某種數據特征的學習和描述;然后再根據這些數據特征,去生成相似的新的數據。

舉例來說,小孩子第一次看到照片,他也不懂得攝像的技術,也不知道什么是像素點;但如果你告訴他,用筆這樣,那樣,再這樣就可以畫出一幅畫;那么他就會模仿你這個行為去畫一幅畫,雖然他可能并不知道這是一幅畫。

而這就是數據的表征,雖然大模型并不知道什么是像素點,什么是采光;但它能根據不同圖像之間的區別,記住這樣那樣再這樣就可以生成一幅畫。

所以說,生成式AI或者說生成式大模型的本質是一種數據表征技術,然后根據表征特點的概率,生成一個最符合當前概率的內容。

而生成式AI最大的作用就是——創造,通過這種方式可能會讓AI具備遠超人類本身的創造力。

?

本文轉載自公眾號AI探索時代 作者:DFires