OmniTokenizer-視覺tokenizer生成

本文介紹一種視覺tokenizer的生成。

AIGC生成模型在人工智能領域發展迅速,視覺生成主要有基于語言模型和擴散模型兩種范式,而tokenizer是其核心組件。現有tokenizer分別針對圖像或視頻輸入設計,存在應用靈活性和數據可擴展性的局限。因此需要一種聯合圖像 - 視頻標記器,以實現從兩種數據中聯合學習,緩解單模態數據稀缺問題,并提高模型的通用性和可擴展性。

今天介紹一種OmniTokenizer方法,感興趣的小伙伴可以看看原文:https://arxiv.org/abs/2406.09399

模型架構

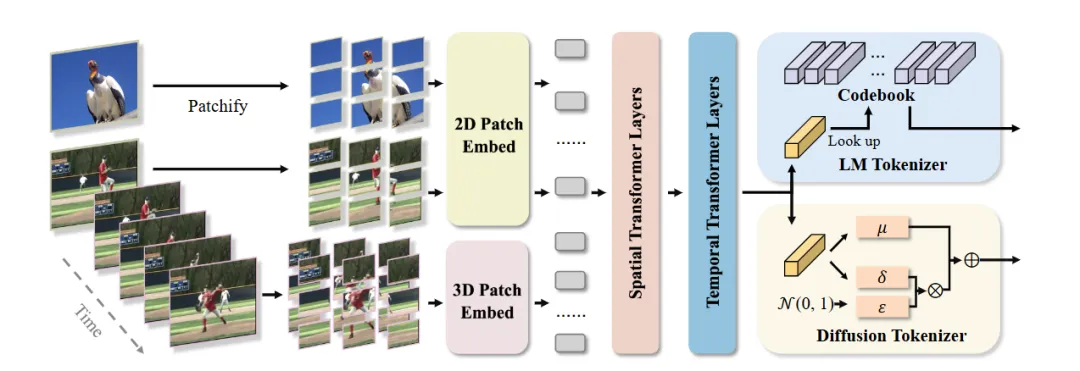

上圖為OmniTokenize架構圖,從中可以看出:

- OmniTokenizer 由 patch 嵌入層和獨立的時空注意力塊組成。采用時空解耦架構,在空間維度使用窗口注意力機制,因其具有局部聚合能力和效率;在時間維度使用因果注意力機制,以捕捉視頻中的運動并確保時間連貫性。

- 輸入數據首先進行 Patchify 操作,將圖像和視頻幀分別分割為不重疊的塊并投影得到嵌入,然后通過時空分離的編碼器獲取潛在代碼,解碼器與編碼器對稱,最后通過線性投影層將時空標記映射回像素空間。

訓練過程

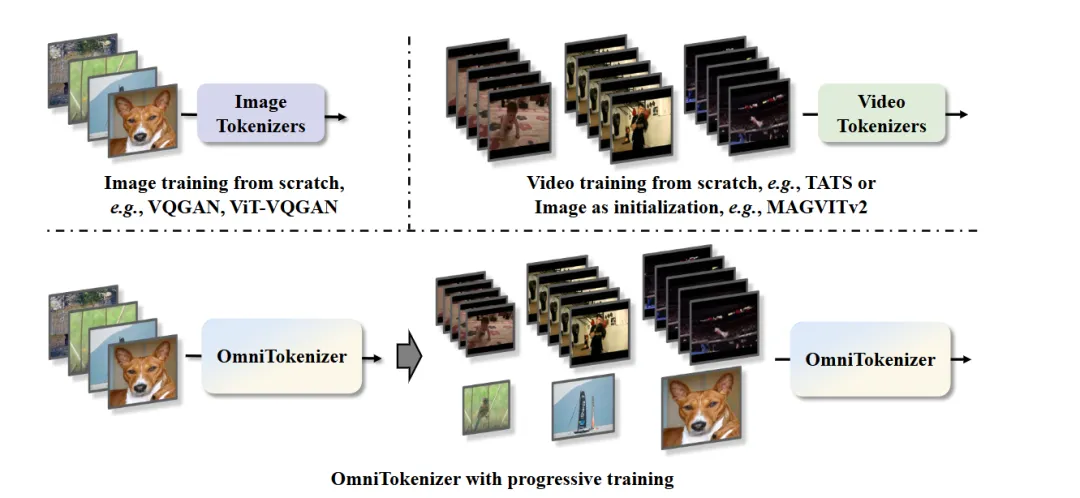

漸進式訓練策略,包括兩個連續階段:

- 首先在固定分辨率的圖像數據上進行訓練,以建立對靜態視覺信息的理解,即基礎的空間編碼能力

- 然后引入視頻數據,在多分辨率上進行聯合訓練,學習時間動態信息,從而使模型能夠準確捕捉單幀的空間細節和視頻序列的時間關系。訓練過程中使用向量量化目標函數,并在后期通過 KL 散度進行微調

實驗結果

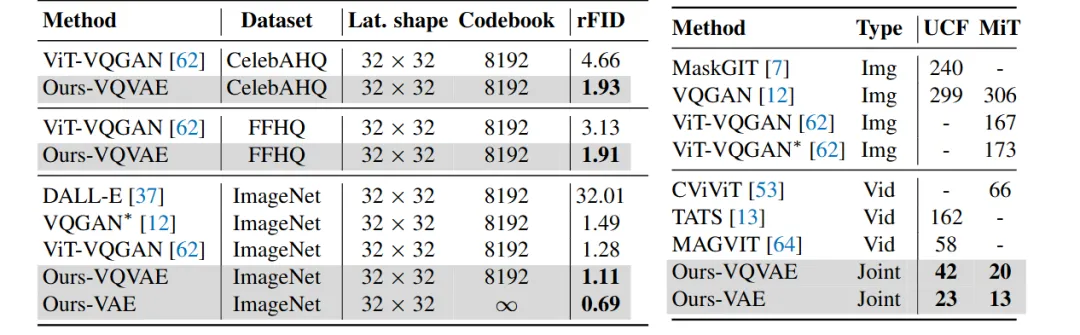

在 ImageNet、CelebA - HQ 和 FFHQ 等圖像數據集以及 UCF - 101 和 Moments - in - Time 等視頻數據集上評估。在相同壓縮率和碼本大小下,OmniTokenizer - VQVAE 在圖像數據集上的重建 FID 指標優于現有方法,在 ImageNet 上達到 1.11,比之前的 SOTA 方法 ViT - VQGAN 提高了 13%;OmniTokenizer - VAE 進一步將 FID 降低到 0.69。在視頻數據集上也取得了最佳的重建結果。

文轉載自公眾號瓦力算法學研所,作者:喜歡瓦力的卷卷

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦