視覺文本視頻生成最強方案!Text-Animator效果確實好!

文章鏈接:https://arxiv.org/pdf/2406.17777

github鏈接:laulampaul.github.io/text-animator.html

視頻生成在游戲、電子商務和廣告等各行業中都是一個具有挑戰性但至關重要的任務。在文本到視頻(T2V)生成領域中,有效地在生成的視頻中視覺文本是一個尚未解決的重要方面。盡管在文本到視頻生成方面取得了一些進展,但現有的方法仍然無法直接在視頻中有效地視覺文本,因為它們主要集中在總結語義場景信息、理解和描繪動作。雖然最近在圖像級別的視覺文本生成方面的進展顯示出了一些希望,但將這些技術轉移到視頻領域面臨著一些問題,特別是在保持文本保真度和運動一致性方面。

本文提出了一種名為Text-Animator的創新方法,用于視覺文本視頻生成。Text-Animator包含一個文本embedding注入模塊,可以精確地描繪生成視頻中視覺文本的結構。此外,還開發了一個攝像機控制模塊和一個文本優化模塊,通過控制攝像機運動和視覺文本的運動來提高生成的視覺文本的穩定性。定量和定性實驗結果表明,Text-Animator在生成視覺文本的準確性方面優于最先進的視頻生成方法。

主要貢獻可以概括為:

- 提出了Text-Animator,這是一種新穎的方法,可以在視頻中生成視覺文本并保持生成視覺文本的結構一致性。這是首次嘗試解決視覺文本視頻生成問題。

- 為Text-Animator開發了一個文本embedding注入模塊,可以精確描繪視覺文本的結構信息。此外,還提出了一個攝像機控制和文本優化模塊,以準確控制攝像機運動和生成視覺文本的運動,從而提高生成的穩定性。

- 大量實驗表明,Text-Animator在生成視覺文本的準確性方面,比現有的文本到視頻和圖像到視頻的生成方法有顯著的優勢。

方法

本節首先介紹Text-Animator的流程。然后分別介紹關鍵組件的詳細信息。

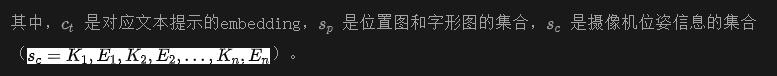

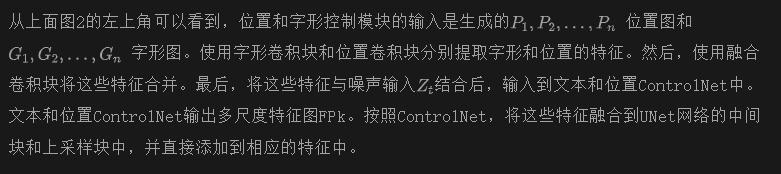

文本條件的視頻生成流程

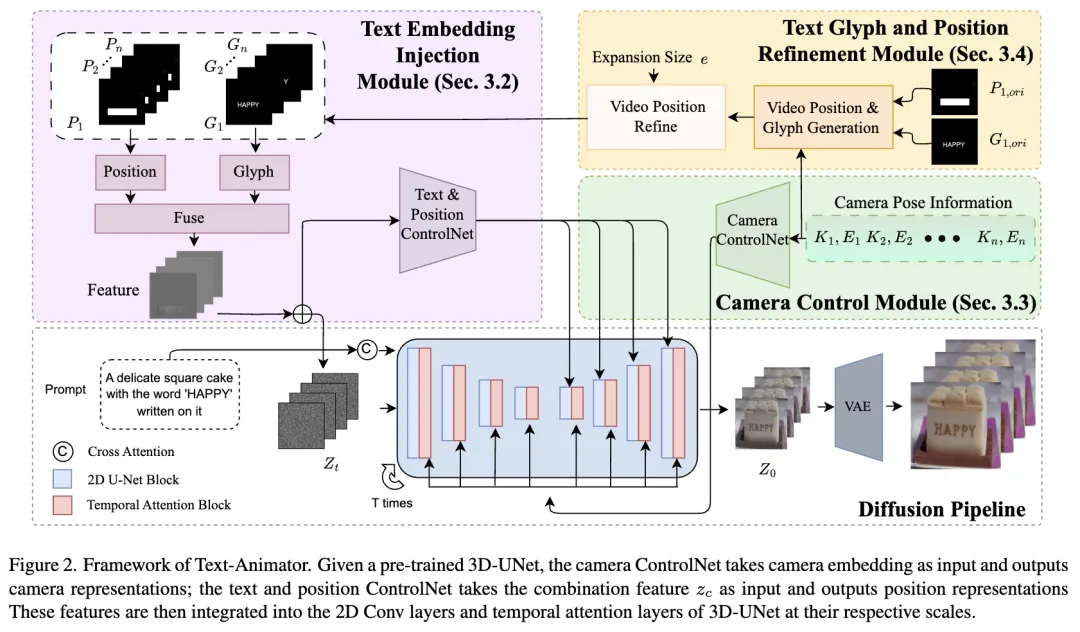

首先,介紹下網絡的整體框架,如下圖2所示。

文本embedding注入模塊

在生成包含視覺文本的視頻時,首先需要考慮的是如何將所需文本的視覺特征有效地embedding到基礎模型(預訓練的UNet模型)中。受到之前在圖像中視覺文本方法的啟發,通過結合文本框的位置和渲染的字形,將文本條件embedding到潛在空間中。文本框指示了在生成的圖像中進行渲染的位置,而渲染的字形利用現有的字體樣式(即‘Arial Unicode’)來預初始化字符的樣式。此外,與圖像生成不同,視頻生成涉及跨多個幀處理特征。為了利用用于圖像生成的預訓練特征提取器,使用逐幀特征提取器從每個幀中提取特征,然后在輸入預訓練UNet模型之前連接這些特征。

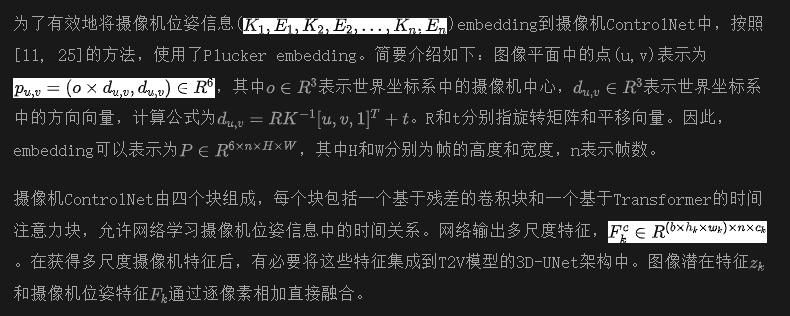

穩定文本生成的攝像機控制

在引入文本embedding注入模塊后,Text-Animator現在能夠生成視覺文本視頻,并使文本隨場景移動。然而,這種文本移動有時會與視頻中物體的移動脫節。例如,在提示“寫有‘STOP’的標志”中,“STOP”部分可能會向右移動,而標志則向左移動。為了生成更穩定的視頻,需要設計額外的控制模塊。因此,建議使用攝像機位姿信息來控制文本的移動,并確保與場景內容的一致性。本節主要討論如何將攝像機位姿信息embedding到基礎模型中。

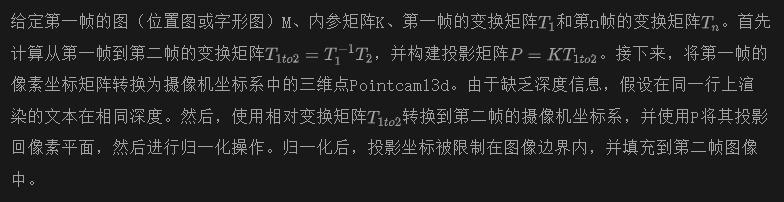

輔助文本字形和位置優化

為了實現攝像機控制模塊與文本embedding注入模塊之間的協作,有必要使用視頻中的攝像機位置信息作為指導,通過考慮第一幀的指導來生成后續幀的位置圖和字形圖。生成方法如下:

實驗

實現細節

選擇AnimateDiffV3作為基礎文本到視頻(T2V)模型。模型的運動模塊權重使用AnimateDiffV3進行初始化。其他部分的權重使用DreamShaper或原始的SD1.5進行初始化。攝像機控制網和文本及位置控制網的訓練方法和數據集使用[11]和[27]中的方法。最后,將所有部分整合并固定參數進行推理。G和P的圖像尺寸分別設置為1024×1024和512×512。擴展尺寸e設置為1.2。在采樣過程中,隨機選擇一些提示語(如“這些文本寫在上面:xxx”)并將它們連接到標題上。推理步驟和指導尺度分別設置為25和7.5。最終,模型輸出尺寸為16×256×384的視頻。

數據集和指標

由于缺乏用于視覺文本生成評估的文本到視頻數據集,使用AnyText-benchmark的LAION子集來評估視覺文本視頻生成的效果。然而,在該數據集中,有些圖像的文本和主要內容是分開的,而有些圖像只有文本沒有任何圖像內容,這對于視頻生成是沒有意義的。因此,從數據集中選擇了約90張圖像組成測試集,命名為LAION子集。

首先,需要評估文本生成的準確性和質量。根據論文[27],采用了句子準確率(Sen. Acc)指標,其中每一行生成的文本根據指定位置裁剪并輸入OCR模型以獲得預測結果。此外,使用歸一化編輯距離(NED)來衡量兩個字符串之間的相似性。為了確保Text-Animator具有更好的視頻生成能力,利用弗里切特embedding距離(FID)來評估生成視頻與真實視頻之間的視頻外觀質量。此外,還采用了提示相似性和幀相似性指標。前者評估輸入描述與輸出視頻之間的語義相似性,后者評估生成視頻的連貫性。

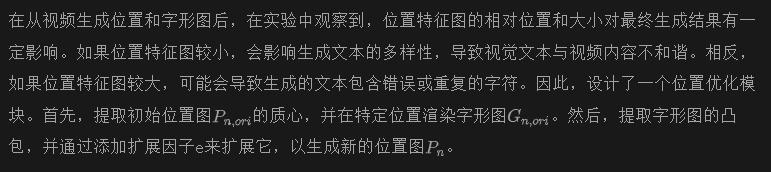

定量結果

定量結果如下表1所示。比較方法分為兩部分。第一部分是特定圖像視覺文本生成工作的組合(GlyphControl和 Anytext)+ 最先進的圖像到視頻(I2V)工作(AnimateLCM,I2VGEN-XL)。第二部分是一階段方法。使用Animatediff-SDXL作為基礎模型,并使用CIVIAI的兩個微調lora權重,分別表示為Animatediff-SDXL(Text Lora A)1和Animatediff-SDXL(Text Lora B)2。這兩個lora權重使用一些具有視覺文本的圖像進行微調。從表1可以看出,這些方法的參數比Text-Animator大得多(超過41%)。

此外,Text-Animator在生成視覺文本的準確性方面顯著優于其他方法,根據評價指標Sen. ACC和NED(分別比最佳方法高出191.8%和30.4%)。這反映了本文方法生成文本的準確性,且生成的視頻中文本沒有崩潰。對于衡量生成視頻與輸入文本相似度的指標(FID和Prompt相似度),Text-Animator取得了第二好的結果。在提示相似度方面,與最佳方法的差距僅為0.6%。在衡量視頻穩定性和幀相似度的指標上,Text-Animator取得了第二好的結果。觀察到,最佳方法Pika傾向于生成移動較小的視頻,使其在該指標上具有優勢。

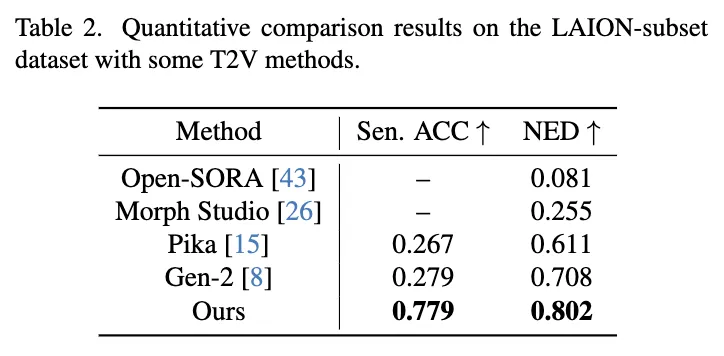

此外,在下表2中,還與Open-SORA和最近的三個最先進API,Morph Studio,Pika 和Gen-2進行了比較。Open-SORA和Morph Studio沒有Sen. ACC得分,因為它們無法生成正確的句子或單詞。Text-Animator在Sen. ACC方面顯著優于其他方法,并且在NED方面也表現優于其他方法。

定性結果

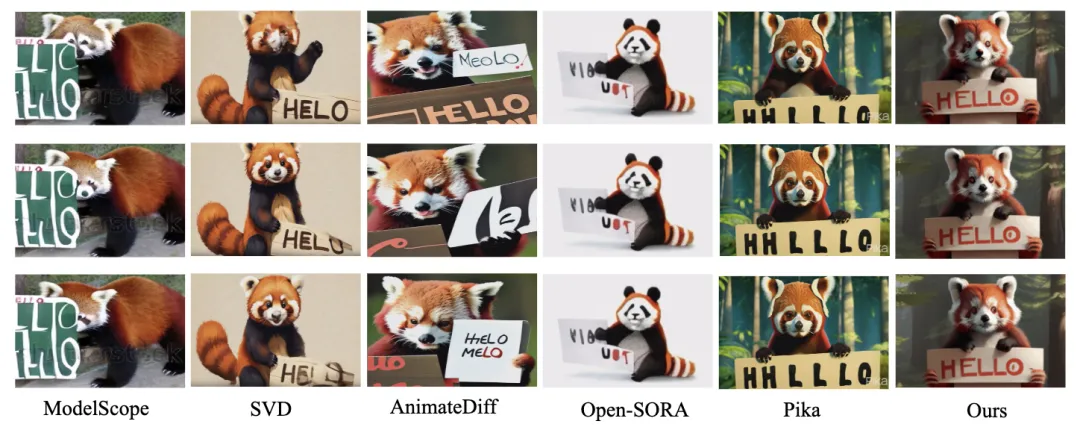

研究者們首先將本文模型與文本到視頻生成領域的最先進T2V模型或API進行比較(包括ModelScope、SVD(Stable Video Diffusion)、AnimatedDiff、Open-SORA和Pika),如下圖3所示。這些模型展示了對上下文的理解能力,但無法生成特定文本并保持文本一致性。與SVD相比,本文的模型不僅能準確渲染每個字符(本文的:‘HELLO’ vs SVD:‘HELO’或Pika:‘HHLLLO’),而且還能保持一致性。SVD未能學習文本的運動信息,導致文本隨著時間的推移變得越來越混亂。

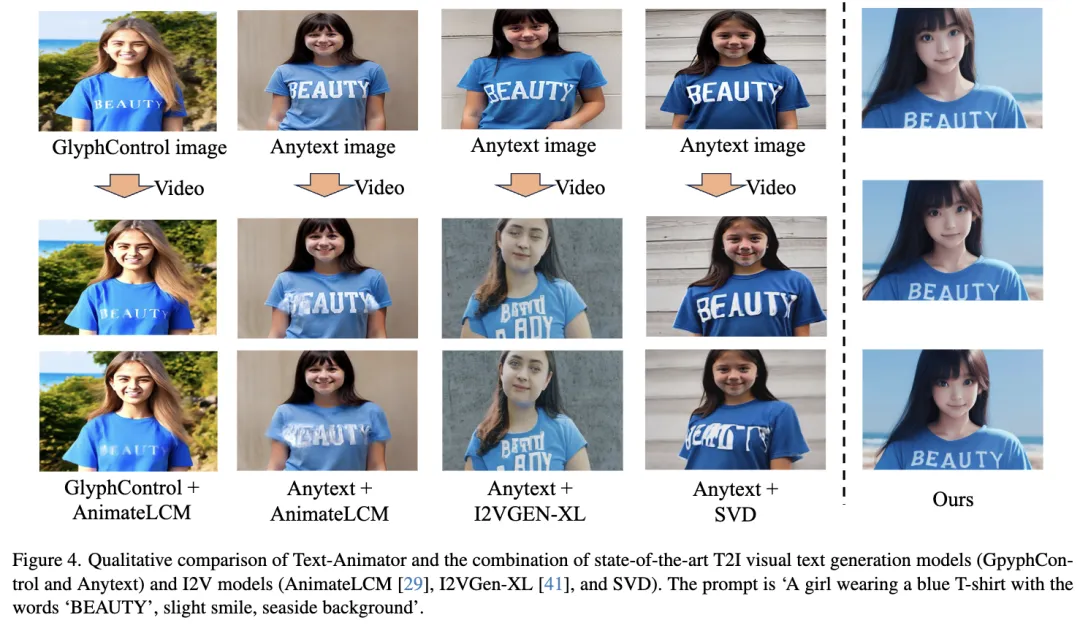

至于與特定視覺文本生成工作的比較,由于目前沒有專門為視覺文本生成設計的T2V工作,將Text-Animator與特定T2I工作的組合(如GlyphControl和Anytext)和最先進的I2V工作(如AnimateLCM、I2VGen-XL和SVD )進行對比。如下圖4所示,Text-Animator在生成文本與背景的整合方面表現優越,而Anytext無法生成海邊背景。當使用I2V方法從參考幀圖像生成視頻時,文本部分往往會變得模糊或扭曲。Text-Animator很好地保持了文本部分的清晰度,并與圖像內容協調移動。

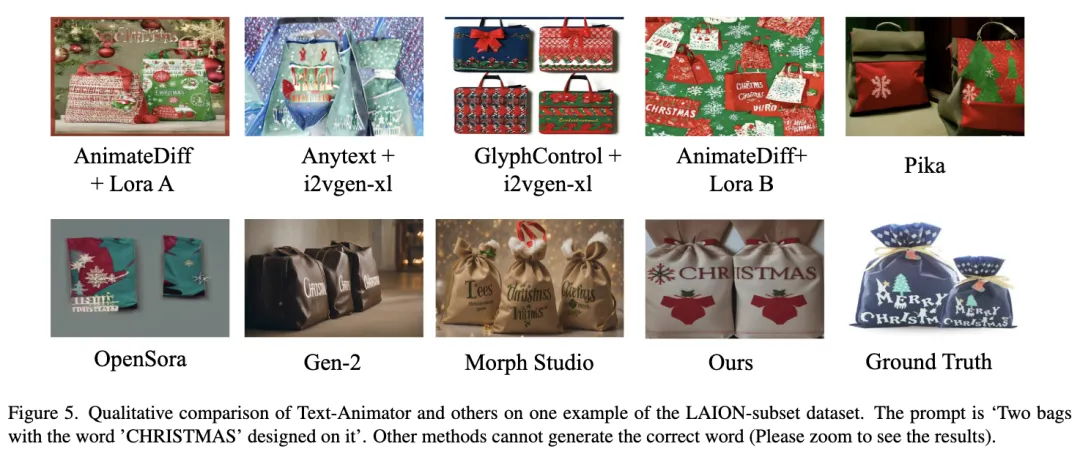

此外,在下圖5中,展示了LAION子集數據集的一個示例。只有Text-Animator能夠正確顯示視覺字符(CHRISTMAS)和包的數量(兩個)。

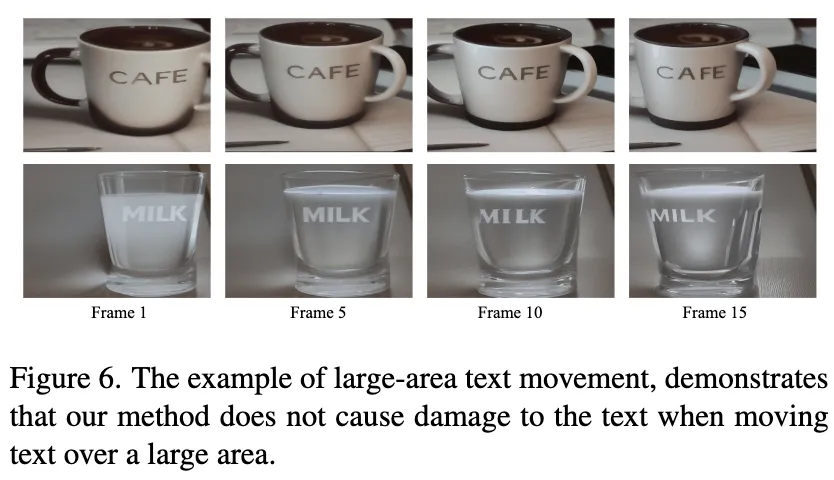

同時,還進行了實驗以驗證本文方法的魯棒性。在下圖6中,展示了Text-Animator在文本區域大幅移動時的魯棒性。現有的SOTA方法在小幅移動期間變形了文本區域(如上例所示),因此這些方法的可視化結果未在此展示。這兩個示例的文本分別為“帶有‘cafe’字樣的辦公室桌上的咖啡杯”和“帶有‘MILK’字樣的牛奶瓶”。移動方向從右到左。可以看到,即使在大范圍的相機移動下,Text-Animator仍然能夠保持文本的結構。

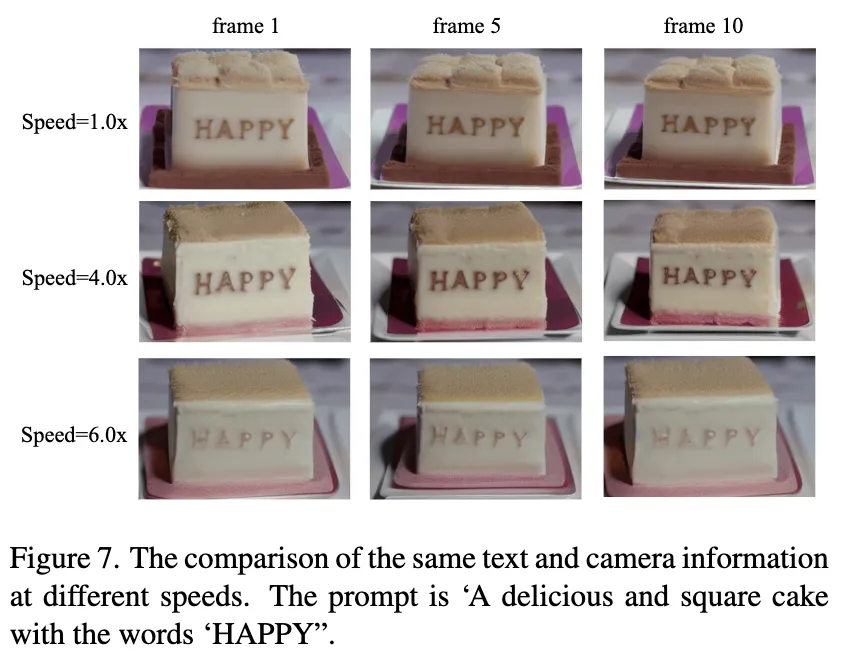

下圖7展示了在相同的相機信息下,通過采樣間隔幀的相機信息,可以控制其移動速度。即使在原速的4倍或6倍速度下,Text-Animator仍然能夠保持文本的結構。

消融研究

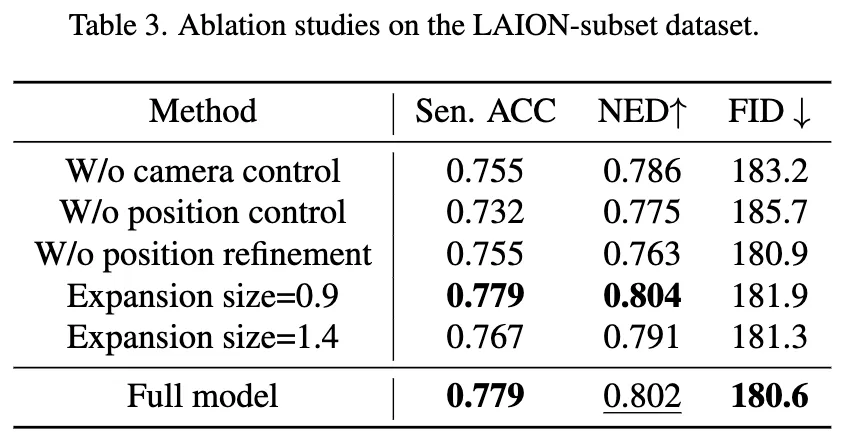

在這一部分中,為了說明本文方法的貢獻,在LAION子集上進行了消融研究。定量比較結果如表3所示。

雙重控制: 進行了消融研究以分析雙重控制設計的有效性。一般來說,僅使用位置框進行引導而不使用相機姿態是可行的。因此,設計了“沒有相機控制”的模型,該模型相對于原始模型去掉了相機引導模塊。此外,還移除了位置塊,僅使用相機姿態和字形embedding,并將此模型命名為“沒有位置控制”。在上表3中,可以看到,在NED指標上,“沒有相機控制”模型的性能比原始模型下降了0.016,而“沒有位置控制”模型的性能比原始模型下降了0.027。

位置精細化和擴展尺寸: 研究者們還進行了實驗,以分析提出的精細化模塊的有效性。當移除視頻位置精細化時,使用LAION子集中的默認位置,并在上表3中將模型表示為“沒有位置精細化”。可以看到,使用默認位置會降低準確性。此外,還進行了適當擴展尺寸的實驗。嘗試了兩個擴展系數:0.9(小于1.2)和1.4(大于1.2)。可以觀察到,雖然較小的擴展系數提高了視頻中文本的準確性,但對視頻生成的質量產生了負面影響。另一方面,較大的擴展系數導致一些字符在視頻中重復出現,從而降低了文本的準確性。

結論

本文提出了Text-Animator,一種創新的方法,用于解決在視覺文本視頻生成領域中將文本元素有效地集成到生成視頻中的挑戰。Text-Animator不僅強調文本的語義理解,還注重細粒度的文本語義,確保視覺文本在動態集成到視頻內容中的同時保持運動連貫性。Text-Animator引入了雙重控制機制——相機和位置控制,以同步文本動畫與視頻運動,從而增強文本元素與視頻場景之間的統一性和協調性。通過廣泛的定量和視覺實驗,證明了Text-Animator在視頻質量和文本表示的保真度方面優于現有的T2V和混合T2I/I2V方法。

本文的貢獻不僅解決了當前的挑戰,還激發了對這一快速發展的多媒體內容生成領域的進一步探索和創新。

本文轉自 AI生成未來,作者:Lin Liu等