清華團隊靠強化學習讓 7B 模型打敗 GPT-4o 數學推理

OpenAI o1 和 o3 模型的發布證明了強化學習能夠讓大模型擁有像人一樣的快速迭代試錯、深度思考的高階推理能力,在基于模仿學習的Scaling Law 逐漸受到質疑的今天,基于探索的強化學習有望帶來新的 Scaling Law。

近日,清華大學 NLP 實驗室聯合上海 AI Lab,清華大學電子系及 OpenBMB 社區提出一種新的結合過程獎勵的強化學習方法—— PRIME(Process Reinforcement through IMplicit REwards),采用 PRIME 方法,研究人員不依賴任何蒸餾數據和模仿學習,僅用 8 張 A100,花費一萬塊錢左右,不到 10天 時間,就能高效訓練出一個數學能力超過 GPT-4o、Llama-3.1-70B的 7B 模型 Eurus-2-7B-PRIME。

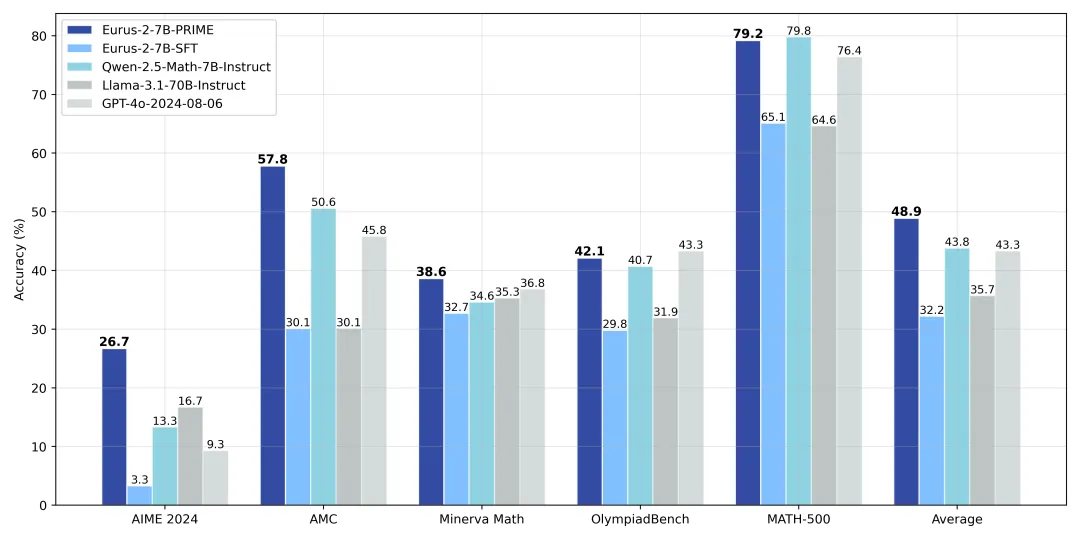

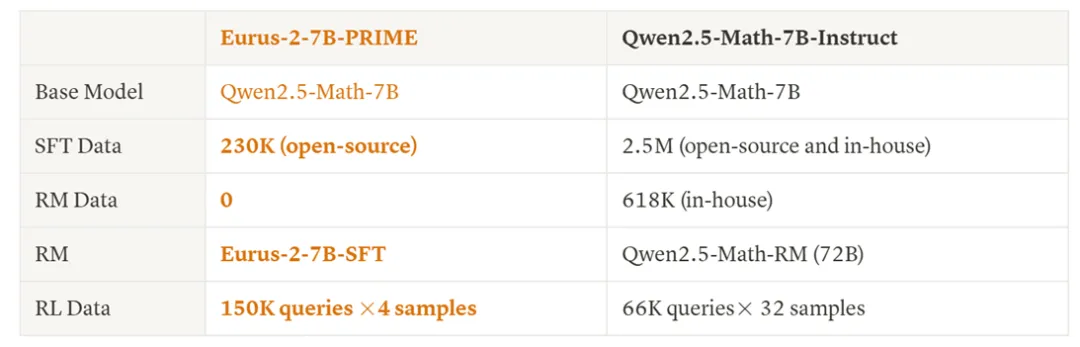

具體而言,研究人員利用 Qwen2.5-Math-7B-Base 作為基座模型,訓練出了新模型 Eurus-2-7B-PRIME ,并在美國 IMO 選拔考試 AIME 2024 上的準確率達到 26.7%,大幅超越 GPT-4o,Llama3.1-70B 和 Qwen2.5-Math-7B-Instruct,且僅使用了 Qwen Math 數據的 1/10。其中,強化學習方法 PRIME 為模型帶來了 16.7% 的絕對提升,遠超已知的任何開源方案。

該項目一經開源就在海外 AI 社區爆火,短短幾天 Github 取得 300+ star。

未來,基于 PRIME 方法和更強的基座模型有潛力訓練出接近 OpenAI o1 的模型。

? 技術 Blog 鏈接:

? GitHub 鏈接:

?? ??https://github.com/PRIME-RL/PRIME??

PRIME 方法介紹

長久以來,開源社區嚴重依賴數據驅動的模仿學習來增強模型推理能力,但這種方法的局限也顯而易見——更強的推理能力需要更高質量的數據,但高質量數據總是稀缺,使得模仿和蒸餾難以持續。雖然 OpenAI o1 和 o3 的成功證明了強化學習有著更高的上限,但強化學習有著兩個關鍵挑戰:(1)如何獲得精準且可擴展的密集獎勵;(2)如何設計可以充分利用這些獎勵的強化學習算法。

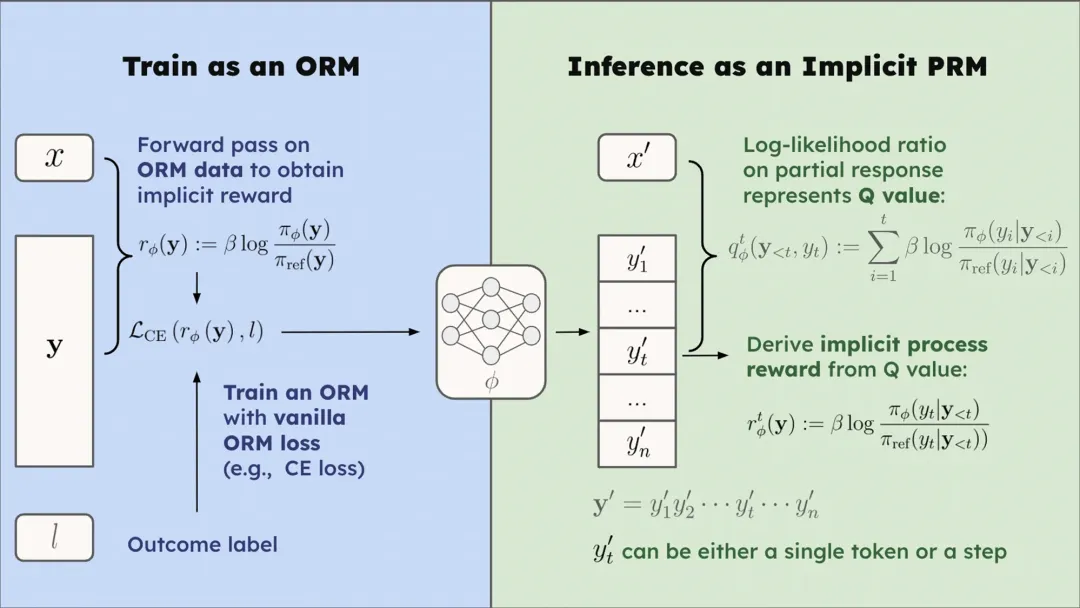

PRIME 算法從隱式過程獎勵(implicit process reward)的思想出發解決這兩個問題。隱式過程獎勵模型可以僅在輸出獎勵模型(outcome reward model, ORM)的數據,即答案的最終對錯上進行訓練,而隱式地建模過程獎勵,最終自動訓練出一個過程獎勵模型,這整個過程都有嚴格的理論保證。

詳細推導見:https://huggingface.co/papers/2412.01981

基于隱式過程獎勵模型的這種性質,研究人員指出將其應用于強化學習有三大優勢:

1. 過程獎勵:隱式過程獎勵模型能夠為每個 token 提供價值估計,在提供過程獎勵的同時無需訓練額外的價值模型(value model)

2. 可擴展性:隱式過程獎勵模型只需結果標簽即可在線更新。所以,我們可以結合策略模型采樣與結果驗證器來直接更新PRM,有效緩解分布偏移與可擴展性問題。

3. 簡潔性:隱式過程獎勵模型本質上就是一種語言模型。在實踐中,研究人員發現可以直接用初始的策略模型初始化 PRM。

隱式過程獎勵解決了PRM在大模型強化學習中怎么用,怎么訓,怎么擴展的三大問題,甚至不需要訓練額外的獎勵模型就可以開始強化學習,易用性和可擴展性極佳。

具體的PRIME算法流程如下圖所示,它是一種在線強化學習算法,能夠將每個token的過程獎勵無縫應用于強化學習流程中。

圖片

圖片

實驗結果

研究人員詳細比較了PRIME算法和基線方法。

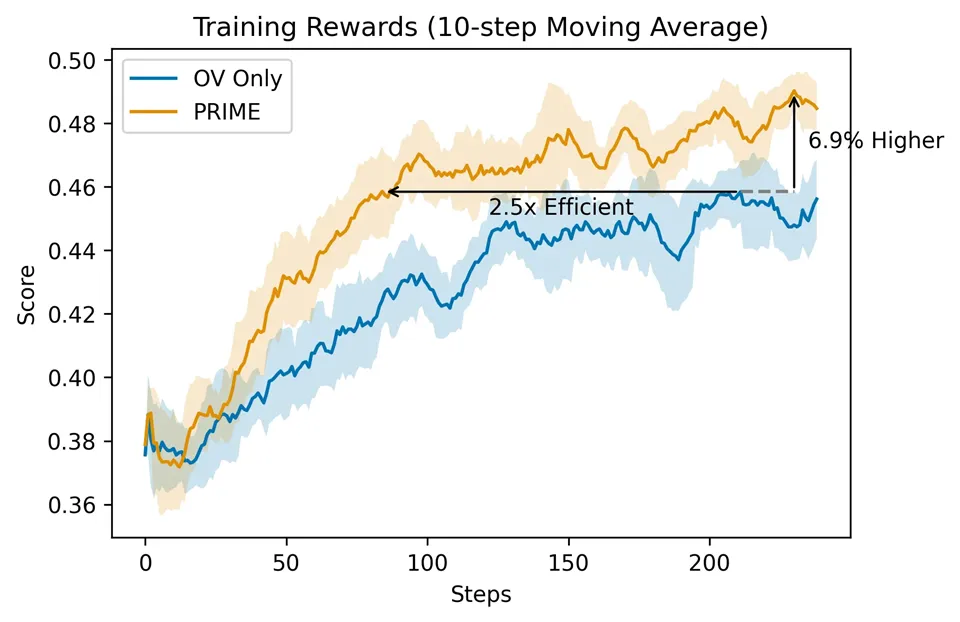

相比于僅用結果監督,PRIME有著 2.5 倍的采樣效率提升,在下游任務上也有著顯著提升。

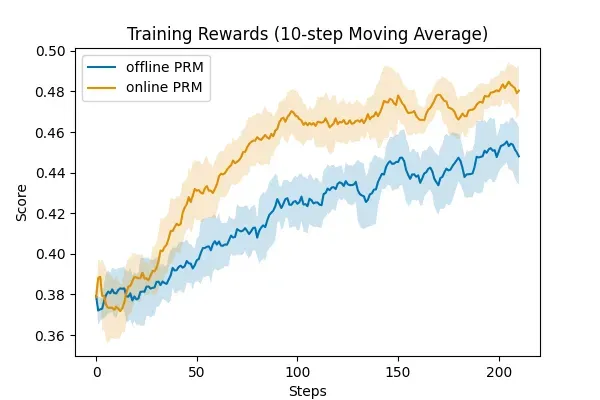

研究人員還驗證了PRM在線更新的重要性,可以看到,在線的PRM更新要顯著優于固定不更新的PRM,這也證明了PRIME算法設計和合理性。

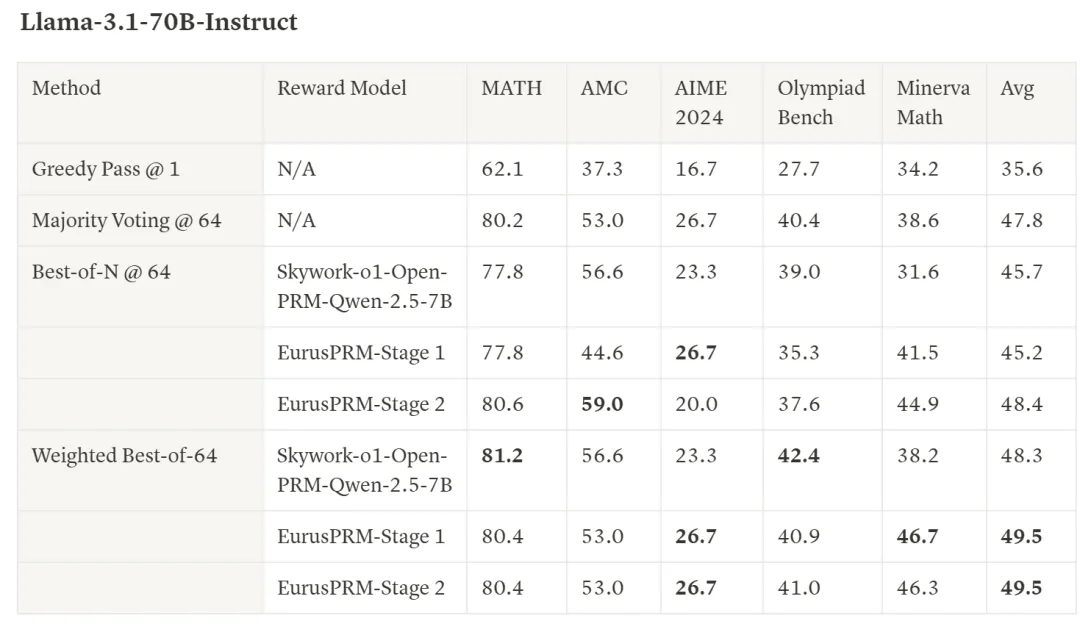

此外,研究人員還額外收集數據,基于 Qwen2.5-Math-Instruct 訓練了 SOTA 水平的 EurusPRM,能夠在 Best-of-N 采樣中達到開源領先水平。

Showcase 介紹

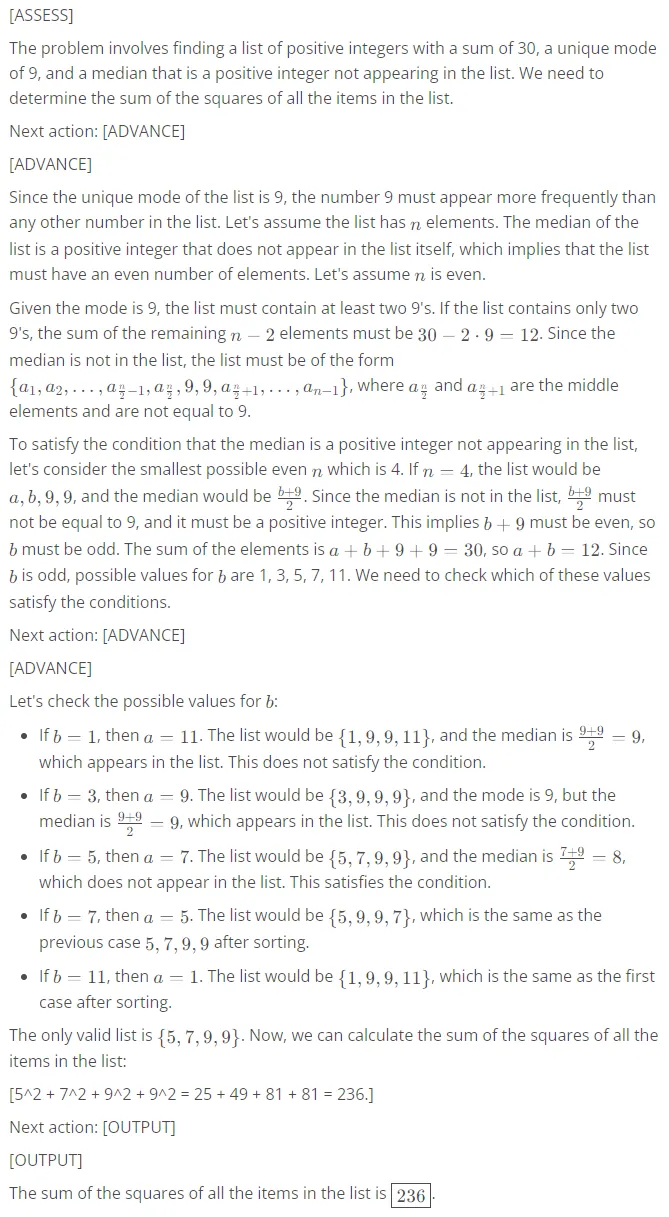

Question1:

AIME 2024試題,Claude-3.5-Sonnet做錯

Answer1:

Question2:

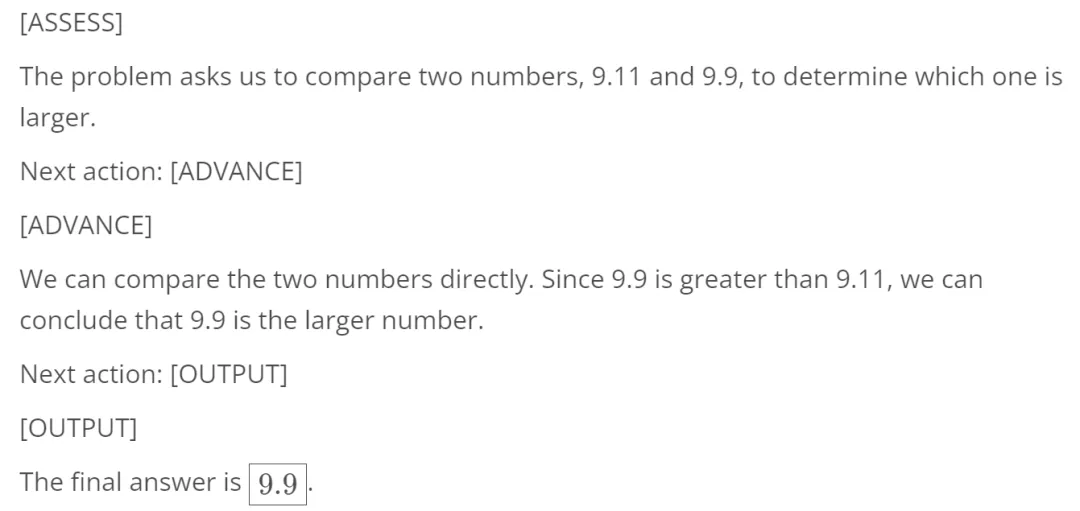

Which number is larger? 9.11 or 9.9?

Answer2:

強化學習是連接已有智能體(大模型)和現實世界(世界模型,具身智能)的橋梁,以及將世界反饋內化為模型智能的路徑,將在下一代人工智能的發展中起到重要作用。PRIME 算法創新性地將隱式過程獎勵與強化學習結合,解決了大模型強化學習的獎勵稀疏問題,有望推動大模型復雜推理能力的進一步提升。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區