斯坦福大學團隊使用多智能體強化學習訓練社交推理語言模型

社交推理游戲是一類需要玩家通過交流和推理來達成目標的游戲,典型的例子是我們熟悉的《狼人殺》,這些游戲要求玩家在有限的信息下,通過與其他玩家的交流和互動,推斷出某個隱藏角色的身份。假如讓多智能體玩狼人殺,這些智能體可以合作、競爭或者兩者兼而有之。研究多智能體環境不僅有助于理解智能體之間的互動,還能為開發更智能、更協調的系統提供理論基礎。

在多智能體環境中,使用自然語言進行交流是一種強大的工具。它不僅能讓獨立的智能體在部分可觀察的環境中共享信息,還能實現與人類的零樣本協調。然而大多數先前的研究存在局限性,要么依賴于大量人類演示的訓練,要么缺乏生成自然和有用交流策略的能力。在這項工作中,斯坦福大學的研究團隊探索了一種無需人類演示的方法,通過訓練語言模型,使其能夠使用自然語言就環境進行富有成效的討論。2 月 11 日,他們的研究論文《Training Language Models for Social Deduction with Multi-Agent Reinforcement Learning》發表于 arXiv 平臺。

研究團隊將溝通問題分解為傾聽和說話兩個方面。他們的主要思想是利用智能體的目標來預測有關世界的有用信息,作為指導溝通的密集獎勵信號。具體來說,通過訓練模型根據討論預測有關環境的信息來提高模型的傾聽技能。同時,通過多智能體強化學習,根據模型對其他智能體的影響獎勵消息,從而提高模型的說話技能。

他們研究的核心問題是如何在沒有人類示范的情況下,訓練語言模型使其在多智能體環境中進行有效的交流。研究團隊探討了如何利用智能體的目標預測世界的有用信息,作為密集獎勵信號指導交流。研究團隊以《我們之間》這款社交推理游戲為實驗平臺,通過多智能體強化學習,分析智能體在復雜社交環境中的表現和行為。研究團隊的主要目標是展示智能體在沒有大量任務特定數據的情況下,通過自我改進提升其交流和推理能力,并最終提高游戲勝率。

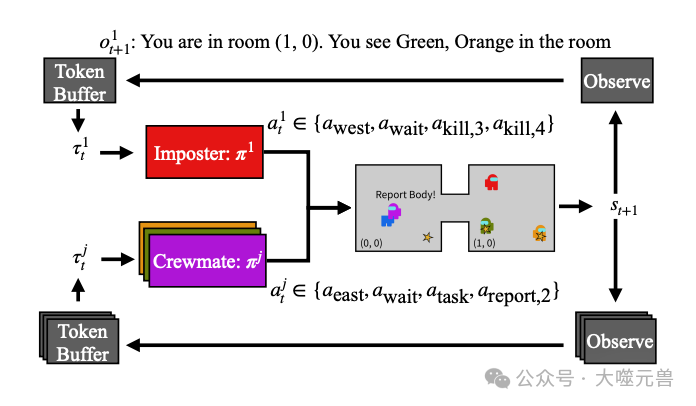

圖1:《我們之間》的游戲和討論階段示例。在游戲過程中,所有代理都在2D網格環境中導航(在這種情況下是1乘2的網格,在(0,0)和(1,0)處有兩個房間),代理可以在同一個房間里看到所有內容。在這里,紅色、綠色和黃色的試劑在房間(1,0),紫色和藍色的試劑在空間(0,0)。船員可以執行任務(由星星表示——在這個例子中有3個任務),而冒名頂替者會殺死船員。在這里,橙色和綠色的特工正在執行任務。特工也可以報告尸體,就像紫色特工目前正在做的那樣,這將啟動討論階段。在討論階段,代理利用大型語言模型生成自由形式的消息,這些消息由我們的框架指導,鼓勵機組人員有效地進行口語和聽力交流,并最終投票選出疑似冒名頂替者。右側顯示的示例討論基于我們訓練的模型生成的討論。

研究團隊由斯坦福大學的四位研究人員組成,他們在人工智能和多智能體系統研究方面具有豐富的經驗。Bidipta Sarkar 主要研究多智能體系統和強化學習,Warren Xia 專注于語言模型在多智能體環境中的應用,C. Karen Liu 的研究領域涵蓋機器人學和人工智能,特別是多智能體協作與協調,而 Dorsa Sadigh 則專注于機器人與人類互動、多智能體系統中的學習與推理。他們的共同努力不僅推動了本研究的順利進行,也為多智能體系統和自然語言處理的交叉研究提供了寶貴的見解。

相關工作

突現交流研究

突現交流是多智能體強化學習(MARL)中的一個重要主題,特別是在參考游戲和重復參考游戲的背景下。在這些游戲中,一方的發言者知道問題的真實答案(例如,從一組圖像中選出特定圖像),然后需要向傾聽者傳達該信息,傾聽者隨后需要選擇所指項目。早期研究表明,人類能夠迅速適應這些任務,利用心智理論推理來理解發言者的意圖。Hawkins等人展示了語言模型通過持續學習能夠適應人類的慣例。然而這些研究主要集中在明確知道答案的情況下,而在社交推理游戲中,所有代理都需要通過交流來集體學習答案,這使得挑戰更為復雜。突現交流研究為理解和改進多智能體之間的交流機制提供了寶貴的見解。

語言模型代理

在任務規劃和決策中,大型語言模型(LLM)憑借其對互聯網規模數據的訪問能力表現出色。在機器人學領域,先前的研究探索了如何使用語言模型根據自然語言指令規劃一系列高級操作。在虛擬游戲環境中,Park等人使用ChatGPT模擬虛擬小鎮的成員,盡管這些代理沒有特定的任務或訓練機制,但他們展示了利用長時記憶流存儲超出語言模型上下文長度的記憶,形成社會網絡。這種外部記憶的使用后來被用于單人環境中的技能學習和多智能體環境中的協調。語言模型能夠在各種環境中控制代理,這對研究團隊在社交推理游戲中直接使用語言模型作為強大起點具有重要意義。

基礎模型與強化學習結合

一些研究將語言模型與強化學習相結合,展示了其在提升代理表現方面的潛力。例如,Cicero是一個用于《外交》游戲的AI,通過對話條件動作模型結合人類行為訓練對話自由模型,并通過強化學習選擇動作。Cicero使用意圖嵌入連接對話生成和策略推理組件,使其能夠以自然的方式與其他代理交流。然而,這種方法限制了RL模型直接控制生成的消息的能力,可能在消息質量方面有所不足。此外,該方法需要大量人類示范,這在許多環境中不實用。

在提供獎勵和作為策略基礎模型方面,基礎模型也表現出色。例如,Hu和Sadigh利用語言模型作為獎勵信號來訓練單獨的網絡,以遵循特定的協調策略。研究團隊同樣使用LLM在討論階段提供更密集的獎勵,但研究團隊直接訓練LLM本身,而不是單獨的策略。強化學習在人類反饋中的應用也顯著提升了LLM的聊天能力。Ouyang等人展示了通過人類反饋進行強化學習的有效性,通過PPO算法的修改微調LLM,提升其表現。Yuan等人進一步允許LLM成為自己的獎勵模型,生成自己的數據進行自我改進。盡管如此,研究團隊的獎勵模型設計仍然依賴于環境,以確保邏輯錯誤的糾正和訓練過程的高效性。

《我們之間》游戲的設計

在這項研究中,研究團隊以流行的社交推理游戲《我們之間》(Among Us)作為實驗平臺,通過設計一個多智能體環境來評估語言模型在復雜社交環境中的表現。他們的目標是創造一個能夠使智能體基于環境中的證據進行討論的環境,從而訓練語言模型在沒有人類示范的情況下進行富有成效的交流。

圖2:游戲循環示意圖。環境首先同時向所有代理發送觀察結果,并在每個時間步從一組有效操作中收集標記化的操作。

角色分配

《我們之間》的游戲角色分為冒充者和船員。游戲開始時,每個玩家被分配為冒充者或船員。船員不知道其他玩家的身份,而冒充者則從一開始就知道所有玩家的身份。在研究團隊的設置中,通常有一個玩家被分配為冒充者,而其他玩家則是船員。船員被分配了一組任務,這些任務分散在整個游戲環境中,要求船員在完成任務的過程中識別出冒充者。

游戲階段

游戲階段分為游戲階段和討論階段。在游戲階段,玩家在一個二維網格環境中移動,通過觀察環境并采取行動來完成任務或進行交流。所有代理可以在相鄰的房間之間移動,完成任務,或報告死亡的船員。冒充者可以在同一房間內殺死船員,但需要在冷卻時間步之間等待。

討論階段是游戲的核心部分。玩家在這個階段可以自由聊天,交流他們的觀察和推測,以識別冒充者。每個玩家輪流說一句話,討論結束后進入投票階段。所有玩家投票選擇要驅逐的嫌疑人,得票最多的玩家被驅逐。如果冒充者未被驅逐,游戲繼續進行,船員可以繼續完成任務,直到所有任務完成或冒充者被驅逐。

獎勵結構

《我們之間》本質上是一個團隊零和游戲,獎勵結構基于船員或冒充者的勝利情況。如果所有任務被完成或冒充者被驅逐,船員獲勝,獲得正向獎勵。相反,如果冒充者的數量大于或等于船員數量,則冒充者獲勝,船員獲得負向獎勵。

這種獎勵機制強調了團隊協作的重要性,要求船員在游戲過程中有效地交流和合作,而冒充者則需要巧妙地隱藏身份并誤導船員。通過這種設計,研究團隊能夠在實驗中評估智能體在復雜社交推理環境中的表現,探索如何通過多智能體強化學習提高語言模型的交流和推理能力。

增強船員交流能力

在《我們之間》的游戲中,有效的交流對于船員識別冒充者至關重要。為了超越基礎的強化學習(RL)模型,研究團隊重點研究了如何提高船員在游戲中的聽力和表達能力,使他們能夠在復雜社交環境中進行更有意義的討論。

冒充者預測的聽力訓練

首先,研究團隊提出了一種利用環境的真實答案提高船員推理能力的方法。在多智能體環境中,船員需要理解環境觀察和其他船員的信息,以便在討論階段做出準確的判斷。通過直接訓練船員利用環境提供的關于冒充者身份的真實答案,可以提高他們的推理能力。研究團隊使用了在討論消息之間的時間步作為訓練信號。這些時間步不需要人類示范數據,代理可以通過任意回滾緩沖區學習觀察和信息。

在每個時間步,當船員被要求提供對冒充者身份的信念時,研究團隊將其作為聽力訓練的損失項。這樣,船員可以根據游戲階段的觀察和討論消息,提高對冒充者身份的判斷力。這一過程不僅使討論更有意義,還能夠使船員在討論階段通過監督學習任務,理解消息的含義,從而準確投票驅逐冒充者。

強化討論學習的表達訓練

除了提高聽力能力,研究團隊還探討了如何通過強化學習提高船員在討論中的表達能力。研究團隊的關鍵思路是基于船員信念變化的獎勵機制來訓練模型。具體來說,研究團隊根據每個消息后其他船員對冒充者身份信念的變化,給予發言船員獎勵。這個獎勵機制模擬了每個消息在預測正確冒充者任務中的因果效果,最有效的消息應該能夠說服其他船員投票驅逐真正的冒充者。

為了綜合應用聽力和表達損失,研究團隊設計了一個綜合策略。該策略結合了RL的強化學習損失和聽力損失,使模型在優化行動的同時,提高識別冒充者的能力。此外,研究團隊還加入了對表達的獎勵機制,使代理能夠區分有用和無用的消息,從而在討論中發送更有效的消息。

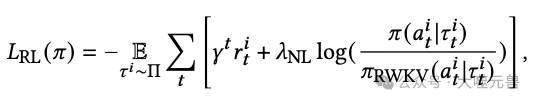

為了訓練語言模型在沒有專家演示的情況下采取更有效的行動,我們可以轉向強化學習。由于Among Us已經為獲勝提供了獎勵,我們可以直接對其進行優化,以生成一個模型??RL,最大限度地減少以下損失:

動態設置下的訓練

在訓練智能體時,僅依賴固定的對手可能會導致智能體策略的單一化和缺乏魯棒性。為了提升智能體在復雜多變環境中的表現,研究團隊采用了自我對弈算法。這種算法允許智能體在訓練過程中不斷與不同版本的自己進行對抗,從而學習到更為全面和靈活的策略。

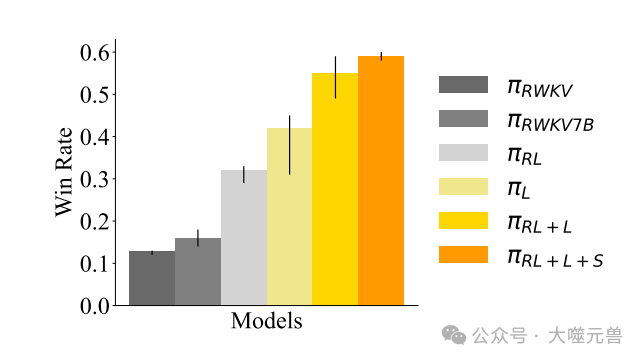

圖3:在“基礎”環境中,使用不同算法訓練的機組人員的勝率:2×2的房間網格,每個機組人員4個任務,5名玩家。誤差條表示使用不同種子進行三次獨立訓練的跑步的最大和最小預期獲勝率。

通過迭代自我對弈,可以逐步提高智能體的魯棒性。每一輪訓練后,智能體都會面臨更強大的對手,這促使其不斷優化自己的策略。最終,經過多輪迭代訓練,智能體能夠在各種情境下表現出較高的勝率,適應不同的游戲變化和對手策略。這種方法不僅提高了智能體的整體性能,也增強了其在面對不確定性和對手變化時的適應能力。

在訓練過程中,為了確保隊友的多樣性與合理性,研究團隊采用了N-Agent臨時團隊設置。具體來說,研究團隊在每一輪訓練中凍結一個船員的策略,使其不隨其他智能體的策略變化而改變。這種做法避免了所有智能體同時退化到某種簡單的、不可行的策略,例如在討論階段不發言或在起始房間不移動。通過保持一個固定的船員,其他智能體必須在更多樣化和合理的環境中學習和適應,從而提高整體團隊的表現。

此外,為了進一步提升智能體的適應能力,研究團隊在訓練中引入了環境參數的隨機化。這意味著在每一輪訓練中,環境配置可能會有所變化,例如環境布局、任務數量和玩家數量等。這種隨機化訓練使得智能體能夠在不同的環境中有效表現,避免了過度擬合某一特定環境配置。實驗結果表明,智能體在不同環境配置下的表現趨勢大致相同,證明了這種方法的有效性。

在訓練過程中,研究團隊觀察到最好的方法是引入世界建模損失。這一損失項確保了模型在訓練中保留其語言建模能力,并幫助其在自己的討論中匹配觀察中體驗的模式。具體來說,世界建模損失通過記錄和預測環境狀態的變化,幫助智能體在討論中生成更相關和合理的消息,從而提高整體表現。

結果分析

研究團隊通過多次實驗和詳細分析,評估了不同訓練方法在《我們之間》游戲中的表現。以下是對這些實驗結果的全面解讀。

合作訓練的性能評估

在合作訓練中,研究團隊首先評估了基礎模型的表現。使用1.5B RWKV模型進行的實驗表明,基礎模型在游戲中的勝率較低,而參數較多的7B模型表現略好,但勝率仍然不足20%。通過強化學習(RL)訓練,性能顯著提高,甚至超過了7B模型。然而,未添加聽力損失的RL模型在識別冒充者方面表現不佳,即使從聽力策略πL開始也迅速失去了辨別能力。

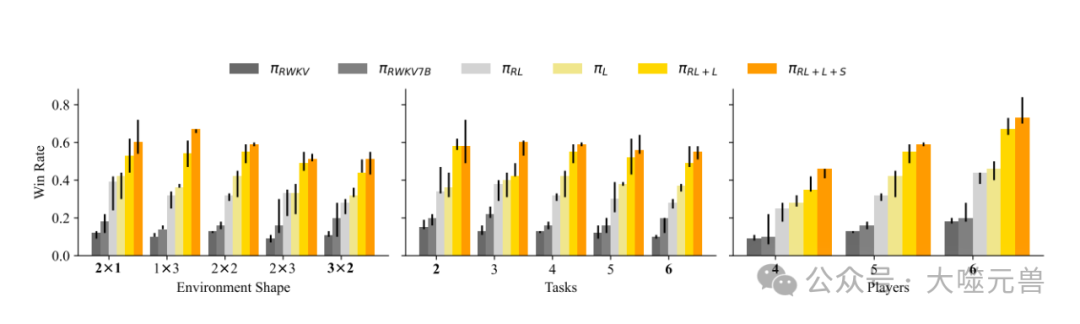

圖4:在不同環境配置下,通過修改環境形狀、任務和玩家數量,使用不同算法訓練的機組人員的勝率。

僅使用聽力訓練(損失項為LL),模型雖然不知道如何采取有效行動,但在預測冒充者身份方面表現出色。結合RL和聽力損失的策略使成功率顯著提高,而進一步加入密集的表達獎勵(RL+L+S)后,模型能在訓練中區分有用和無用的消息,使勝率翻倍。盡管沒有明確的表達獎勵,語言模型仍然能夠生成連貫的消息,在討論中分享懷疑,使得討論間接得到改進。

環境變化對模型表現的影響

研究團隊測試了不同環境配置下的模型表現,發現環境形狀對勝率影響較小,較小的環境由于冒充者難以在不被目擊的情況下殺人而勝率更高。任務數量增加使得通過完成任務獲勝更難,而船員數量增加則顯著提高了勝率。這表明,語言模型能夠在面對不同環境變化時,保持較好的適應性和魯棒性。

消息模式的評估

基礎RWKV模型的消息通常不集中,經常虛構更多上下文,而改進后的RL+L+S模型則直接指控冒充者,或者在消息中提及冒充者。一般來說,提及特定代理使得其他代理更可能投票反對他們。此外,船員分享類似環境觀察的信息幫助判斷冒充者身份,例如提到某個玩家離開發現尸體的房間。然而,有時船員也會撒謊,以最具說服力的陳述獲取足夠的票數驅逐冒充者。

冒充者的魯棒性

通過多輪自我對弈實驗,分析船員策略對抗訓練冒充者的表現。結果顯示,即使面對對抗性訓練的冒充者,船員策略依然有效。冒充者嘗試將責任轉移給其他玩家,通過反指控其他船員來迷惑對手,模擬船員的討論模式,有時成功欺騙船員。語言模型的上下文學習能力使冒充者能夠模仿之前發言的船員,進行對抗性討論。

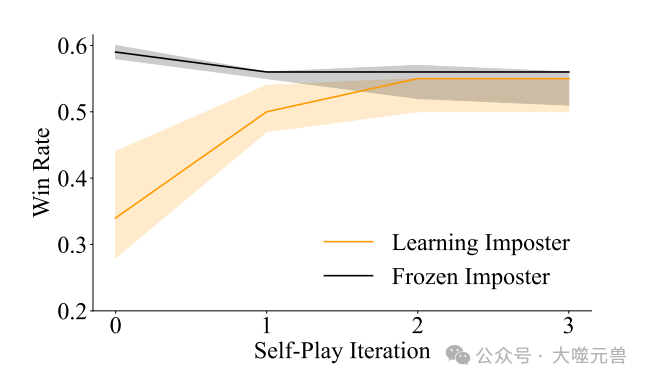

圖5:在基礎環境中評估的自玩迭代策略的可利用性曲線。橙色線表示對抗經過對抗訓練的冒名頂替者的預期獲勝率。黑線表示針對本次迭代的冒名頂替者進行專門優化的船員的預期獲勝率。請注意,迭代0指的是基礎模型,而迭代1指的是合作訓練部分的機組人員策略。陰影區域代表了使用不同種子進行三次獨立訓練的跑步的最大和最小獲勝率。

訓練中的失敗模式與解決方案

在實驗過程中,研究團隊遇到了一些失敗模式并提出了解決方案。首先,討論容易脫離自然語言,需要仔細調整強化學習中的軟KL約束以保持語言生成的正常。當約束權重過低時,RL訓練模型在幾輪后就會偏離自然語言,輸出隨機標記,導致性能停止提高。

其次,同時訓練所有船員會導致退化解決方案,例如僅輸出換行符或停留在起始房間不移動。通過凍結一個船員不學習,避免了這種策略退化問題。最后,RL訓練模型在討論中使用動作標記而非自然語言,為解決此問題,研究團隊引入了世界建模損失,確保模型保留語言建模能力,并幫助其在討論中匹配觀察中體驗的模式。

討論

在這項研究中,研究團隊展示了一種利用多智能體強化學習訓練語言模型的方法,使其在社交推理游戲中能夠進行有效的討論和交流。通過在《我們之間》游戲中的實驗,研究證明了即使在沒有大量任務特定人類數據的情況下,語言模型依然能夠自我改進,提升在多智能體環境中的表現。

本研究的重要貢獻在于展示了自我改進LLM在社交推理游戲中的巨大潛力。通過多智能體強化學習方法,模型不僅學會了在復雜的社交環境中進行有效的交流,還能夠從討論中提取有用信息,進一步提升游戲的勝率。研究團隊的實驗結果表明,智能體在面對對抗性訓練的冒充者時,依然能夠保持協作和協調,未被破壞討論過程。這一發現為未來的多智能體系統應用打開了新的大門,展示了在新任務中實現多智能體交流的可能性。

然而,盡管取得了顯著成果,本研究也存在一些局限性。一個主要的局限在于研究團隊的場景預測技術依賴于特定任務。在《我們之間》中,討論與預測冒充者身份之間有自然的聯系,但這種結構未必適用于所有的社交推理游戲和現實世界環境。未來研究的一個有趣方向是探索讓智能體自主識別場景中與特定任務相關的方面,而不是依賴于手動指定。

此外,研究團隊注意到在討論過程中,船員并不總是誠實,他們傾向于選擇最具說服力的陳述。這種行為在《我們之間》這樣的沙盒環境中或許是可接受的,但在其他應用場景中可能會帶來潛在風險。因此,優化討論中的誠實性成為未來研究的重要方向。確保智能體在交流過程中不僅有效,還能夠傳達真實和準確的信息,對于多智能體系統的實際應用至關重要。

總之,研究不僅提供了一種新的訓練方法,還為未來的多智能體強化學習和語言模型研究提供了重要的啟示和參考。盡管存在局限性,我們相信,通過進一步的研究和改進,這一領域將會取得更多突破性進展,推動智能體系統在各種復雜環境中的應用和發展。(END)

參考資料:https://arxiv.org/pdf/2502.06060

本文轉載自 ??獨角噬元獸??,作者: FlerkenS