基于深度強化學習的投資組合配置動態優化

投資組合優化是金融中的核心挑戰,涉及資金在多個資產間的動態配置,傳統方法存在假設限制和適應性不足的問題。本研究探討深度強化學習在投資組合優化中的應用。結果表明,深度強化學習(DRL)模型在投資組合優化中表現優異,年化平均回報率為19.56%,夏普比率為1.5550,顯示出卓越的風險調整回報。

論文地址:https://arxiv.org/pdf/2412.18563

摘要

人工智能正在改變金融投資決策,深度強化學習(DRL)在機器人顧問服務中展現出應用潛力。傳統投資組合優化方法在動態資產權重調整中面臨挑戰。

本文提出一種動態優化模型,利用深度強化學習實現更有效的資產配置。創新點:

- 提出專為Actor-Critic算法設計的夏普比率獎勵函數,通過隨機采樣和強化學習優化投資組合表現。

- 設計符合資產優化目標的深度神經網絡。

通過對CSI300指數成分股的實證評估,與傳統方法(均值-方差優化、風險平價策略)進行比較。回測結果顯示該動態優化模型在資產配置中有效,提升了風險降低、風險回報指標和整體表現。

簡介

人工智能(AI)在自然語言處理領域取得顯著進展,ChatGPT通過“人類反饋強化學習”(RLHF)提升了語言理解和生成能力。RLHF結合了深度學習和強化學習,顯著提高了AI系統的性能和對齊。深度強化學習(DRL)在自然語言處理、游戲AI和機器人控制等領域表現出色,但在金融領域的應用仍處于探索階段,尤其是在投資組合優化方面。

投資組合優化是金融中的核心挑戰,涉及資金在多個資產間的動態配置,傳統方法存在假設限制和適應性不足的問題。本研究探討深度強化學習在投資組合優化中的應用,開發新獎勵函數和深度神經網絡架構,旨在構建智能動態資產配置模型,推動金融領域的AI應用。

相關工作

馬科維茨建立了現代投資組合理論,推動了投資組合優化的定量分析方法。塞繆爾森認為馬科維茨模型適用于單期投資,但對多期資產配置不足,提出了財富規劃的效用函數。后續研究者(如凱利、默頓等)擴展了效用函數在資產配置優化中的應用,但存在選擇函數的主觀性和普適性未驗證的局限。黑利特曼模型引入主觀元素,假設市場存在隱含均衡收益,但對主觀預期的置信水平缺乏統一標準。查恩斯等人提出的數據包絡分析(DEA)為資產配置優化提供了非參數分析框架。柯克帕特里克將模擬退火算法應用于投資組合優化,阿爾諾等人則使用遺傳算法來最小化投資風險。這些模型普遍將投資組合權重調整視為靜態,未考慮時間維度及資產配置隨交易活動的演變。

經典資產配置模型(如Markowitz框架)通過將資產權重與預期收益相乘來計算投資組合收益,但在動態交易環境中,應使用實際收益而非預期收益。投資組合的終期收益應基于前期資產權重與當前期資產實際收益的乘積,許多金融優化模型(如條件風險價值模型、風險平價模型等)忽視資產權重的時間演變,導致模型在實際交易中的有效性受損。傳統金融計量分析方法及復雜算法(如DEA、模擬退火、遺傳算法)未能充分捕捉投資組合權重動態調整,難以實現最佳資產配置策略。深度強化學習(DRL)通過深度神經網絡提升了傳統強化學習(RL)的目標函數近似能力,早期RL主要使用策略梯度(PG)和Q學習算法。Moody等人首次應用PG算法于單資產管理,后續研究多集中于單風險資產管理,如Dempster等的外匯交易模型。Q學習算法在資產管理中的應用也由Neuneier、Gao等人進行,但仍限于單資產管理。一些學者在DRL優化資產配置時忽視了深度神經網絡設計和資產權重約束(∑????,??=1)。近期,Jiang等人提出了針對加密貨幣市場的DRL資產優化模型,但其交易成本推導存在數學不一致性,需進一步驗證模型在其他資本市場的有效性。

當前的深度強化學習(DRL)投資組合優化模型主要基于投資組合回報的獎勵函數,但在中國股市表現不佳,導致研究者采用固定投資權重的方式進行回測,違背了DRL模型的初衷。研究者們已提出多種新獎勵函數以提升DRL的資產優化性能,如Wu等人使用定制的夏普比率獎勵函數,Almahdi等人結合Calmar比率與遞歸強化學習(RRL)優化美國和新興市場資產。本研究提出了一種專為Actor-Critic算法設計的夏普比率獎勵函數,增強模型穩定性并優化動態投資組合過程。研究還開發了一種專門的深度神經網絡架構,結合VGG網絡設計原則,優化處理三維結構的時間序列數據,提升模型的泛化能力并降低過擬合風險。本研究在長倉限制下應用DRL模型優化CSI300成分股投資組合,并與多種計量經濟學優化模型進行系統比較,驗證DRL模型在資產配置優化中的有效性。該研究為學術界提供了新的投資組合優化方法,并為實際投資組合管理提供了有效解決方案,展示了在真實交易環境中動態資產權重變化的潛力。

DRL模型配置

深度強化學習(DRL)可用于交易,表示為軌跡??,符合馬爾可夫決策過程(MDP)框架。交易過程可視為MDP,賬戶啟動到結束構成一個episode。本研究將投資組合交易者定義為代理,建立狀態、動作和獎勵規范。實施DRL算法和深度神經網絡進行投資組合優化。

狀態空間

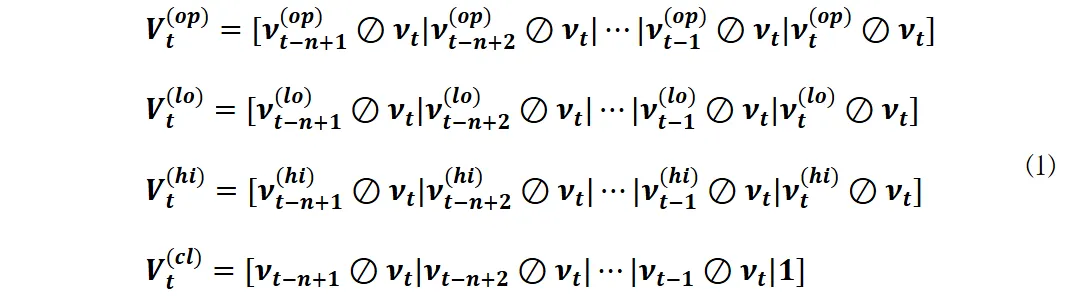

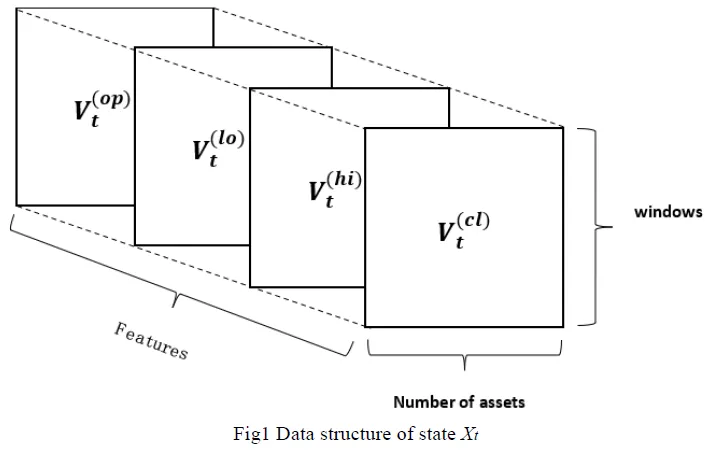

狀態空間在深度強化學習(DRL)中構成了代理與環境的交互基礎,基于有效市場假說,狀態空間僅使用每日資產價格數據構建。本研究采用Jiang等人提出的三維狀態空間配置,因其適合深度神經網絡處理,且視頻游戲應用推動了DRL的突破。傳統金融計量模型常用主成分分析(PCA)等降維技術,但會導致信息損失,而深度神經網絡能有效分析復雜特征關系。狀態定義為 ( S_t = X_t ),價格張量 ( X_t ) 包含四個數據特征:開盤價、最低價、最高價和收盤價。

行動空間

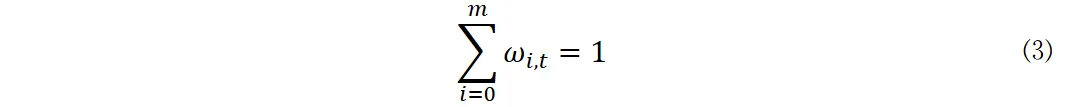

模型僅考慮多頭頭寸,不涉及賣空。投資組合權重表示模型的行動向量,包含風險資產和現金資產的權重。投資組合權重在時間t滿足約束條件,且所有權重非負。投資組合初始化時,所有資產權重總和為1。

其他元素的推導和獎勵功能的設置

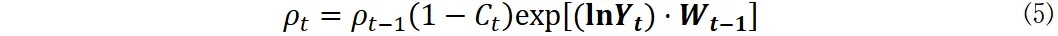

資產組合在時間t的收盤價格用向量??表示,相對價格向量??定義為當前價格與前期價格的比值。組合價格??在時間t的表達式為:

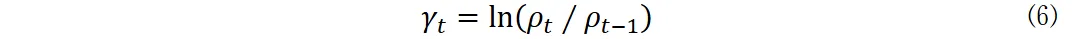

日常對數收益率????定義為:

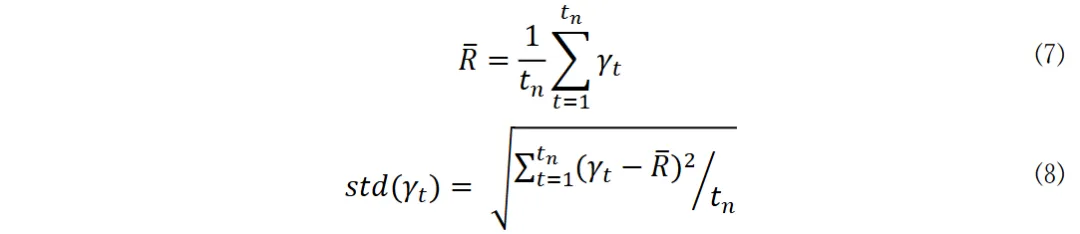

平均年化夏普比率作為獎勵函數,目標是最大化該函數。

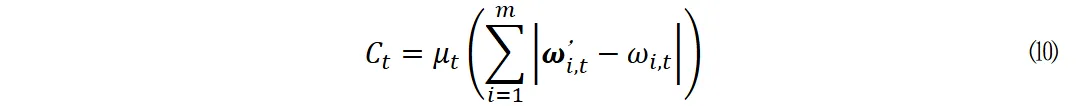

交易成本率????由公式確定,設定為0.00025。

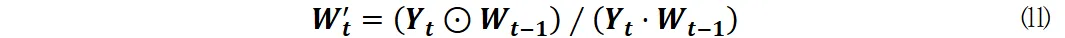

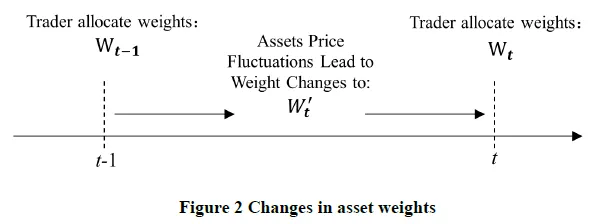

??′?? 表示在t-1期后和t期前的自主價格變動所導致的權重值。公式中使用Hadamard積和內積計算權重更新。

DRL算法的選擇和網絡結構

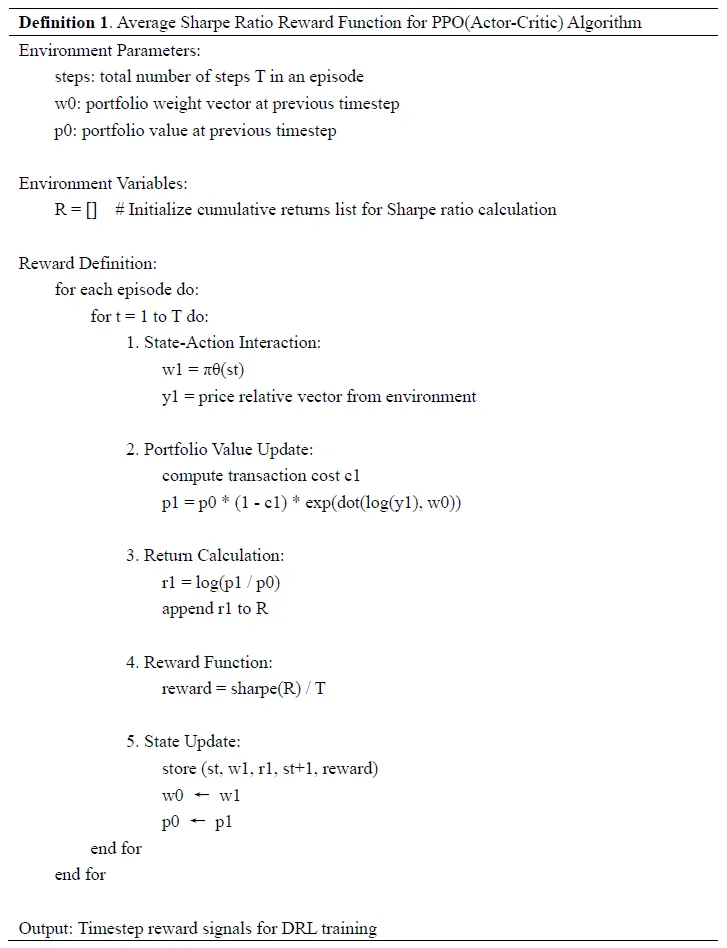

Actor-Critic體系結構中平均夏普比獎勵函數的設計

深度強化學習(DRL)算法分為在線和離線兩類,離線算法計算資源需求高且收斂慢,因此選擇了在線算法PPO。PPO結合了多種優化技術,如廣義優勢估計(GAE)和價值函數裁剪,擴展了信任域策略優化(TRPO)。PPO的Actor-Critic架構結合了基于回合的更新和逐步更新,采用嵌套循環結構進行算法實現。

開發了針對Actor-Critic框架的平均夏普比率獎勵函數,利用PPO進行投資組合優化。在每個交易步驟中,Actor網絡生成投資組合權重,計算價格變化、交易成本和對數收益,更新收益列表以計算夏普比率。通過歸一化年化夏普比率,確保不同回合長度和交易序列的獎勵可比性,提升模型訓練穩定性。實驗結果表明,平均夏普比率獎勵函數在PPO算法中有效提升了模型的樣本外表現。

神經網絡設計

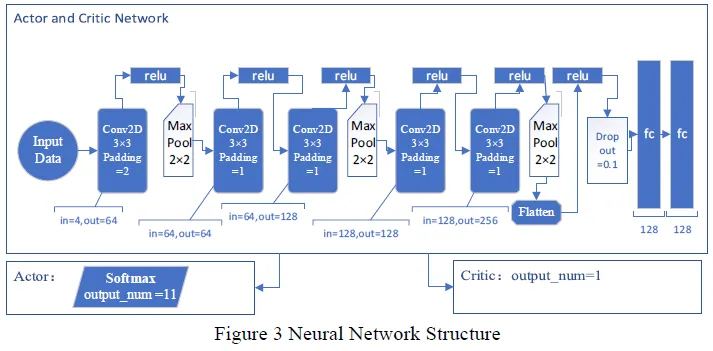

早期人工神經網絡在數據驅動理論模型開發中面臨功能逼近精度與梯度穩定性之間的平衡挑戰,限制了網絡深度的增加。深度神經網絡的進展推動了強化學習(RL)算法的發展,促進了深度強化學習(DRL)的形成。DRL中的深度神經網絡架構對性能至關重要,合理的網絡設計能顯著提升DRL效果。本研究采用VGG架構處理三維狀態空間(價格張量????),包含5個卷積層和Max Pool層進行特征提取與池化。最后通過Flatten操作將特征數據轉為一維向量,接著是兩個包含128個神經元的全連接層。Actor網絡使用softmax激活函數生成資產權重的動作向量,Critic網絡則輸出價值函數,無激活函數。Actor網絡的softmax輸出結構支持11個資產(10個風險資產 + 1個無風險資產)。

實證測試

數據選擇,預處理和假設

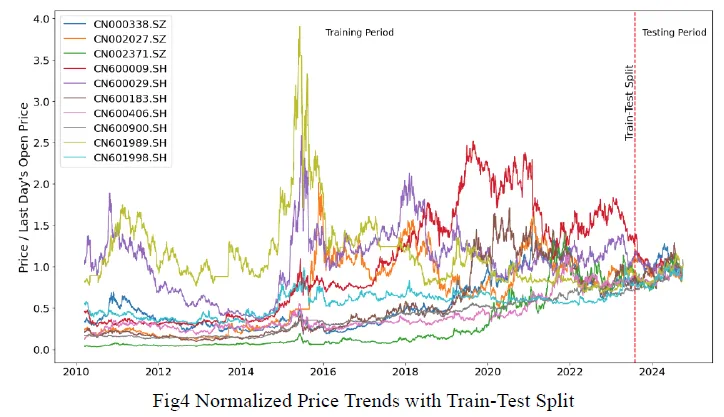

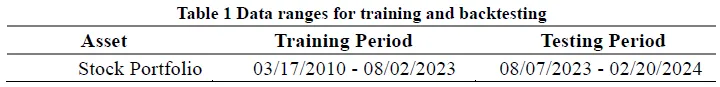

本研究構建了一個包含1個無風險資產和10個風險資產的投資組合,數據來源于Wind數據庫,采用隨機選股方法,旨在驗證深度強化學習(DRL)模型的適應性和決策能力。資產選擇基于單一時間標準:資產需在2012年12月31日前上市,以確保有足夠的歷史數據進行訓練。研究假設風險資產具有足夠流動性,交易執行及時,且交易活動對市場影響微乎其微。

性能指標,回測期和比較優化模型

性能指標包括年化平均收益、年化波動率、夏普比率、索提諾比率、最大回撤等,采用六個月的回測期進行模型優化效果評估。回測數據為完全獨立的樣本,確保模型未接觸未來價格信息。比較分析框架包括多種優化模型(如經典均值方差、條件風險價值等),重點關注風險最小化和夏普比率最大化。

歷史數據窗口選擇遵循EVaR和HRP模型的框架,分別使用4年和1年的數據。4年期包含1,008個交易日,基于252天的年度交易日歷。資產權重調整被視為靜態過程,采用滾動窗口方法進行權重預測。9月1日的權重預測基于截至8月31日的前4年或1年歷史數據。交易成本計算使用DRL模型中設定的參數。

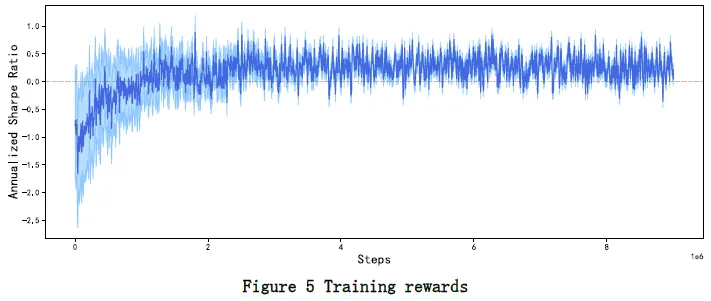

訓練結果和獎勵收斂

深度強化學習(DRL)結合神經網絡與強化學習框架,通過在線統計推斷優化決策策略,旨在最大化預期累積獎勵。訓練過程中,代理在9百萬步內獲得的獎勵與訓練步驟呈正相關,顯示出系統性改進。獎勵值趨于收斂,年化夏普比率穩定在-0.3到0.8之間,大部分獎勵值保持在零以上,表明代理在已知環境中具備穩定的回報生成能力,支持模型的穩健性。

回測結果

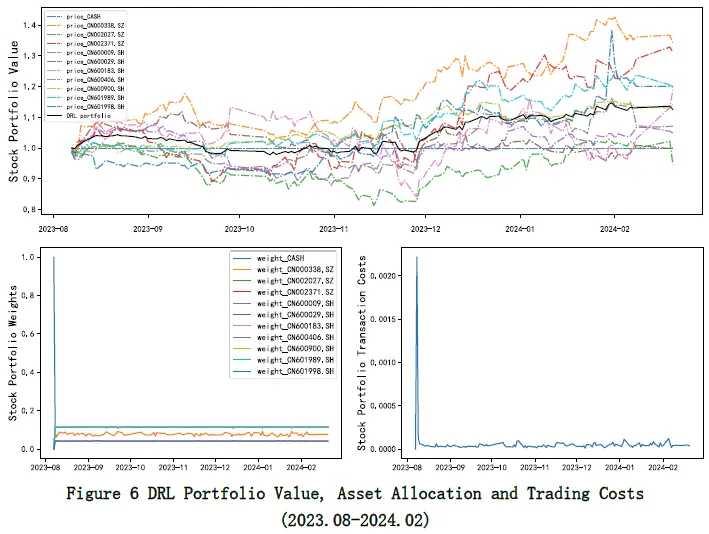

投資組合價值、資產配置和交易成本

圖6上半部分展示了資產相對價格,作為資產價格標準化的方法;下半部分顯示了資產權重和交易成本。DRL投資組合在回測期間持續增長,從1.0增至1.1256,總回報率為12.56%。中間經歷了9月的輕微回撤,但隨后恢復良好。

投資組合包含現金和10只股票,初始權重接近均勻分配,權重標準差穩定在0.031至0.033之間,現金比例保持在0.11至0.12之間。CN002027.SZ和CN002371.SZ的權重調整較為活躍,而CN600029.SH和CN600183.SH的權重較低。交易成本管理有效,初始資本配置時成本約0.22%,后續交易成本維持在0.002%至0.01%之間。PPO算法的投資組合展現出良好的風險收益特征,表明深度強化學習在投資組合管理中的應用潛力。

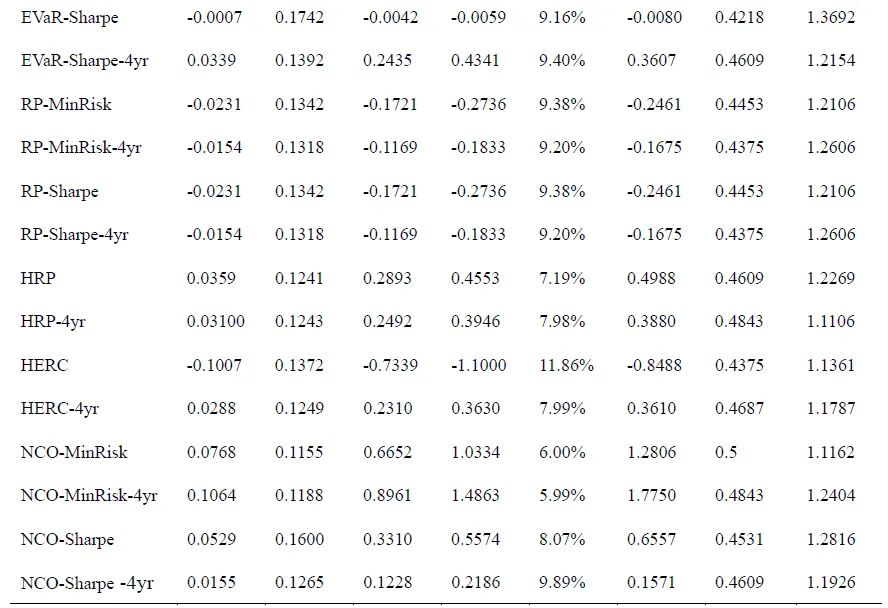

股票優化模型的性能比較

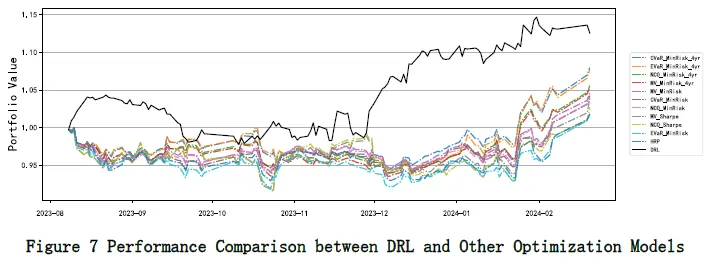

表2比較了多種股票優化模型的表現,采用“模型類型-優化目標-數據窗口”的命名方式。深度強化學習(DRL)模型在投資組合優化中表現優異,年化平均回報率為19.56%,夏普比率為1.5550,顯示出卓越的風險調整回報。DRL模型的Sortino比率為2.9567,最大回撤僅為5.85%,Calmar比率為3.3395,表明其在風險管理方面的優勢。傳統模型中,CVaR-MinRisk-4yr表現最佳,年化回報為15.08%,最大回撤為5.38%,夏普比率為1.2290。風險平價(RP)和層次化均等風險貢獻(HERC)模型表現不佳,RP模型產生負回報,HERC模型最大回撤為11.86%。DRL模型的投資勝率為47.28%,平均盈虧比為1.4204,顯示出其在市場機會捕捉和損失緩解方面的能力。DRL模型在回測期間的表現優于傳統優化模型,尤其在收益指標和資產配置動態捕捉方面具有明顯優勢。

DRL模型在CS1300成分股的投資組合優化中表現出色,主要得益于兩個因素:

- 回測期內CS1300成分股呈上升趨勢,有利于長期策略驗證。

- CSI300成分股的投資者構成穩定,機構投資者比例高,導致投資模式更系統化。

相較于中小市值股票,CSI300成分股的價格和交易數據更可靠,能更好地反映市場基本面和投資者情緒,為DRL模型提供了更強的學習環境。這些結構特征提升了DRL模型的學習和市場適應能力,從而增強了其在CSI300成分股投資組合優化中的表現。

總結

傳統金融優化模型在資產配置中使用靜態框架,無法有效捕捉資產權重的動態變化,且對市場波動適應性不足。深度強化學習(DRL)作為一種數據驅動的動態優化框架,能減少主觀偏差,適合實際交易過程中的資產配置優化。

本研究提出了一種針對Actor-Critic DRL算法的平均夏普比率獎勵函數,開發了處理三維金融數據的深度神經網絡架構,并采用隨機采樣方法進行模型訓練。提出的獎勵函數在長期投資策略中表現出優越的優化效果,訓練期間獎勵值主要集中在正域,顯示出強收斂性,并在樣本外回測中取得了更高的夏普比率。與主流金融優化模型相比,DRL框架在資產配置優化和風險管理方面具有顯著優勢。未來研究應關注金融數據的噪聲特性、DRL環境建模及重要交易信號提取,以及DRL模型的驗證框架和市場條件下的表現一致性。

本文轉載自 ??靈度智能??,作者: 靈度智能