白話DeepSeek R1的GRPO強化學習算法:原理、圖解、視頻

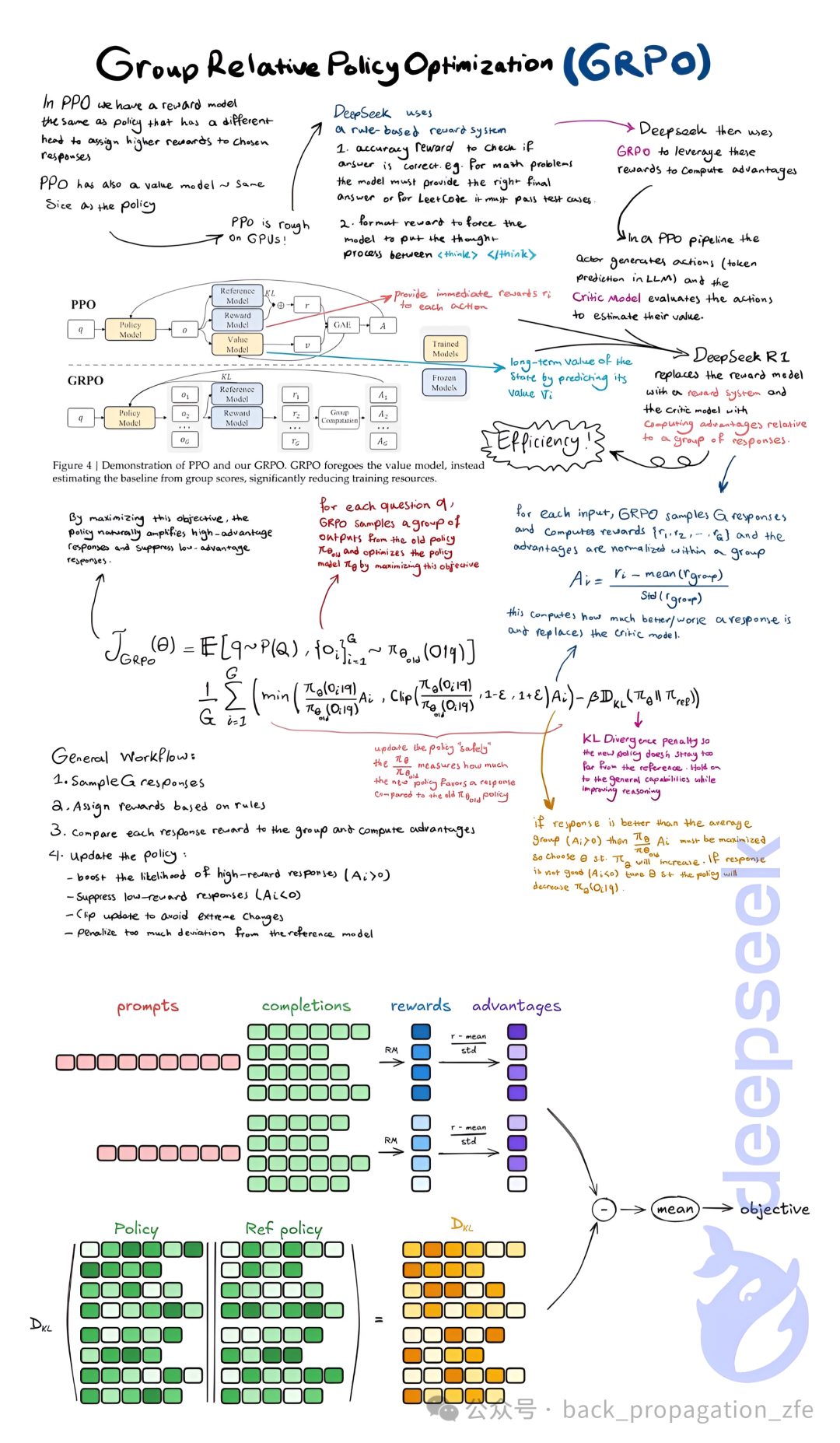

GRPO (Group Relative Policy Optimization) 算法核心思想:

想象一下,老師在教一個學生寫作文。傳統的強化學習方法(比如PPO)會給學生的每一句話打分,告訴他這句好,那句不好。但 GRPO 不這么做,它更像是一位“佛系”老師:

- 不看過程,看結果:GRPO 不會逐句指導學生,而是讓學生一口氣寫完幾篇不同的作文(一組作文)。

- 幾篇作文一起比較:然后,老師把這幾篇作文放在一起比較,根據一個預先定好的規則(基于規則的獎勵模型),評判哪篇作文整體上更好。

- 規則說話:這個規則可能很簡單,比如看作文是否通順、有沒有錯別字(對于數學題,就是看答案對不對;對于編程題,就是看代碼能不能跑通)。

- 鼓勵“好作文”, 抑制“差作文”:老師會告訴學生,你這次寫的這幾篇里,哪幾篇相對好一些,以后多照著這個路子寫。哪幾篇差一些,以后別這么寫了。至于具體怎么寫出來的,老師不太關心。

- “穩定” 提升:每次提升都比較穩妥,不會讓學生的寫作水平突然變得很奇怪。盡量保持原有的答題能力,上一篇文章說的KL散度能幫忙“穩定”。?

關鍵點:

- 基于規則的獎勵模型:GRPO 的“打分”標準是事先定好的規則,而不是像 PPO 那樣,需要訓練一個專門的“打分模型”。

- 獎勵結果,不獎勵過程:GRPO 看最終答案的好壞,不關心答案是怎么一步步推導出來的。這個可以避免Reward Hacking (感興趣的可以去看看 前OpenAI算法科學家寫的博客 https://lilianweng.github.io/posts/2024-11-28-reward-hacking/ )。

- 組內相對優勢:GRPO 關注的是一組答案之間的相對好壞,而不是每個答案的絕對分數。

- 效率高,節省資源: 不用像PPO一樣訓練價值模型。

總的來說,GRPO 就像一個“結果導向”的老師,它用一套簡單的規則來評價一組不同的結果,然后鼓勵學生朝著相對好的方向去努力。

下面這張小抄圖以非常容易理解的方式展示了GRPO算法。它是兩個作者圖的拼接,上半部分我找到了作者(credit to hesam@x),下半部來自這兒 https://huggingface.co/docs/trl/main/en/grpo_trainer , 沒寫作者, Anyway, credit to huggingface.)

本文轉載自??后向傳播??,作者: 張發恩

已于2025-3-4 11:21:50修改

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦