DeepSeek-R1-Distill-Qwen-1.5B 在某些基準測試中超越了 GPT-4o 原創(chuàng) 精華

01、概述

隨著人工智能領域的快速發(fā)展,推理能力已經(jīng)成為了衡量大規(guī)模語言模型(LLMs)性能的一個重要指標。為了推動推理能力的極限,我們迎來了DeepSeek-R1系列模型的誕生。這個系列包括了兩個重要版本:DeepSeek-R1-Zero和DeepSeek-R1,它們分別在強化學習(RL)和傳統(tǒng)的監(jiān)督微調(SFT)方法中找到了新的平衡,展示了前所未有的推理能力。

DeepSeek-R1-Zero突破了傳統(tǒng)的訓練方式,直接通過大規(guī)模的強化學習進行訓練,而沒有依賴預先的監(jiān)督微調。這一創(chuàng)新使得模型在推理任務中表現(xiàn)出色,但同時也暴露了某些挑戰(zhàn),比如語言混合、無休止重復等問題。為了進一步提升性能,DeepSeek-R1加入了冷啟動數(shù)據(jù)的處理,解決了這些問題,達到了與OpenAI-o1在數(shù)學、代碼和推理任務中的類似表現(xiàn)。

不僅如此,DeepSeek-R1系列模型還開源了大量的訓練成果,包括基于Llama和Qwen模型蒸餾而來的六個緊湊型模型,其中DeepSeek-R1-Distill-Qwen-32B在多個基準測試中超越了OpenAI-o1-mini,創(chuàng)造了新的最先進結果。

02、模型介紹

后訓練:通過強化學習優(yōu)化基礎模型

傳統(tǒng)的語言模型通常依賴**監(jiān)督微調(SFT)作為基礎訓練方法,然后通過后期的微調來增強模型的推理能力。然而,DeepSeek團隊采取了一種全新的方式,直接通過大規(guī)模的強化學習(RL)**對基礎模型進行訓練,省略了SFT的初步步驟。這一方式讓模型能夠通過自主探索復雜問題的推理鏈條(Chain-of-Thought,CoT),自發(fā)地發(fā)展出許多強大且有趣的推理行為。

DeepSeek-R1-Zero正是通過這種強化學習方法訓練出來的,并且它展示了諸如自我驗證、反思、以及生成長推理鏈條等能力,標志著在推動推理能力方面的一個重要里程碑。更值得注意的是,這也是首個通過純粹的RL驗證大規(guī)模語言模型推理能力的研究,無需任何監(jiān)督微調。這一突破為未來的相關研究奠定了基礎。

DeepSeek-R1的創(chuàng)新管線

在DeepSeek-R1的開發(fā)過程中,我們采用了一個雙階段強化學習流程,并結合兩階段的監(jiān)督微調(SFT),旨在發(fā)現(xiàn)更加優(yōu)化的推理模式,并且能夠與人類偏好相對齊。這個管線的設計不僅提升了模型的推理能力,還為AI行業(yè)提供了一種新的模型開發(fā)思路,有助于推動未來更高效的推理模型的出現(xiàn)。

03、蒸餾:小模型也能表現(xiàn)出色

大模型推理模式的蒸餾

我們還展示了如何將大模型中的推理模式蒸餾到小模型中,取得了比在小模型上直接通過RL訓練的推理模式更優(yōu)秀的表現(xiàn)。通過將DeepSeek-R1生成的推理數(shù)據(jù)用于對小型模型進行微調,我們顯著提升了這些模型在多個基準測試中的表現(xiàn),證明了即使是參數(shù)較少的模型,也能在推理任務中取得不遜色的大模型的成績。

這一研究的另一個亮點是,DeepSeek團隊公開了多款蒸餾模型,包括1.5B、7B、8B、14B、32B以及70B六個版本,這些模型基于Qwen2.5和Llama3系列進行了蒸餾處理。這些小型模型在多個推理任務中表現(xiàn)出色,對于研究人員和開發(fā)者來說,將是一個非常有價值的資源。

04、模型信息

DeepSeek團隊提供了詳細的模型下載鏈接,供研究人員和開發(fā)者下載使用。以下是DeepSeek-R1系列以及其蒸餾版本的模型參數(shù)和下載信息:

DeepSeek-R1系列模型

DeepSeek-R1-Zero | 671B | 37B | 128K | ?? HuggingFace |

DeepSeek-R1 | 671B | 37B | 128K | ?? HuggingFace |

DeepSeek-R1蒸餾模型

DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | ?? HuggingFace |

DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | ?? HuggingFace |

DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B | ?? HuggingFace |

DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B | ?? HuggingFace |

DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | ?? HuggingFace |

DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct | ?? HuggingFace |

05、模型評估結果

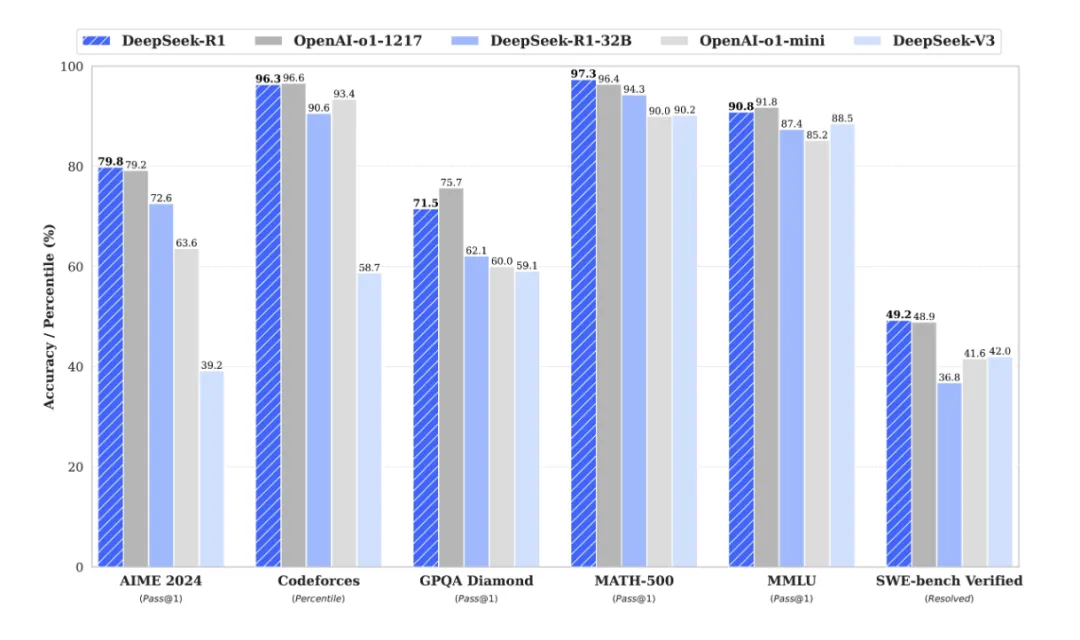

對于所有DeepSeek模型,我們將最大生成長度設置為32,768個tokens,確保能處理更長的輸入和生成更復雜的答案。在需要進行采樣的基準測試中,我們使用了溫度0.6和top-p值0.95,并生成了64個響應以估算pass@1的指標。以下是模型在多個基準測試中的評估結果:

DeepSeek-R1:在數(shù)學、代碼和推理任務中的表現(xiàn)可與OpenAI-o1相媲美,證明了該模型的強大推理能力。

DeepSeek-R1-Distill:系列小型模型,在多個測試中超過了OpenAI-o1-mini,表現(xiàn)出色。

06、結語

DeepSeek-R1系列模型的發(fā)布,標志著推理能力在大規(guī)模語言模型中的新突破。從DeepSeek-R1-Zero到DeepSeek-R1,我們展示了如何通過強化學習(RL)直接驅動推理能力的提升,同時通過蒸餾技術,使得更小的模型同樣能夠達到高效的推理表現(xiàn)。這不僅是對AI研究的一次重大貢獻,也為未來的模型開發(fā)提供了新的思路。

隨著更多小型化模型的開源,研究人員和開發(fā)者能夠更好地利用這些技術,打造出適應不同場景的推理系統(tǒng)。未來,隨著推理技術的不斷進步,DeepSeek-R1系列無疑將在各個領域引領人工智能的創(chuàng)新浪潮。

參考:

本文轉載自公眾號Halo咯咯 作者:基咯咯

原文鏈接:??https://mp.weixin.qq.com/s/i3JL_r4rLpPExFboqgFvPA??