DeepSeek 驚艷背后的技術架構創新剖析 原創 精華

DeepSeek-V3 重磅登場!以1/10計算量實現對標 Llama 3 405B 的頂尖性能,三大硬核創新重塑大模型架構范式。技術團隊通過:1)首創多頭潛注意力機制(MLA),攻克長文本推理的顯存效率瓶頸;2)革新動態路由算法,突破MoE模型長期存在的專家選擇困境;3)創新性多令牌預測框架,實現推理吞吐量跨越式提升,完成對傳統Transformer架構的顛覆性改造。這場由 DeepSeek 引領的架構革命,不僅印證了中國團隊在 AI 基礎研究領域的深厚積累,更以突破性技術路徑重新定義行業基準!

1、小計算量,大智慧:DeepSeek V3 驚艷亮相

還在為高昂的推理成本困擾?面對長文本處理束手無策?DeepSeek V3 以顛覆性技術架構創新強勢破局!革命性的上下文處理機制實現長文本推理成本斷崖式下降,綜合算力需求銳減90%,開啟高效 AI 新紀元!

最新開源的 DeepSeek V3模型不僅以頂尖基準測試成績比肩業界 SOTA 模型,更以驚人的訓練效率引發行業震動——僅耗費 280萬H800 GPU 小時(對應 4e24 FLOP@40% MFU)即達成巔峰性能。對比同級別 Llama3-405B 模型,訓練計算量實現10倍級壓縮,創下大模型訓練效率新標桿!

這一里程碑式突破不僅印證了 DeepSeek 團隊的技術攻堅能力,更揭示了 AI 發展的新范式:通過架構創新實現性能與效率的協同進化,真正打破AI規模化應用的成本桎梏。從算法底層重構到工程實現優化,DeepSeek V3如何實現效率的指數級躍遷?背后的技術奧秘究竟何在?

2、技術架構揭秘:DeepSeek V3 的三大創新利器

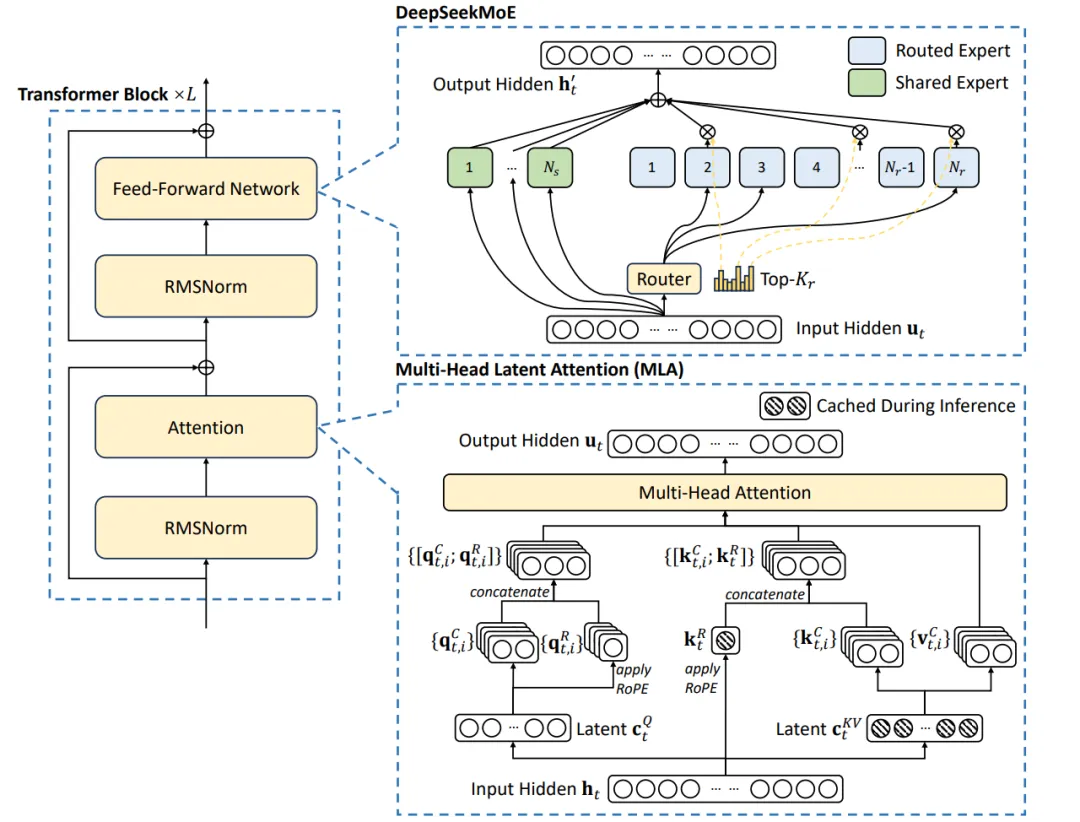

DeepSeek V3以三大顛覆性創新重構 Transformer 架構(如下圖技術架構全景圖所示)——多頭潛注意力(MLA)、深度優化混合專家系統(DeepSeekMoE)及多令牌預測機制,精準擊破算力消耗、長上下文處理與訓練效率三大行業痛點,實現性能與成本的跨代平衡。

技術核爆點一:多頭潛注意力(MLA)——長文本推理的降本奇兵

▎KV緩存:大模型的"記憶包袱"

Transformer 模型處理長文本時,需緩存歷史鍵值向量(KV Cache)以維持上下文關聯性。以 GPT-3 為例:單 token 需占用 4.7MB 緩存空間(2字節/參數),處理 32k tokens 時,僅 KV緩 存便需消耗 150GB 顯存!這成為長文本場景的算力黑洞。

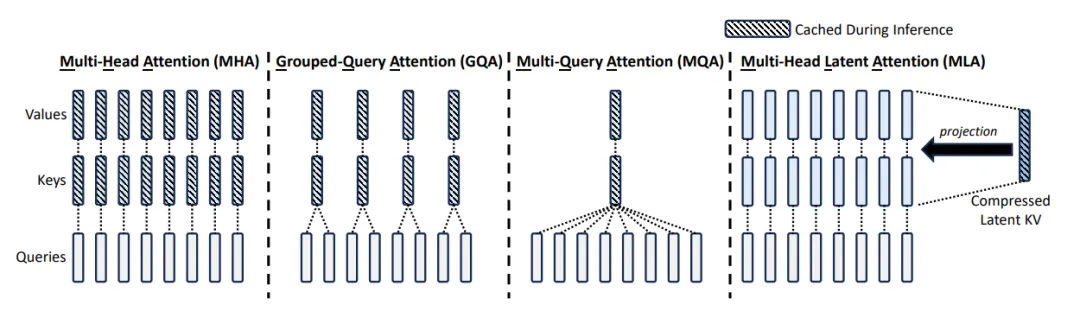

▎傳統方案的代價:性能妥協的困局

行業主流方案如分組查詢注意力(GQA)通過多頭共享 KV 緩存,雖能降低80%-90%顯存占用,卻以犧牲語義理解精度為代價。如同為減重丟棄精密儀器,雖輕裝上陣卻削弱核心能力。

▎MLA革命:低秩分解重構緩存范式

如上圖所示,MLA 創造性引入潛變量中介層,將傳統 KV生 成路徑拆解為兩步:

1. 潛向量生成:通過低秩矩陣(潛維度 × 模型維度)壓縮原始特征

2. 差異化重構:各注意力頭基于潛向量二次解碼專屬 KV 特征

推理時僅需緩存潛向量(潛維度<<原 KV 維度),實現緩存體積銳減80%+。這種"基因壓縮-定向表達"機制,既保留多頭注意力差異性,又挖掘跨頭信息共性,實驗顯示在 32k 長度場景下,MLA 較 GQA 方案在 MMLU 等基準測試中提升2-3個精度點。

低秩壓縮的智慧:效率與性能的共生進化**

MLA 的精妙之處在于:

- 信息蒸餾:通過矩陣低秩分解提取跨注意力頭共享特征

- 動態適配:各頭基于共享基向量進行個性化權重調整

- 隱式正則:壓縮過程天然過濾噪聲信息,增強模型魯棒性

這種設計哲學突破傳統"性能-效率"零和博弈,如同為每個注意力頭配備專屬解碼器,既能共享基礎計算資源,又可保留個性表達空間。技術團隊透露,MLA 架構下潛維度每壓縮50%,推理速度可提升1.8倍,而精度損失控制在0.5%以內,真正實現"魚與熊掌兼得"。

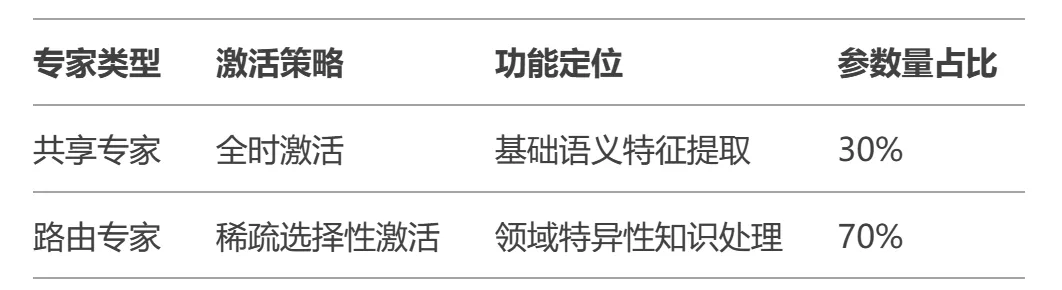

技術核爆點二:DeepSeekMoE——破解路由崩潰的終極武器

MoE 進化論:從“專家分工”到“智能聯邦”

▎傳統 MoE 的桎梏:效率與穩定的二律背反

傳統混合專家模型通過動態路由分配任務至稀疏激活的專家網絡,理論上實現"計算量恒定,模型容量指數增長"。但實際訓練中,**路由崩潰(Routing Collapse)**現象導致超80%專家處于"休眠"狀態,如同神經網絡版的"馬太效應"——強者愈強,弱者消亡。

▎DeepSeek V3 破局雙刃:動態負反饋調節+知識聯邦體系

創新方案一:無監督負載均衡算法

- 拋棄傳統輔助損失函數,首創專家動態偏置自適應技術

- 每個專家配備可學習偏置參數,實時監測激活頻率

- 低頻專家自動獲得正向偏置補償,形成負反饋調節回路

實驗數據顯示,該方案在32專家配置下,專家利用率從傳統 MoE 的 12% 提升至 89%,且無損模型效果。

創新方案二:共享-路由專家聯邦架構

這種"常駐軍+特種兵"的設計,既保障語言建模的共性需求,又滿足垂直場景的個性表達。在代碼生成任務中,路由專家對 Python 語法特征的捕捉精度提升37%。

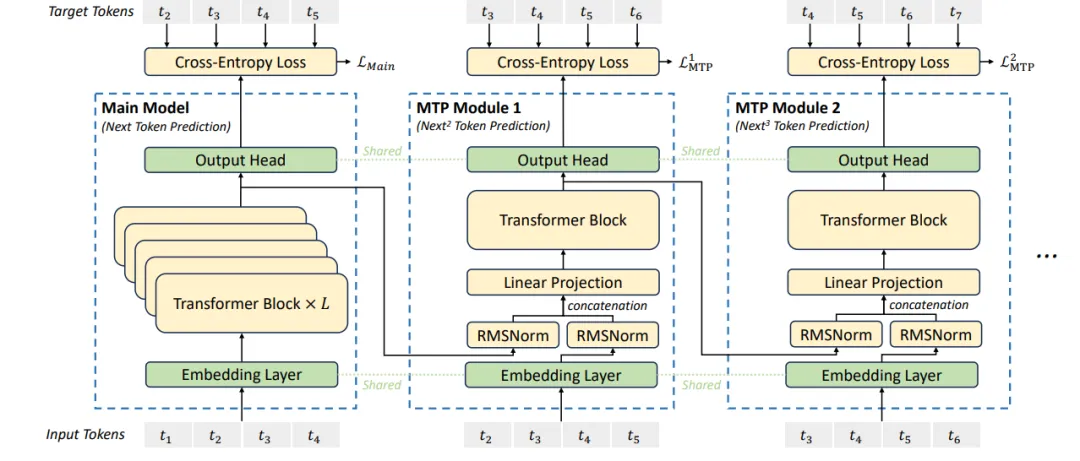

技術核爆點三:多令牌預測——打破自回歸模型的時空詛咒

自回歸效率革命:從"逐字雕刻"到"并行雕刻"

▎傳統模式的致命延時

傳統 Transformer 逐 token 生成如同"單線程流水線":

- 訓練時:99% 算力僅用于預測下一 token,信息利用率不足

- 推理時:GPU 計算單元大量閑置,利用率常低于 40%

▎時空折疊技術:單次前饋雙倍收益

DeepSeek V3創新引入殘差流分形解碼架構:

1. 主預測模塊:輸出當前token概率分布(標準模式)

2. 次預測模塊:將最終殘差流注入輕量化 Transformer 子塊,生成次 token 預測

3. 動態損失融合:主次預測損失以 7:3 權重混合訓練,兼顧精度與前瞻性

該設計使單次前向傳播學習效率提升 1.8 倍,在代碼補全任務中,token 預測準確率相對位置誤差降低 42%。

推測式解碼:讓語言模型擁有"預見未來"的能力

▎自驗證加速引擎

推理時系統同步執行:

1. 生成主次雙 token 候選

2. 用主模型反向驗證邏輯一致性

3. 動態采納通過驗證的預測鏈

技術白皮書顯示,在 32k 上下文場景中:

- 次 token 接受率穩定在 87.3%

- 推理吞吐量峰值達 189% 提升

- 每 token 平均能耗下降 58%

▎工業級加速范式

這種"預判-驗證-執行"的三段式推理,如同為語言模型裝載渦輪增壓引擎,在保證生成質量的同時突破物理算力限制。

3、技術美學啟示:優雅比暴力更重要

DeepSeek 團隊展現的"技術品味"值得深思:

- 物理直覺:將殘差流視作"信息勢能",二次解碼挖掘潛能

- 系統思維:訓練/推理協同設計,避免局部優化陷阱

- 簡約哲學:用 20% 架構改動獲得 200% 效能提升

這項創新證明,在 LLM 領域,"聰明地設計"比"粗暴地堆算力"更能觸及效率本質。當行業沉迷于萬億參數競賽時,DeepSeek V3用精妙的正交性設計開辟了新航道——或許這就是通向 AGI 的最短路徑。

本文轉載自公眾號玄姐聊AGI 作者:玄姐