DeepSeek核心架構(gòu)-DeepSeekMoE:細(xì)粒度專家劃分與共享專家隔離技術(shù)的深度解析!

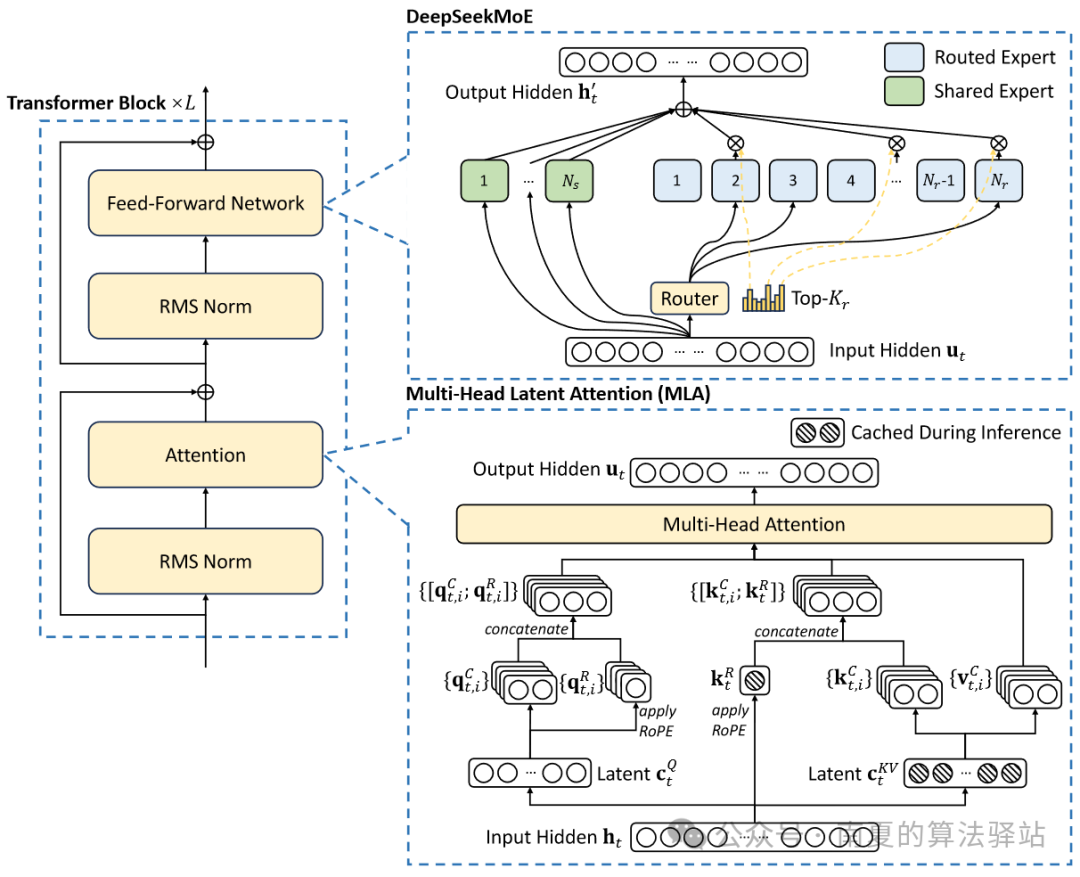

圖1 DeepSeek-V2&DeepSeek-V3基本架構(gòu)。

DeepSeekMoE架構(gòu)的提出源于DeepSeek發(fā)表的論文《DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models》,在DeepSeek-V2、V3及R1中得到了更好的應(yīng)用。

1.DeepSeekMoE關(guān)鍵技術(shù)

(1)DeepSeekMoE架構(gòu)有兩個(gè)關(guān)鍵思想:細(xì)粒度專家劃分和共享專家隔離。細(xì)粒度專家細(xì)分以實(shí)現(xiàn)更高的專家專業(yè)化程度和更準(zhǔn)確的知識(shí)獲取,共享專家隔離以減少專家之間的知識(shí)冗余。

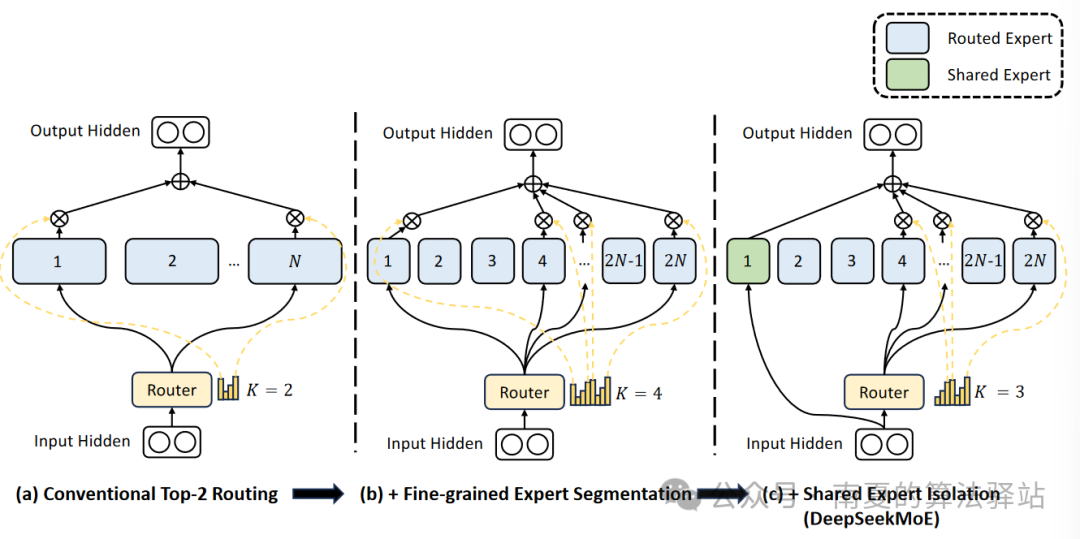

圖2 DeepSeekMoE架構(gòu)示意圖。

(2)細(xì)粒度專家劃分:專家數(shù)量有限的情況下,分配給特定專家的Token更可能包含各種類型的知識(shí)。因此,指定的專家將學(xué)習(xí)不同類型的知識(shí),但很難同時(shí)利用這些知識(shí)。如果將每個(gè)Token送達(dá)到更多的專家中,各種類型的知識(shí)將在不同的專家中被解析和學(xué)習(xí)。在這種情況下,每個(gè)專家仍可以保持高度的專業(yè)化,且有助于實(shí)現(xiàn)跨專家的知識(shí)分布。

(3)共享專家隔離:傳統(tǒng)路由策略中,分配給不同專家的Token可能蘊(yùn)含一些通用知識(shí)或信息。不同的專家可能會(huì)在各自的參數(shù)中獲得這些通用知識(shí),從而導(dǎo)致專家參數(shù)的冗余。若有專門的共享專家來捕捉和整合上下文中的通用知識(shí),將緩解其他路由專家之間的參數(shù)冗余。這種冗余參數(shù)的減少有助于由更專業(yè)的專家構(gòu)建更加參數(shù)高效的模型。

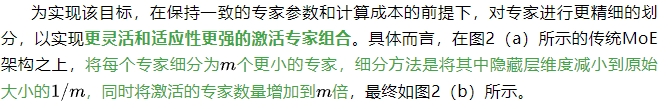

為實(shí)現(xiàn)該目標(biāo),在細(xì)粒度專家劃分的基礎(chǔ)上進(jìn)一步隔離一部分專家作為共享專家。無論路由模塊如何,每個(gè)Token都將會(huì)被送入這部分共享專家。為保證恒定的計(jì)算成本,激活的路由專家將減少相應(yīng)的數(shù)量,如圖2(c)所示。

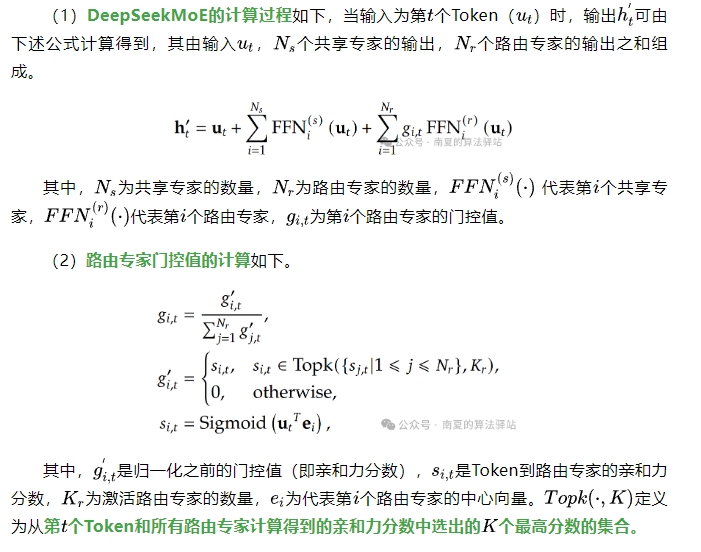

2.DeepSeekMoE計(jì)算原理

上述計(jì)算原理來源于DeepSeek-V3,相比于DeepSeek-V2略有不同。V3采用Sigmoid函數(shù)計(jì)算親和力分?jǐn)?shù),而V2中使用的是Softmax函數(shù)。同時(shí),V3中增加了為所有選定的親和力分?jǐn)?shù)應(yīng)用歸一化以生成最終門控值的方法。

(2)需要注意的是,除每次選定的個(gè)激活路由專家外,其他路由專家的門控值為0,即不激活。

本文轉(zhuǎn)載自 ??南夏的算法驛站??,作者: 趙南夏