知識圖譜增強營養健康大模型:邁向改進的管理、可重復性和驗證 - RPI等

摘要

生成式大型語言模型(LLMs)通過實現快速、類人的文本生成改變了人工智能領域,但它們面臨挑戰,包括管理不準確的信息生成。諸如提示工程、檢索增強生成(RAG)以及整合特定領域知識圖譜(KGs)等策略旨在解決這些問題。然而,尤其是在通過Web API使用封閉訪問LLM的開發者中,實現實驗的管理、可重復性和驗證所需水平仍存在挑戰,這增加了與外部工具集成的復雜性。為解決這一問題,我們正在探索一種軟件架構,通過優先考慮靈活性和可追溯性來增強LLM工作流程,同時促進更準確和可解釋的輸出。我們描述了我們采用的方法,并提供了一個營養案例研究,展示了其將大型語言模型(LLMs)與RAG和知識圖譜(KGs)整合以獲得更強大AI解決方案的能力。

LLM experimentation through knowledge graphs: Towards improved management, repeatability, and verification - ScienceDirect

??https://www.sciencedirect.com/science/article/pii/S1570826824000398??

核心速覽

研究背景

- 研究問題:這篇文章要解決的問題是如何通過知識圖譜(Knowledge Graphs, KGs)和檢索增強生成(Retrieval-Augmented Generation, RAG)來改進大型語言模型(LLMs)的管理、可重復性和驗證。LLMs在生成類似人類的文本方面取得了顯著進展,但面臨著生成不準確信息的挑戰。

- 研究難點:該問題的研究難點包括:實現LLMs實驗的管理、可重復性和驗證的期望水平,特別是對于通過Web API使用封閉訪問LLMs的開發者,這簡化了與外部工具的集成。

- 相關工作:該問題的研究相關工作包括:prompt工程、RAG框架和基于權威領域本體的知識圖譜(KGs)的使用。現有的RAG框架旨在緩解LLMs響應中的幻覺和過時知識或缺失信息的問題。KGs作為結構化的外部信息源,已被用于增強LLMs的可靠性和可解釋性。

研究方法

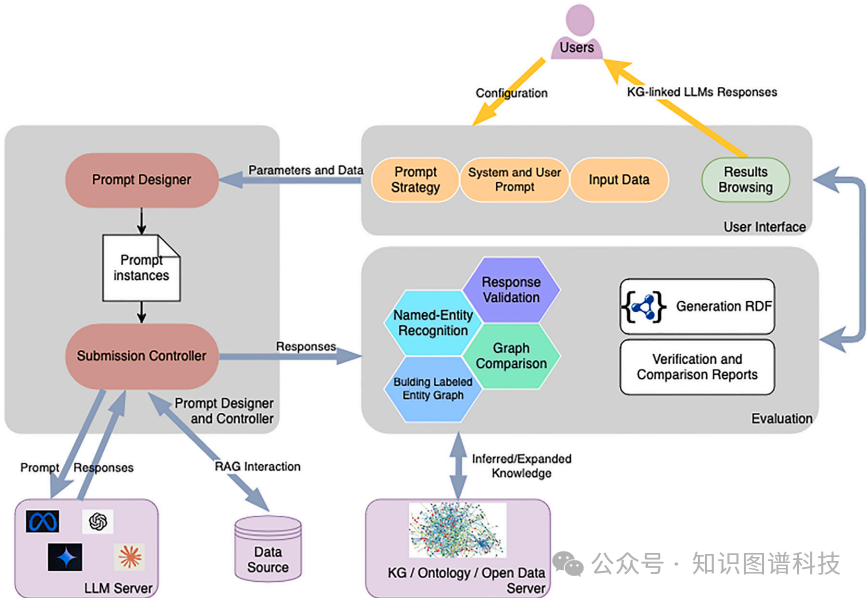

這篇論文提出了一種軟件架構,用于增強LLMs的工作流程,優先考慮靈活性、可追溯性和可重復性,同時促進更準確和可解釋的輸出。具體來說,

- 靈活性和可追溯性:ChatBS-NexGen架構允許用戶交互式地定制和組合高級提示策略,而無需編程知識。通過直觀的界面,用戶可以輕松配置提示策略(如少樣本學習、思維鏈、驗證鏈)、動態槽位的信息告知系統和用戶提示,以及輸入數據集。此外,還包括設置模型溫度、提示重新提交次數和選擇不同的LLMs等選項。所有這些特性共同促進了LLMs實驗的靈活性。

- RAG和KG增強的LLMs實驗:評估模塊旨在通過將LLMs的主要實體與領域知識圖譜或開放網絡連接起來,進行驗證、基準測試和專家分析。實驗使用的KG平臺是Whyis,一個下一代的、具有動態代理交互的有知覺黑板架構。評估模塊包括子模塊用于實體識別和構建標記實體圖,利用Whyis的高級功能,使跨多個LLMs和單個LLMs的多次重新提交的響應之間的比較成為可能。

- 營養案例研究:使用一個包含100名患者數據的食品和營養領域的數據集進行實驗。目標是評估LLMs生成的飲食建議的適用性,考慮到個人因素如性別、年齡、性別、體重、健康指標、慢性疾病診斷以及飲食限制和偏好。

實驗設計

- 數據收集:實驗使用了包含100名患者數據的食品和營養領域的數據集。每個患者的個人信息包括性別、年齡、性別、體重、健康指標、慢性疾病診斷、飲食限制和偏好等。

- 實驗設計:在典型的測試運行中,用戶(營養研究組的成員)使用ChatBS-NexGen用戶界面輸入以下信息和選擇數據源:提示策略、LLMs、提示重新提交次數、KG鏈接等。然后,ChatBS-NexGen執行提示設計子模塊,實例化100個提示并提交給選定的LLMs。提交控制器子模塊提交(并重新提交10次)每個實例化的提示,接收其響應并將其傳遞給評估步驟。

- 樣本選擇:選擇了100名患者的數據進行實驗,每個患者的提示實例化和重新提交10次。

- 參數配置:用戶可以選擇不同的提示策略(如少樣本學習、思維鏈、驗證鏈)、LLMs(如GPT-4o mini和Llama 3.1-8B)、提示重新提交次數等。

結果與分析

- 驗證結果:在100名患者的實驗中,LLMs推薦了483種不同的食物類型,其中178種(36.8%)可以通過FoodKG進行驗證。對于30名糖尿病患者,LLMs推薦了260種不同的食物類型,其中123種(47.3%)可以通過FoodKG進行驗證。

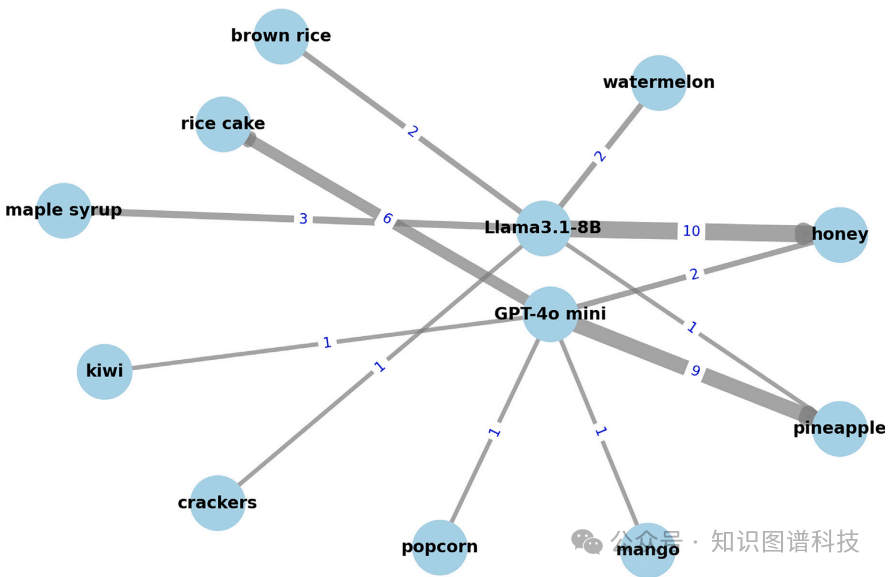

- 高GI食物的推薦:在推薦的10種高GI(≥50)食物中,LLMs對糖尿病患者提出了不同的建議。例如,Llama 3.1向10名糖尿病患者推薦了“蜂蜜”,占糖尿病患者的33%,而GPT-4o mini推薦了“菠蘿”,占30%。

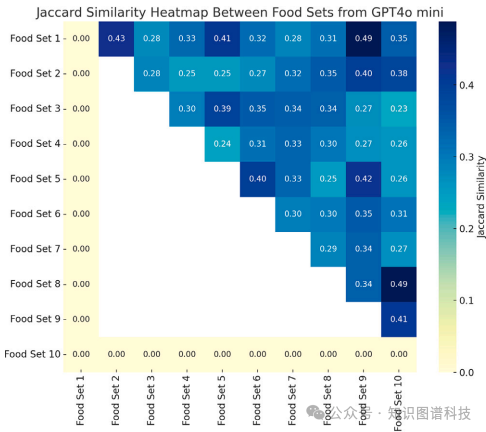

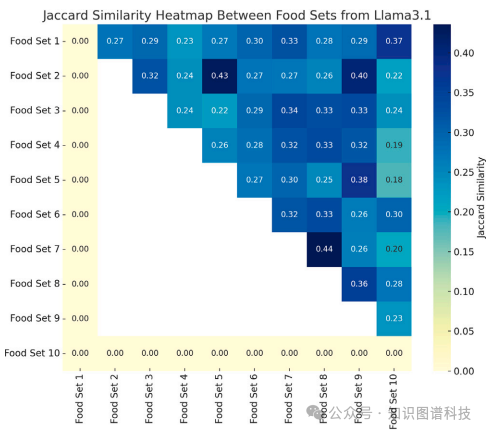

- 響應一致性:通過計算不同LLMs和同一LLMs的多次響應之間的Jaccard相似系數,發現不同LLMs之間以及同一LLMs的不同響應之間的一致性較低。例如,GPT-4o mini對同一患者的10個響應之間的Jaccard相似系數為0.05,表明只有5%的食物在所有響應中被共享。

總體結論

這篇論文提出了一種新的架構ChatBS-NexGen,用于改進LLMs實驗的管理、可重復性和驗證。通過結合RAG和KGs,該架構能夠提供更準確和可解釋的輸出,并通過詳細的日志記錄確保實驗的可追溯性。未來的研究方向包括支持多模態輸入輸出、自動提示策略、與XAI框架的集成、邏輯一致性驗證器和對抗場景模擬器等。

論文評價

優點與創新

- 靈活的架構設計:ChatBS-NexGen架構通過直觀的界面和模塊化的設計,支持多種提示策略、不同的LLM架構、數據輸入和實驗設置,確保了實驗的靈活性。

- 可追溯性:整個實驗過程被詳細記錄,包括時間戳、提示數據、模型版本、響應元數據等,確保了實驗的可追溯性。

- 重復性控制:通過日志記錄和多次執行,可以重現相同的實驗條件,評估LLMs響應的變化,增強了實驗的重復性。

- RAG和KG集成:該架構支持檢索增強生成(RAG)和知識圖譜(KG)的集成,顯著提高了響應的驗證性和解釋能力。

- 營養案例研究:通過真實的醫療項目案例,展示了該架構在實際應用中的潛力,特別是在處理LLMs生成的飲食建議時,能夠識別不適當的推薦和高變異性。

- 多模型支持:支持多種LLMs的交互和評估,增強了平臺的通用性和實用性。

不足與反思

- 知識圖譜的局限性:在應用領域中,知識圖譜的數據不完整和查詢構建的復雜性是主要限制因素。許多知識圖譜缺乏關鍵屬性或完全缺失,限制了其在詳細和可靠分析中的應用。

- 標準化本體的重要性:采用標準化和權威本體對于增強不同系統之間的互操作性至關重要。需要開發方法將詳細的溯源元數據嵌入知識圖譜中,并展示其在提高可靠性和實用性方面的應用。

- 查詢機制的改進:需要改進知識圖譜查詢機制,簡化領域特定數據的檢索過程,以便用戶更容易使用。

- 未來研究方向:包括支持多模態輸入輸出、引入自動提示策略、通過與XAI框架集成提供高級解釋能力、整合邏輯一致性驗證器和對抗場景模擬器、動態集成多樣化指標進行上下文評估、關注安全驗證和偏見緩解等方面的工作。

關鍵問題及回答

問題1:ChatBS-NexGen架構如何實現LLMs實驗的靈活性和可追溯性?

ChatBS-NexGen架構通過以下方式實現LLMs實驗的靈活性和可追溯性:

- 靈活性:用戶可以通過直觀的界面交互式地定制和組合高級提示策略,如少樣本學習、思維鏈(CoT)、驗證鏈等。用戶還可以輸入動態槽位和相應的數據集,并設置模型溫度、提示重提交次數和選擇不同的LLMs。這些功能使得平臺能夠適應多樣化的實驗要求和用例。

- 可追溯性:整個實驗過程被詳細記錄,包括時間戳、輸入提示、模型版本、響應元數據、實驗參數和外部集成等信息。這些日志確保了每一步驟都可以被追蹤和審計,從而提高了實驗的透明度和可重復性。

問題2:在營養案例研究中,ChatBS-NexGen如何利用知識圖譜(KGs)驗證LLMs生成的飲食建議?

- 實體識別:首先,ChatBS-NexGen識別出LLMs響應中的食物名稱。

- 鏈接到KG:然后,將這些食物名稱鏈接到FoodKG和WhatToMake本體。FoodKG包含了食物的詳細信息,如血糖指數(GI),這些信息用于驗證LLMs的建議是否適合特定的健康狀況。

- 驗證和分析:通過比對FoodKG中的信息,ChatBS-NexGen能夠驗證LLMs推薦的食物是否合適。例如,對于糖尿病患者,系統可以檢查推薦食物的高GI值,并提供相應的反饋。

問題3:ChatBS-NexGen在處理LLMs響應的相似性分析時采用了哪些方法?這些方法揭示了什么?

ChatBS-NexGen采用了兩種方法來分析LLMs響應的相似性:

- 跨LLMs比較:通過計算不同LLMs(如Llama-3.1和GPT-4o mini)之間響應的Jaccard相似系數,來比較它們對同一患者的推薦結果。例如,Llama-3.1和GPT-4o mini對同一患者推薦的食品覆蓋范圍分別為42%和39%。

- 同一LLMs內部比較:通過計算同一LLMs(如GPT-4o mini)多次響應之間的Jaccard相似系數,來評估其一致性。例如,GPT-4o mini對同一患者生成的10個響應的Jaccard相似系數為0.05,表明不同響應之間的一致性很低,推薦結果存在顯著差異。

這些方法揭示了LLMs在生成推薦時存在的高變異性和一致性挑戰,強調了在管理和驗證LLMs響應時需要更多的自動化和結構化工具。

本文轉載自 ??知識圖譜科技??,作者:KGGPT