基于預訓練模型的知識圖譜嵌入編輯

一、引言

知識圖譜和大型語言模型都是用來表示和處理知識的手段。不同于大型語言模型,知識圖譜中的知識通常是結構化的,這樣的結構讓其具有更強的準確性和可解釋性。知識圖譜嵌入(Knowledge Graph Embedding,KGE)是一種將知識圖譜中的實體和關系轉化為低維度、連續的向量空間表示的技術。這種轉化使得復雜的關系和屬性能夠以向量形式表達,從而便于機器學習算法進行處理。這些技術為各種知識密集型任務(例如信息檢索、問答和推薦系統)提供了寶貴的后端支持。最近的一些工作表明,基于預訓練語言模型的知識圖譜嵌入可以充分利用文本信息進而取得較好的知識圖譜表示性能。

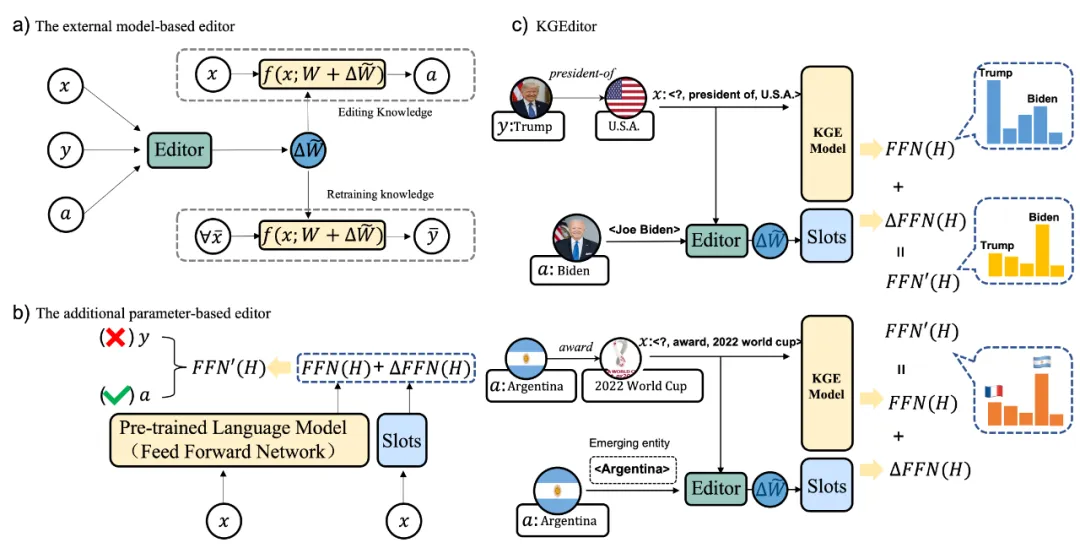

然而,現有的知識圖譜嵌入模型一般是作為一個靜態工件被部署在服務中,一經訓練好知識圖譜表示模型就很難適應新出現的實體以及處理事實知識發生修改的情況,比如,如果讓一個在2021年以前訓練的知識圖譜表示模型去預測<美國、現任總統、?>,那么它最有可能給出的答案是唐納德·特朗普。但是隨著美國總統大選舉行,總統換屆,到2021年總統就變成了喬·拜登。因此,如何高效地修改其中過時或錯誤的知識成為了一個挑戰。為解決這一問題,本文提出了一種基于預訓練語言模型的知識圖譜嵌入編輯方法——KGEditor。不同于直接編輯大型語言模型內部的知識,知識圖譜嵌入編輯是針對知識圖譜中的事實性知識進行操作。并且編輯知識圖譜嵌入需要考慮知識的復雜結構,比如一對多,多對多等知識結構。

二、方法

(1)任務定義

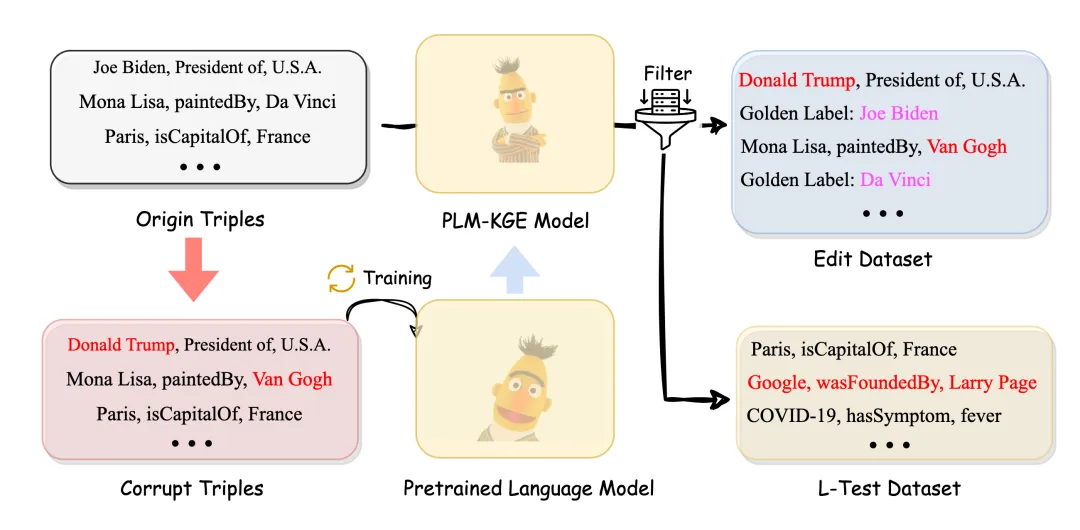

隨著外部世界的變化,需要將新的事實加入到現有KG中去。因此有必要將這些新的三元組知識靈活地插入到KGE中。所以引出了第二個子任務ADD,其目的是將前一階段訓練中沒有的全新知識植入到模型中去,這類似于KG中的歸納推理設置,但是整個模型是不需要重新訓練的。這兩種任務示意如圖所示:

本文將編輯KGE模型的任務整體定義如下:

(2)Metrics

Success@1 metric (Succ@k): KGE編輯的可靠性是通過鏈接預測來判斷是否將原有錯誤的知識成果修改回來。為了驗證編輯效果的有效性,本文采用了知識圖譜補全的設定,即通過對候選實體分數進行排名,生成一個實體列表。通過計算正確實體出現在位置K來定義修改后的模型的可靠性,定義為Success@1 metric (Succ@k),其公式如下:

Retaining Knowledge Rate of Change: 知識穩定性是試圖去評估編輯方法在成功更新特定三元組知識時,是否對知識圖譜表示模型獲取的其余知識Ox帶來了影響。本文這里主要采用兩種評估方式來探究編輯方法對于知識圖譜表示模型的影響大小,分別是知識保持率和知識的變化率。知識保持率Retain Knowledge (RK@k)代表的是原始模型預測的實體,在編輯完成后仍然能夠正確推斷出來的概率。首先本文設定了一個專門用于穩定性測試的數據集:L-test。L-test數據集收集了原始模型預測出來的Top 1的三元組數據,作為觀測數據集。如果編輯前后的KGE模型預測相對應的三元組預測保持不變,則認為編輯遵循知識局部性,即不會影響其余事實。通過計算保留知識局部性的比例作為知識編輯穩定性的衡量標準,其定義如下所示:

Edited Knowledge Rate of Change: 為了更好觀察編輯對穩定性影響的大小,本文引入了兩個額外的指標來衡量編輯帶來的影響大小。即編輯知識的變化率(Edited Knowledge Rate of Change)和保留知識的變化率(Retaining Knowledge Rate of Change),兩個公式定義如下:

(3)模型選擇

本文采用的知識圖譜嵌入模型都是基于預訓練的知識圖譜嵌入模型。文中將這類模型進一步細分為兩種形式:其一是以KG-BERT為代表的FT-KGE(Finetuning Knowledge Graph Embedding)模型,其二是以NN-KG代表的PT-KGE(Prompt Tuning Knowledge Graph Embedding)模型。

FT-KGE,如KG-BERT,KG-BERT將KG中的三元組視為文本序列。這類方法通過對由[SEP]和[CLS]等特殊token連接的關系和實體的三元組的描述進行訓練,然后將描述序列作為微調的輸入。通常使用[CLS]來進行二元分類來判斷三元組的合法性,注釋如下:

(4)Datasets

為了構建知識圖譜編輯數據集,本文借助了目前知識圖譜中常見的兩個基準數據集:FB15k237和WN18RR。

EDIT Task:未來確定編輯對象,本文收集了在KGE模型鏈接預測任務上具有挑戰性的數據。即本文采樣了鏈接預測中,實體排序在2,500以上的數據(模型難以預測正確的三元組補全數據)。對于穩定性測試集,本文將模型原本能夠預測保持在top k的數據保留下來,做為L-test數據集。其構建的具體流程如圖所示:

ADD Task:對于ADD任務數據集構建,本文采用了知識圖譜補全任務中的歸納推理任務設定(利用已有的知識圖譜中的信息來預測或推斷缺失的關系和實體),測試數據集中的實體知識都是在訓練中沒有見過的,所以可以看作為新增的知識。

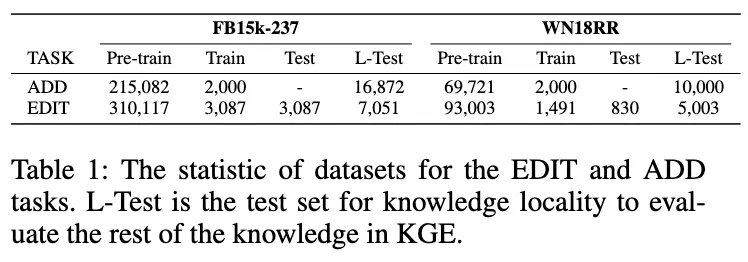

在FB15k-237和WN18RR上本文都采用相同的數據集設定,處理方式也保持一致。通過以上操作,本文最終可以得到以下四個數據集:E-FB15k237,A-FB15k237,E-WN18RR,和A-WN18RR。其中具體的統計如表所示:

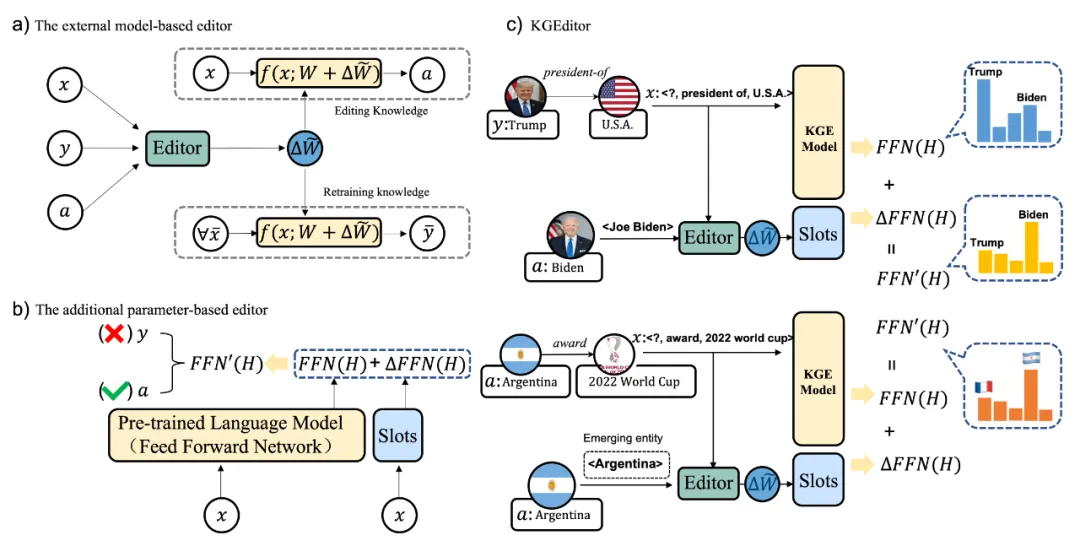

(5)KGEditor

本文首先在一些通用的知識編輯方法上進行初步的實驗測定,發現現有的知識編輯方法存在以下問題。首先基于額外參數的編輯方法CaliNet不管是在Edit還是ADD任務上,表現都比較一般,其效果不如給予額外模型的編輯方法,如MEND和KE等。但是MEND和KE的編輯效率是低的,其額外模型的參數需要去生成網絡參數,所以其編輯所需要訓練的參數也會隨著隱藏層緯度的增大而增加,不會比微調的方式更節約資源。所以本文總結兩種方法的優缺點,通過綜合兩者的優勢,提出了一個新的編輯方法:Knowledge Graph Embeddings Editor(KGEditor),其具體示意如圖所示:

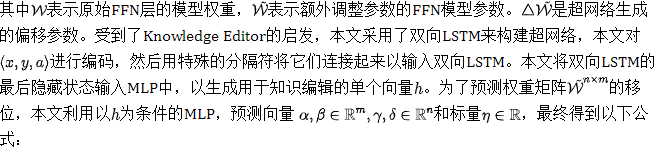

KGEditor可以在不丟失編輯性能的前提下,盡可能節約編輯的資源開銷。這樣可以節約更多的資源實現更加高效的編輯。直觀上來講,本文構建了一個與FFN架構相同的附加層,并利用其參數進行知識編輯。但是額外FFN層的參數不是依靠微調訓練,而是利用額外的超網絡來生成附加層的額外調整參數。其公式如下:

三、實驗

(1)實驗結果

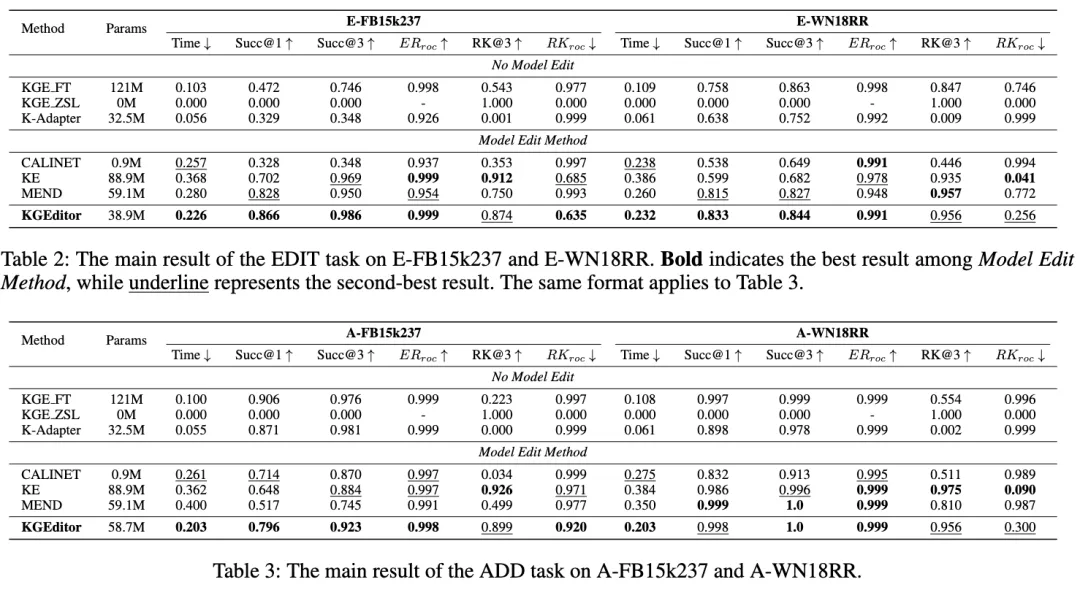

本文利用現有的一些主流知識編輯范式與KGEditor進行比較,其中具體包括CALINET、MEND和Knowledge Editor。為了對照,本文對一些其他基礎范式基線也進行了對比,首先是直接在少量更新知識上進行微調的范式和Zero-Shot的方法。其次對于K-Adapter這種使用額外參數的方法與CALINET進行比較,其中具體的實驗結果如下所示。

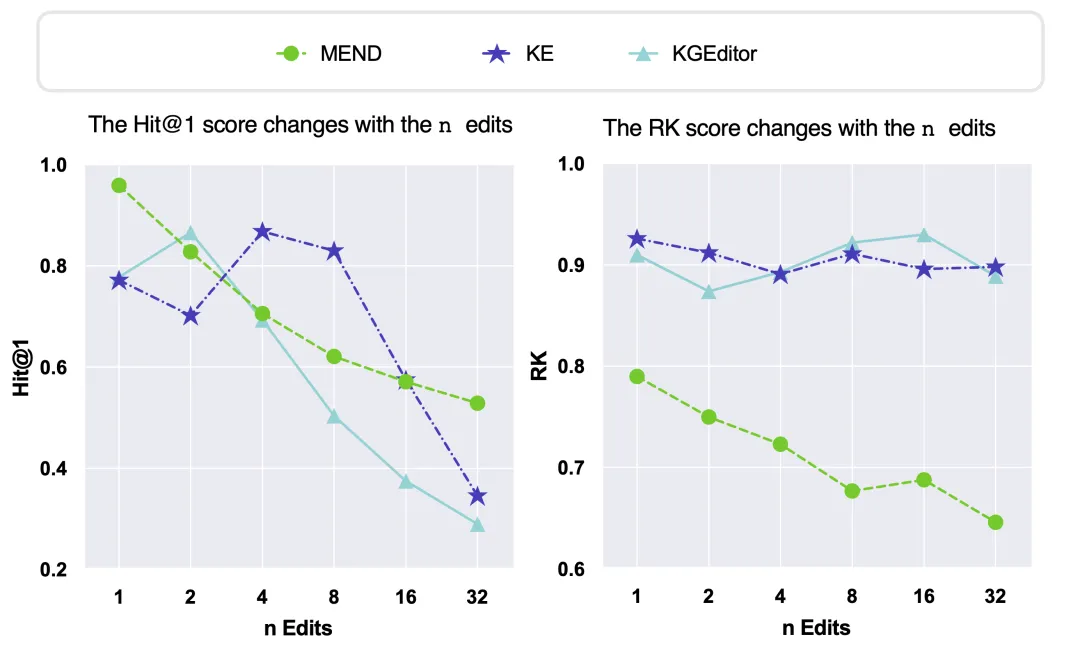

此外,本文還研究了在知識圖譜表示編輯過程中,不同數量的編輯事實對模型性能的影響。通過在E-FB15k237數據集上進行不同數量編輯的實驗,本文分析了編輯數量對知識可靠性和局部性的影響。其中主要關注三種模型:KE、MEND以及KGEditor在不同編輯數量下的表現,結果如下所示。

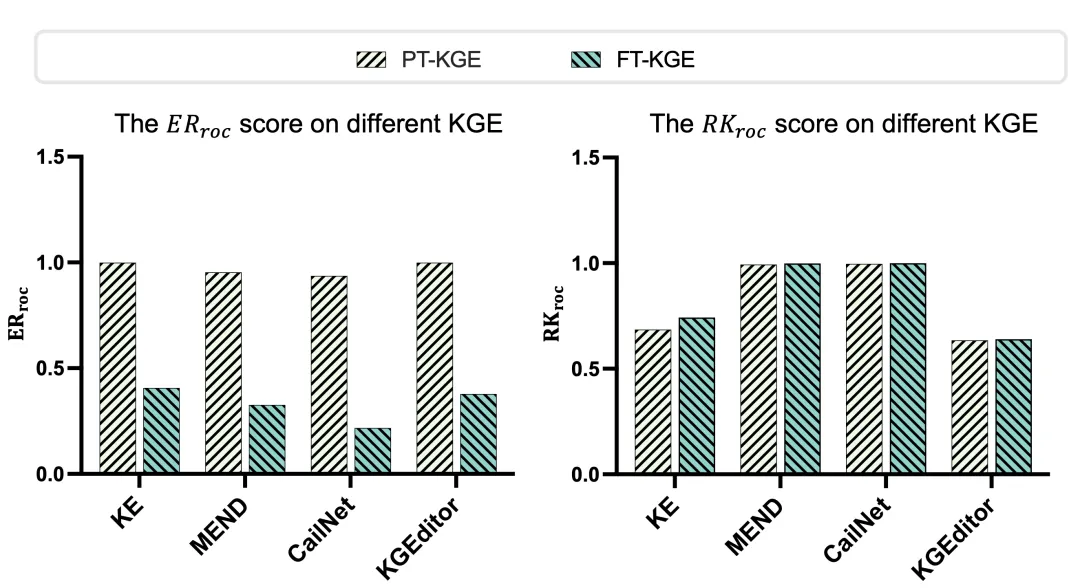

本文還探討和評估不同基于預訓練的知識圖譜表示初始化方法在編輯范式上的應用效果。通過在EDIT任務上對FT-KGE和PT-KGE的方法進行實驗,本文分析了它們在知識可靠性和局部性方面的性能表現,結果如圖所示。

(2)Case分析

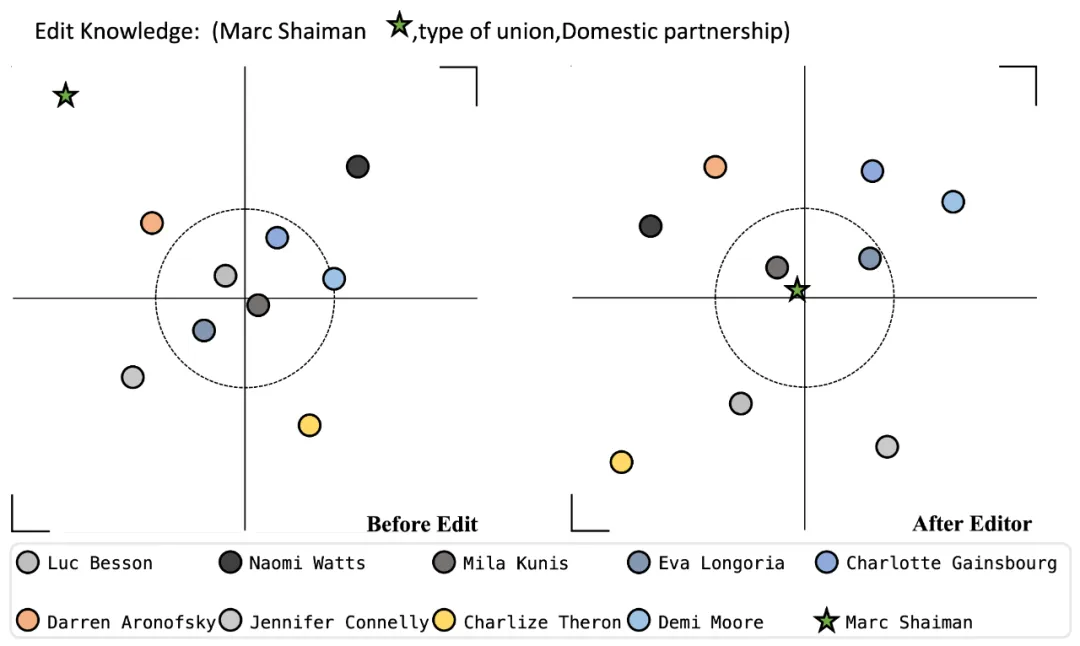

我們隨機挑選了一個編輯的Case,并通過可視化展示了編輯前后的實體變化來更清晰地觀察KGEditor的性能表現。下圖展示了知識編輯應用前后,預測實體位置的顯著變化。即在對模型進行編輯后,正確的實體明顯靠近圓心,展示了編輯KGE模型的有效性。

四、Demo

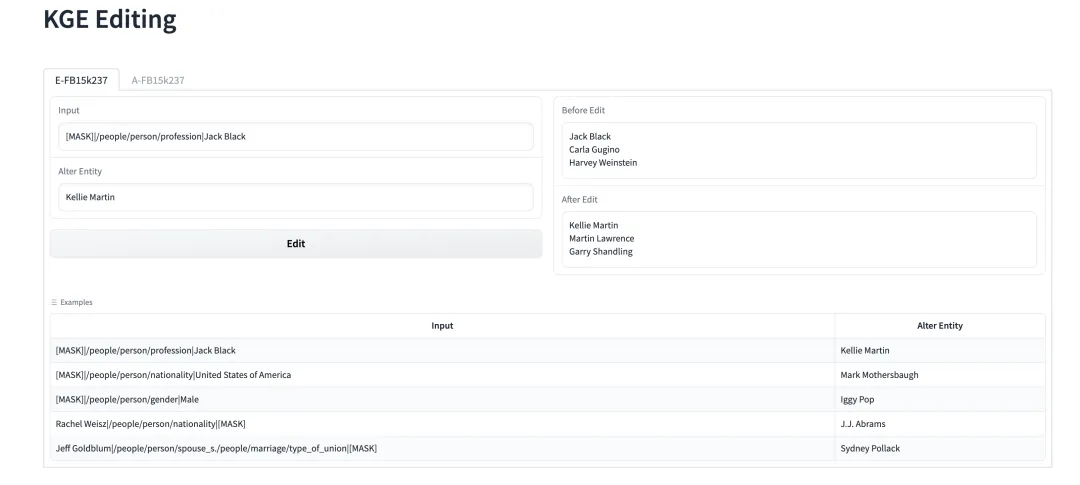

為了方便讀者更直觀了解我們的工作,我們在huggingface的Space平臺,利用Gradio去搭建了一個簡易Demo。我們會在結果處展示編輯前后預測實體的變化,具體如下圖所示。

五、總結

本文主要介紹了知識圖譜嵌入模型的編輯工作。區別于傳統的編輯預訓練語言模型的任務,KGE編輯是基于知識圖譜中的事實性知識進行操作。此外,本文提出了一個新的編輯方法——KGEditor。KGEditor是一種高效修改模型中知識的一種方法,能夠有效地節約計算資源的開銷。此外,我們的工作還有一些不足之處,比如如何去編輯知識圖譜中的一對多以及多對多知識?如何在KGE模型中做到持續更新?這都是一些未來的工作。

本文轉載自:??ZJUKG??

作者:程思源