探析可解釋人工智能 (XAI) 方法在 GDPR 合規性中的應用

1. 引言

人工智能 (AI) 正迅速滲透到我們生活的方方面面,并在各個領域展現出巨大的潛力。尤其是在信貸、住房和醫療等高風險領域,AI驅動的自動化決策 (ADM) 系統正發揮著越來越重要的作用。這些系統能夠高效地處理海量數據,并根據預設算法做出決策,從而提高效率、降低成本。然而,ADM 系統的廣泛應用也引發了人們對其透明度和問責制的擔憂。由于許多 ADM 系統基于復雜的機器學習模型,例如深度神經網絡,其決策過程往往難以理解,甚至可能存在算法偏差和歧視等問題,這給個人權益帶來了潛在風險。

為了解決 ADM 系統的"黑盒"問題,可解釋人工智能 (XAI) 應運而生。XAI 旨在提供各種方法來解釋復雜模型的決策過程,使人們能夠理解 AI 如何做出決策,并評估其公平性和可靠性。XAI 不僅有助于提高用戶對 AI 系統的信任度,還有助于識別和糾正算法偏差,確保 AI 系統的負責任使用。

歐盟的《通用數據保護條例》(GDPR) 對數據隱私和個人權利進行了嚴格的規定,其中包括對自動化決策的解釋權的要求。GDPR 第 22 條及其相關條款規定,個人有權不被完全基于自動化處理(包括分析)的決策所約束,并且有權獲得關于這些決策的解釋。然而,GDPR 對解釋權的具體內容和形式并沒有明確規定,這給 XAI 方法的合規性帶來了挑戰。

為了探究 XAI 方法如何滿足 GDPR 的要求,在論文《The explanation dialogues: an expert focus study to understand requirements towards explanations within the GDPR》中,比薩大學和南安普頓大學的研究者進行了一項專家焦點研究,旨在了解法律專家對 XAI 解釋的理解、期望和推理。這項研究的結果將為 XAI 方法的開發和應用提供重要的指導,并有助于促進 AI 系統在 GDPR 框架下的合規性。

2. 背景與相關工作

2.1 GDPR 與自動化決策

GDPR 第 22 條規定,個人有權不被完全基于自動化處理的決策所約束,除非該決策: (1) 是訂立或履行合同所必需的;(2) 基于數據主體的明確同意;(3) 是由歐盟或成員國法律授權的。此外,GDPR 還對特殊類別的個人數據(例如種族、政治觀點、健康狀況等)的自動化處理進行了更嚴格的限制。

即使滿足上述例外情況,GDPR 仍然要求數據控制者采取適當的保障措施來保護數據主體的權益。這些保障措施包括: (1) 數據主體有權獲得人工干預;(2) 數據主體有權表達自己的觀點;(3) 數據主體有權對決策提出異議。此外,GDPR 第 71 條款還提到了數據主體有權獲得對決策的解釋。

然而,GDPR 對解釋權的具體內容和形式并沒有明確規定,這引發了關于其含義和范圍的廣泛討論。一些學者認為,解釋權是競爭權的前提,數據主體只有理解了決策的依據和邏輯,才能有效地行使競爭權。另一些學者則認為,解釋權的范圍應受到 GDPR 透明度原則的限制,數據控制者只需提供必要的信息,而無需透露其商業秘密或知識產權。

不同國家對 GDPR 第 22 條的實施也存在差異。例如,法國和匈牙利在其國內法中明確規定了對自動化決策的解釋權,而其他一些國家則沒有。這些差異反映了各國對 XAI 解釋的不同理解和期望。

2.2 可解釋人工智能 (XAI)

XAI 方法可以根據其解釋范圍和模型依賴性進行分類。局部解釋方法旨在解釋單個決策,而全局解釋方法則旨在解釋整個模型的行為。模型特定方法只能用于特定類型的模型,而模型無關方法則可以應用于任何類型的模型。

研究中使用了三種模型無關的局部解釋方法:

- SHAP (SHapley Additive exPlanations):SHAP 是一種基于博弈論的特征相關性方法,它可以計算每個特征對最終決策的貢獻值。SHAP 值可以是正的也可以是負的,表示該特征對決策結果的正面或負面影響。

- DICE (DIverse Counterfactual Explanations):DICE 是一種對比解釋方法,它可以生成與待解釋實例相似但具有不同預測結果的實例。這些對比實例可以幫助用戶理解如何改變輸入特征以獲得不同的決策結果。

- LORE (LOcal Rule-based Explanations):LORE 是一種基于規則的對比解釋方法,它可以生成描述決策邏輯的規則。LORE 可以提供事實規則和對比規則,分別解釋當前決策的依據和如何改變輸入以獲得不同決策。

2.3 定性研究

XAI 中的用戶研究旨在了解不同用戶對 XAI 解釋的理解、接受程度和使用方式。用戶研究通常采用定性研究方法,例如調查、訪談和觀察,以收集用戶的反饋和意見。扎根理論是一種從定性數據中生成理論的分析方法。它通過對數據進行編碼和分類,逐步提煉出核心概念和理論框架。

3. 解釋對話

3.1 研究問題

研究旨在回答以下兩個研究問題:

- 法律專家如何理解 ADM 系統的解釋,以及他們如何判斷現有方法的法律合規性?

- 法律專家是否理解并信任 ADM 系統的解釋,以及他們認為應該如何改進?

3.2 研究設計

研究設計了一個貸款申請場景,其中銀行使用隨機森林模型來評估客戶的信用風險,并使用 XAI 方法向客戶解釋貸款申請的結果。隨機森林模型在訓練集和測試集上的準確率分別為 0.815 和 0.8,表明模型具有良好的預測性能。

研究選擇了 SHAP、DICE 和 LORE 三種 XAI 方法,并以不同的形式 (例如圖表、表格、規則) 向參與者呈現。選擇這些方法的原因包括:它們能夠提供不同類型的解釋信息 (例如全局解釋、局部解釋、對比解釋);它們是 XAI 領域的最新方法,并具有一定的法律支持。

研究招募了 9 位法律專家參與在線問卷調查,并對其中 6 位進行了后續訪談。選擇法律專家的目的是了解他們對 XAI 解釋的法律合規性和可理解性的看法。

3.3 技術細節

研究使用了 South German Credit Dataset 作為貸款申請場景的數據集。該數據集包含 1000 個數據樣本,每個樣本有 20 個特征和一個二元響應變量 ("good vs. bad" credit)。

XAI 解釋方法的計算使用了 Python 的 sklearn、SHAP 和 DICE (dice-ml) 包,以及 LORE 的開源代碼。在線問卷調查使用了 Qualtrics 軟件,訪談則通過 Microsoft Teams 進行,并進行了錄音和轉錄。所有數據都進行了匿名化處理,以保護參與者的隱私。

3.4 評估細節

問卷數據經過清洗后,對參與者的自由文本回答進行了扎根理論分析。兩位研究人員獨立地對文本進行開放編碼、軸心編碼和選擇性編碼,最終生成了一套包含六個核心現象的編碼表。訪談數據也進行了類似的扎根理論分析,最終生成了一套包含三個核心現象的編碼表。

4. 結果

4.1 問卷調查結果

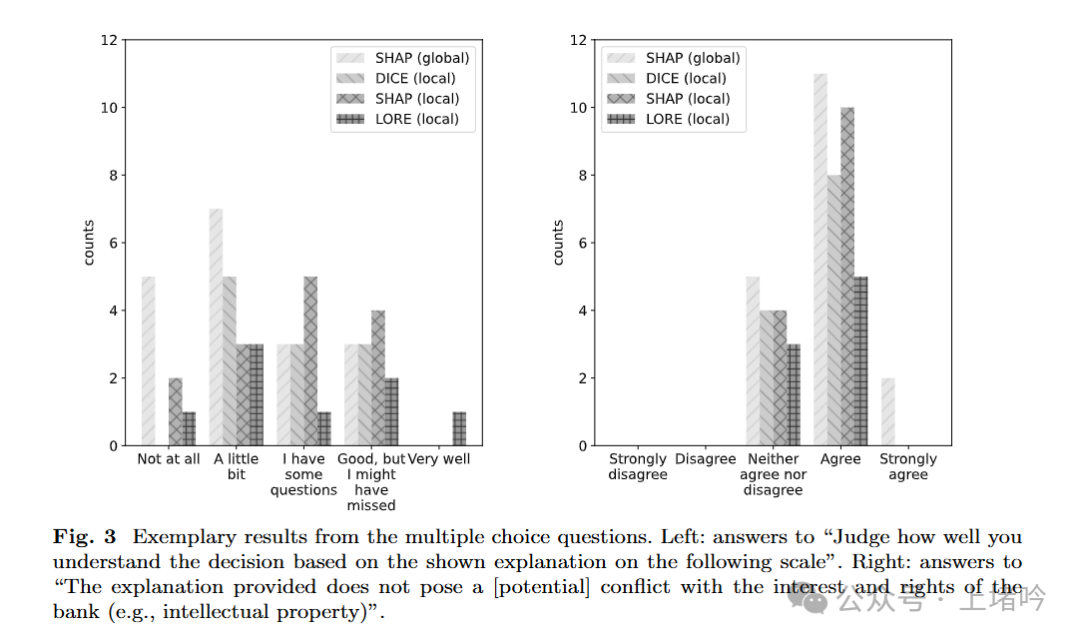

問卷結果分析主要圍繞以下六個核心現象展開: 解釋的相關性、對普通用戶的可理解性、交付方式和格式的適當性、行使權利的適用性、決策結果對信息需求的意義以及信息的完整性。

參與者對不同 XAI 方法的評價如下:

- 全局 SHAP:參與者普遍認為全局 SHAP 解釋難以理解,缺乏與個案相關的具體信息,并且對行使權利沒有幫助。

- 局部 SHAP:參與者對局部 SHAP 解釋的評價褒貶不一,一些人認為它有助于理解決策,另一些人則認為它過于復雜和難以理解。

- DICE:參與者對 DICE 解釋的評價較為正面,認為它提供了更具體的對比信息,但同時也指出其可操作性有限。

- LORE:參與者對 LORE 解釋的評價差異較大,一些人認為它清晰易懂,另一些人則認為它缺乏信息和指導意義。

4.2 訪談結果

訪談結果主要圍繞三個核心現象展開:解釋的呈現、有效性以及高級主題。訪談結果顯示,參與者對 XAI 解釋的理解程度仍然有限,并且對解釋權的范圍和內容存在不同看法。一些參與者強調了解釋的可理解性,認為解釋應該清晰易懂,以便數據主體能夠理解決策的依據。另一些參與者則更關注解釋的法律合規性,認為解釋應該提供足夠的信息,以便數據主體能夠評估決策的合法性和公平性。

4.3 相互聯系與總結

研究發現,解釋的有效性與其上下文密切相關,例如應用領域、決策的重要性以及適用的法律法規。此外,數據控制者和數據主體之間的利益權衡也是一個重要的考慮因素。XAI 解釋需要在保護數據主體權益的同時,兼顧數據控制者的商業利益和知識產權。

總的來說,問卷和訪談的結果都表明,現有的 XAI 方法在可理解性、信息完整性和法律合規性方面仍有改進空間。

5. 討論的關鍵問題

5.1 回答研究問題

在第四部分詳細分析了問卷和訪談的結果之后,現在我們來解讀一下研究提出的兩個核心問題:

- 問題 1:法律專家如何理解 ADM 系統的解釋,以及他們如何判斷現有方法的法律合規性?

研究結果顯示,法律專家對 XAI 解釋的理解存在一定難度,尤其是在面對 SHAP 生成的圖形解釋時,他們普遍感到困惑。這表明 XAI 方法的可理解性仍有待提高,開發者需要更加注重解釋的清晰性和直觀性。此外,法律專家對現有 XAI 方法的 GDPR 合規性也表示擔憂。他們認為,許多解釋缺乏關鍵信息,例如決策的具體依據、特征的重要性以及與個案相關的細節。這突顯了 XAI 方法在信息完整性方面需要改進,以滿足 GDPR 的要求。 - 問題 2:法律專家是否理解并信任 ADM 系統的解釋,以及他們認為應該如何改進?

研究發現,法律專家對 XAI 解釋的信任程度并不高。他們認為,現有的解釋方法難以幫助數據主體充分理解決策過程,并評估其合法性和公平性。為了改進 XAI 解釋,法律專家提出了一些建議,例如:

- 結合全局解釋和局部解釋,以提供更全面的信息。

- 使用清晰易懂的語言和圖表,避免使用過于專業的術語和復雜的圖形。

- 提供更多與個案相關的細節,例如特征的具體取值和對決策的影響。

- 增加解釋的交互性,允許數據主體探索不同的假設情景。

5.2 改進建議

基于研究結果, XAI 方法的開發者可以考慮以下改進建議:

- 呈現方式:為了提高可理解性,XAI 解釋應該結合全局解釋和局部解釋。全局解釋可以幫助用戶了解模型的整體行為,而局部解釋可以幫助用戶理解個體決策的具體原因。此外,開發者應該使用清晰易懂的語言和圖表來呈現解釋,避免使用過于專業的術語和復雜的圖形。例如,可以使用自然語言、決策樹或簡單的圖表來解釋模型的決策邏輯。

- 格式選擇:XAI 解釋的格式應該根據用戶的需求和理解能力進行選擇。對于非專業用戶,可以使用文本、簡單的圖表或決策規則來解釋模型的決策過程。對于專業用戶,可以使用更復雜的圖形或數學公式來解釋模型的內部機制。

- 內容設計:XAI 解釋應該提供足夠的信息,以幫助用戶理解決策過程。這些信息應該包括決策的依據、特征的重要性以及對比信息等。例如,可以使用 SHAP 方法來解釋每個特征對決策的貢獻,使用 LIME 方法來解釋模型在局部區域的行為,使用 DICE 方法來生成對比解釋。

- 用戶需求:在開發 XAI 方法時,應該充分考慮用戶的需求。可以通過用戶研究來了解用戶的認知水平、信息需求和解釋偏好。此外,可以根據用戶的反饋來改進 XAI 方法的設計和實現。

5.3 法律問題*

在設計和應用 XAI 方法時,還需要注意以下法律問題:

- 可理解性和可解釋性:GDPR 要求 XAI 解釋必須清晰易懂,以便數據主體能夠理解自動化決策的過程,并評估其合法性和公平性。開發者需要確保 XAI 解釋的語言、格式和內容都易于被目標用戶理解。

- 透明度閾值:GDPR 鼓勵透明度,但也承認保護商業秘密和知識產權的重要性。在設計 XAI 解釋時,需要平衡數據主體的信息權和數據控制者的商業利益。

- 利益沖突:XAI 解釋需要平衡數據主體和數據控制者之間的利益。開發者應該避免設計可能導致利益沖突的解釋方法,例如,避免過度強調有利于數據控制者的信息,而忽略不利于數據控制者的信息。

5.4 未來趨勢

未來,參照之前的論文觀點,XAI 的發展趨勢可能有以下幾個:

- 與其他技術的結合:XAI 可以與聯邦學習、差分隱私等技術結合,以更好地保護數據主體的隱私和權益。例如,可以將 XAI 方法應用于聯邦學習模型,以解釋模型如何在不訪問原始數據的情況下進行訓練和決策。

- 個性化解釋:XAI 可以根據用戶的需求和理解能力提供個性化的解釋。例如,可以根據用戶的專業背景、認知水平和信息需求,調整解釋的語言、格式和內容。

- 動態解釋:XAI 可以隨著模型的更新和數據的變化提供動態的解釋。例如,可以將 XAI 方法與模型監控技術相結合,以便在模型的行為發生變化時及時更新解釋。

6. 結論

XAI 方法在 GDPR 合規性中發揮著重要的作用。它能夠幫助數據主體理解自動化決策的過程,并評估其合法性和公平性,從而保障數據主體的權益。研究通過對法律專家的調查和訪談,深入了解了他們對 XAI 解釋的理解、期望和顧慮。研究結果為 XAI 方法的開發和應用提供了重要的指導。

未來,XAI 方法需要在可理解性、信息完整性和法律合規性方面不斷改進,以更好地滿足 GDPR 的要求,并促進 AI 系統的負責任使用。

參考論文: arXiv:2501.05325v1 [cs.CY] 9 Jan 2025

本文轉載自 ??上堵吟??,作者: 一路到底孟子敬