分布式訓練通信優化,重疊通信,參數子集同步,低精度外梯度量化

研究背景與意義

- 研究背景:隨著大規模語言模型(LLMs)的迅速發展,訓練這些模型所需的計算資源和帶寬需求也隨之增加。傳統的分布式訓練方法面臨著設備協同和通信延遲等挑戰,這使得在數千個加速器上進行有效訓練變得復雜。

- 研究意義:本文提出的Streaming DiLoCo方法,旨在通過放寬設備協同的要求,降低訓練過程中的帶寬需求,從而提高訓練效率。這一方法的成功實施將為分布式訓練提供新的思路,助力在有限的帶寬條件下實現大規模模型的有效訓練。

- 研究目標:論文旨在通過三項創新(參數子集同步、計算與通信重疊、低精度外梯度量化)來實現帶寬的顯著降低,同時保持模型訓練質量。

研究方法與創新

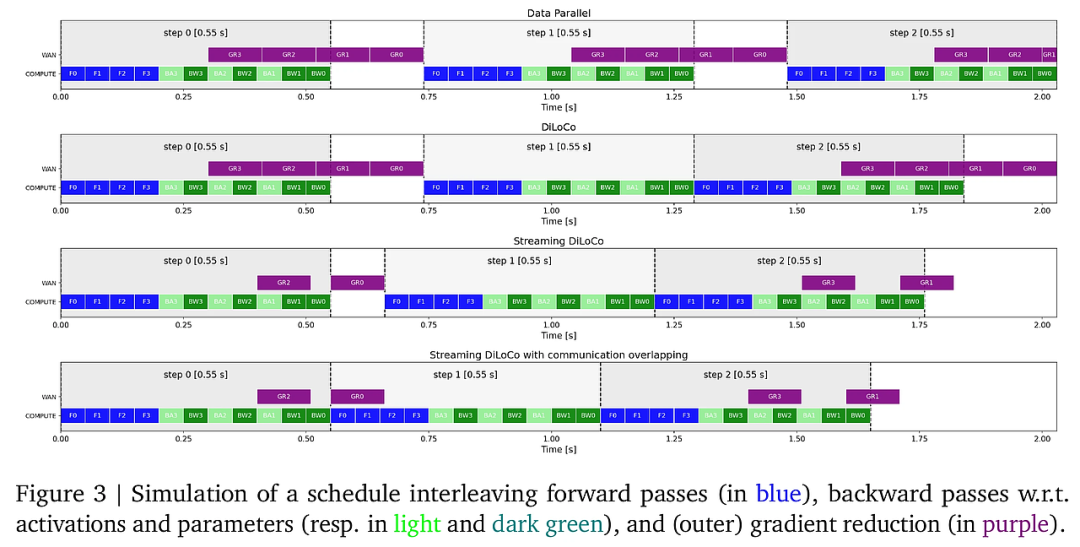

- 研究方法概述:本文基于DiLoCo算法,通過對參數同步和通信機制進行改進,提出了Streaming DiLoCo方法。該方法允許在訓練過程中對參數進行分批同步,并在計算步驟中重疊通信。

- 方法創新:

- 參數子集同步:僅同步部分參數,而不是在每次迭代中同步所有參數,這樣可顯著降低峰值帶寬需求。

- 計算與通信重疊:在進行參數同步的同時,繼續進行訓練計算,從而減少整體訓練時間。

- 低精度外梯度量化:通過將外梯度量化至更低的精度(如4位浮點),進一步減少通信所需的帶寬,且不影響模型性能。

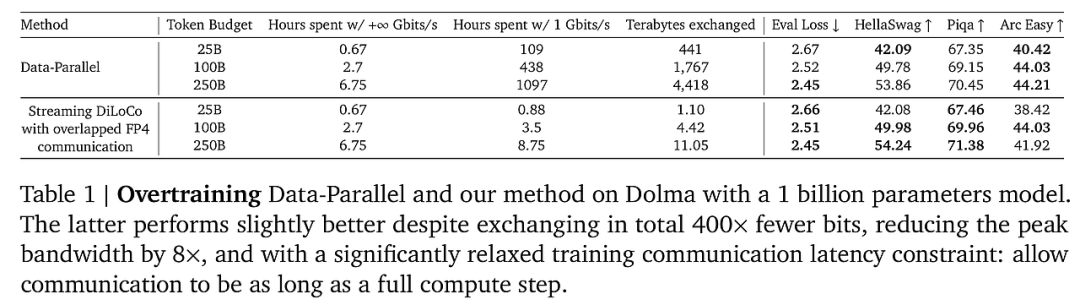

- 優勢對比:與傳統的Data-Parallel方法相比,Streaming DiLoCo在保持相似的訓練效果的同時,帶寬需求降低了400倍。這一創新為大規模模型的訓練提供了新的解決方案。

實驗設計與結果分析

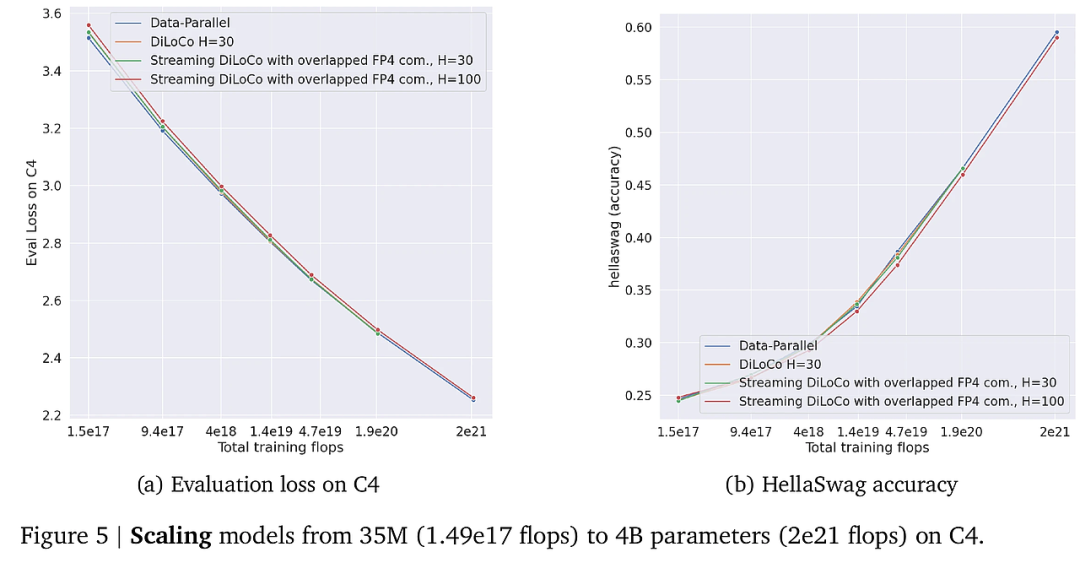

- 實驗設計:通過在不同規模的模型(從35M到4B參數)上進行訓練,評估Streaming DiLoCo方法的性能。實驗設置包括使用C4數據集和Chinchilla架構,采用不同的帶寬條件進行對比。

- 結果分析:

- 計算利用率:實驗結果顯示,Streaming DiLoCo在帶寬為1-5 Gbit/s的條件下,計算利用率高達95%,而傳統Data-Parallel方法則需要更高的帶寬以達到相似的效果。

- 訓練效果:在多個下游任務(如HellaSwag、Piqa等)中,Streaming DiLoCo與Data-Parallel方法的表現相似,證明了其在降低帶寬需求的同時,仍能保持模型性能。

- 統計顯著性:通過對比實驗的統計分析,確認了Streaming DiLoCo在帶寬利用率和訓練效率上的顯著優勢。

結論與展望

- 總結貢獻:本文提出的Streaming DiLoCo方法,通過創新的參數同步策略和通信機制,顯著降低了大規模模型訓練中的帶寬需求,保持了訓練效果。

- 分析局限:盡管Streaming DiLoCo在帶寬利用率上表現優異,但在不同設備間的異構性和通信延遲方面仍需進一步研究。

- 方法展望:未來的研究可以探索如何將Streaming DiLoCo方法與其他分布式學習框架結合,以應對更復雜的訓練場景,同時進一步優化通信效率和模型性能。

通過上述分析,可以看出本文不僅在理論上提出了新的方法論,同時在實驗中驗證了其有效性,為大規模語言模型的訓練提供了新的思路和方法。

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦