EVEv2.0,視覺語言分開編碼,多模態視覺語言理解;視覺信息引導與標記邏輯增強減少大語言模型幻覺

研究背景與意義

在當前的人工智能研究領域,視覺-語言模型(VLMs)正迅速發展,特別是在大型語言模型(LLMs)和視覺模型(LVMs)取得顯著進展的背景下。本文提出的EVEv2.0模型,旨在解決現有編碼器驅動的VLMs在多模態理解和推理中的局限性。研究表明,現有的編碼器驅動方法在靈活性和適用性上存在一定挑戰,尤其是在處理復雜的視覺信息時。因此,EVEv2.0通過引入無編碼器的設計,試圖減少視覺和語言之間的干擾,從而提升模型的整體性能和可擴展性。

研究方法與創新

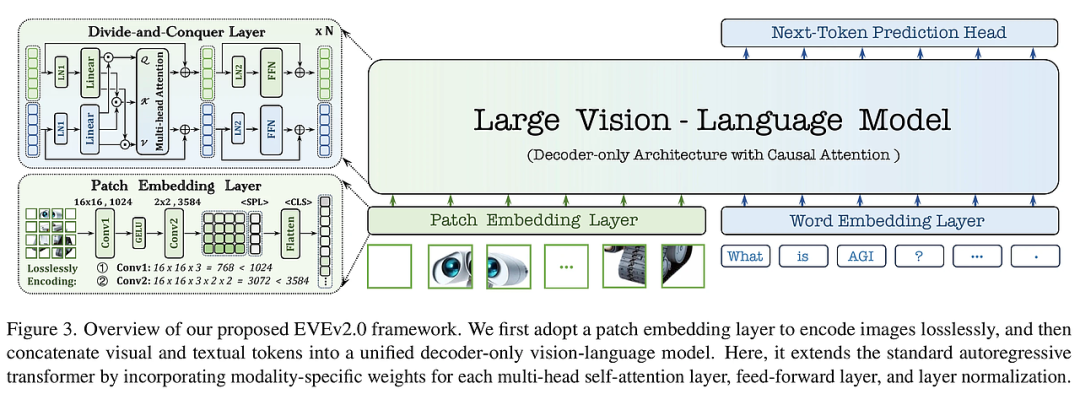

EVEv2.0的核心創新在于其全新的“分而治之”架構,旨在有效整合視覺和語言信息。該模型通過以下幾個關鍵策略實現了創新:

- 去耦合設計:EVEv2.0將視覺和語言的處理模塊進行分離,使用不同的注意力矩陣和規范化層,以減少模態間的干擾。

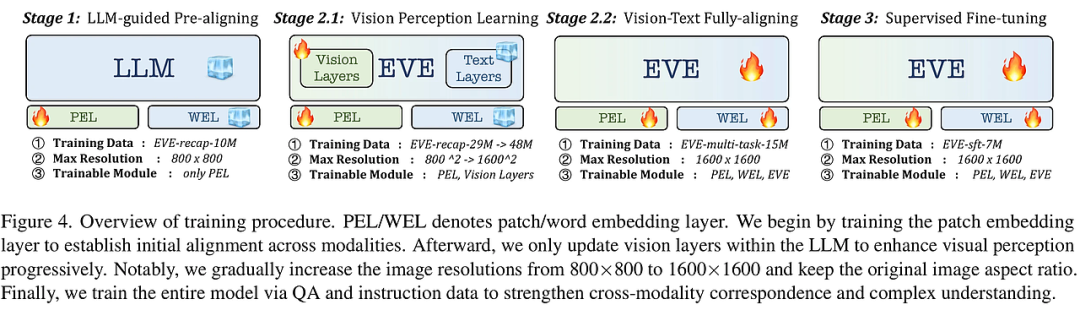

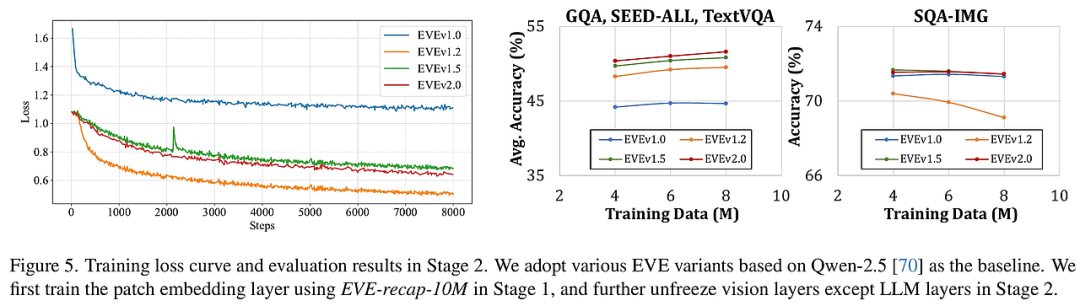

- 高效的訓練策略:通過逐步引入視覺層和語言層的訓練,EVEv2.0能夠在保持預訓練知識的同時,優化視覺感知能力。

- 無編碼器架構:相較于傳統方法,EVEv2.0不依賴于預訓練的視覺編碼器,而是從頭開始構建視覺表示,提升了模型在多模態任務中的表現。

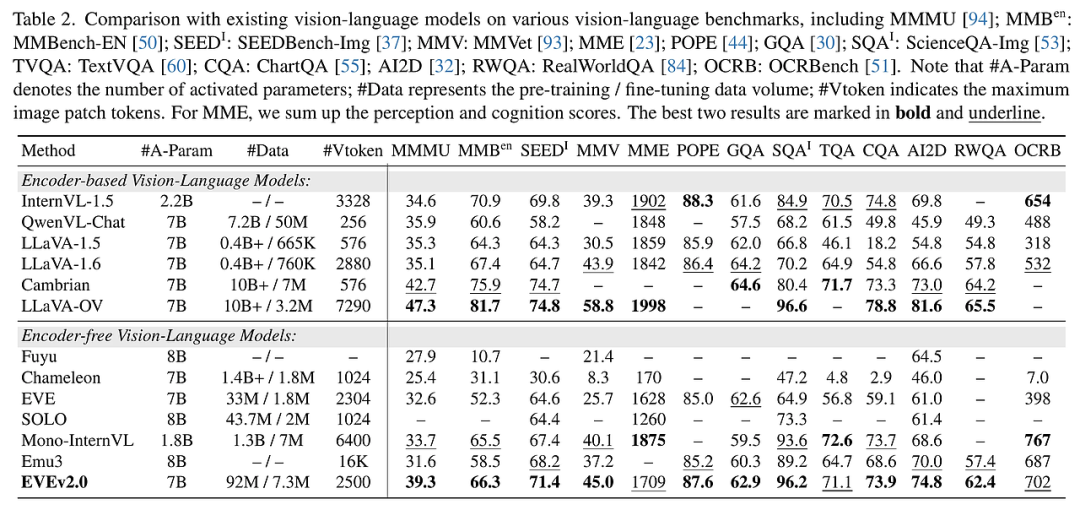

這些方法使得EVEv2.0在多個視覺語言基準測試中表現出色,尤其是在數據擴展和模型可伸縮性方面,展現了其強大的潛力。

實驗設計與結果分析

EVEv2.0的實驗設計包括多個階段,逐步優化模型的視覺和語言理解能力。通過對比不同的訓練數據集和模型架構,研究發現:

- 數據規模效應:隨著訓練數據規模的增加,模型性能顯著提升,尤其是在復雜的視覺理解任務中。

- 視覺感知學習:模型在視覺層的訓練過程中,通過引入高質量的圖像-文本對,極大地增強了視覺感知能力。

- 多模態對齊:EVEv2.0在多模態對齊任務中表現優異,顯示出其在處理復雜視覺和語言信息時的優勢。

這些結果表明,EVEv2.0不僅在理論上提供了新的思路,也在實踐中展現了其強大的應用潛力。

結論與展望

EVEv2.0的提出,標志著無編碼器VLMs研究的一個重要進展。通過系統地分析和優化模型架構,EVEv2.0在多模態理解和推理中展現了卓越的性能。未來的研究可以進一步探索模型的擴展性,尤其是在音頻和視頻等其他模態的整合上。EVEv2.0為無編碼器VLMs的研究提供了新的方向,期待其在實際應用中的廣泛應用與發展。

The Hidden Life of Tokens: Reducing Hallucination of Large Vision-Language Models via Visual Information Steering

2025-02-05|Rutgers U, Stanford, Google DeepMind|??9

???http://arxiv.org/abs/2502.03628v1????

????https://huggingface.co/papers/2502.03628????

????https://github.com/LzVv123456/VISTA???

研究背景與意義

在多模態人工智能領域,大型視覺語言模型(LVLMs)如LLAVA和MiniGPT-4的崛起,標志著文本與視覺信息的無縫融合。然而,這些模型在實際應用中常常出現“幻覺”現象,即生成的內容在語法上是合理的,但與視覺輸入不相符。這種現象不僅降低了模型的可靠性,也限制了其在關鍵應用場景中的有效性。

本研究通過分析LVLMs的內部動態,揭示了幻覺產生的根本原因。研究者們發現,幻覺的形成與以下幾個因素密切相關:視覺信息在生成過程中的逐漸喪失、語義有效詞匯的早期激活,以及隱藏的真實信息。這些發現為理解和解決LVLMs中的幻覺問題奠定了基礎,并為未來的研究指明了方向。

研究方法與創新

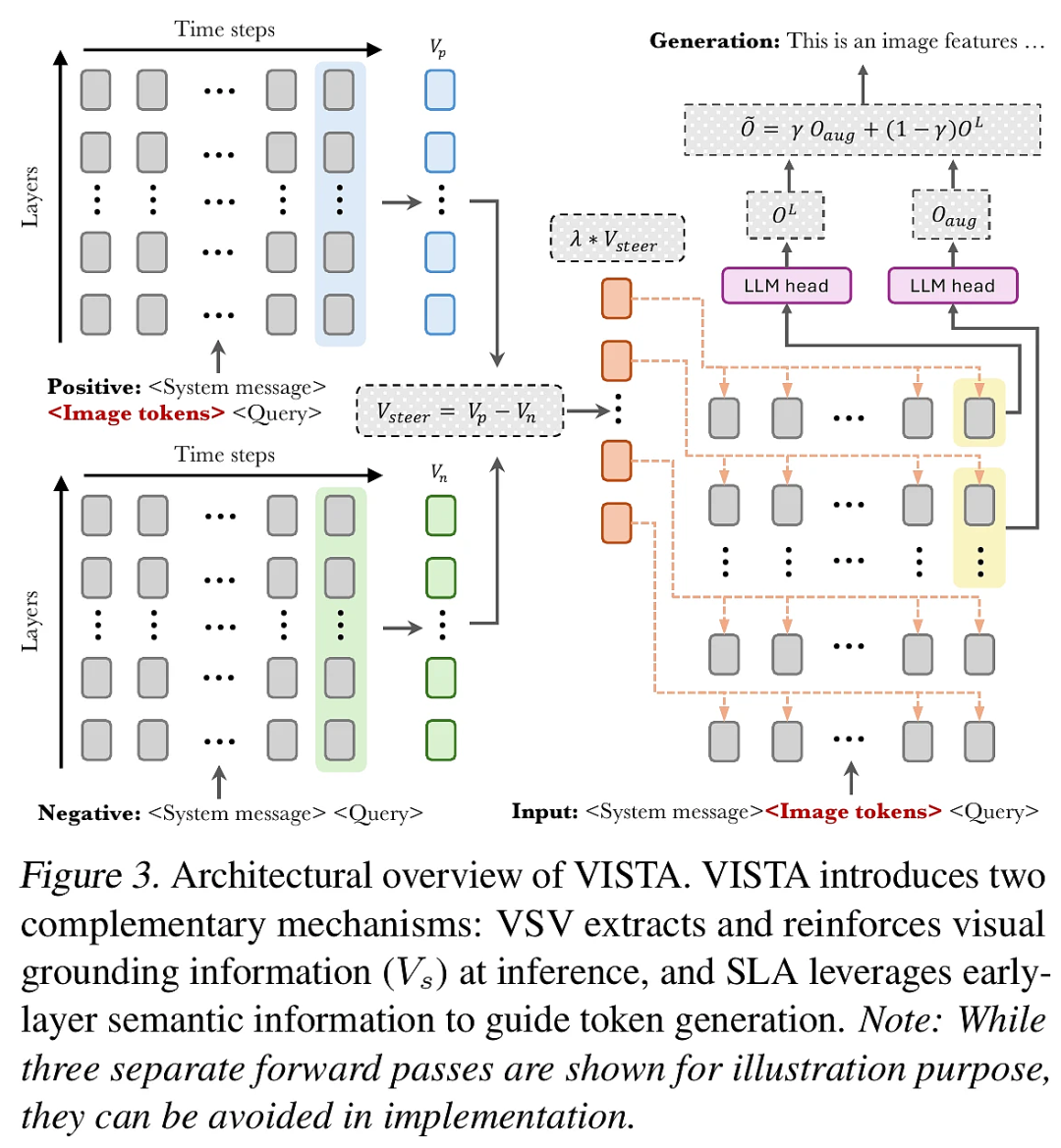

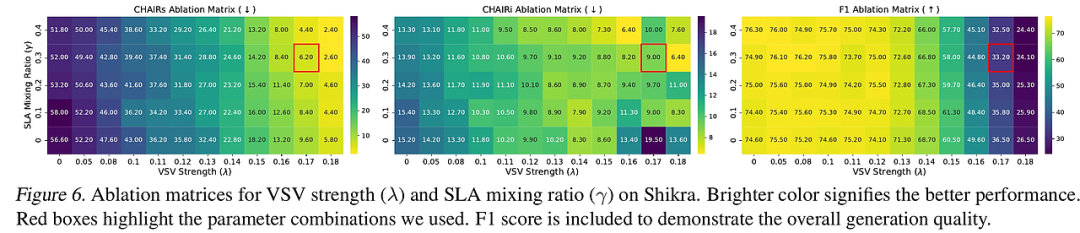

本研究提出了一種新的干預框架——視覺信息引導與標記邏輯增強(VISTA),旨在減少LVLMs的幻覺現象并促進真實信息的生成。VISTA的創新之處在于其無需額外訓練,能夠有效整合到現有的解碼策略中。其核心機制包括兩個互補模塊:

- 視覺引導向量(VSV):通過提取和強化視覺線索,抵消生成過程中的視覺信息喪失。

- 自標記增強(SLA):利用早期激活現象,優先考慮語義有效的標記,從而提升生成質量。

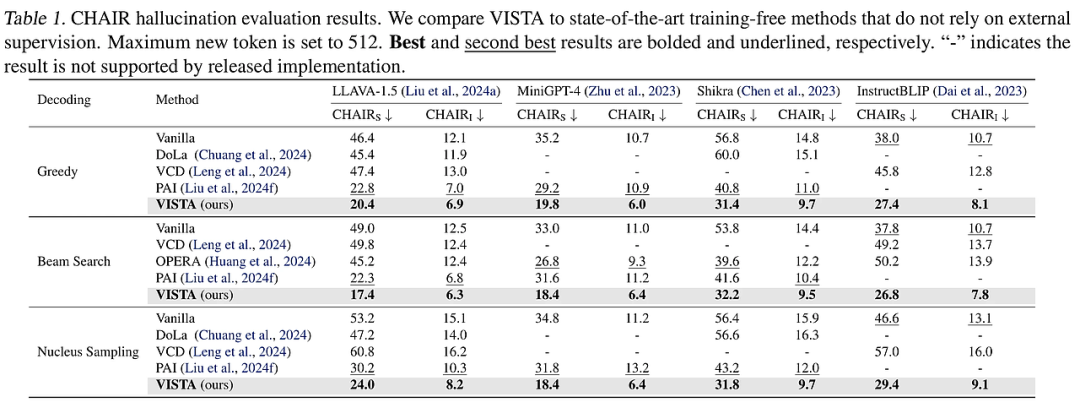

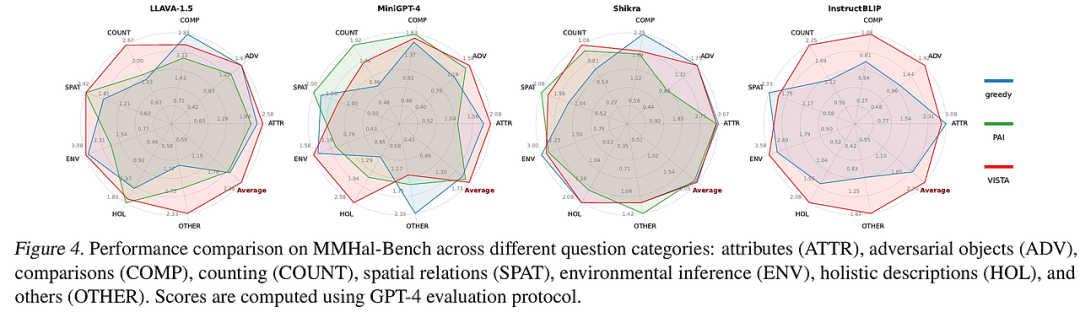

通過對比現有方法,VISTA在多個基準測試中表現出顯著的優勢,減少了約40%的幻覺現象,并在四個不同架構下的多個解碼策略中均表現出色。

實驗設計與結果分析

本研究通過綜合實驗設計評估VISTA的有效性,涉及四種架構和三種解碼策略。實驗結果顯示,VISTA在減少幻覺方面的表現顯著優于傳統方法,尤其在開放式生成任務中,其表現提升尤為明顯。

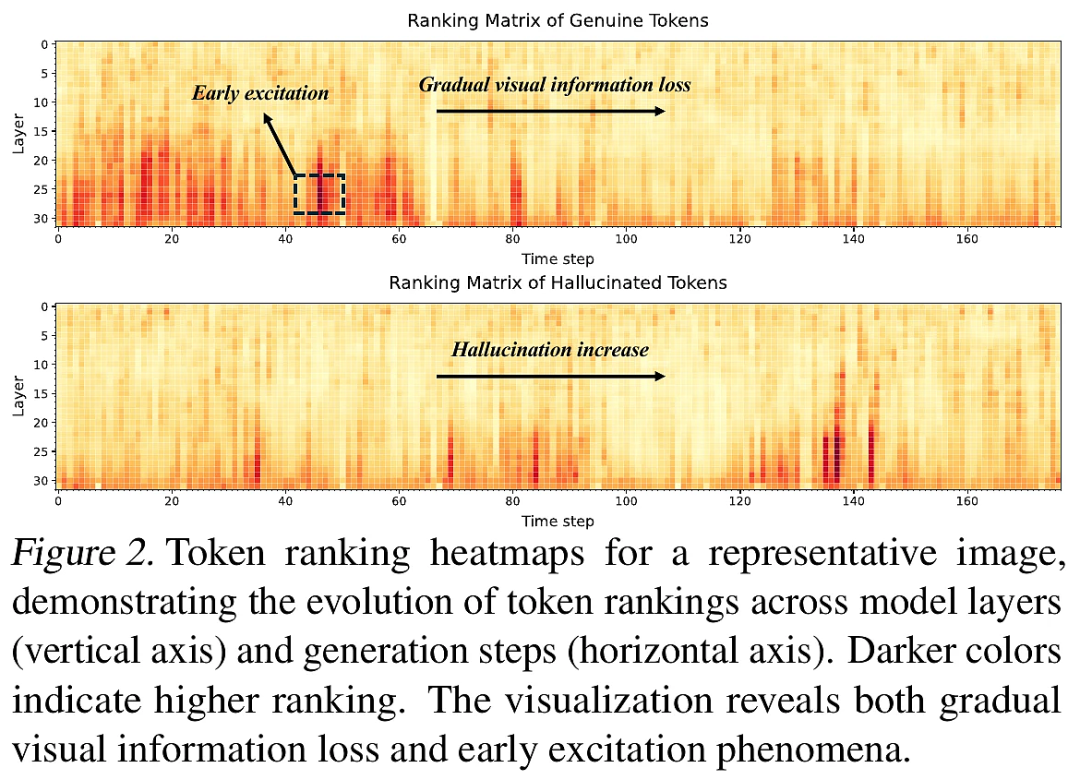

- 逐步視覺信息喪失:隨著生成過程的進行,真實標記的排名逐漸下降,而幻覺標記的排名則逐漸上升。這一現象表明,語言優先的影響在生成的后期階段顯著增強。

- 早期激活:語義有效標記在倒數第二層的激活達到峰值,表明模型在最終決策階段過于強調語法結構而非視覺信息。

- 隱藏真實信息:盡管某些真實標記未被最終解碼,但在生成過程中仍保持較高的排名,表明模型可能感知到更多的視覺線索。

結論與展望

本研究的貢獻在于提出了一種新穎的框架(VISTA),有效解決了LVLMs中的幻覺問題,促進了真實信息的生成。盡管取得了顯著成效,但仍存在一些局限性,如對特定任務的適應性和模型復雜性等。未來的研究可以進一步探索VISTA在其他多模態任務中的應用潛力,并優化其在不同場景下的表現,以實現更高的生成質量和更強的模型魯棒性。

通過本研究,期待為多模態人工智能的進一步發展提供新的視角與思路。