洞悉arXiv的LLM論文趨勢 原創(chuàng)

大型語言模型 (LLM) 正在極大地影響 AI 研究,引發(fā)了關于迄今為止發(fā)生了什么變化以及如何塑造該領域未來的討論。為了澄清這些問題,有研究人員分析新的數(shù)據(jù)集,其中包含16,979篇與LLM相關的arXiv論文,重點關注2023年與2018-2022年相比的最新趨勢。

首先研究人員觀察到LLM 研究越來越多地影響著社會,這從計算機和社會arXiv中LLM 論文提交量增長20倍可以看出。大量新作者來自非計算機的NLP領域,推動了各個學科擴展。

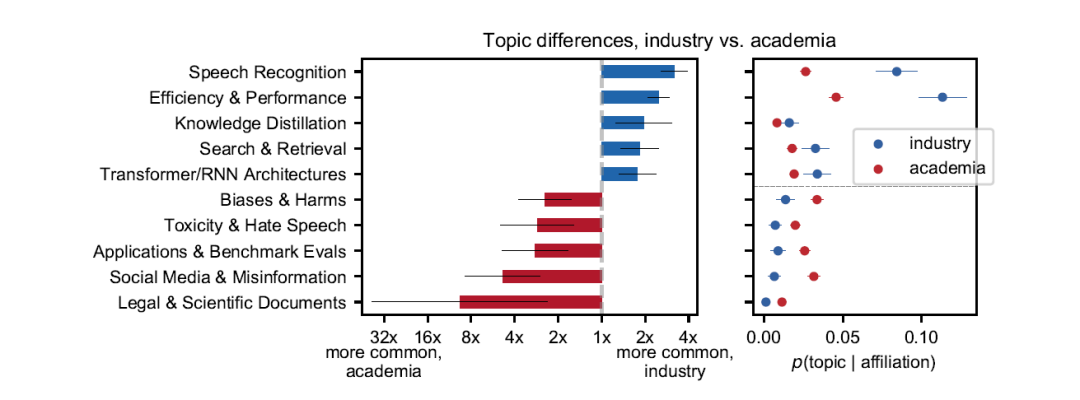

其次,令人驚訝的是2023 年行業(yè)出版物份額較小,主要是由于谷歌和其他大型科技公司的產(chǎn)出減少,亞洲的大學出版更多。

注意百分比的數(shù)字

2023年,LLMs的研究急劇增加,大約15%的新計算機科學和統(tǒng)計學論文都提到了LLMs,比2022年的7.5%有了巨大的飛躍。表明學術(shù)界對LLMs的興趣增長得很快。

主要涉及如下六個方面:

1. 許多論文都集中在模型LLMs的設計和訓練方法上。研究人員正在探索諸如Transformer架構(gòu)、縮放定律以及如何在大型數(shù)據(jù)集上有效訓練這些模型的方法。

2. 提高推理和推理能力是LLMs的主要研究領域。這包括整合外部知識,創(chuàng)建基準進行測試,以及使用高級技術(shù)來增強模型響應。

3. LLMs被用于問答、代碼生成、任務自動化和創(chuàng)意寫作等各個領域的應用領域研究也很熱門。該領域主要著眼于LLMs可以做什么、局限性以及如何擴大實際用途。

4. LLMs對社會的影響和道德方面的研究也浮上了水面。在LLMs快速發(fā)展的過程中引發(fā)了錯誤信息、偏見、隱私和濫用等重要問題。

5. 如何解釋和評估LLMs是另一個重點。研究人員正在開發(fā)和測試解釋這些復雜模型的方法,旨在使它們更加透明和穩(wěn)健。

6. 隨著LLMs規(guī)模的擴大,找到有效的方法來使用和部署它們至關重要。這里的研究包括模型壓縮、蒸餾和加速硬件的技術(shù)。

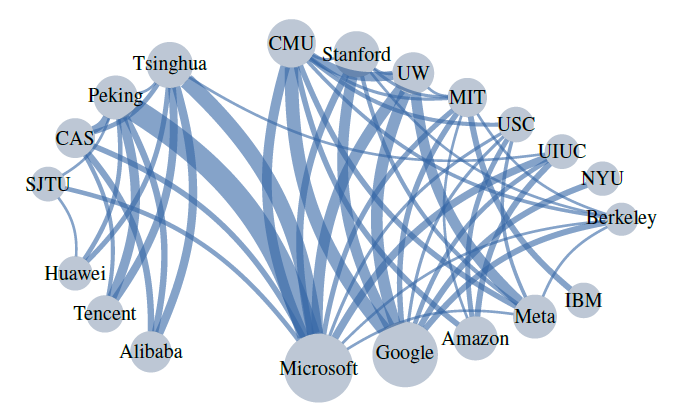

機構(gòu)之間的合作關系,線段粗細代表合作的緊密度

該研究還著眼于誰在進行LLM研究以及這如何影響正在研究的主題。大多數(shù)LLM論文來自大學,但像Microsoft和谷歌這樣的大型科技公司也做出了很大貢獻。高被引論文通常擁有更大的團隊,并且更有可能來自工業(yè)界而不是學術(shù)界。這表明科技公司的合作和資源可能有助于產(chǎn)生更有影響力的研究。

本文轉(zhuǎn)載自 ??魯班模錘??,作者: 龐德公