今日arXiv最熱NLP大模型論文:天津大學發布大模型數學能力細粒度評價基準FineMath

引言:大語言模型數學能力評估的重要性

數學能力的評估對于理解和發展大語言模型(LLMs)至關重要。數學問題不僅涉及對數字的理解和操作,還包括了抽象概念化、邏輯推理等核心能力的考察。因此,一個高質量的數學評估基準對于全面評估LLMs的能力具有重大意義。

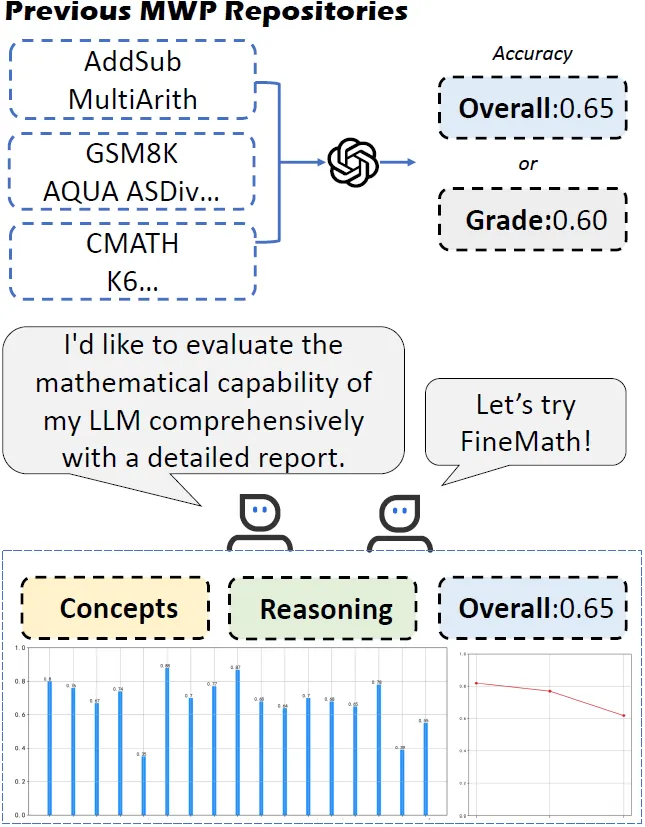

傳統的數學問題數據集,如AddSub和MultiArith(下圖),提供了基礎的數學詞匯問題庫,但這些通常只能評估模型在特定數學問題上的準確性。隨著中文LLMs的迅速發展,相應的中文數學評估數據集也應運而生。然而,簡單的準確率評估并不能充分揭示模型掌握了哪些數學概念或技能。因此,迫切需要一個更全面的測試集,能夠細致地評估LLMs在不同難度級別的數學問題上的推理能力。

▲FineMath能夠從三個方面評估LLMs的數學能力:理解抽象數學概念的準確性、推理的準確性以及整體的準確性。

為了解決這一問題,我們提出了FineMath,這是一個針對中文LLMs的細粒度數學評估基準數據集(參見上圖)。該數據集包含小學數學的核心概念,分為17類數學詞匯問題,用以深入分析LLMs的數學推理能力。所有數學詞匯問題均經手工標注,按解決難度(推理步驟數)分級。通過在FineMath上對多個LLMs進行實驗,我們發現中文LLMs在數學推理上還有進步空間。我們還深入分析了評估過程和方法,發現它們對模型結果和理解其數學推理能力有重大影響。FineMath數據集即將公開。

論文標題:

FineMath: A Fine-Grained Mathematical Evaluation Benchmark for Chinese Large Language Models

論文鏈接:

???https://arxiv.org/pdf/2403.07747.pdf??

FineMath基準的構建與目標:細粒度評估中文LLMs的數學推理能力

1. 數據集概述與關鍵數學概念的覆蓋

FineMath基準旨在全面評估中文LLMs的數學推理能力。該基準涵蓋了小學數學中的主要關鍵數學概念,并進一步細分為17類數學應用題(Math Word Problems, MWPs),使得能夠深入分析LLMs的數學推理能力。這些關鍵概念和技能包括數字與運算、代數、幾何、測量、數據分析與概率、問題解決和推理等。

2. 17個數學問題類別的詳細介紹

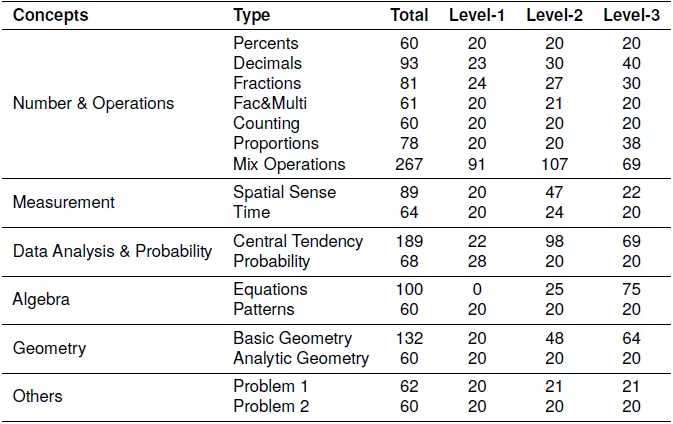

FineMath包含17種類型的MWPs(見下表),這些類型基于中國教育部制定的數學課程標準以及美國國家數學教師委員會(NCTM)設定的原則和標準。這些類別包括百分比、小數、分數、因數與倍數、計數、比例和混合運算等。每種類型的MWPs都包含三個難度級別,以促進詳細的推理能力分析。

3. 難度分級與推理步驟的標注

FineMath中的每個數學問題都根據解決問題所需的推理步驟數量手動注釋難度級別。問題被分為三個難度級別:一步推理的問題為一級難度,兩步推理的問題為二級難度,三步或更多步推理的問題為三級難度。這種分類不僅反映了問題的難度,還代表了推理過程。

數據收集與注釋過程

1. MWP分類與問題標準化

在數據收集過程中,我們將收集到的問題分類為17種類型,每種類型對應一個關鍵或基本概念。我們將多個查詢的問題標準化,確保每個問題只包含一個查詢,并重新表述模糊查詢,以便模型能夠生成唯一的答案。

2. 數學推理與答案標準化

我們手動進行MWPs的回答過程,并由人工雙重檢查真實答案。我們要求注釋者提供回答每個MWP的步驟,每個步驟應該是原子的、不可分割的。對于使用固定解決公式的計算,例如計算圓的面積,我們將其視為單步MWPs。

3. 多項選擇題的轉換

為了便于自動評估,我們還將原始的MWPs轉換為多項選擇題形式,手動提供額外的對比答案選項,類似于AQUA數據集。

FineMath數據統計與分析

1. 數據集的整體統計信息

FineMath數據集旨在評估中文LLMs的數學推理能力,涵蓋了小學數學中的主要概念,并進一步細分為17類數學應用題。這些類別的題目都經過手動注釋,根據解決問題所需的推理步驟數量來標注難度等級。數據集包含1584個問題,每個數學概念至少包含60個問題,每個難度等級至少包含20個問題。FineMath的數據統計顯示,所有問題被分為五個主要數學概念和兩種經典類型的數學應用題,確保了數據集的多樣性和全面性。

2. 數據集污染分析及其對模型性能的影響

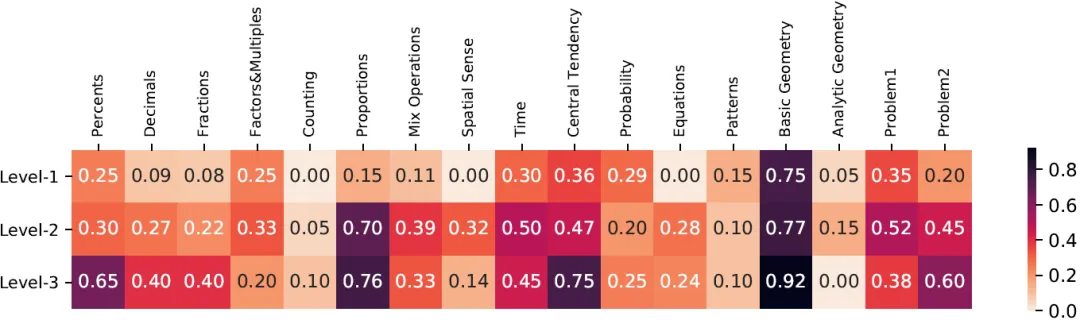

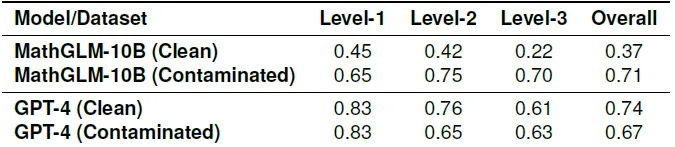

FineMath數據集的一個關鍵考量是測試數據污染問題,即測試數據可能無意中被包含在模型的訓練數據中。這種污染可能導致模型性能的高估,從而誤導我們對模型泛化能力的理解。為了評估污染情況,研究人員采用了與GPT-3相同的方法來計算FineMath與Ape210K(一個公開的大規模中文數學應用題數據集)之間的n-gram重疊情況(下圖)。通過這種方法,研究人員發現某些問題類型的重疊率明顯高于其他類型,例如基礎幾何和比例問題。

為了深入了解這些重疊示例對模型性能的影響,研究人員將測試示例分為兩個數據集:一個包含重疊示例的污染數據集和一個與Ape210k訓練集沒有重疊的干凈數據集。在對比GPT-4和MathGLM-10B在這兩個數據集上的表現時(下表),發現MathGLM-10B在污染數據集上的表現顯著優于干凈數據集。相比之下,GPT-4在兩個數據集上的表現相當。這表明MathGLM-10B可能對重疊示例過擬合,而污染確實可以提高模型的性能。因此,為了確保模型之間的公平比較,并從FineMath基準測試中得出準確的結論,建議過濾掉訓練集和FineMath基準測試之間的重疊示例。

實驗設計與評估的LLMs

1. 評估的LLMs類別與特點

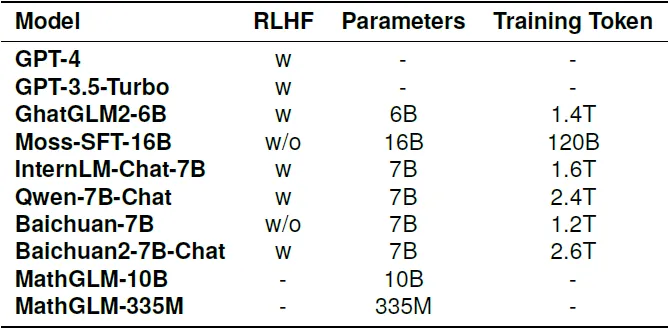

在FineMath上進行的實驗評估了多種LLMs,包括OpenAI開發的GPT-4和GPT-3.5-Turbo,以及專門為中文開發的LLMs和使用中文數學數據微調的LLMs。這些模型的參數范圍從數十億到數千億不等,訓練數據量從數十億到數萬億不等(下表),這些因素都對模型的問題解決和推理能力至關重要。

2. 實驗中使用的提示(Prompts)

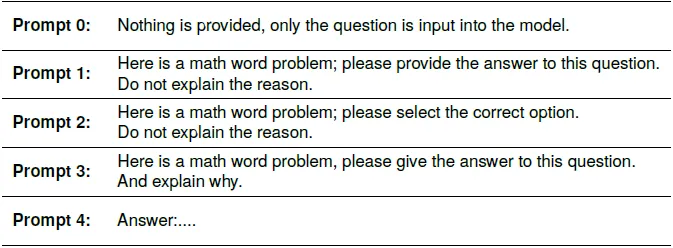

實驗在零樣本設置下進行,研究人員嘗試了多種提示來進行評估和分析。這些提示包括不提供任何額外信息,只輸入問題到模型中;不解釋原因,只提供問題答案;以及提供問題答案并解釋原因等(下表)。

3. 主要結果與不同類別的表現分析

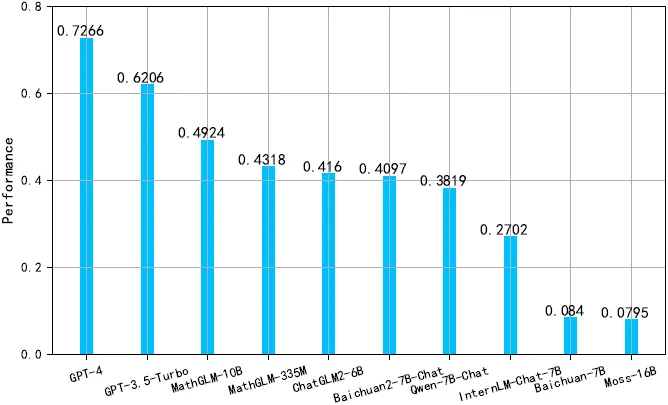

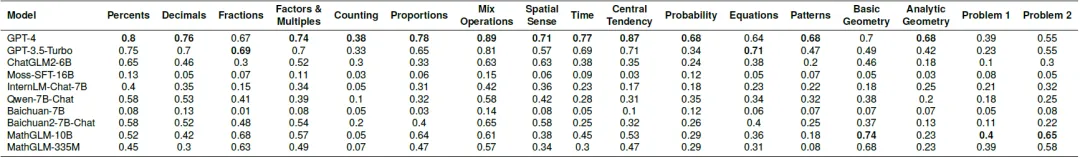

在17個數學應用題類別中,GPT-4在所有模型中表現最佳(下圖),其準確率在不同類別中的表現差異顯著(下表)。例如,在“混合運算”類別中,GPT-4的準確率最高,達到89%,而在“計數”類別中,準確率最低,為38%。GPT-4在概率和解析幾何類別中的表現超過其他所有模型,提高了超過25%。GPT-3.5-Turbo在不同的數學應用題類別中的表現與GPT-4相似,但在概率、基礎幾何和解析幾何上有超過20%的顯著差異。

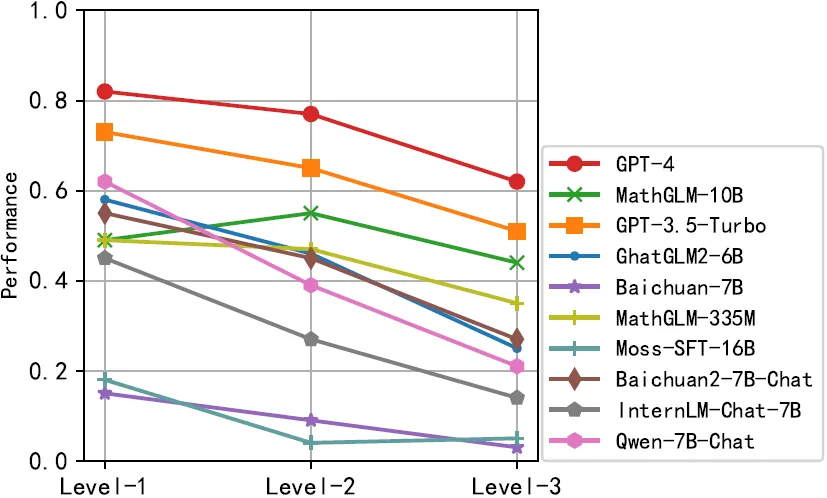

在數學推理步驟數量方面,LLMs的表現隨著推理步驟的增加而降低(下圖)。GPT-4在所有難度級別上保持了超過60%的準確率,對于只需要一個推理步驟的數學應用題,其準確率高達82%。而GPT-3.5-Turbo的準確率平均比GPT-4低10%。其他模型在不同的數學應用題類別和推理步驟數量上的表現也有所不同,顯示出模型在數學推理能力上的差異。

分析:評估過程中的關鍵因素

1. 提示(Prompts)對模型準確性的影響

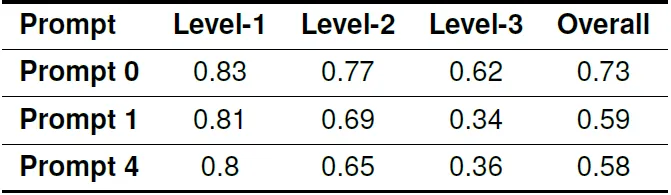

在評估過程中,提示(Prompts)的使用對模型產生的答案準確性有顯著影響。例如,GPT-4在不同提示下的整體準確率分別為73%,59%,和58%(下表),這表明即使是簡單的提示變化也可能導致模型性能的顯著差異。

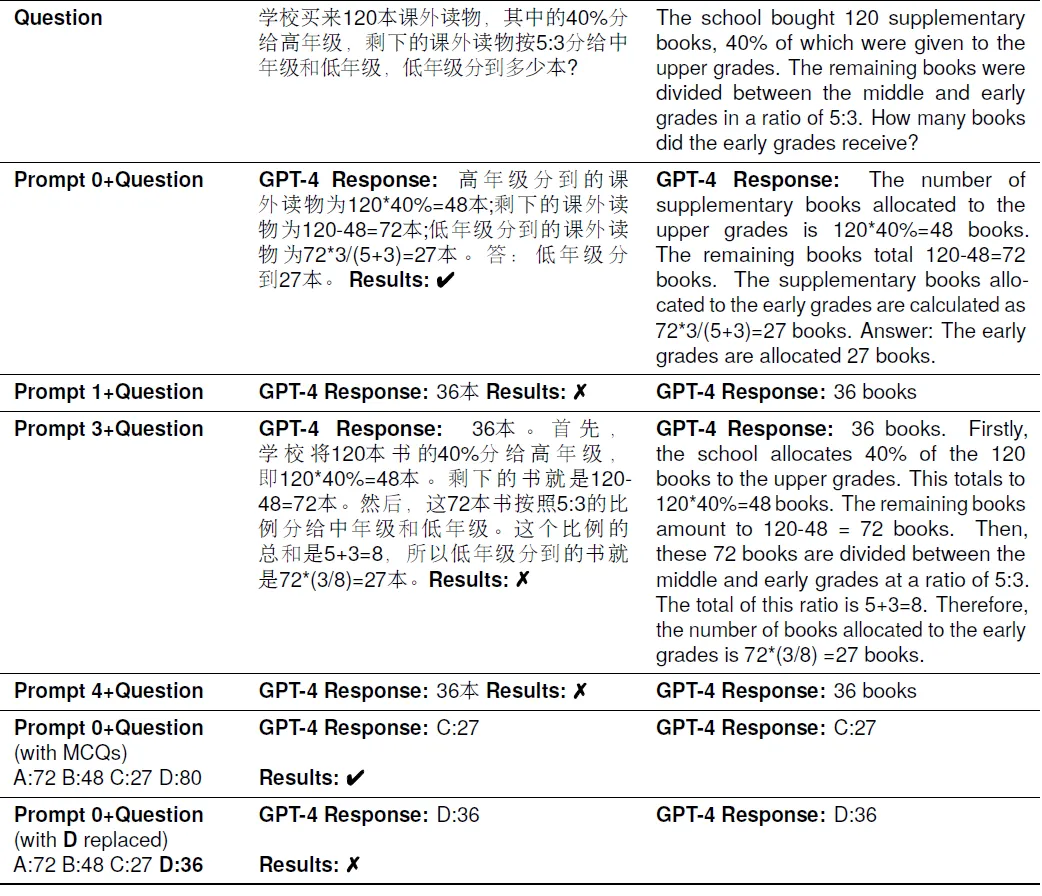

提示如“Answer:”可能會促使模型跳過推理過程,直接輸出答案,從而增加了生成錯誤答案的可能性。下表是示例。

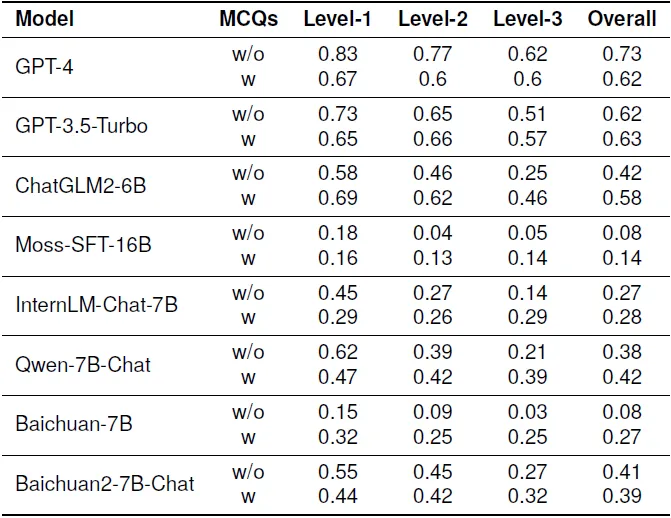

2. 生成式評估與選擇題評估方法的比較

在初步實驗中發現,一些新開發的LLMs不總是遵循指令,經常生成與答案無關的大量文本。因此,將數據轉換為選擇題形式,模型可以從中選擇正確的答案。通過比較(下表),我們發現生成式評估與選擇題評估方法在準確性上存在顯著差異,差距可能超過10%。值得注意的是,將任務結構化為選擇題形式似乎降低了高性能模型的準確性,同時提高了性能較差模型的準確性。選擇題選項本身可能作為一種提示,影響模型的性能。

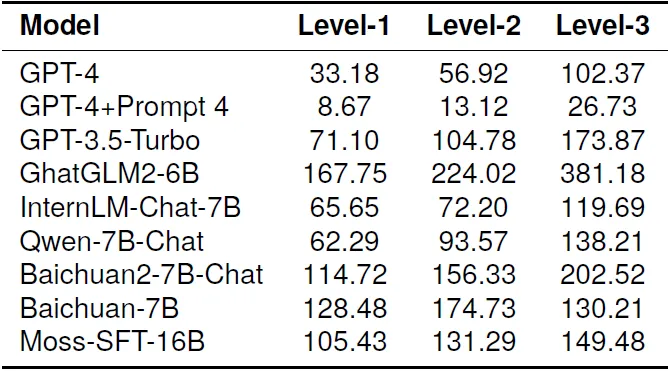

3. 模型響應長度與“信心”的關聯

對模型生成的響應長度進行統計分析時,發現兩個現象(下表)。首先,如GPT-4和GPT-3.5-Turbo這樣的模型傾向于生成緊密圍繞問題的響應,文本較短,這可能表明了高準確性模型的特點。其次,數學問題需要的推理步驟越多,模型生成的響應往往越長。我們推測,模型在回答問題時的“信心”影響了其響應的長度。在某些情況下,即使在指示模型只提供答案而不解釋的情況下,模型仍會為難度較大的問題生成邏輯推理。

結論與展望

FineMath作為一個細粒度的基準測試集,為全面評估中文LLMs的數學能力提供了重要工具。通過對多個LLMs的評估,我們不僅關注模型的準確性,還深入分析了評估過程和方法,揭示了這些經常被忽視的因素對評估結果和我們對模型數學推理能力理解的顯著影響。

FineMath的貢獻在于它提供了一個綜合性的基準,覆蓋了中國小學數學的主要概念,并將數學問題分為17個類別,使得對LLMs的數學推理能力進行深入分析成為可能。此外,FineMath的污染分析使研究人員能夠檢查訓練數據是否影響評估結果,從而確保了評估的公平性和有效性。

未來的研究方向可以包括進一步提高評估方法的公平性和有效性,例如通過更復雜的提示和任務形式來測試模型的推理和理解能力。此外,可以探索如何減少訓練數據中的污染,以及如何提高模型在處理更復雜數學問題時的性能。隨著LLMs的不斷進步,FineMath及其后續版本有望成為評估和提升中文LLMs數學推理能力的重要工具。

本文轉載自夕小瑤科技說,作者:Tscom