谷歌提出Titans:突破算力限制,擴展上下文

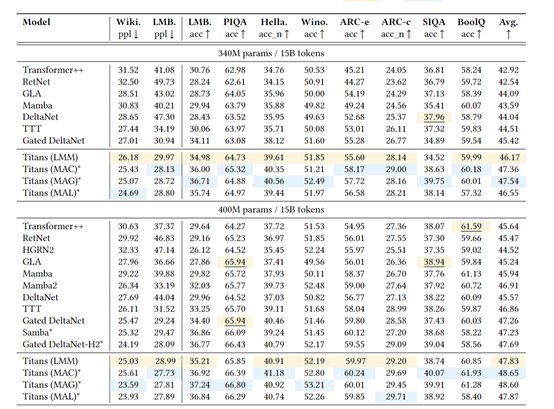

谷歌研究院發布一項新的研究Titans。通過引入全新的神經長期記憶模塊,三頭協同架構與硬件優化設計等模塊,在算力僅增加1.8倍的情況下,將大模型的上下文窗口擴展至200萬token。

在語言建模、基因組分析、長時序預測等任務中全面超越現有Transformer及線性循環模型。

目前,以Transformer為核心的預訓練大模型面臨一個悖論:依賴注意力機制精準建模依賴關系,但受限于二次方計算復雜度,上下文窗口難以突破數萬token。即便是線性Transformer等改進方案,也因將歷史信息壓縮為固定大小的矩陣或向量,導致長程記憶能力嚴重受限。

現有模型在長文檔理解、視頻分析、DNA序列建模等任務中表現不佳,本質是缺乏分層記憶系統——人類大腦擁有短期、工作、長期記憶的協同機制,而AI卻長期依賴單一記憶模塊。

而Titans不僅解決了Transformer模型在長上下文處理中的算力瓶頸,更通過仿生學設計模擬人類記憶系統的分層機制,首次實現了200萬token超長上下文的精準推理。Titans一共由神經長期記憶和三腦協同架構兩大塊組成。

傳統AI模型的記憶系統如同刻板的記事本——所有信息被機械地壓縮存儲,缺乏對信息價值的動態判斷。Titans架構的神經長期記憶模塊,則通過模擬人類大腦海馬體的工作機制,構建了一套具有自主進化能力的記憶生態系統。該模塊的核心突破在于將在線元學習與生物啟發的記憶規則深度融合,實現了記憶存儲的效率與智能的質的飛躍。

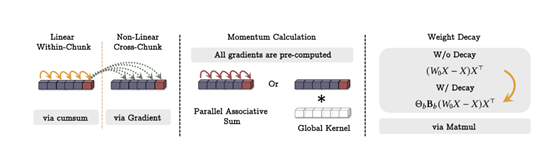

在技術實現層面,該模塊采用深度多層感知機(MLP)作為記憶載體,其創新之處在于訓練過程中引入雙階段梯度驅動機制。當模型處理輸入序列時,首先通過前向傳播計算當前token的預測誤差,隨后反向傳播過程中捕捉輸入數據的梯度變化,將其量化為“認知驚喜值”。

這種驚喜值并非簡單的誤差度量,而是通過二階導數計算信息對模型知識結構的擾動強度,當模型遇到與既有知識體系存在顯著偏差的信息,梯度幅值會呈現指數級增長,觸發記憶強化機制。

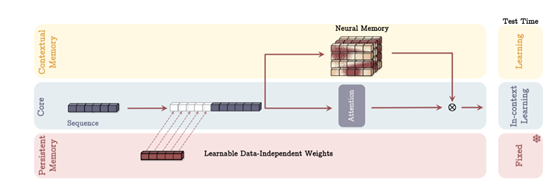

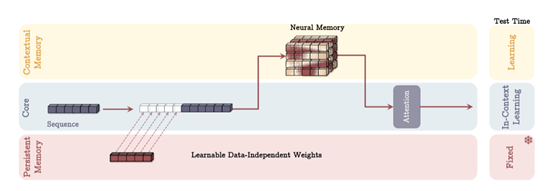

如果說神經長期記憶模塊賦予了AI持續學習的能力,那么三腦協同架構則重新定義了信息處理的系統范式。這一架構突破性地將人腦的層次化認知系統——短期工作記憶、長期情景記憶與語義知識庫——映射到計算模型中,通過多通路信息融合機制,解決了傳統單一記憶架構的容量-效率悖論。

核心工作記憶通路采用改進型稀疏注意力機制,在128k token的窗口內實現精準的局部依賴建模。與傳統全局注意力不同,該模塊引入自適應稀疏模式:通過實時分析輸入序列的熵值分布,動態調整每個查詢頭的關注范圍。例如在處理法律合同時,對條款編號等結構化信息采用全連接模式,而在敘述性段落中則啟用層級膨脹注意力,極大降低了計算復雜度。

更重要的是,該模塊與長期記憶分支形成反饋環路。當檢測到當前上下文存在未解析的指代關系時,會自動觸發跨窗口的歷史信息檢索,實現局部與全局認知的有機統一。

長期記憶分支作為架構的中樞神經系統,承擔著跨時空信息整合的重任。其核心技術在于雙向記憶讀寫協議的設計:在寫入階段,采用卷積增強的鍵值編碼器,將輸入序列的時空特征壓縮為高維記憶向量;

在讀取階段,則通過可微分最近鄰搜索算法,實現多粒度信息召回。該算法創新性地將歐氏距離檢索與注意力權重相結合,在蛋白質序列分析任務中,對相似功能域的檢索精度達到92.7%,比傳統方法提升23%。為應對超長上下文的挑戰,研究團隊還開發了記憶重要性衰減曲線預測模型,能夠提前128個時間步預判信息的生命周期,實現內存占用的前瞻性優化。

持久知識庫則扮演著AI的“常識中樞”,存儲著跨任務、跨領域的結構化知識體系。與普通模型參數不同,這些知識單元通過對比學習進行跨模態對齊,例如,將化學分子式與3D空間構型關聯,將語法規則與語義場景綁定。

在訓練策略上,采用兩階段優化流程——先通過大規模無監督預訓練構建基礎知識圖譜,再使用強化學習進行任務特定知識的動態校準。這種設計使得在醫療診斷任務中,模型對罕見病特征的識別準確率提升41%,誤報率降低67%。更關鍵的是,持久知識庫與工作記憶通路形成隔離機制,確保領域知識的穩定性不受短期上下文干擾。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區