高效注意力機制與硬件優化:硬件優化的稀疏注意力,長上下文建模

研究背景與意義

在當今的語言模型研究中,長上下文建模被廣泛認為是提升模型能力的關鍵。然而,傳統的注意力機制在處理長序列時,計算復雜度高,導致顯著的延遲和資源消耗。研究者們逐漸意識到稀疏注意力機制可能是解決這一問題的有效途徑。本文提出了一種名為“Native Sparse Attention(NSA)”的機制,旨在通過算法創新與硬件優化的結合,實現高效的長上下文建模。

研究背景

- 長上下文建模的重要性:隨著應用需求的多樣化,長上下文建模成為語言模型發展的重要方向。

- 現有挑戰:傳統的全注意力機制在長序列處理時面臨高計算成本,限制了模型的實用性。

研究意義

- 效率提升:NSA機制通過動態分層稀疏策略,結合粗粒度和細粒度的令牌選擇,旨在在保持模型性能的同時顯著提高計算效率。

- 創新點:該研究的創新點在于實現了端到端的訓練,減少了預訓練計算,同時保持了模型的性能。

研究方法與創新

NSA機制的核心在于其獨特的算法設計與硬件優化,主要體現在以下幾個方面:

1. 動態分層稀疏策略

- 粗粒度令牌壓縮:將輸入序列分塊處理,通過聚合相鄰令牌的信息,減少計算量。

- 細粒度令牌選擇:在壓縮的基礎上,選擇最重要的令牌進行精細計算,確保模型能夠關注到重要信息。

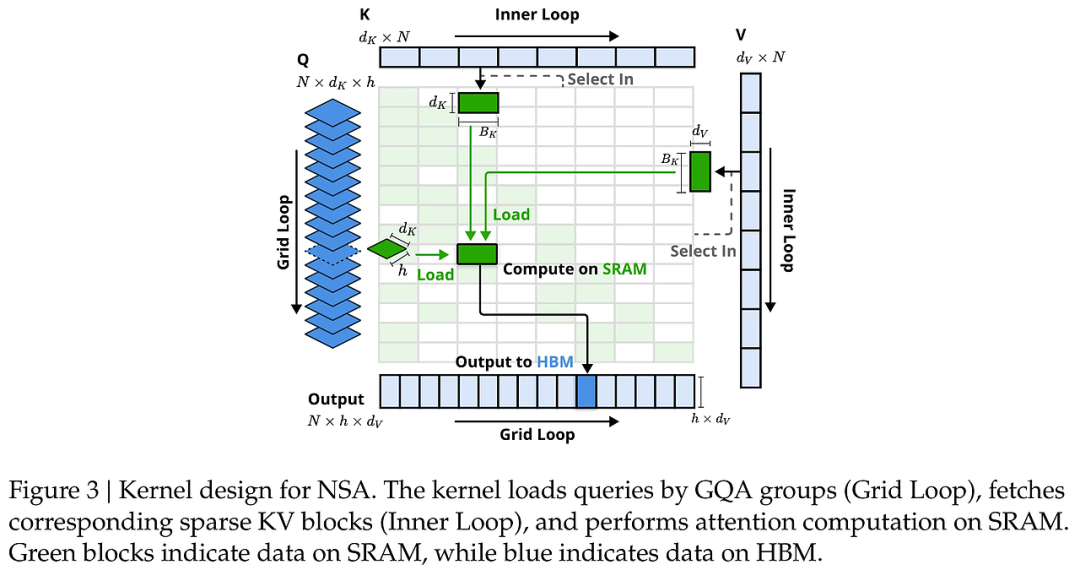

2. 硬件優化

- 算法與硬件對齊:針對現代硬件進行優化,確保算法設計能夠充分利用硬件的計算能力,減少內存訪問延遲。

- 平衡算術強度:通過平衡計算與內存訪問,優化模型的整體性能。

3. 端到端訓練

- 訓練感知設計:NSA支持端到端的訓練,使得模型在訓練過程中能夠動態調整稀疏模式,提升學習效率。

實驗設計與結果分析

在實驗中,NSA在多個基準測試中表現出色,尤其是在長上下文任務和推理評估中。

實驗設計

- 數據集:使用27B參數的Transformer骨干網絡,進行260B詞元的預訓練。

- 性能評估:在長上下文任務和鏈式推理任務中,與傳統的全注意力模型進行對比。

結果分析

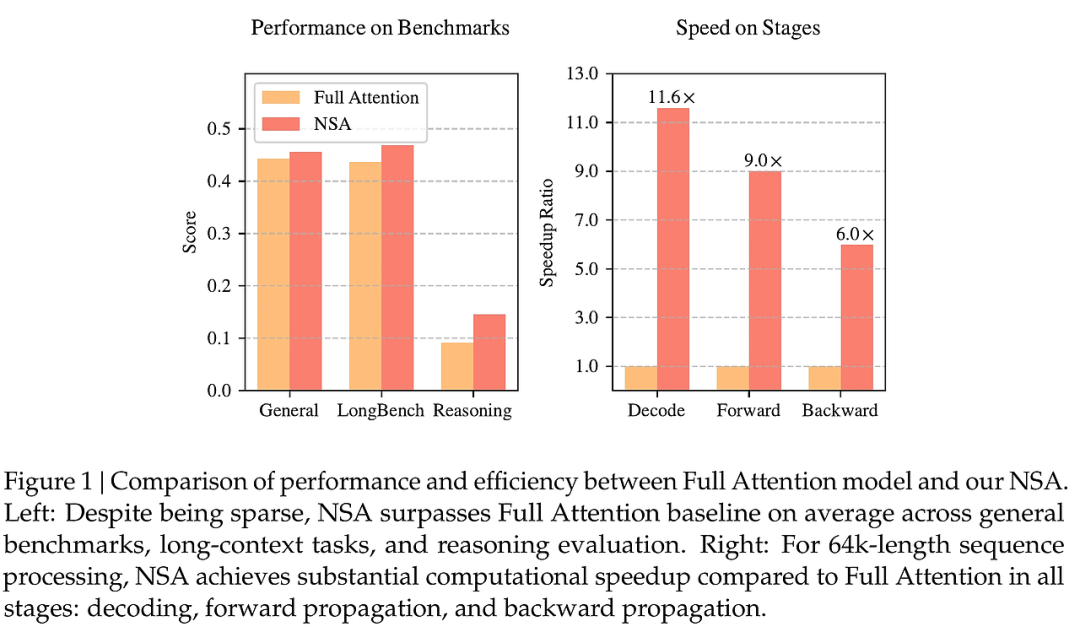

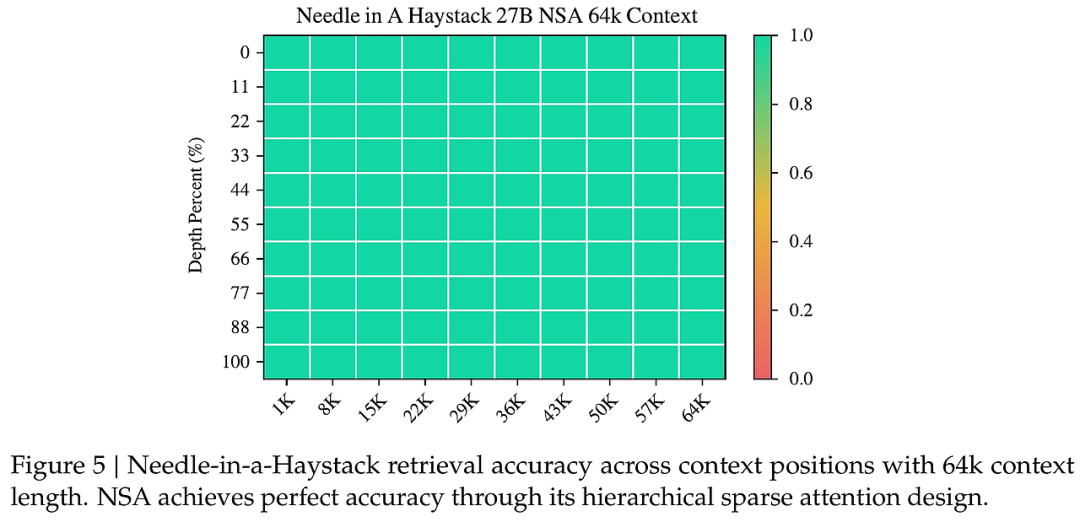

- 性能對比:實驗結果表明,NSA在多個基準測試中超越了全注意力模型,尤其是在長序列處理上表現出更高的計算效率和準確性。

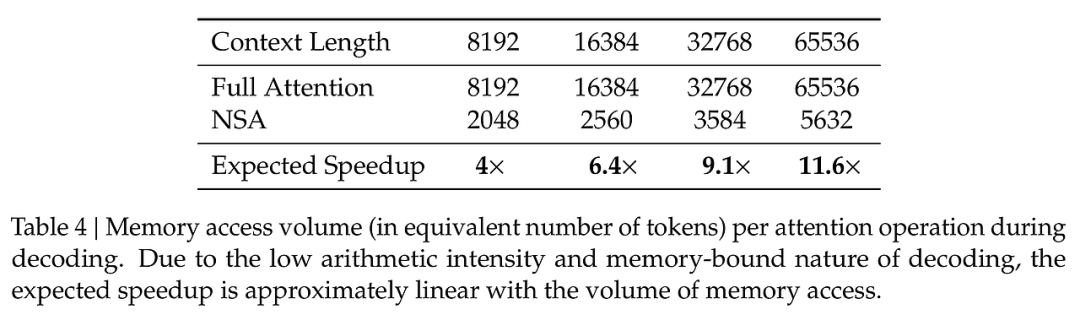

- 計算速度:NSA在解碼、前向傳播和反向傳播階段均實現了顯著的速度提升,驗證了其在實際應用中的有效性。

結論與展望

本文提出的NSA機制在長上下文建模中展現了優越的性能,其創新的稀疏注意力設計有效平衡了模型能力與計算效率。盡管取得了一定的成果,但仍需進一步探索在更復雜任務中的應用潛力。未來的研究可以集中在以下幾個方面:

- 更廣泛的應用場景:探討NSA在多輪對話、代碼生成等領域的適用性。

- 算法優化:繼續優化算法以適應不斷變化的硬件環境,提高模型的靈活性與適應性。

通過這些探索,NSA有望在未來的語言模型研究中發揮更大的作用。

本文轉載自 ??AI研究前瞻??,作者: 胡耀淇

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦