DeepSeek-R1 + RooCline:極佳的強化學習AI編碼代理!對標o1、蒸餾小模型本地部署

Hi,這里是Aitrainee,歡迎閱讀本期新文章。

Deepseek R1正式發布。不是之前的Light版本,而是完整的R1。

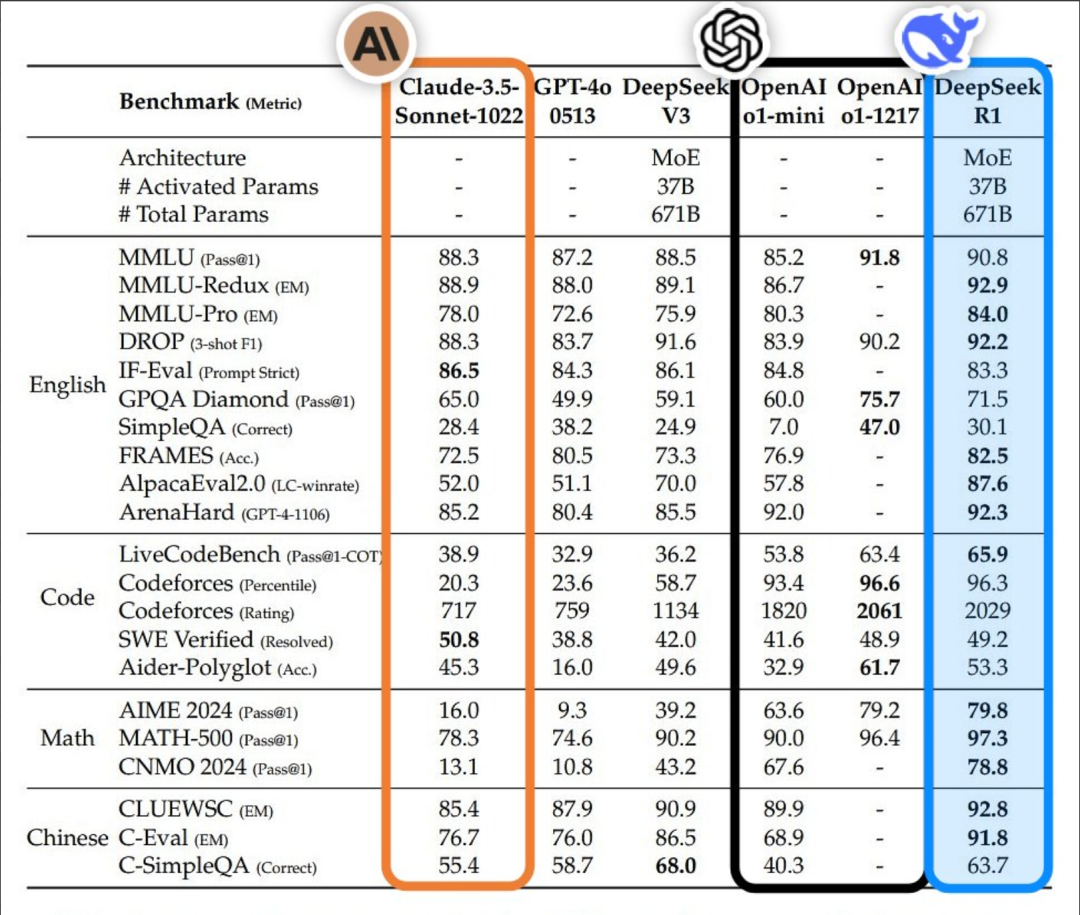

性能與o1相當,還采用MIT開源協議,可以商用。現在能在Deepseek chat平臺用,也提供API。

模型分兩個版本:主力R1,和面向研究的R1-Zero。

R1-Zero沒有監督微調,直接RL,是一個未經過對話偏好對齊監督微調的版本,專門為研究人員或希望自行微調模型的人提供。

正式發布的R1還是用了SFT階段。

R1是671B參數的大模型,激活參數只有37B,基于Deepseek V3訓練。特別強化了思維鏈和推理能力。

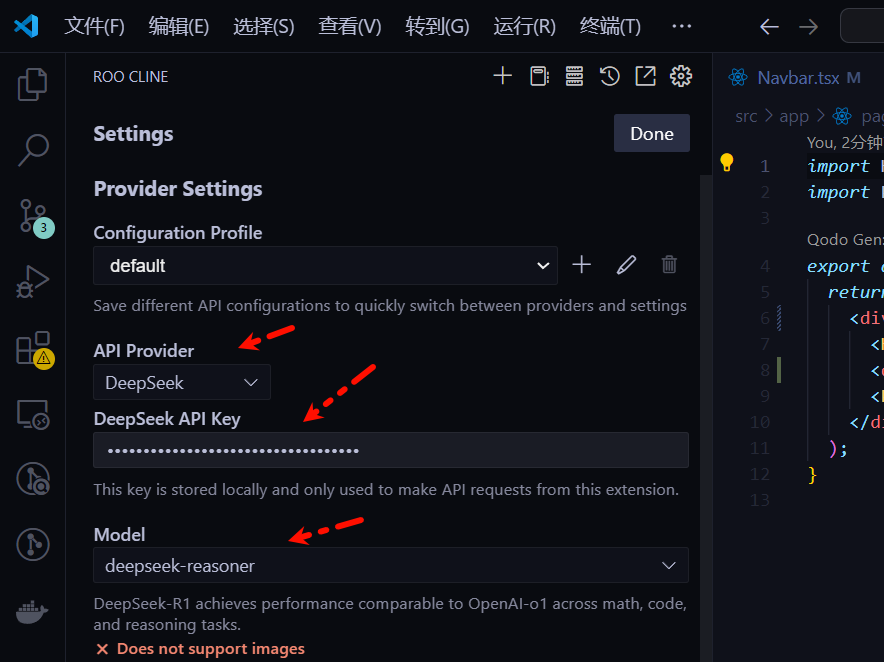

現在Cline或者Roocline中可以直接使用R1了。API獲取:???https://platform.deepseek.com/usage??

在Roocline中這樣設置:

Roocline是什么?看這里:

??全新免費的 RooCline 超越了Cline v3.1 ?!更快、更智能、更出色的Cline分叉!(自主AI編程、0門檻)??

作為測試,我們用前面寫過一篇文章《??從0到1用AI做了個AI服務網站, 全程沒寫一行代碼??》,把開頭的那個三合一提示詞扔給他:

讓他創建一個Saas網站原型。那么提示詞比較長,可以通過上面這篇文章獲得。

挺不錯的,Saas框架、前后端、登陸注冊、生圖都還可以。

其次,這是它在Cline中速度、消耗表:

youtube@WorldofAI

Deepseek官網直接Chat使用:

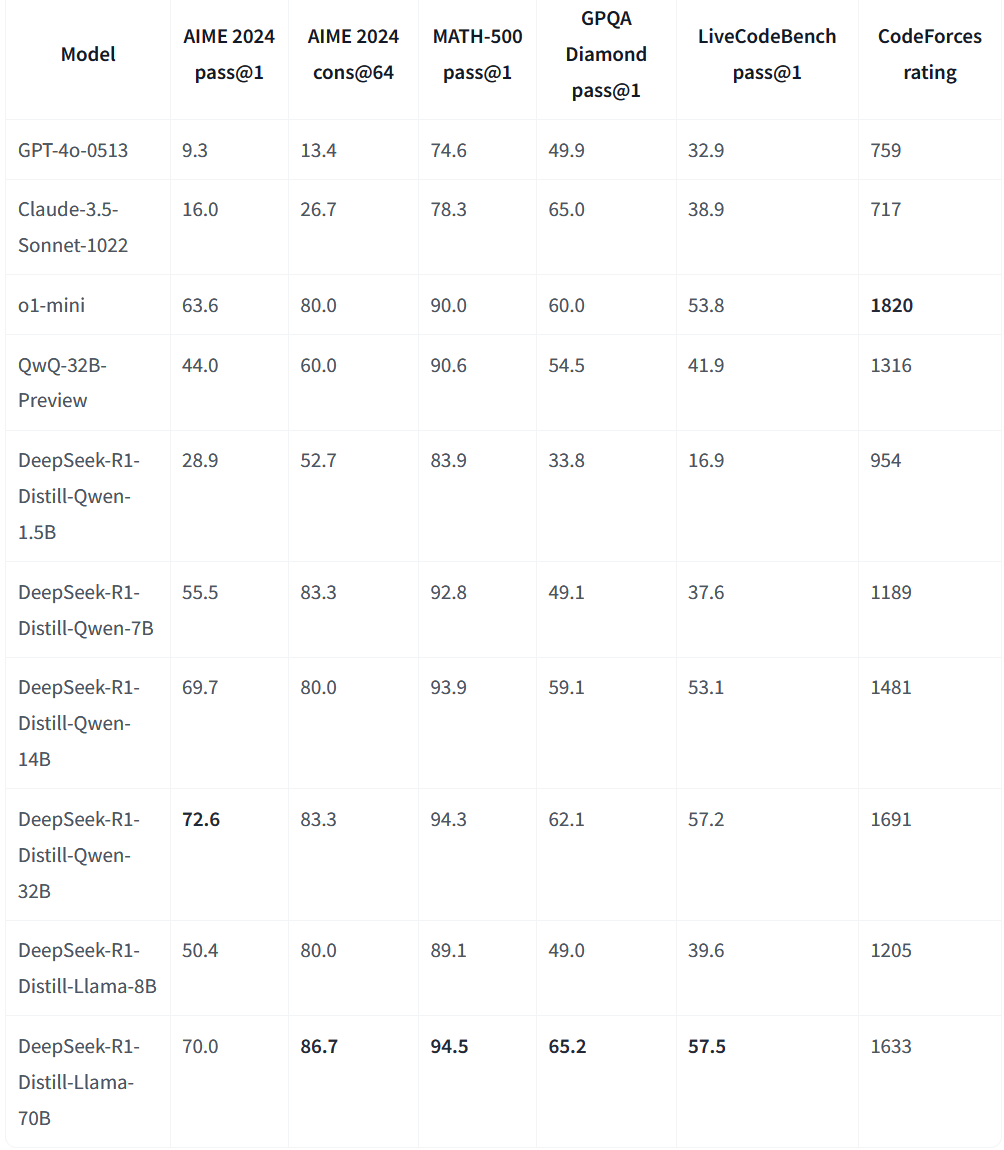

此外,還有6個蒸餾小模型:Qwen 1.5B、7B,Llama 8B,Qwen 14B、32B,還有Llama 系列。

這些微調模型使用由DeepSeek-R1生成的樣本進行訓練,這大大降低了思考模型的構建門檻。

這個操作很暖心,讓不同需求的用戶都能用上,從筆記本到服務器,都能找到合適的版本。

測試結果超出預期,最強的是Llama-70B。GPQA Diamond 65.2,比Claude 3.5還高。編程上,LiveCodeBench 57.5,CodeForces 1633,幾乎能和o1-mini比肩。

Ollama已經可以部署了,很快也能用VLLM本地運行。

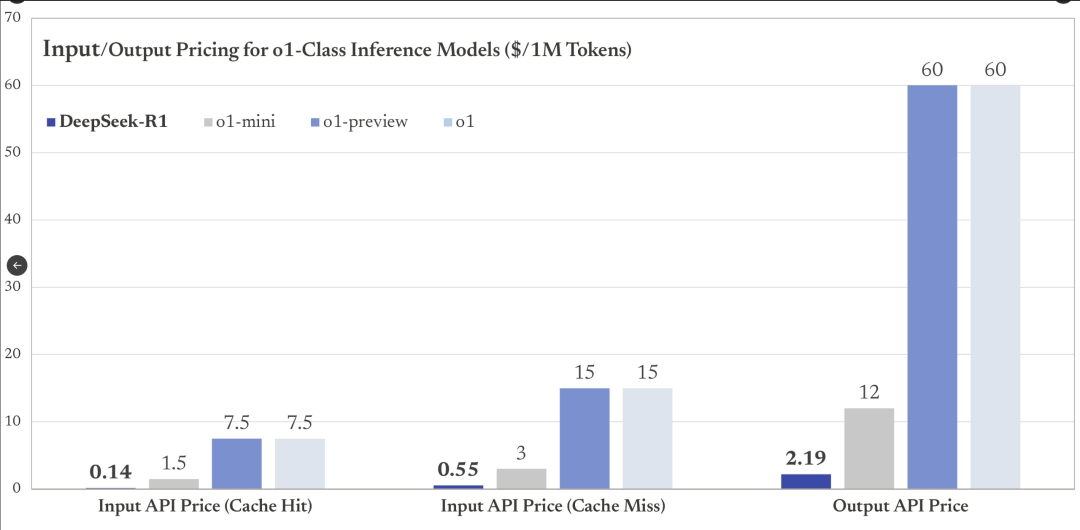

R1價格很友好。API收費:輸入每百萬token 0.14美元(緩存命中),0.55美元(緩存未命中),輸出2.19美元。對比o1:輸入15美元,輸出60美元。

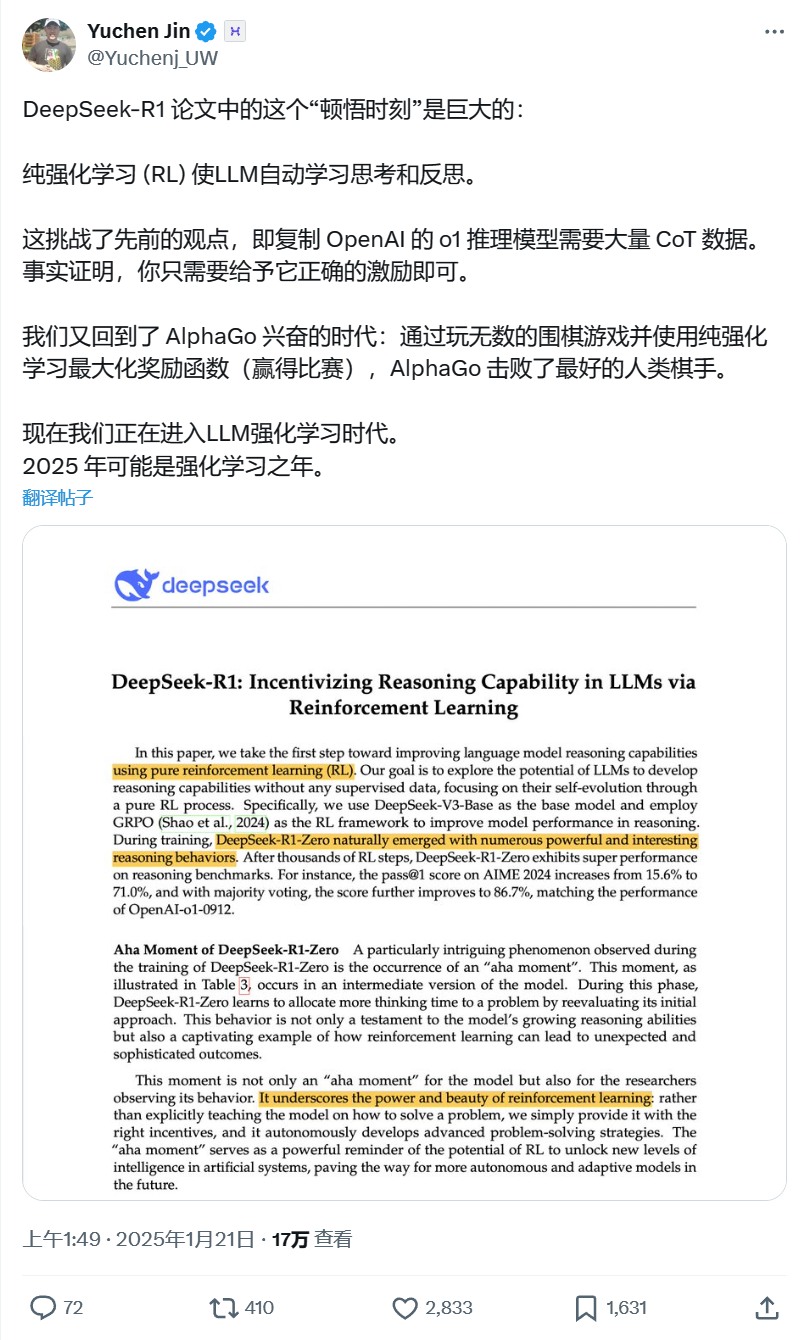

再說完全靠強化學習,不需要監督微調這一條:

用硬編碼規則計算獎勵,而非使用學習型的獎勵模型。學習型獎勵模型可能會被強化學習策略“利用”或“作弊”,導致優化的結果偏離預期目標。就像AlphaZero,從零開始學習,不靠模仿人類。

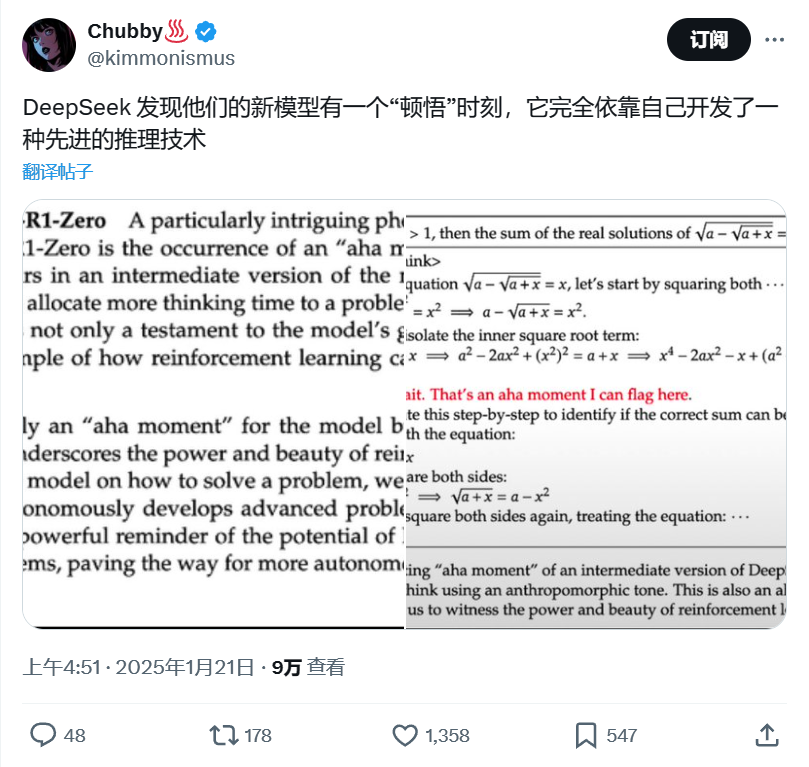

訓練過程中有意思的發現:模型的思考時間會自然增長,這不是預設的,是自發形成的。模型逐漸學會為復雜問題花費更多時間進行思考,體現出類似于“自我反思”和“探索行為”的能力。

這是高級智能行為的一種表現,表明模型具備了更深層次的推理能力。這種未被明確編碼的能力,屬于智能的“涌現特性”(emergent behavior)。

他們發明的GRPO比PPO更簡單:去掉critic網絡,用多個樣本的平均獎勵代替,簡化了內存使用。這個方法,是他們2024年2月才提出的。

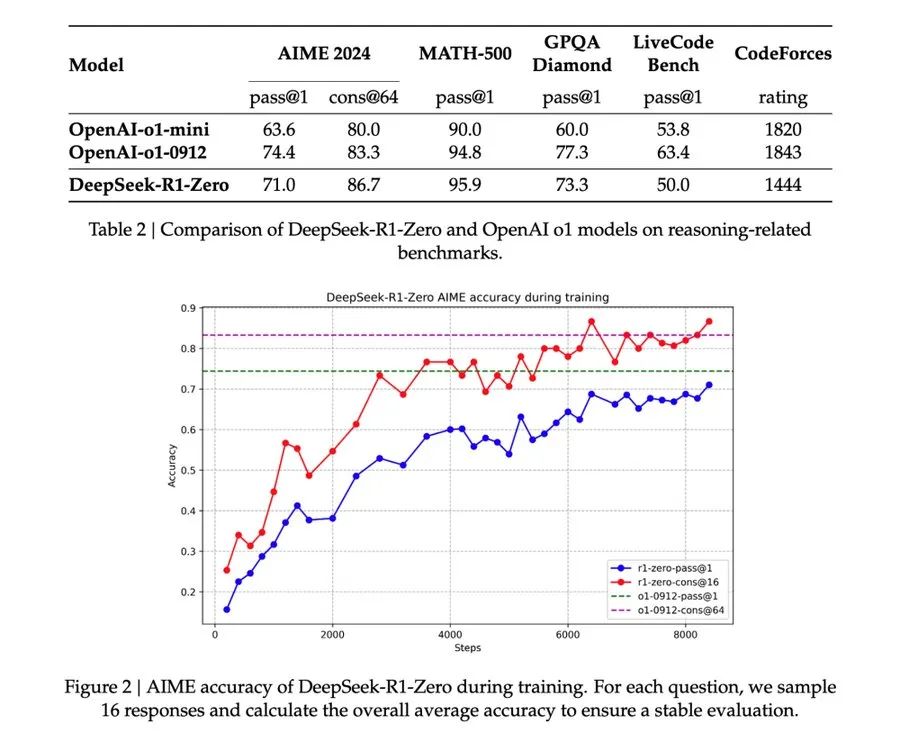

DeepSeek-R1-Zero的測試結果很有意思。

只靠強化學習,在AIME 2024上得到71.0分,MATH-500達到95.9分。雖然比o1-0912略低,但差距并不大。

特別是在MATH-500上,R1-Zero的95.9分超過了o1-mini的90.0分。這說明純RL訓練的模型,也能掌握復雜的數學推理。

LiveCode Bench上得到73.3分,比o1-mini的60.0分高出不少。

這個結果很重要:它證明了,不需要大量標注數據,單靠強化學習,AI也能學會思考和推理。這可能會改變我們訓練AI的方式。

R1,僅用幾個月就達到了閉源大廠的水平,還提供了更實惠的價格。

最后,據官方所述,DeepSeek-R1還有幾個地方需要提升,他們將繼續努力:

通用能力上,函數調用、多輪對話、角色扮演和JSON輸出,都不如V3版本。團隊打算用長鏈推理來改進。

語言處理有點意思。現在主要針對中英文優化,其他語言容易混雜。比如用德語問,它可能用英語想,再用德語答。

提示詞很敏感。少樣本提示反而會影響性能,建議直接描述問題和輸出格式,效果更好。

軟件工程任務上,評估太慢影響了RL訓練。計劃用拒絕采樣或異步評估來提速。

本文轉載自 ??AI進修生??,作者: Aitrainee