DeepSeek的三種接入使用方法 原創

前言

DeepSeek作為國產頂尖大模型,在代碼生成和邏輯推理方面表現優異。本文提供三種不同場景下的接入方案,滿足從普通用戶到開發者的不同需求。

當前問題

由于訪問量激增和網絡攻擊,官網服務可能出現不穩定。本文提供三種備用接入方案:

方法一:使用??chatbox+硅基流動??接入云端API使用(適合于普通用戶使用)

方法二:使用??Cursor+硅基流動??接入云端API使用(適合于程序員人群)

方法三:使用??ollama本地化部署??使用(適用于有安全隱私需求的用戶)

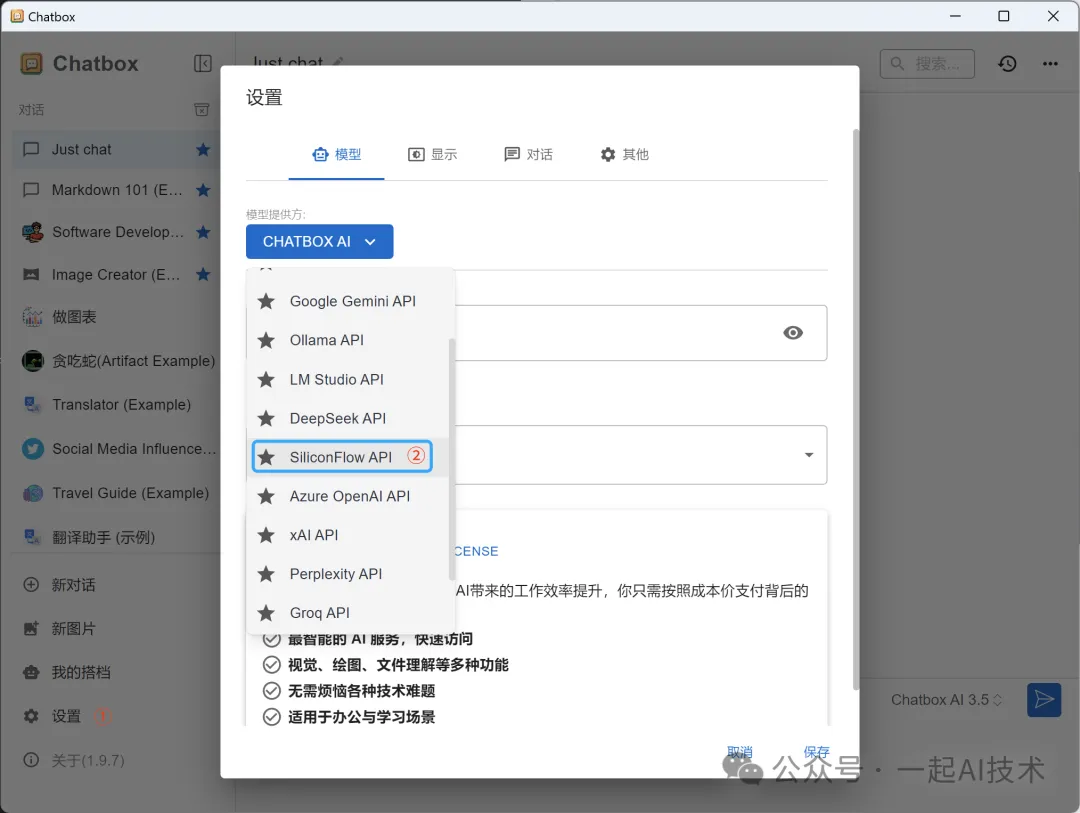

方法一:使用chatbox+硅基流動接入云端API使用

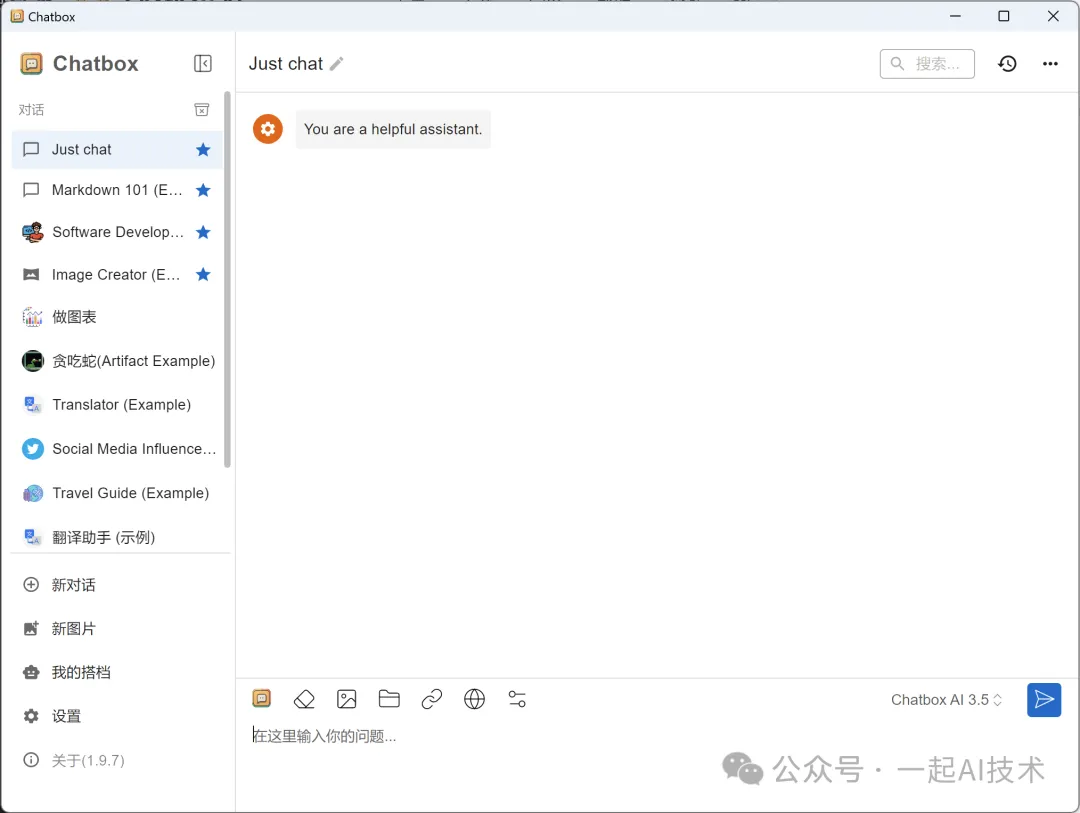

1. 安裝chatbox

下載對應版本并安裝chatbox

說明:

- 本例中以Windows為例,其他平臺請參考官網

2. 注冊硅基流動賬號

訪問硅基流動官網 ??https://siliconflow.cn/m??

完成注冊和實名認證

說明:硅基流動現在注冊并實名認證后,會贈送14元金額試用。

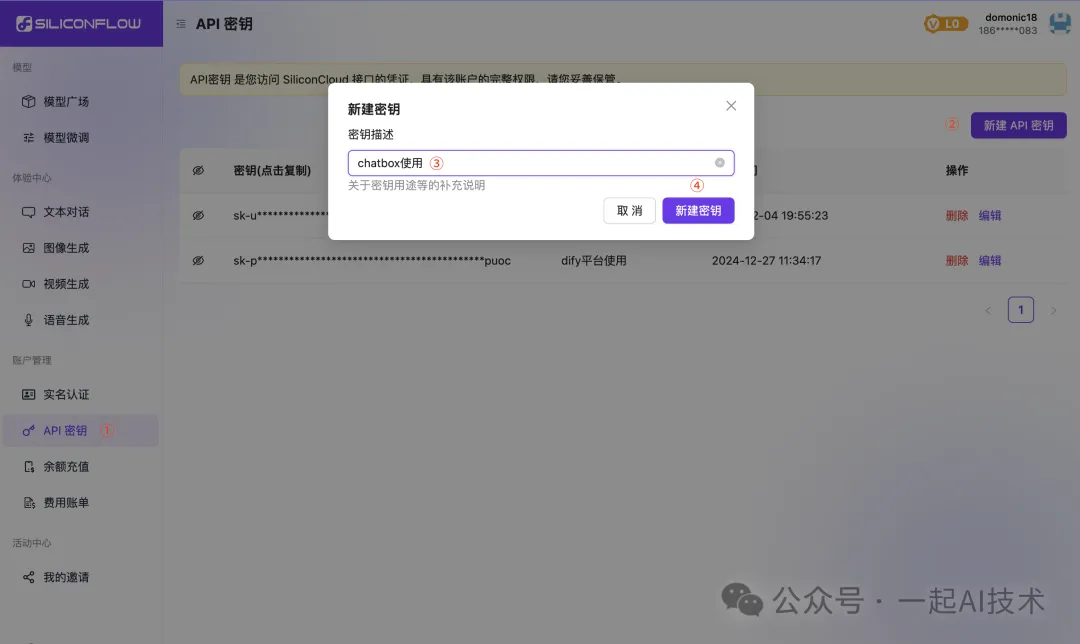

3. 獲取API Key

登錄后,點擊左側菜單欄的「API密鑰」

選擇「API密鑰」->「新建API密鑰」

輸入密鑰描述內容后,點擊「新建密鑰」

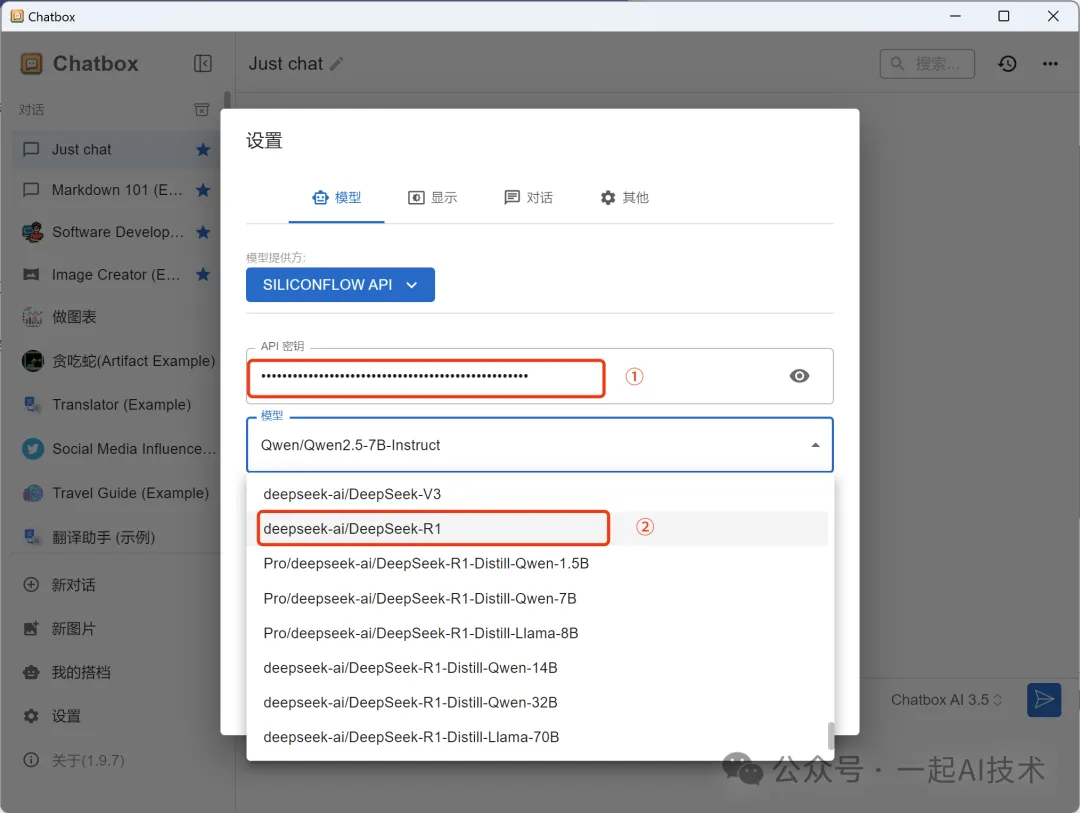

4. 配置chatbox

設置 -> 模型提供商 -> 選擇「SiliconFlow API」

在API密鑰框,將上一步獲取的API Key填入「API 密鑰」

在模型框,選擇「deepseek-r1」后,點擊

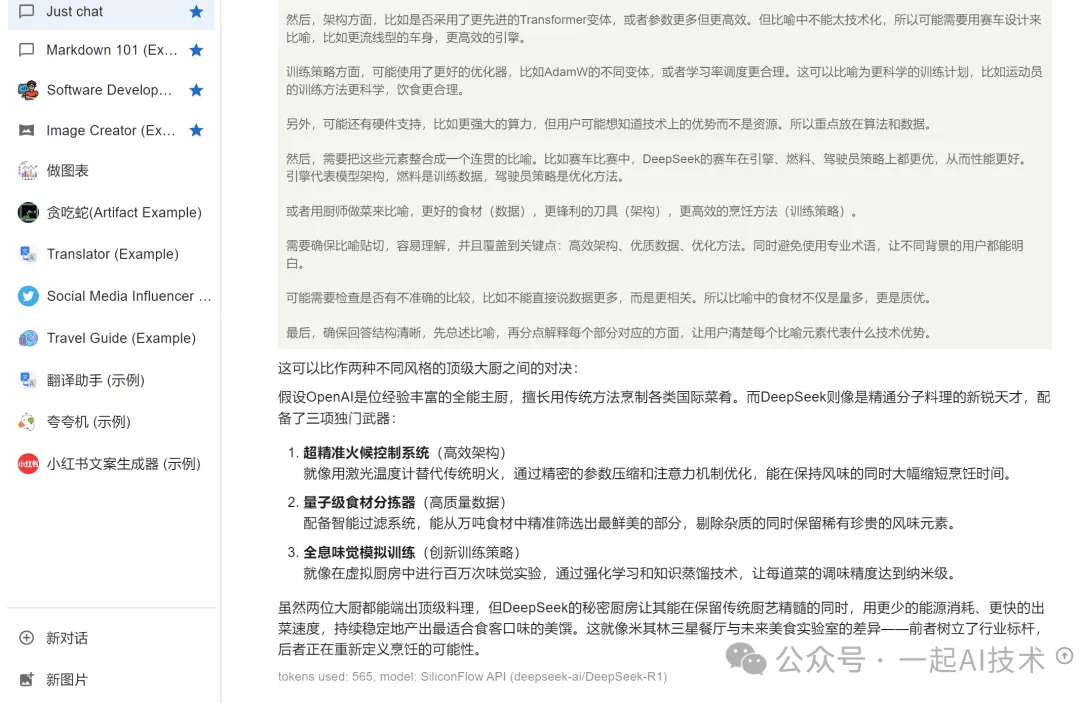

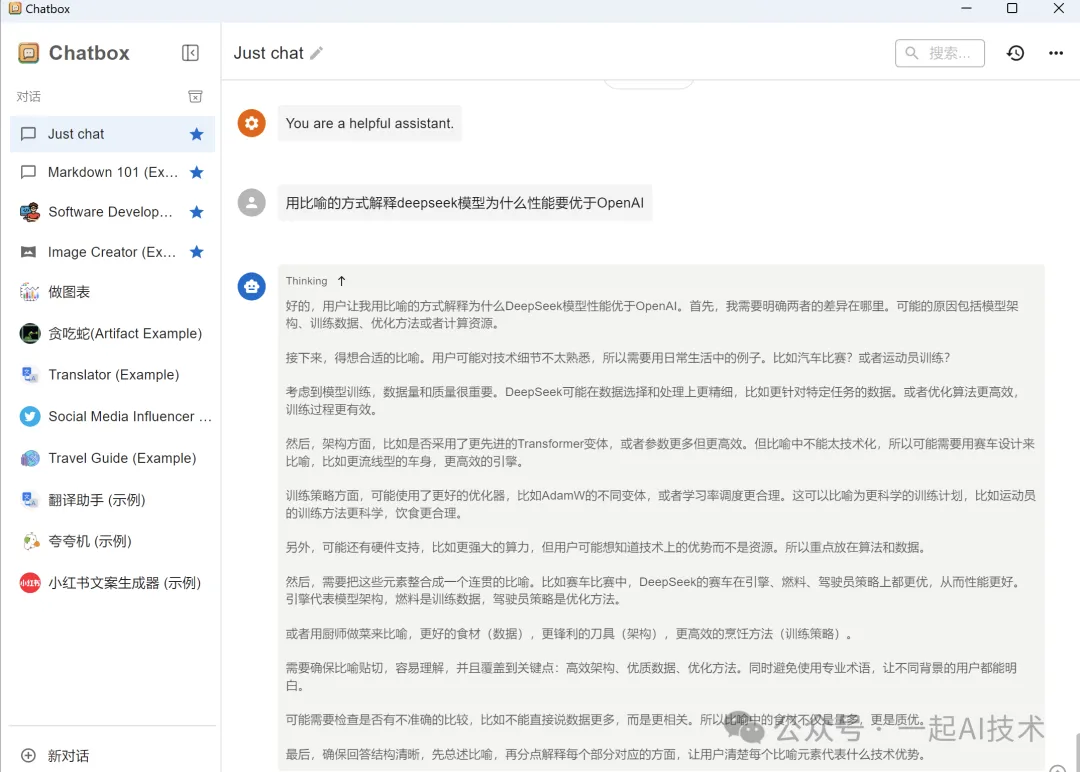

5. 測試模型效果

輸入測試問題:"用比喻的方式解釋deepseek模型為什么性能要優于OpenAI"

方法二:使用cursor+硅基流動接入云端API使用

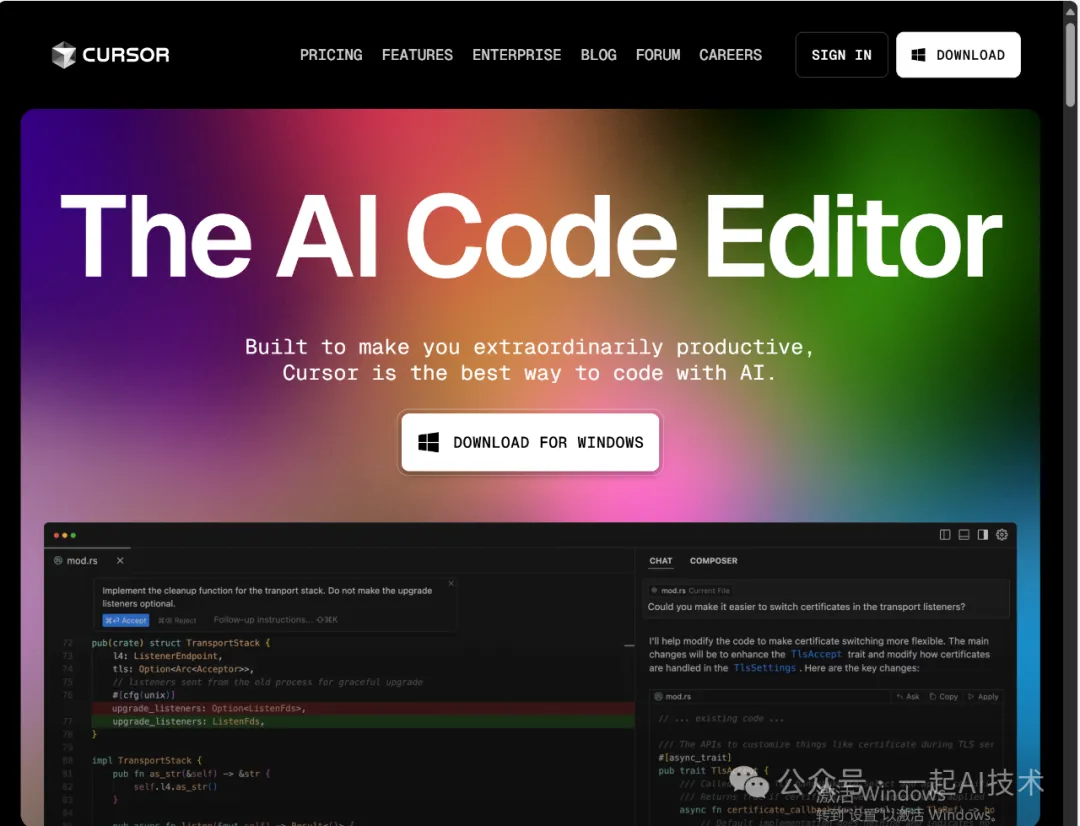

1. 安裝cursor

- 訪問 https://www.cursor.com/

- 下載并安裝IDE

- 注冊cursor賬號

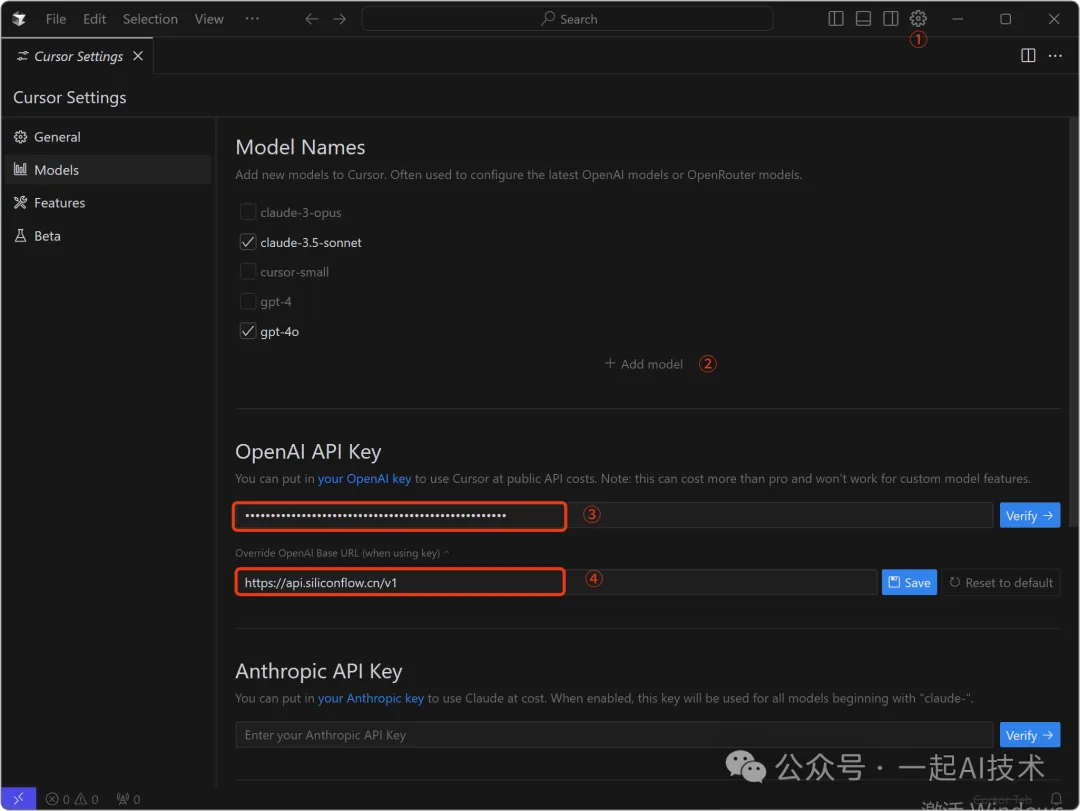

2. 配置硅基流動API

- 打開Cursor設置對話框

- 左側選擇Models

- 在OpenAI API Key框,填入硅基流動上創建的API Key

- 在OpenAI Base URL框,填入?

?https://api.siliconflow.cn/v1??并保存 - 點擊Add Model,輸入?

?deepseek-ai/DeepSeek-R1?? - 點擊Verify,驗證模型是否可用

說明:

- 硅基流動的API Base URL可以在硅基流動官網的模型廣場,選擇對應的模型查看其API文檔獲得。

- 模型名稱?

?deepseek-ai/DeepSeek-R1??可以在硅基流動的模型廣場中,選擇對應的模型后直接復制獲得。

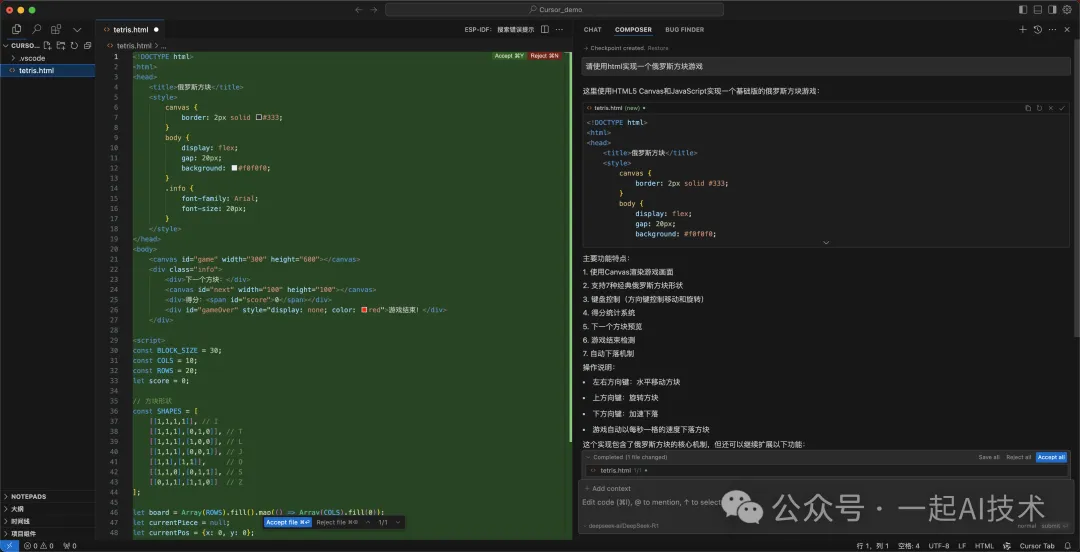

3. 測試代碼功能

- 使用cursor創建一個新的項目,例如"俄羅斯方塊游戲"

- 使用快捷鍵?

?Cmd/Ctrl+I??打開Composer界面 - 輸入我們的需求后回車,例如:"請使用html實現一個俄羅斯方塊游戲"

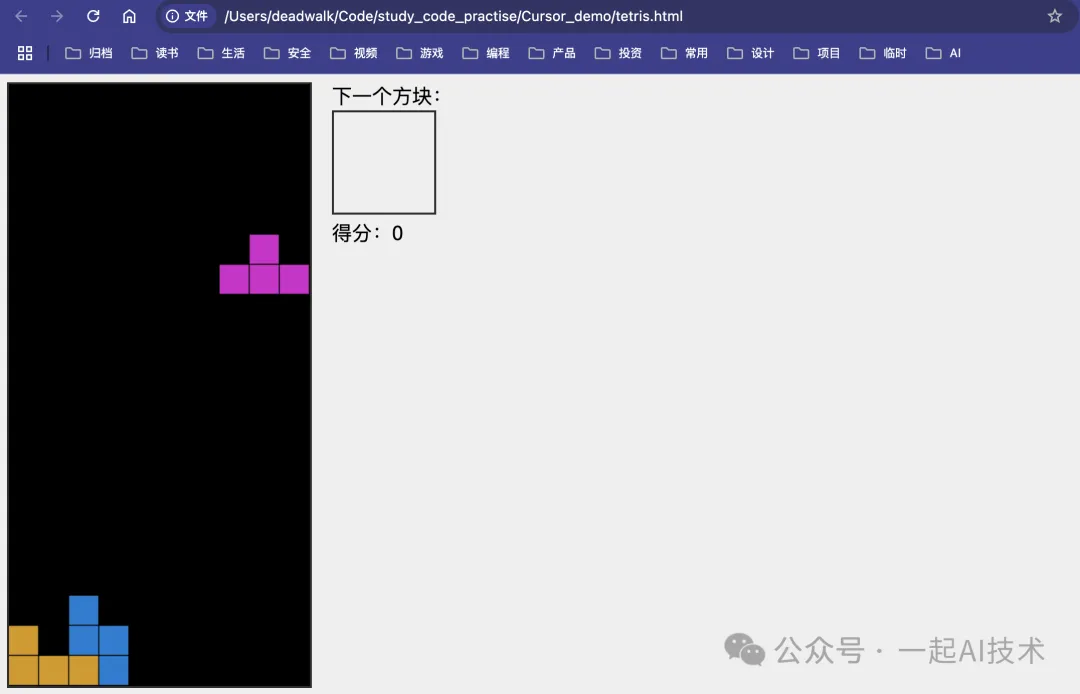

- Cursor會調用硅基流動的DeepSeek-R1模型,自動生成俄羅斯方塊游戲,如下圖:

- 使用瀏覽器打開生成的tetris.html文件,即可看到俄羅斯方塊游戲,如下圖:

備注:

- Cursor有14天的試用期,試用期結束后需要購買訂閱才能繼續使用。

- 經過實測,使用Cursor內置的DeepSeek-R1模型會比硅基流動API的DeepSeek-R1模型速度會更快。

方法三:使用ollama本地化部署使用

1. 硬件配置

模型規模 | 使用場景 | CPU核心 | 內存容量 | 顯卡型號 | 顯存需求 | 推薦部署方式 |

1.5B | 嵌入式設備 | 4核 | 8GB | Jetson Orin | 6GB | 4-bit量化+TensorRT加速 |

7B | 個人開發/測試 | 8核 | 32GB | RTX 3060 | 14GB | FP16精度+單卡推理 |

70B | 企業級服務 | 32核×4 | 512GB | A100 80G ×4 | 320GB | 張量并行+流水線并行 |

671B | 超大規模計算 | 64核×8 | 2TB | H100 80G ×16 | 1.28TB | 混合并行+專家并行 |

注明:

- 顯存預估方式一般為:模型參數×2.5(如7B模型需7×2.5=17.5GB,需RTX 3090 24GB)

- 本例中,筆者使用的是RTX 4080顯卡16G顯存,所以選擇7B模型。

2. 安裝ollama

訪問ollama官網 https://ollama.com/

根據系統選擇對應的安裝方式

# Windows用戶:訪問 https://ollama.com/download/windows 下載安裝包

# Mac用戶:訪問 https://ollama.com/download/mac 下載安裝包

# Linux用戶:執行

curl -fsSL https://ollama.com/install.sh | sh說明:

- 本例中以Windows為例,其他平臺請參考官網

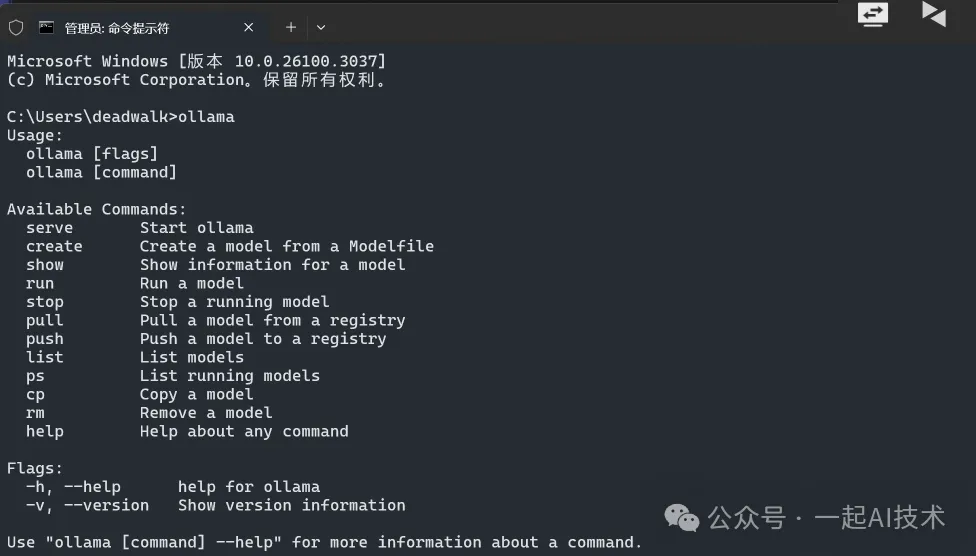

- 安裝完成后,在命令行中輸入ollama可以看到命令行幫助文檔

3. 配置ollama的下載路徑

因為ollama默認下載路徑為??C:\Users\用戶名\.ollama??,所以我們需要配置ollama的下載路徑,避免C盤占用過大。

在??系統設置→搜索"環境變量"→高級系統設置→添加系統變量??中新增Ollama的下載路徑

變量名:OLLAMA_MODELS

變量值:G:\ai_LLMs_modules\Ollama說明:變量值請根據自己的情況修改,本例中是?

?G:\ai_LLMs_modules\Ollama??

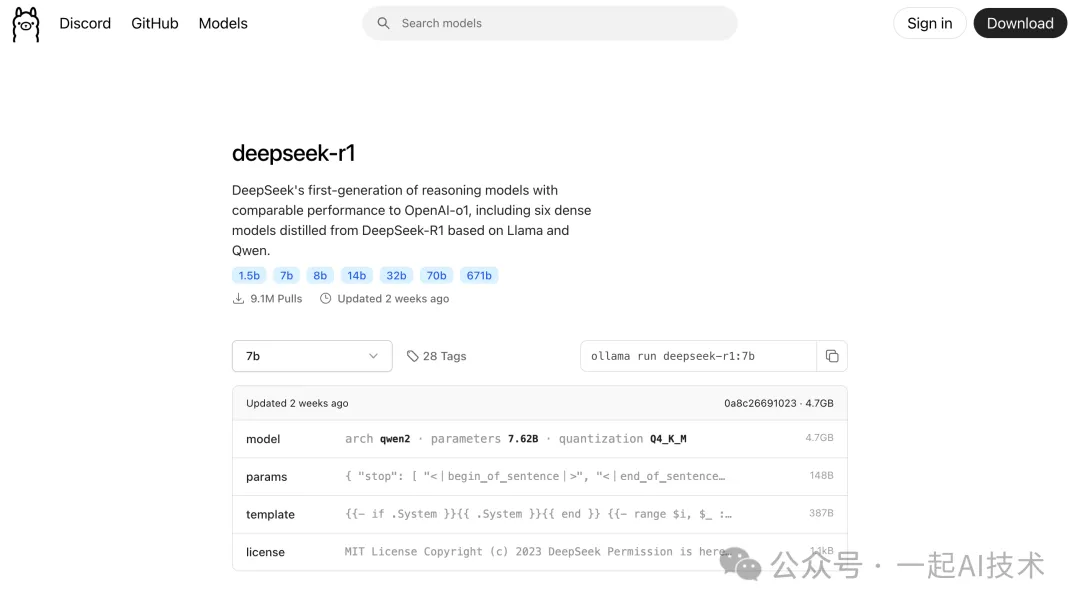

4. 下載DeepSeek大模型

- 訪問ollama模型查詢頁面https://ollama.com/search

- 搜索deepseek-r1模型

- 根據本機配置情況,我們選擇?

?deepseek-r1:7b??模型,執行如下命令

ollama run deepseek-r1:7b下載模型根據網絡環境會花費不同的時間,待下載完成后,會提示"success"

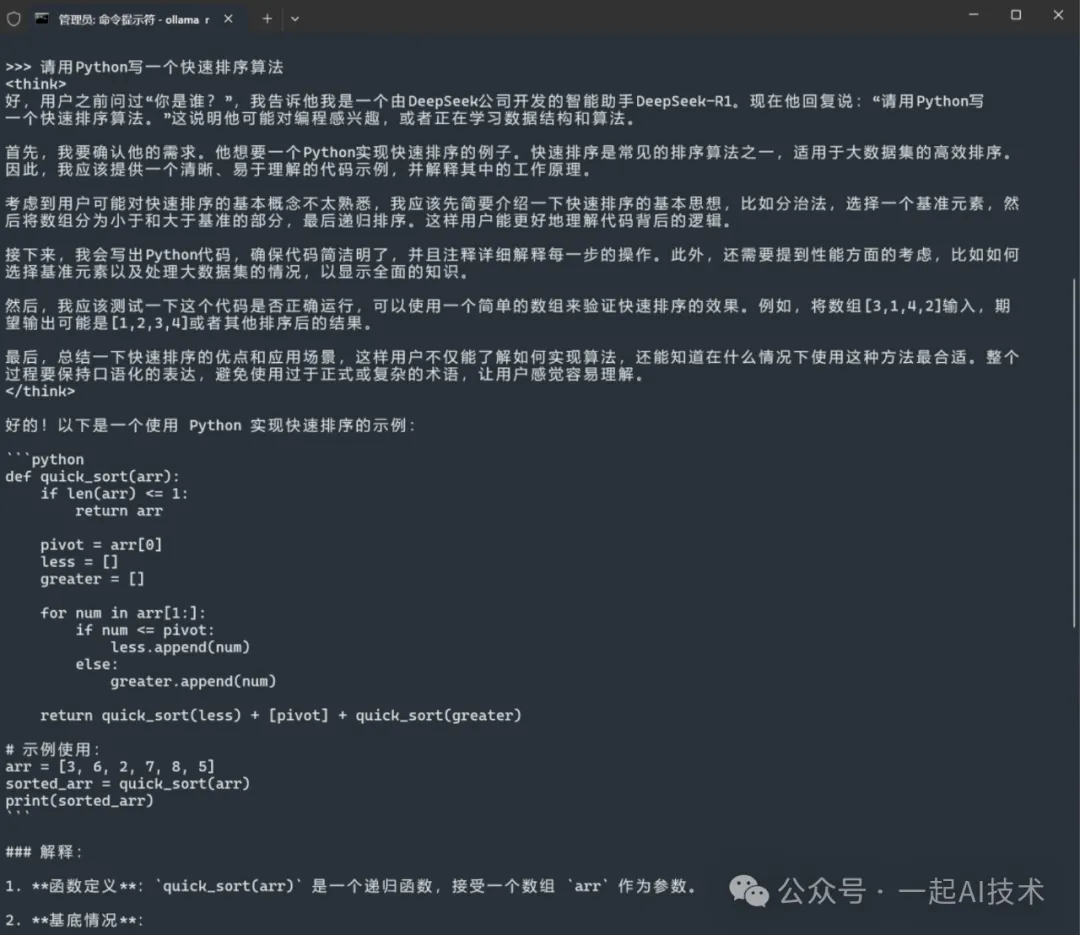

5. 測試模型效果

>>> 請用Python寫一個快速排序算法

6. 集成前端UI

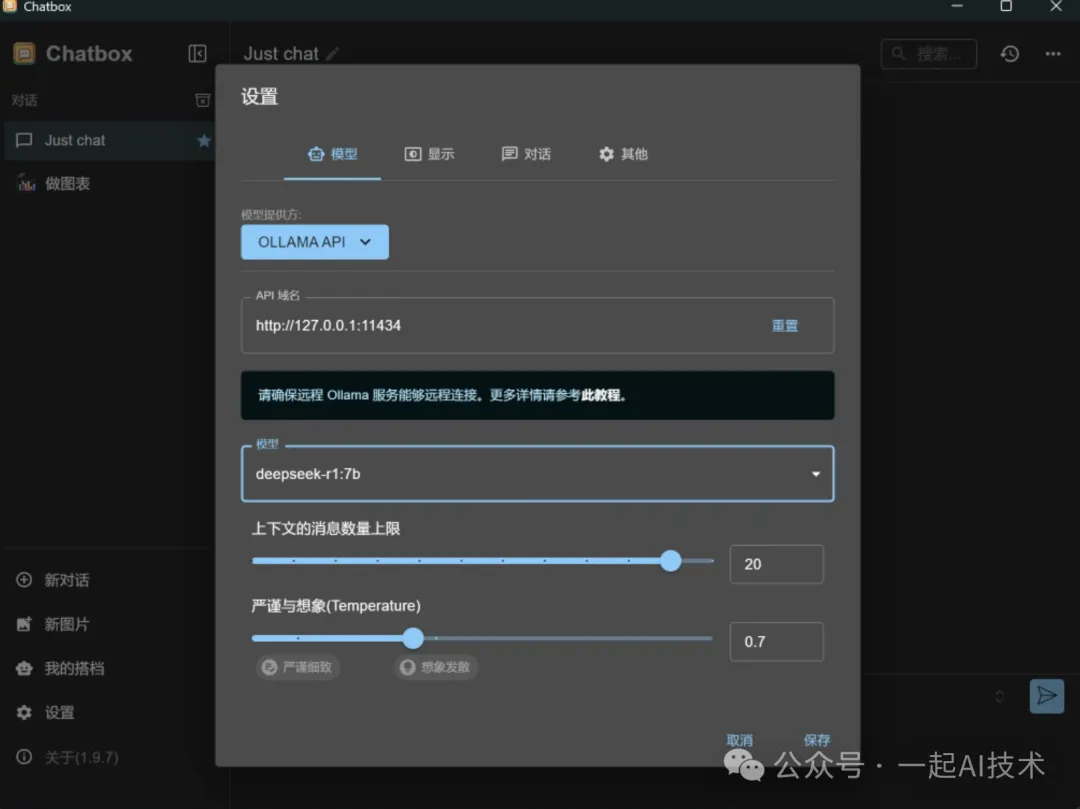

因為ollama本身沒有提供前端UI,通過命令行交互起來比較繁瑣。所以,我們可以根據之前介紹的方法一或方法二,將模型集成到前端chatbox或者cursor中。

本例,我們采用方法一,將模型集成到chatbox中。

- 打開chatbox,點擊設置

- 模型提供方選擇 ?

?Ollama API?? - API域名填寫 ?

?http://127.0.0.1:11434?? - 模型選擇 ?

?deepseek-r1:7b?? - 點擊保存

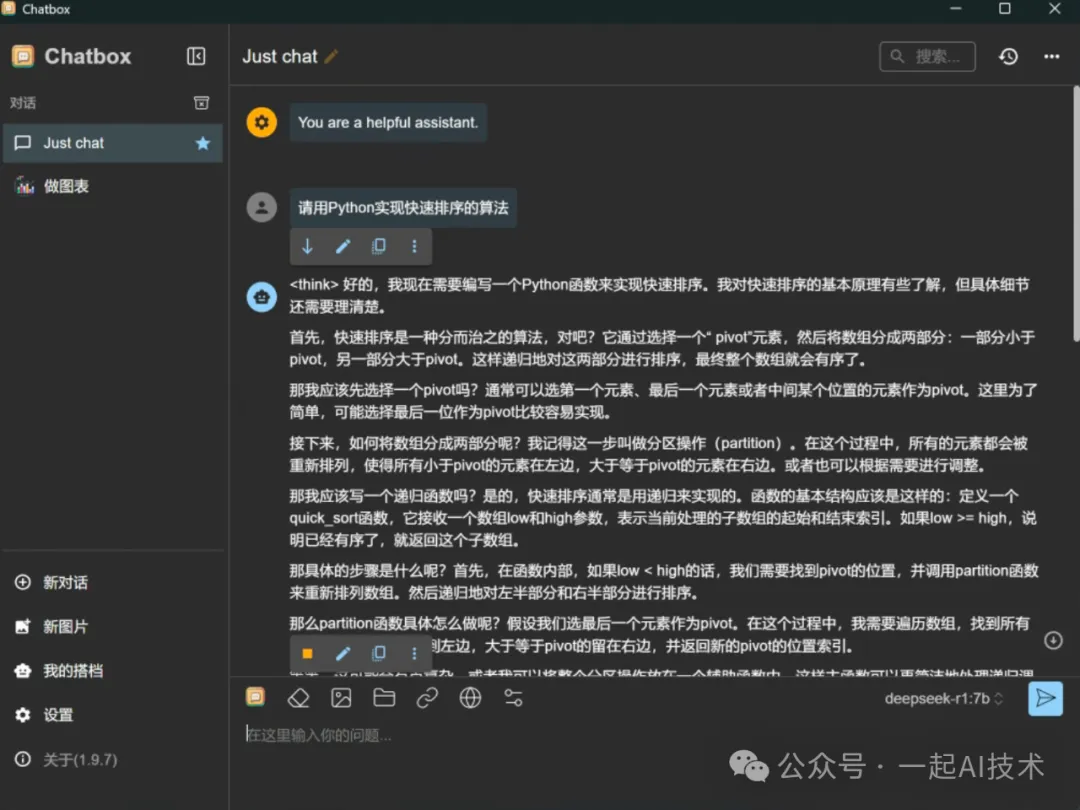

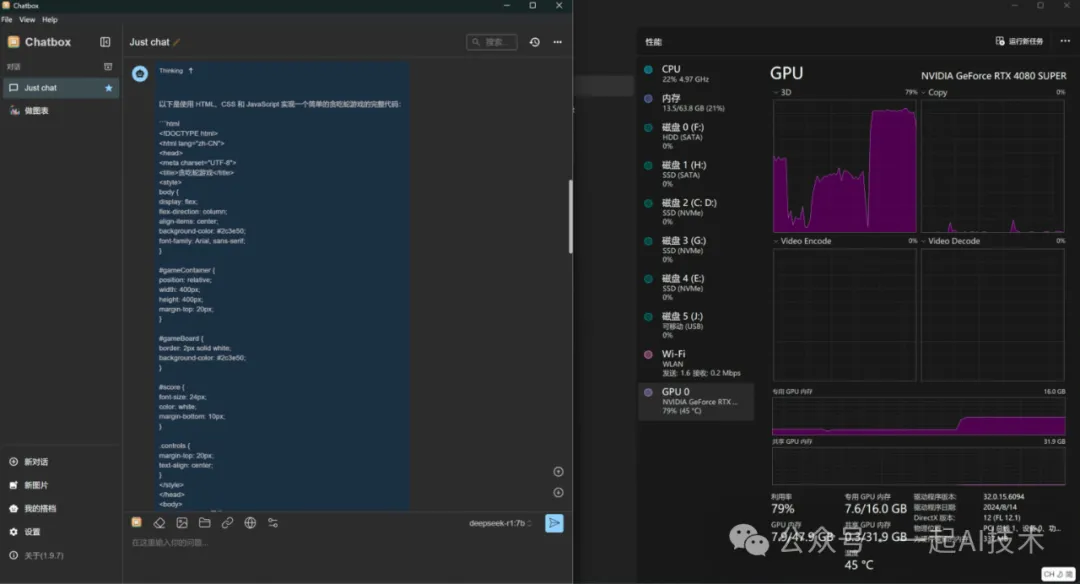

運行效果:

說明:經過實測,筆者4080顯卡16G顯存,使用ollama本地化部署deepseek-r1:7b 模型,顯存占用約7G,可以實現流暢的交互體驗。

優缺點對比

對比維度 | 方法一:ChatBox+API | 方法二:Cursor+API | 方法三:Ollama本地部署 |

部署難度 | ?? (需注冊API Key) | ??? (需IDE配置) | ???? (需硬件環境) |

響應速度 | 100-200ms (依賴網絡質量) | 300-500ms (試驗時較慢) | 50-150ms (本地計算) |

隱私性 | 中 (數據經過第三方服務器) | 中 (數據經過第三方服務器) | 高 (完全本地運行) |

硬件要求 | 無特殊要求 | 無特殊要求 | 16GB內存+獨立顯卡 |

成本 | ¥4/100 萬個 Tokens | $10/月訂閱費 | 一次性硬件投入 |

適用場景 | 日常辦公/簡單問答 | 程序開發/技術寫作 | 敏感數據處理/定制開發 |

模型更新 | 自動更新 | 跟隨IDE版本 | 手動更新 |

離線可用性 | 否 | 否 | 完全離線 |

備注說明:

- ¥4/100 萬個 Tokens 是硅基流動的API價格,其相當于:

- 讓AI寫一個5000字的文章,花費約為:1萬 Tokens ÷ 100萬 Tokens × 4元 =0.04元;

- 讓AI每天寫100個5000字的文章,花費約為:100次 × 1000 Tokens = 10萬 Tokens → 10萬 ÷100萬 ×4元 =0.4元

內容小結

- DeepSeek大模型在部署方面,支持多種方式,滿足從普通用戶到開發者的不同需求。

- 對于普通用戶,使用chatbox+硅基流動接入云端API使用,可以實現快速接入和使用。

- 對于程序員,使用cursor+硅基流動接入云端API使用,可以實現代碼開發和調試輔助。

- 對于有安全隱私需求的用戶,使用ollama本地化部署使用,可以實現完全離線使用。