小洞不補,大洞吃苦:西交、麥馬開源全新「拖動式編輯」框架&數據集

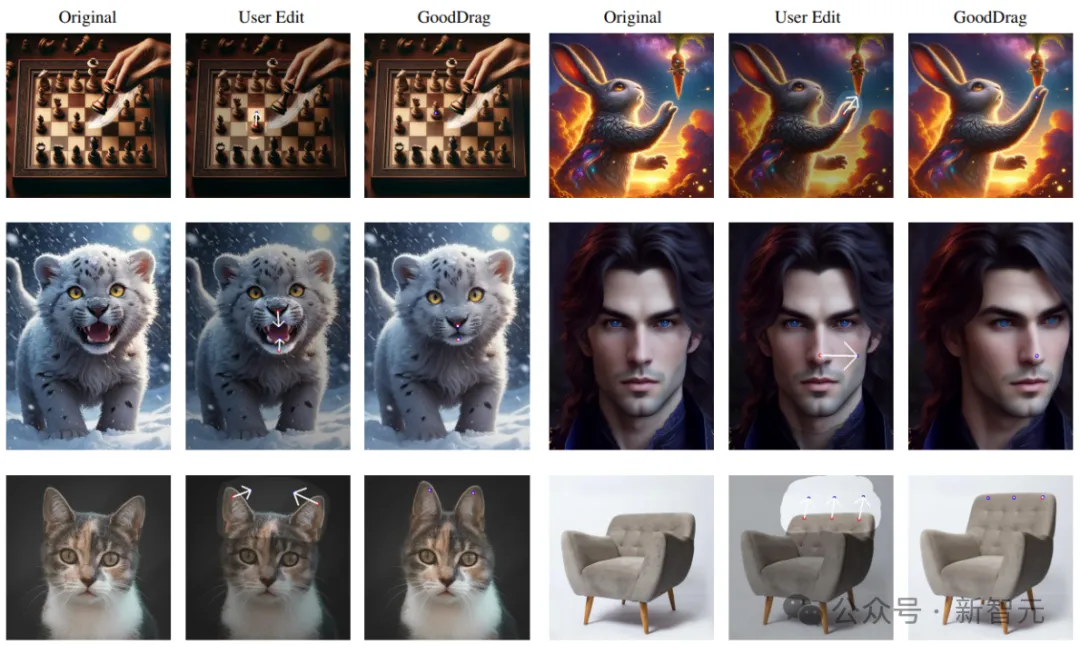

拖動式圖像編輯是一種新型的、用戶交互式的圖像編輯方法。

通過設置起始點與目標點,用戶可以將圖像的內容拖動至指定位置,得到合理的圖像結果。

當前的拖動式編輯基于GAN或者diffusion模型。然而這些方法或受限于GAN模型本身的生成能力,或在diffusion模型上無法得到穩定且高質量的結果。

論文地址:??https://arxiv.org/abs/2404.07206??

項目地址:??https://gooddrag.github.io/??

最近,西安交通大學和麥克馬斯特大學的研究人員提出的一種全新GoodDrag方法包含一種Alternating Drag and Denoising(AlDD)的用于拖動式編輯的框架和information-preserving motion supervision,有效提高了基于diffusion模型的拖動編輯的圖像質量。

值得注意的是,GoodDrag遵循簡約的設計原則(如無必要,勿增實體):AlDD只需要改變計算順序,而不增加任何計算;information-preserving的改進則只需要巧妙地對損失中的一項進行改動。這種簡潔性極大提升了方法的泛化能力,也為未來研究提供了扎實的基準。

此外,研究人員還建立了包含不同類型拖動編輯任務的新數據集Drag100,并采用新的指標對拖動編輯結果的準確性和圖形質量進行評估。

方法概述

1. 拖動編輯

基本的拖動編輯將一組起始點pi對應的圖像內容拖動至對應的目標點qi,其主要過程分為兩部,動作監督和當前點追蹤。

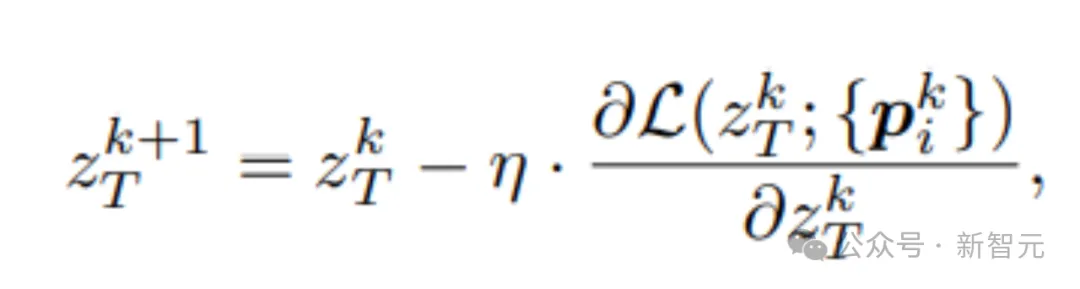

動作監督對當前的latent code進行更新后,得到一步拖動后的新latent code

此時,圖像上對應的內容發生了變化,起始點對應的圖像內容不一定隨著隨著拖動路勁改變,可能發生偏離,因此我們需要對當前點進行追蹤,得到新的當前點。

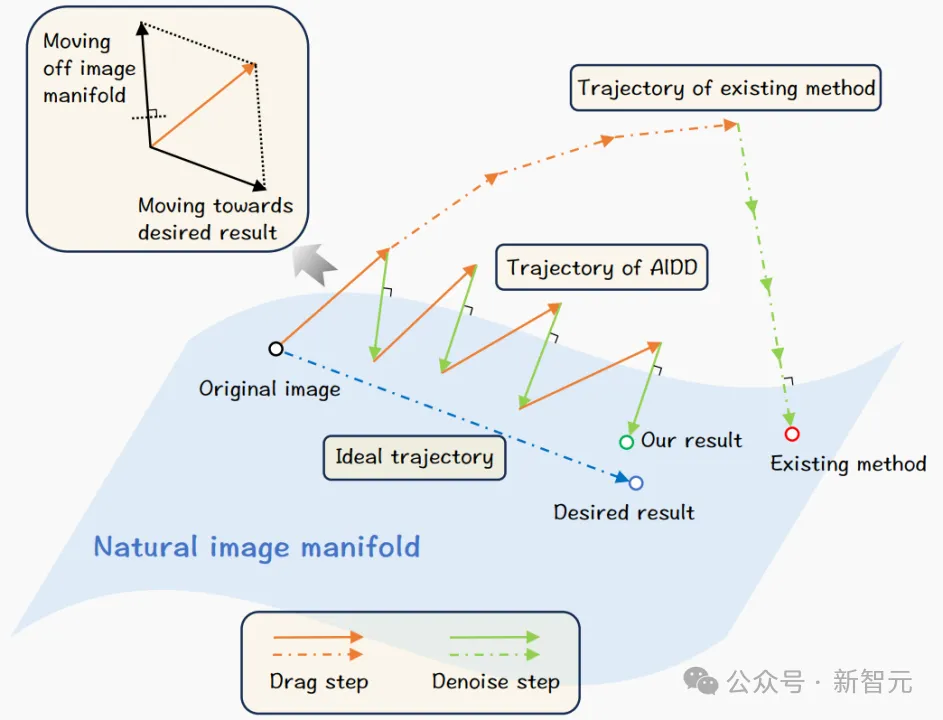

2. AlDD框架

A stitch in time saves nine (小洞不補,大洞吃苦)

當前基于diffusion的拖動編輯方法將所有的拖動操作集中在diffusion去噪的某一步上,然后通過去噪進行修復并得到拖動后的結果。

當大量的拖動編輯加入時,造成的擾動可能過大,從而使diffusion無法修復。我們提出的AlDD框架交替進行拖動編輯和diffusion去噪,有效抵抗拖動所帶來的累積擾動,從而得到高質量的圖像。

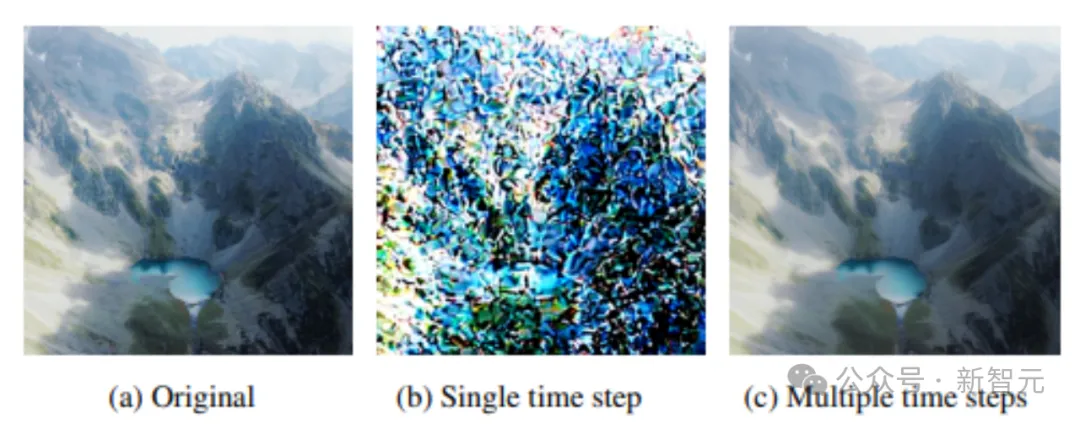

簡單實驗證明累積誤差會對diffusion的去噪生成造成影響。圖中未單步denoise加入多個高斯噪聲和多步denoise過程每次加入一個高斯噪聲,當大量誤差累積時,diffusion無法恢復原圖,相反,每次少量的擾動可以被diffusion的去噪過程修復。

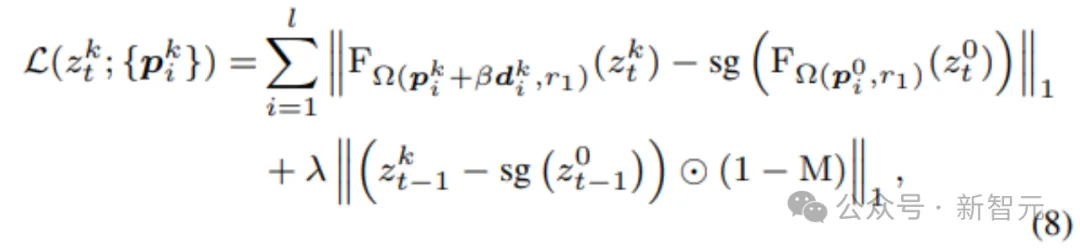

3. Information-Preserving Motion Supervision

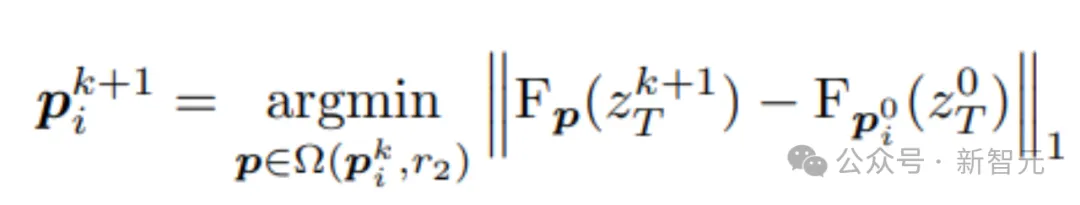

過去基于GAN或者diffusion的拖動編輯將當前追蹤點所對應的patch作為下一步motion supervision的目標。

然而,這樣的做法忽視了拖動編輯可能是不充分的;或者隨著編輯,當前patch的內容由于累積誤差發生了偏離。以偏離的patch作為motion supervision目標會進一步導致誤差累積,從而進入惡性循環。

文中提出的Information-Preserving Motion Supervision,總是以當前diffusion的time stpe的feature中起始點的patch作為目標,從而進一步避免累積誤差對Motion Supervision造成干擾。

研究人員設計了新的動作監督式,此處pi^0所對應的特征總是作為動作監督目標。

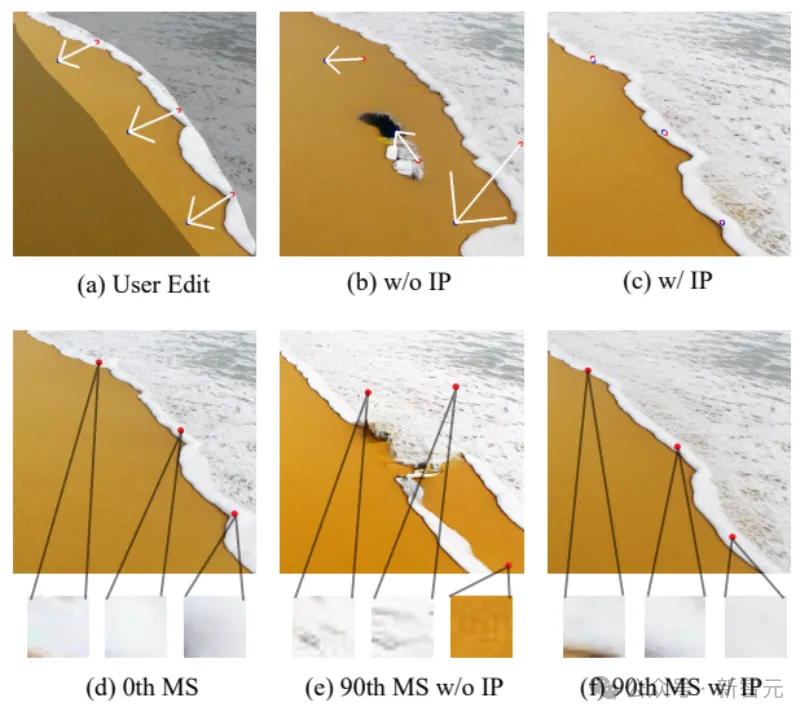

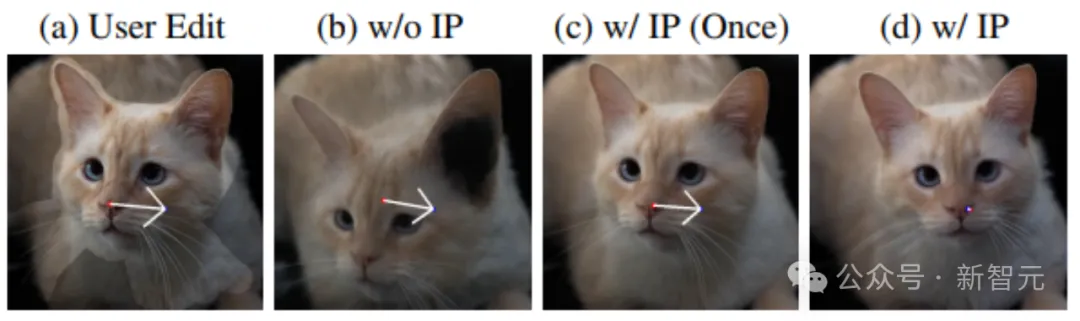

此圖中,Information-Preserving Motion Supervision隨著拖動編輯進行,其點對應的圖像總是和原圖像的起始點相符,而非Information-Preserving Motion Supervision則隨著拖動Motion Supervision次數增加,對應的目標逐漸偏離原來的圖像內容,從而導致結果不佳。

全新基準數據集Drag100

拖動編輯是一種新型的圖像編輯手段,缺乏相應的數據集和定量評估方法。我們引入新的數據集Drag100,拖動準確性指數Dragging Accuracy Index (DAI)和圖像質量評估分數Gemini Score (GScore)。

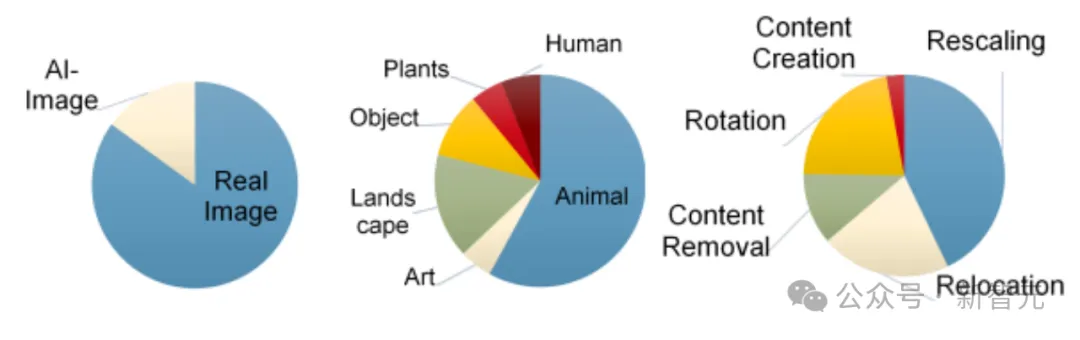

盡管最近的基于diffusion拖動文章提供了一些數據集,Drag100不僅僅考慮圖像內容種類的不同,還考慮拖動任務的不同。拖動編輯大致包含以下幾,移動,旋轉,縮放,內容消除和內容生成。

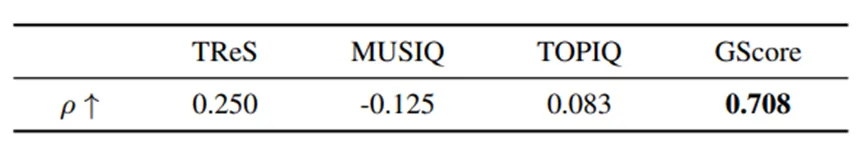

我們比較不同的圖像質量評估指標和GScore與人眼判別的相關性。對不同的指標,我們分別計算與問卷人眼圖像質量判斷結果的Spearman’s rank correlation coefficient(斯皮爾曼等級相關系數)。最后的平均結果如下,GScore表現出高度的正相關,遠優于其他圖像質量評估指標。

另一方面,為了在開放數據集上評估生成圖片的圖像質量,我們嘗試傳統NoReference Image Quality Assessment (NR-IQA)方法,發現此類方法和人眼對圖像質量的評估相關性較差。

因此,采用大型多模態模型,引入基于Gemini模型的GScore,以替代大范圍測試時對人眼評估的依賴。我們通過問卷證明了GScore與人眼評判具有較高的相關性。

實驗結果

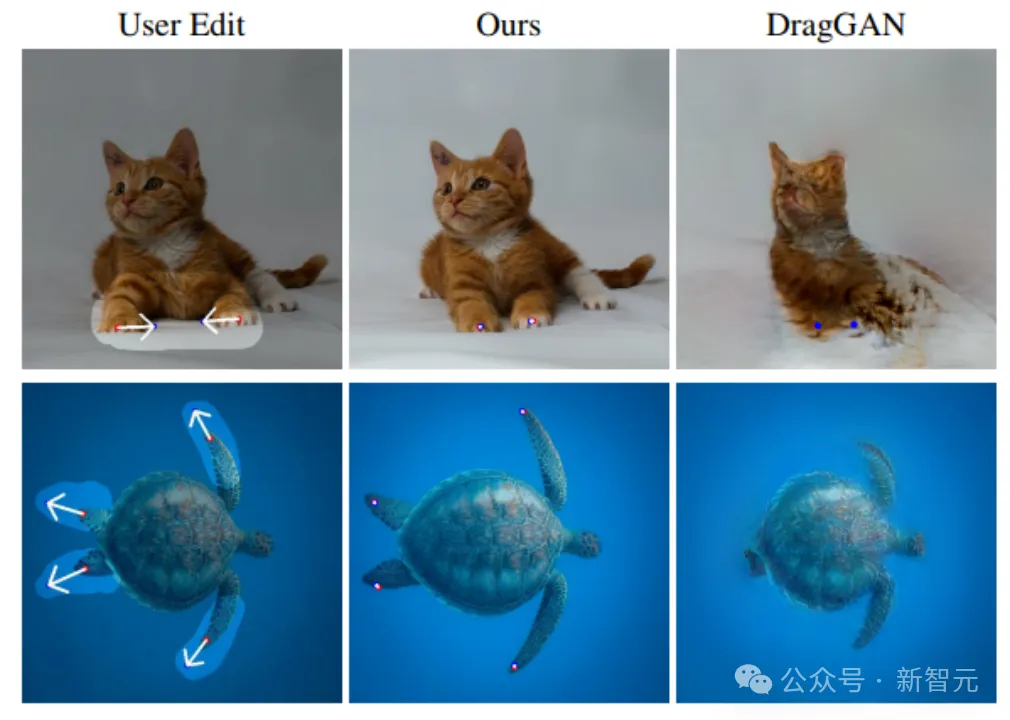

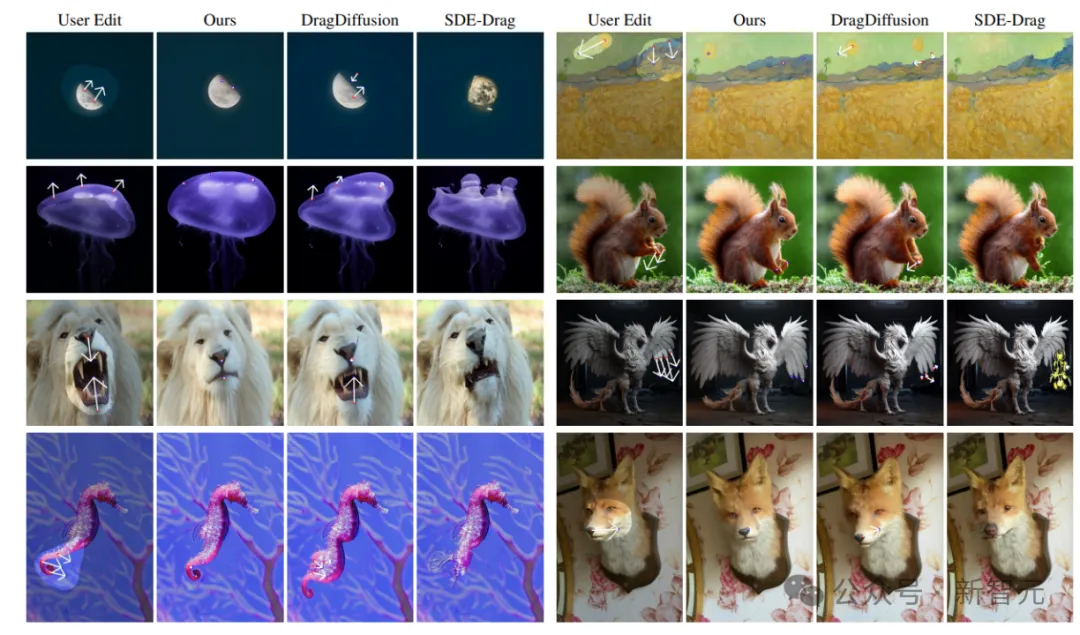

GoodDrag的拖動編輯效果在拖動精確度和圖像質量在定性和定量上都超過了現有方法。

部分圖像結果:

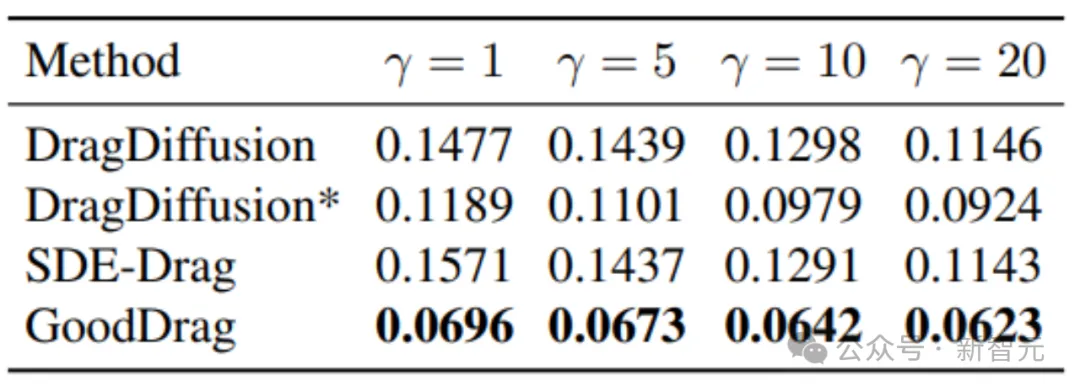

DAI在Drag100上的結果如下,DragDiffusion*增加了DragDiffusion默認的拖動編輯次數:

評估圖像質量的GScore如下

此外,研究人員還進行實驗驗證AlDD和Information-Preserving Motion Supervision的有效性。

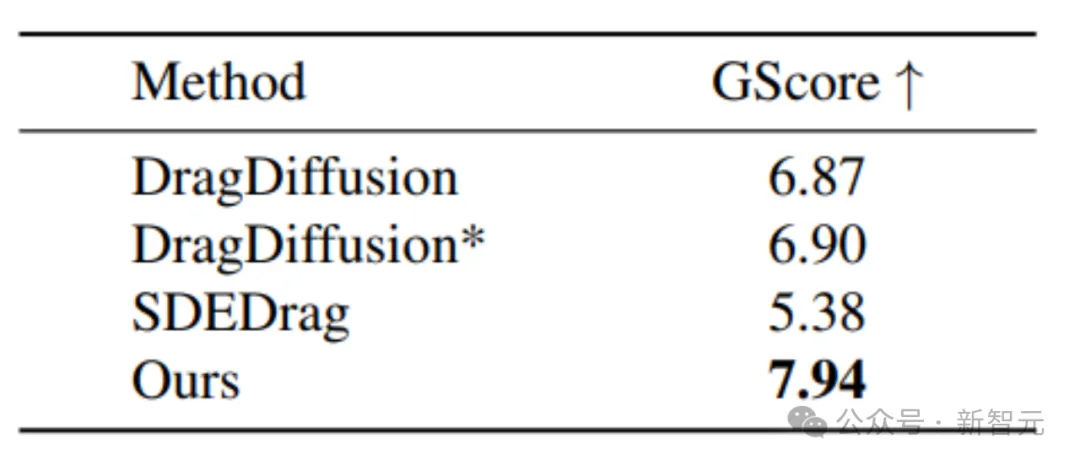

下圖為是否采用AlDD框架的比較,使用AlDD可以保留原圖的細致紋理,而非AlDD則會使圖像失真。

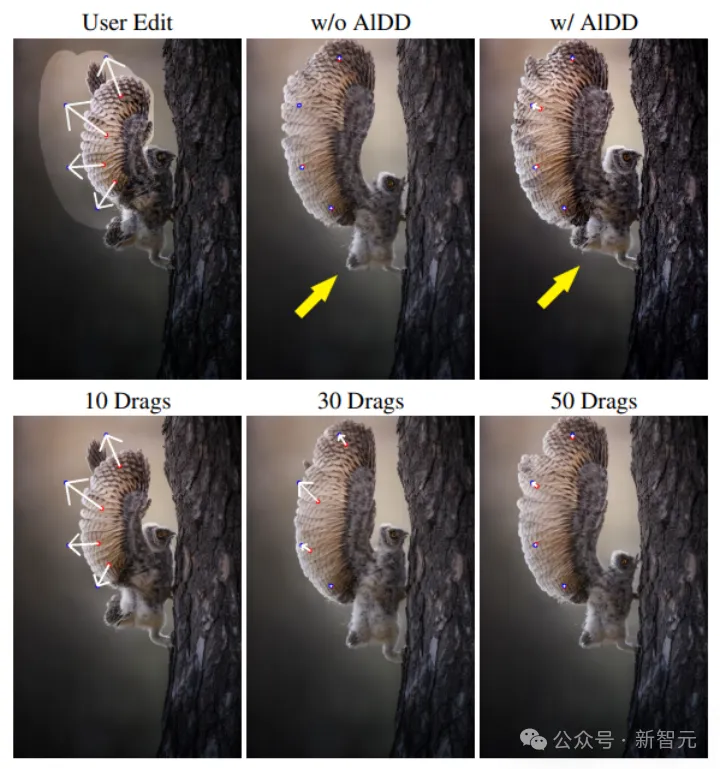

Information-Preserving Motion Supervision可以進一步保證圖像質量,也會導致拖動編輯的難度上升,因此我們對每次動作監督進行小learning rate的多次重復。不采用Information-Preserving Motion Supervision會導致目標偏離,從而拖動編輯失敗。

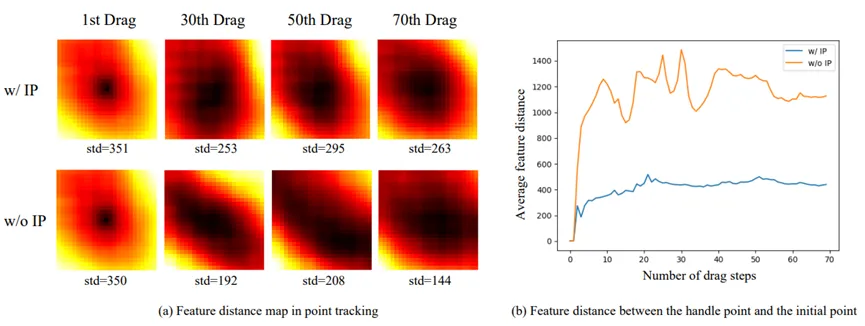

以下熱力圖和折線圖進一步說明Information-Preserving Motion Supervision的必要性。在當前的追蹤時,Information-Preserving Motion Supervision可以使追蹤區域更敏感,如以下熱力圖(以歸一化)所示,Information-Preserving Motion Supervision方法使黑色區域更小,更具鋒度,從而提高追蹤的準確性。

同時折線圖反映了用于追蹤的特征和原特征數值上的差異,Information-Preserving Motion Supervision有效保留了原特征的內容。

總結

GoodDrag探索了基于diffusion模型對拖動編輯造成影響的因素。設計了AlDD框架和Information-Preserving Motion Supervision,有效提高了拖動編輯的準確性和圖像質量。

此外還為拖動編輯提供了新的數據集Drag100,以及評估準確性DAI和評估圖像質量的GScore。

GoodDrag現已開源,提供多種簡易運行方式,支持用戶使用自己的圖片進行嘗試:https://gooddrag.github.io/

本文轉自 新智元,作者:新智元