輕量化AI的崛起:蒸餾模型如何在資源有限中大放異彩 原創(chuàng)

01、概述

我們可能已經(jīng)聽說了 Deepseek,但你是否也注意到 Ollama 上提到了 Deepseek 的蒸餾模型?或者,如果你嘗試過 Groq Cloud,可能會看到類似的模型。那么,這些“distil”模型到底是什么呢?在這一背景下,“distil”指的是組織發(fā)布的原始模型的蒸餾版本。蒸餾模型本質(zhì)上是較小且更高效的模型,設(shè)計目的是復(fù)制較大模型的行為,同時減少資源需求。

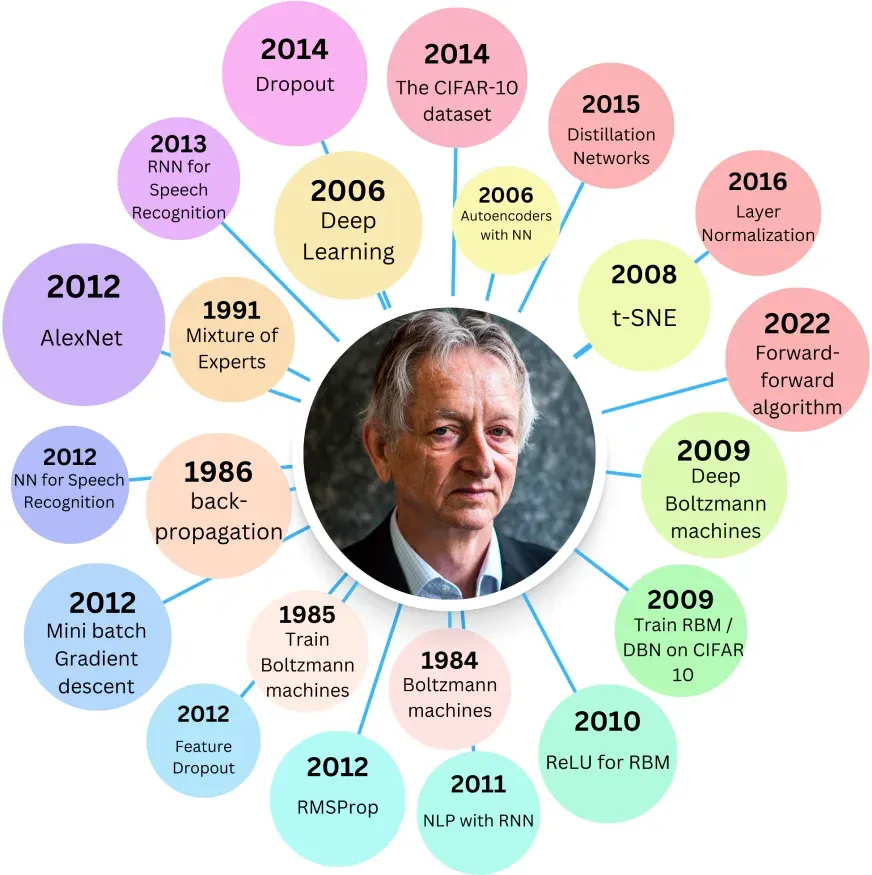

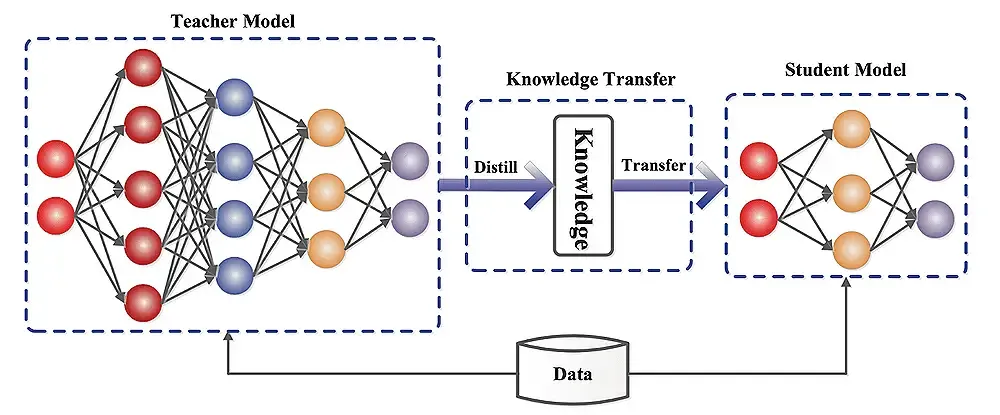

這種技術(shù)由 Geoffrey Hinton 在 2015 年的論文“Distilling the Knowledge in a Neural Network”中首次提出,旨在通過壓縮模型來保持性能,同時降低內(nèi)存和計算需求。Hinton 提出了一個問題:是否可以訓(xùn)練一個大型神經(jīng)網(wǎng)絡(luò),然后將其知識壓縮到一個較小的網(wǎng)絡(luò)中?在這里,較小的網(wǎng)絡(luò)被視為學(xué)生,而較大的網(wǎng)絡(luò)則扮演教師的角色,目標(biāo)是讓學(xué)生復(fù)制教師學(xué)習(xí)的關(guān)鍵權(quán)重。

02、蒸餾模型的益處

蒸餾模型帶來了多方面的優(yōu)勢,包括:

- 減少內(nèi)存占用和計算需求。

- 降低推理和訓(xùn)練時的能耗。

- 加快處理速度。

例如,在移動和邊緣計算中,較小的模型尺寸使其非常適合部署在計算能力有限的設(shè)備上,確保移動應(yīng)用和物聯(lián)網(wǎng)設(shè)備中的快速推理。此外,在大規(guī)模部署如云服務(wù)中,降低能耗至關(guān)重要,蒸餾模型有助于減少電力使用。對于初創(chuàng)公司和研究人員,蒸餾模型提供了性能與資源效率之間的平衡,支持更快的開發(fā)周期。

03、蒸餾模型的引入

蒸餾模型的引入過程旨在保持性能,同時減少內(nèi)存和計算需求。這是 Geoffrey Hinton 在 2015 年論文中提出的模型壓縮形式。Hinton 提出了一個核心問題:是否可以訓(xùn)練一個大型神經(jīng)網(wǎng)絡(luò),然后將其知識壓縮到一個較小的網(wǎng)絡(luò)中?在這一框架下,較小的網(wǎng)絡(luò)(學(xué)生)通過分析教師的行為和預(yù)測,學(xué)習(xí)其權(quán)重。訓(xùn)練方法包括最小化學(xué)生輸出與兩種目標(biāo)之間的誤差:實(shí)際的真實(shí)標(biāo)簽(硬目標(biāo))和教師的預(yù)測(軟目標(biāo))。

雙重?fù)p失組件

- 硬損失:這是與真實(shí)標(biāo)簽(地面真相)比較的誤差,通常在標(biāo)準(zhǔn)訓(xùn)練中優(yōu)化,確保模型學(xué)習(xí)正確的輸出。

- 軟損失:這是與教師預(yù)測比較的誤差。雖然教師可能不完美,但其預(yù)測包含了輸出類別相對概率的寶貴信息,有助于指導(dǎo)學(xué)生模型實(shí)現(xiàn)更好的泛化。

訓(xùn)練目標(biāo)是最小化這兩者的加權(quán)和,其中軟損失的權(quán)重由參數(shù) λ 控制。即使有人可能認(rèn)為真實(shí)標(biāo)簽已足夠用于訓(xùn)練,加入教師的預(yù)測(軟損失)實(shí)際上可以加速訓(xùn)練并提升性能,通過提供細(xì)致的指導(dǎo)信息。

Softmax 函數(shù)與溫度

這一方法的關(guān)鍵部分是修改 Softmax 函數(shù),通過引入溫度參數(shù)(T)。標(biāo)準(zhǔn) Softmax 函數(shù)將神經(jīng)網(wǎng)絡(luò)的原始輸出分?jǐn)?shù)(logits)轉(zhuǎn)換為概率。當(dāng) T=1 時,函數(shù)表現(xiàn)為標(biāo)準(zhǔn) Softmax;當(dāng) T>1 時,指數(shù)變得不那么極端,產(chǎn)生更“軟”的概率分布,揭示每個類別的相對可能性更多信息。為了糾正這一效應(yīng)并保持從軟目標(biāo)的有效學(xué)習(xí),軟損失乘以 T^2,更新后的總體損失函數(shù)確保硬損失(來自實(shí)際標(biāo)簽)和溫度調(diào)整后的軟損失(來自教師預(yù)測)適當(dāng)?shù)刎暙I(xiàn)于學(xué)生模型的訓(xùn)練。

具體實(shí)例:DistilBERT 和 DistillGPT2

- DistilBERT:基于 Hinton 的蒸餾方法,添加了余弦嵌入損失來測量學(xué)生和教師嵌入向量之間的距離。DistilBERT 有 6 層、6600 萬參數(shù),而 BERT-base 有 12 層、1.1 億參數(shù)。兩者的重新訓(xùn)練數(shù)據(jù)集相同(英語維基百科和多倫多書籍語料庫)。在評估任務(wù)中:

GLUE 任務(wù):BERT-base 平均準(zhǔn)確率為 79.5%,DistilBERT 為 77%。

SQuAD 數(shù)據(jù)集:BERT-base F1 分?jǐn)?shù)為 88.5%,DistilBERT 約為 86%。

- DistillGPT2:原始 GPT-2 有四個尺寸,最小版本有 12 層、約 1.17 億參數(shù)(某些報告稱 1.24 億,因?qū)崿F(xiàn)差異)。DistillGPT2 是其蒸餾版本,有 6 層、8200 萬參數(shù),保持相同的嵌入尺寸(768)。盡管 DistillGPT2 的處理速度是 GPT-2 的兩倍,但在大文本數(shù)據(jù)集上的困惑度高 5 點(diǎn)。在 NLP 中,較低的困惑度表示更好的性能,因此最小 GPT-2 仍優(yōu)于其蒸餾版本。你可以在 Hugging Face 上探索該模型。

04、實(shí)現(xiàn)大型語言模型(LLM)蒸餾

實(shí)現(xiàn) LLM 蒸餾涉及多個步驟和專用框架:

框架和庫:

- Hugging Face Transformers:提供 Distiller 類,簡化從教師到學(xué)生模型的知識轉(zhuǎn)移。

- 其他庫:TensorFlow Model Optimization 提供模型剪枝、量化和蒸餾工具;PyTorch Distiller 包含使用蒸餾技術(shù)壓縮模型的實(shí)用程序;DeepSpeed(由微軟開發(fā))包括模型訓(xùn)練和蒸餾功能。

涉及的步驟:

- 數(shù)據(jù)準(zhǔn)備:準(zhǔn)備代表目標(biāo)任務(wù)的數(shù)據(jù)集,數(shù)據(jù)增強(qiáng)技術(shù)可進(jìn)一步增強(qiáng)訓(xùn)練示例的多樣性。

- 教師模型選擇:選擇表現(xiàn)良好的預(yù)訓(xùn)練教師模型,教師的質(zhì)量直接影響學(xué)生的性能。

- 蒸餾過程:初始化學(xué)生模型,配置訓(xùn)練參數(shù)(如學(xué)習(xí)率、批量大小);使用教師模型生成軟目標(biāo)(概率分布)以及硬目標(biāo)(真實(shí)標(biāo)簽);訓(xùn)練學(xué)生模型以最小化其預(yù)測與軟/硬目標(biāo)之間的組合損失。

- 評估指標(biāo):常用指標(biāo)包括準(zhǔn)確率、推理速度、模型大小(減少)和計算資源利用效率。

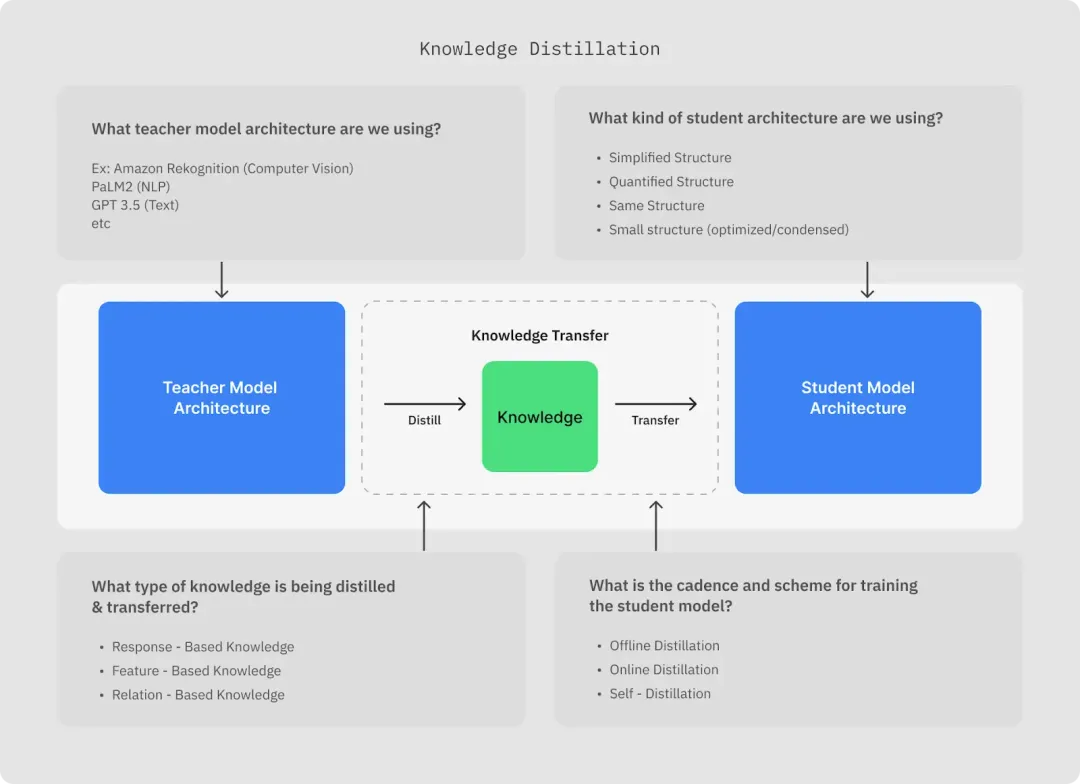

05、理解模型蒸餾

模型蒸餾的核心是訓(xùn)練學(xué)生模型模仿教師的行為,通過最小化學(xué)生預(yù)測與教師輸出之間的差異,這是一種監(jiān)督學(xué)習(xí)方法,構(gòu)成了模型蒸餾的基礎(chǔ)。關(guān)鍵組件包括:

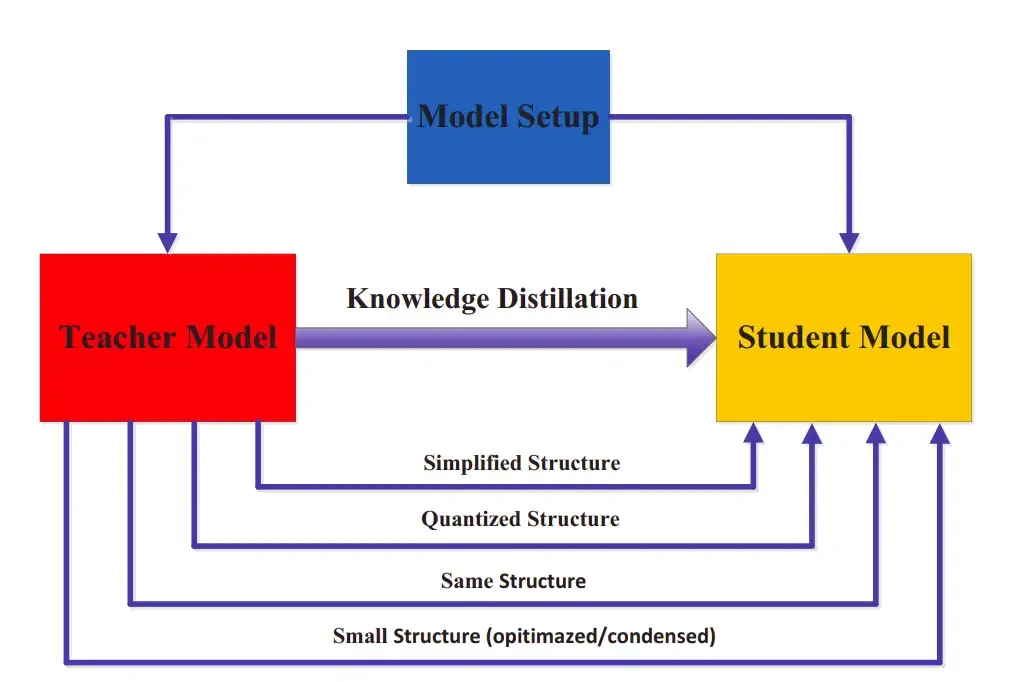

- 選擇教師和學(xué)生模型架構(gòu):學(xué)生模型可以是教師的簡化或量化版本,也可以是完全不同的優(yōu)化架構(gòu),具體取決于部署環(huán)境的特定要求。

- 蒸餾過程解釋:通過最小化學(xué)生與教師預(yù)測之間的差異,學(xué)生學(xué)習(xí)教師的行為,確保在資源受限情況下保持性能。

挑戰(zhàn)與局限性

盡管蒸餾模型提供了明顯益處,但也存在一些挑戰(zhàn):

- 準(zhǔn)確性權(quán)衡:蒸餾模型通常比其較大對應(yīng)物略有性能下降。

- 蒸餾過程的復(fù)雜性:配置正確的訓(xùn)練環(huán)境和微調(diào)超參數(shù)(如 λ 和溫度 T)可能具有挑戰(zhàn)性。

- 領(lǐng)域適應(yīng):蒸餾的有效性可能因具體領(lǐng)域或任務(wù)而異。

06、未來方向

模型蒸餾領(lǐng)域快速發(fā)展,一些有前景的領(lǐng)域包括:

- 蒸餾技術(shù)進(jìn)步:正在進(jìn)行的研究旨在縮小教師和學(xué)生模型之間的性能差距。

- 自動化蒸餾過程:新興方法旨在自動化超參數(shù)調(diào)整,使蒸餾更易訪問和高效。

- 更廣泛的應(yīng)用:除了 NLP,模型蒸餾在計算機(jī)視覺、強(qiáng)化學(xué)習(xí)等領(lǐng)域也越來越受到關(guān)注,可能改變資源受限環(huán)境中的部署。

實(shí)際應(yīng)用

蒸餾模型在各個行業(yè)中找到實(shí)際應(yīng)用:

- 移動和邊緣計算:較小的尺寸使其理想用于計算能力有限的設(shè)備,確保移動應(yīng)用和物聯(lián)網(wǎng)設(shè)備中的快速推理。

- 能效:在大規(guī)模部署如云服務(wù)中,降低能耗至關(guān)重要,蒸餾模型有助于減少電力使用。

- 快速原型開發(fā):對于初創(chuàng)公司和研究人員,蒸餾模型提供性能與資源效率之間的平衡,支持更快的開發(fā)周期。

07、結(jié)論

蒸餾模型通過在高性能與計算效率之間實(shí)現(xiàn)微妙平衡,改變了深度學(xué)習(xí)。盡管由于其較小尺寸和依賴軟損失訓(xùn)練,可能犧牲一些準(zhǔn)確性,但其快速處理和減少資源需求使其在資源受限設(shè)置中特別有價值。總之,蒸餾網(wǎng)絡(luò)模擬其較大對應(yīng)物的行為,但由于容量有限,性能永遠(yuǎn)無法超過它。這種權(quán)衡使蒸餾模型在計算資源有限或性能接近原始模型時成為明智的選擇。相反,如果性能下降顯著或通過并行化等方法計算能力充足,選擇原始較大模型可能更好。

本文轉(zhuǎn)載自公眾號Halo咯咯 作者:基咯咯