Mistral-Small-24B-Instruct-2501:小身材,大智慧,AI界的“輕量級拳王”來了! 原創

01、概述

在人工智能領域,開發既緊湊又高性能的語言模型一直是一個巨大的挑戰。大型模型雖然表現卓越,但往往需要龐大的計算資源,這讓許多硬件能力有限的用戶和組織望而卻步。與此同時,市場對多任務處理、多語言支持和高效準確響應的需求日益增長。如何在性能、可擴展性和可訪問性之間找到平衡,尤其是在本地部署和數據隱私方面,成為了一個關鍵問題。這也催生了創新的需求:我們需要更小、更高效的模型,既能媲美大型模型的性能,又能保持多功能性和成本效益。

最近,自然語言處理領域取得了一些重要進展,像GPT-4、Llama 3和Qwen 2.5這樣的大規模模型展現了卓越的性能,但它們對計算資源的需求也相當驚人。為了應對這一問題,研究人員開始專注于開發更小、更高效的模型,比如通過指令微調和量化技術來實現本地部署,同時保持競爭力。多語言模型如Gemma-2在語言理解方面取得了突破,而函數調用和擴展上下文窗口的創新則提升了任務適應性。盡管如此,如何在性能、效率和可訪問性之間找到平衡,仍然是開發小型高質量語言模型的關鍵。

02、Mistral-Small-24B-Instruct-2501:小身材,大能量

最近,Mistral AI發布了一款名為Mistral-Small-24B-Instruct-2501的模型,這款模型雖然只有240億參數,但卻展現了頂尖的性能。它通過多樣化的指令微調任務,實現了高級推理、多語言支持和無縫應用集成。與那些“龐然大物”相比,Mistral-Small專為高效的本地部署優化,支持像RTX 4090 GPU或32GB內存的筆記本電腦這樣的設備,并通過量化技術進一步降低了資源需求。

32k上下文窗口:處理長文本的“神器”

Mistral-Small的一個亮點是它的32k上下文窗口,這意味著它可以輕松處理大量輸入信息,同時保持高響應速度。無論是長篇文章、復雜指令還是多輪對話,它都能游刃有余地應對。此外,模型還支持JSON格式輸出和原生函數調用,這讓它在對話系統和任務特定場景中表現得更加靈活。

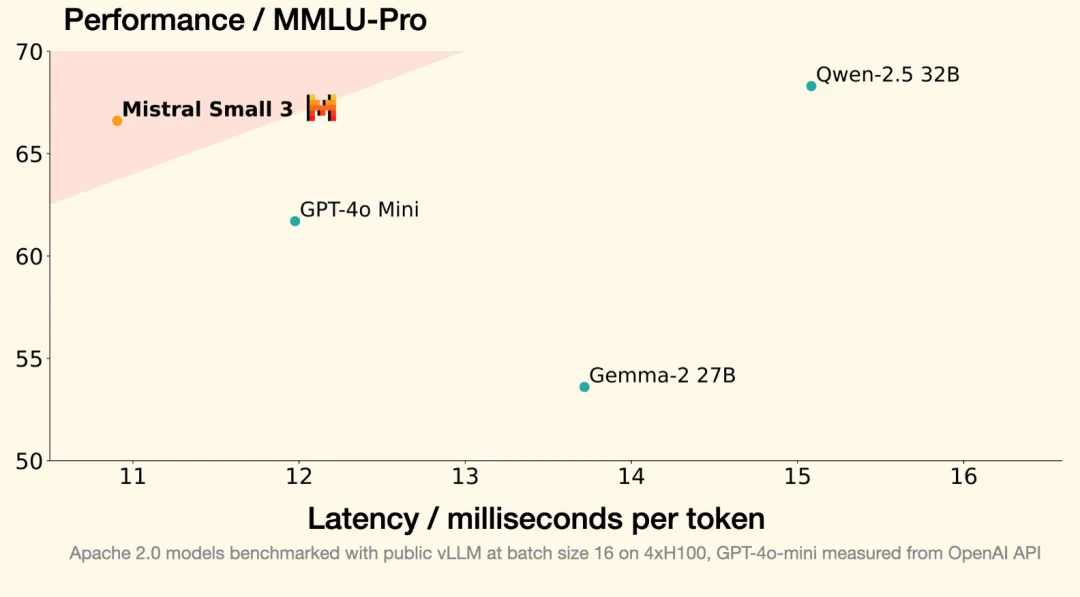

開源+低延遲:開發者的福音

為了讓更多開發者和企業能夠使用,Mistral-Small采用了Apache 2.0開源協議,這意味著無論是商業還是非商業用途,都可以自由使用和修改。它的先進架構不僅實現了低延遲和快速推理,還特別適合那些對成本敏感的中小企業和個人開發者。可以說,Mistral-Small在性能和資源效率之間找到了一個完美的平衡點,甚至在某些任務上超越了Llama 3.3-70B和GPT-4o-mini這樣的大型模型。

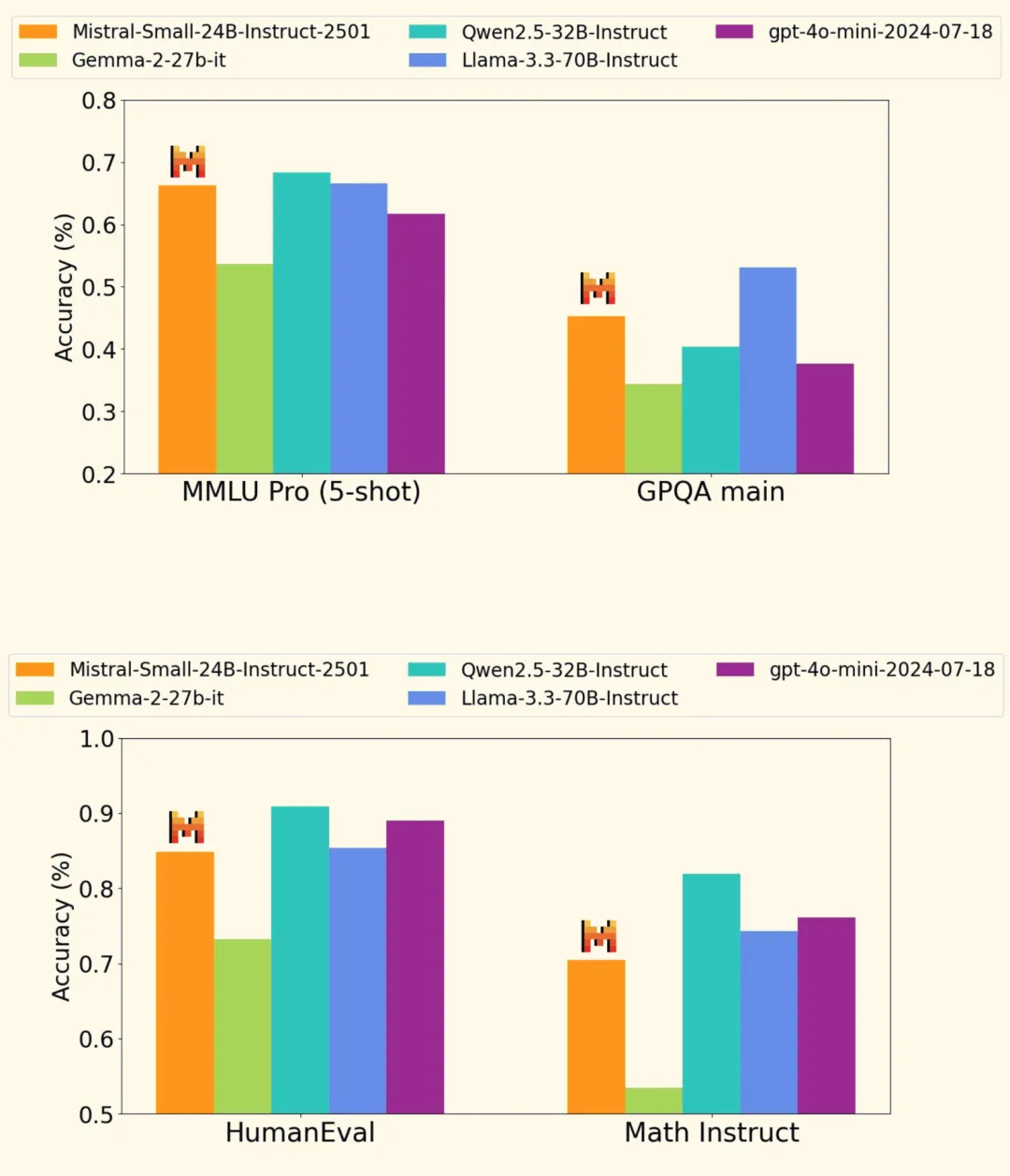

03、性能實測:小模型也能“打”大模型

Mistral-Small-24B-Instruct-2501在多個基準測試中表現搶眼,甚至在某些任務上超越了那些參數更多的“大塊頭”。比如,在HumanEval編碼測試中,它的準確率達到了84.8%,在數學任務中也拿到了**70.6%**的高分。更令人印象深刻的是,它在指令遵循、對話推理和多語言理解方面的表現也相當出色,無論是在公開數據集還是私有數據集上都取得了競爭力十足的分數。

多語言支持:全球化的“語言大師”

Mistral-Small的多語言能力也值得一提。它不僅能處理常見的英語任務,還能在多種語言之間自如切換,這對于全球化企業來說無疑是一個巨大的優勢。無論是翻譯、跨語言溝通還是多語言內容生成,它都能輕松應對。

本地部署:數據隱私的“守護者”

對于那些對數據隱私有高要求的用戶來說,Mistral-Small的本地部署能力無疑是一個巨大的加分項。你不再需要將敏感數據上傳到云端,只需在本地設備上運行模型,就能享受到高效的AI服務。這對于醫療、金融等對數據安全要求極高的行業來說,簡直是量身定制的解決方案。

開源+社區支持:AI界的“共享經濟”

Mistral-Small的開源特性不僅降低了使用門檻,還為開發者社區提供了一個共享和協作的平臺。無論是企業還是個人開發者,都可以基于這個模型進行二次開發,打造屬于自己的AI應用。這種開放性和靈活性,正是AI技術快速發展的關鍵驅動力。

04、總結:小模型,大未來

Mistral-Small-24B-Instruct-2501的發布,標志著小型語言模型在性能和效率方面邁出了重要一步。它不僅展現了與大型模型媲美的能力,還通過高效的本地部署和開源特性,為更多用戶提供了低成本、高靈活性的AI解決方案。無論是對話系統、多語言處理還是任務特定應用,Mistral-Small都能勝任。

未來,隨著AI技術的不斷進步,我們相信會有更多像Mistral-Small這樣的“輕量級拳王”出現,它們將以更小的體積、更低的成本,為各行各業帶來智能化的變革。而對于開發者和企業來說,這無疑是一個充滿機遇的時代。

參考:

本文轉載自公眾號Halo咯咯 作者:基咯咯

原文鏈接:??https://mp.weixin.qq.com/s/NLy14KPwzNwXAWqMQAml9g??