CVPR 2024 | 擅長處理復雜場景和語言表達,清華&博世提出全新實例分割網絡架構MagNet

指代分割 (Referring Image Segmentation,RIS) 是一項極具挑戰性的多模態任務,要求算法能夠同時理解精細的人類語言和視覺圖像信息,并將圖像中句子所指代的物體進行像素級別的分割。RIS 技術的突破有望在人機交互、圖像編輯、自動駕駛等諸多領域帶來革命性變革。它能夠極大地提升人機協作的效率和體驗。盡管目前最先進的 RIS 算法已經取得了顯著進展,但仍然面臨著模態差異 (modality gap) 的問題,即圖像和文本特征的分布并未完全對齊。這一問題在處理復雜的指代語言表達和罕見語境時尤為突出。

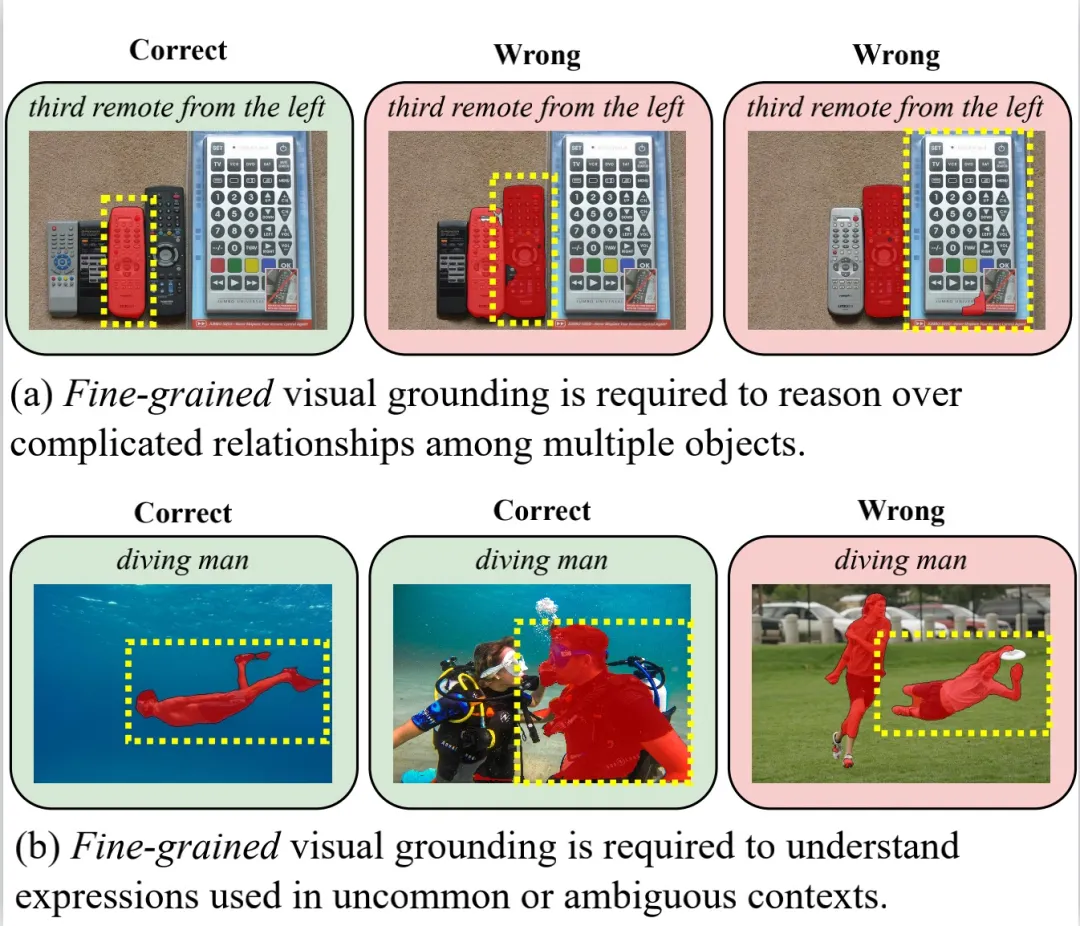

圖 1:細粒度語言 - 圖像對齊能力對 RIS 的重要性示意圖。紅色掩碼是目前最先進的 RIS 算法之一 LAVT 的預測結果,而黃色虛線框則是正確的標注。

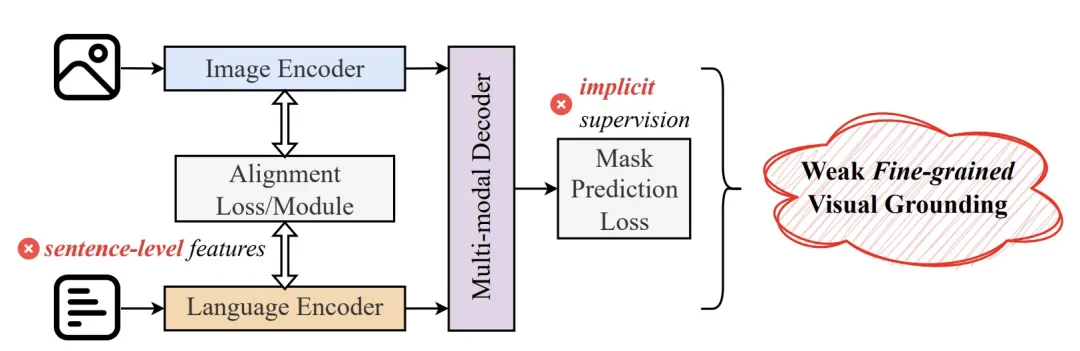

目前的 RIS 研究主要集中在設計新穎的損失函數或引入創新的網絡架構 / 模塊,以增強語言 - 圖像的分布對齊。盡管取得了顯著進展,但仍存在兩個根本性問題,導致它們在細粒度語言 - 圖像對齊(Fine-grained Visual Grounding)方面能力不足:

1. 這些方法主要依賴于句子級別的語言特征進行語言 - 圖像對齊,導致它們在文字級別的語言 - 圖像對齊能力較為薄弱。

2. 這些方法在訓練過程中往往缺乏顯式的監督信號,無法有效地教會模型進行細粒度對齊,導致它們在處理復雜的指代語言時表現不佳。

圖 2:現有算法的缺陷

在近期一篇 CVPR 2024 工作中,來自清華大學自動化系和博世中央研究院的聯合研究團隊設計了一種新的輔助任務 Mask Grounding。通過隨機掩碼部分文本詞匯,并讓算法學習預測其真實身份,這一任務旨在顯式地教會模型學習文本與視覺對象之間的細粒度對應關系。除此之外,他們還提出了一個新穎的跨模態對齊模塊(Cross-modal Alignment Module)和一個新穎的跨模態對齊損失函數 (Cross-modal Alignment Loss),來進一步全面縮小語言和圖像之間的模態差距。基于這些技術,他們設計了一個全新的實例分割網絡架構 Mask-grounded Network (MagNet)。

- 論文標題:Mask Grounding for Referring Image Segmentation

- 論文地址:https://arxiv.org/abs/2312.12198

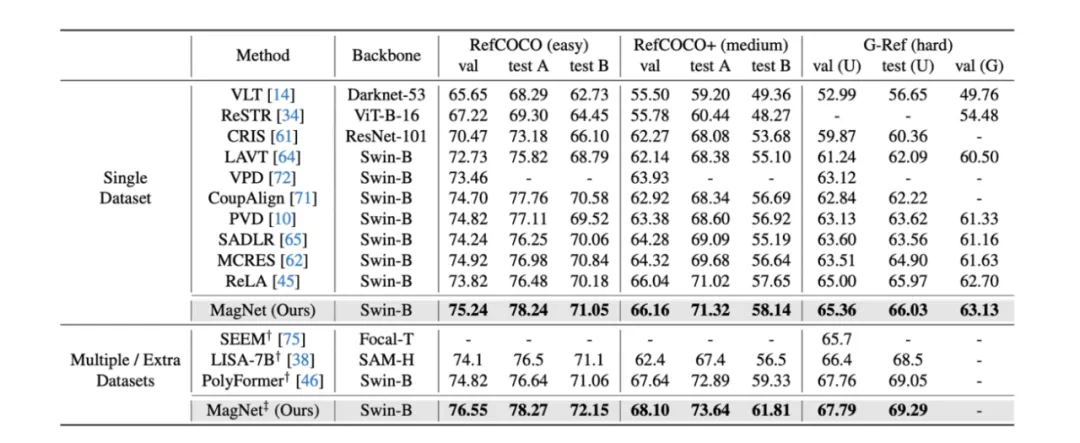

在 RefCOCO、RefCOCO + 和 G-Ref 數據集上,MagNet 大幅超越了所有之前最優的算法,在整體交并比 (oIoU) 這項核心指標上顯著提升了 2.48 個百分點。可視化結果也證實,MagNet 在處理復雜場景和語言表達時具有出色的表現。

方法

MagNet 由 3 個獨立互補的模塊組成,分別為 Mask Grounding,Cross-modal Alignment Module 和 Cross-modal Alignment Loss。

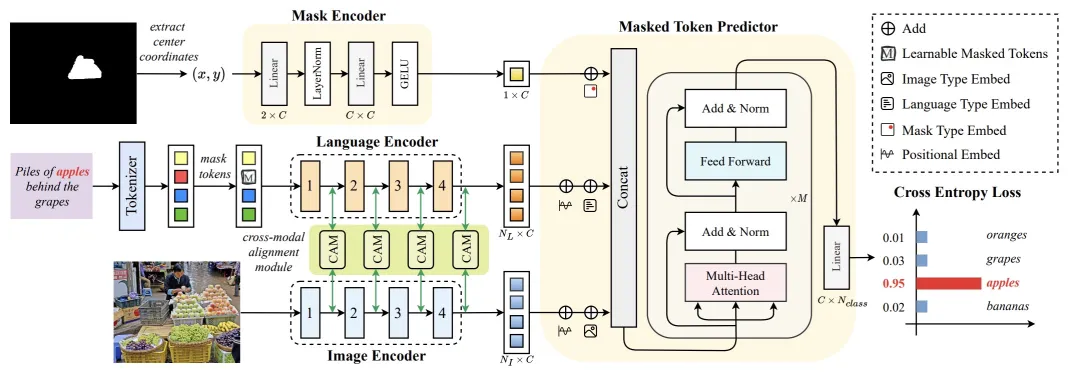

1.Mask Grounding

圖 3:Mask Grounding 流程圖

如圖 3 所示,在給定輸入圖像、對應的指代表達以及分割掩碼的情況下,作者隨機選取句子中的某些詞匯,并將其替換為一個特殊的可學習掩碼 token。然后,訓練模型來預測這些被替換詞匯的實際身份。通過成功預測被掩碼 token 的身份,模型能夠理解文本中的哪些詞匯對應于圖像的哪些部分,從而在此過程中學習細粒度語言 - 圖像對齊能力。為了執行這一輔助任務,首先提取掩碼區域的中心坐標,并將其傳遞給一個 2 層 MLP,以編碼分割掩碼的特征。同時,使用線性層將語言特征映射到與圖像特征相同的維度。然后,使用提出的掩碼 token 預測器聯合處理這些特征,并使用注意力機制模塊來進行掩碼 token 預測。雖然 Mask Grounding 需要通過語言編碼器進行額外的前向傳遞來處理被掩碼的表達式,但由于語言編碼器非常小,整體計算成本幾乎可以忽略不計。

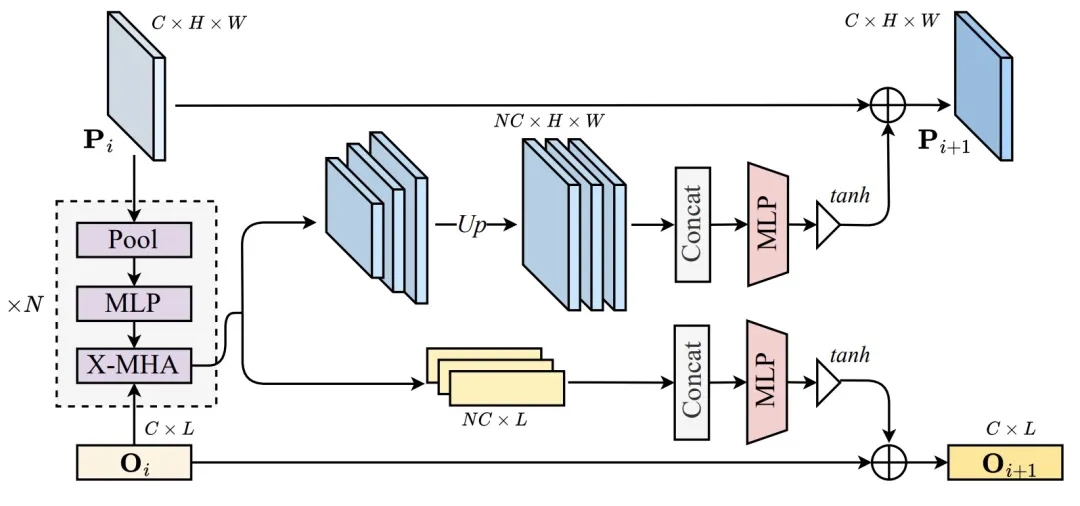

2.Cross-modal Alignment Module (CAM)

圖 4:Cross-modal Alignment Module 結構圖

如圖 4 所示,為了進一步提升模型性能,作者還提出了跨模態對齊模塊(CAM),通過在執行語言 - 圖像融合之前將全局上下文先驗注入圖像特征來增強語言 - 圖像對齊效果。CAM 首先使用不同窗口大小的池化操作生成 K 個不同金字塔尺度的特征圖。然后,每個特征圖通過一個 3 層 MLP 以更好地提取全局信息,并與另一模態進行交叉注意力操作。接下來,所有輸出特征通過雙線性插值上采樣到原始特征圖尺寸,并在通道維度上拼接。隨后,使用一個 2 層 MLP 將拼接后的特征通道數減少回原始維度。為了防止多模態信號淹沒原始信號,使用一個帶有 Tanh 非線性的門控單元來調制最終輸出。最后,這個門控后的特征被加回到輸入特征中,然后傳遞給圖像或語言編碼器的下一階段。在作者的實現中,CAM 被加到圖像和語言編碼器的每個階段末尾。

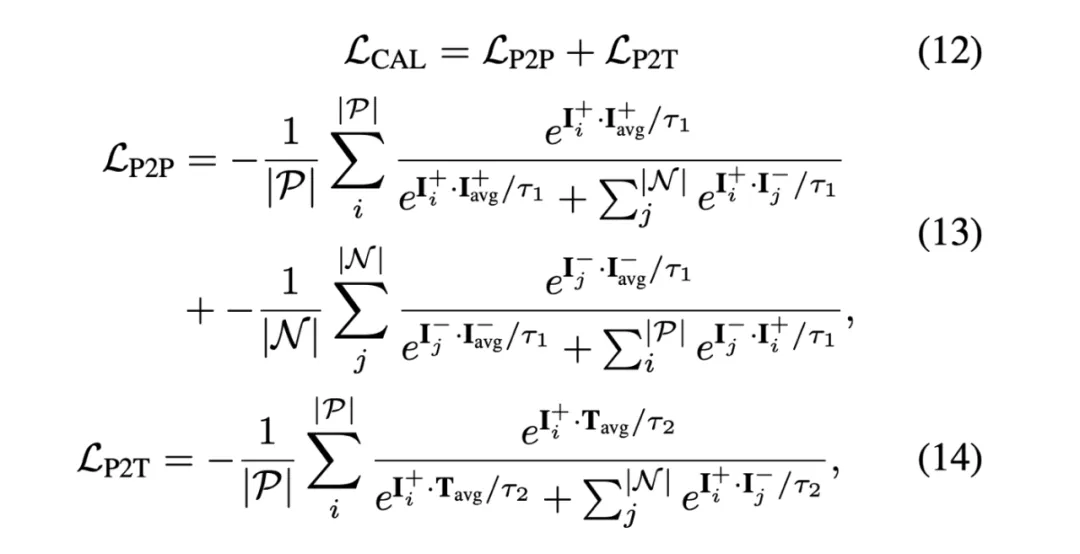

3.Cross-modal Alignment Loss (CAL)

圖 5:Cross-modal Alignment Loss 公式

為了監督模型對齊語言和圖像特征,作者提出了一種新穎的跨模態對齊損失函數 (CAL)。圖五展示了該損失函數的數學公式。與之前工作不同,CAL 同時考慮了像素到像素 (Pixel-to-Pixel,P2P) 和像素到文本 (Pixel-to-Text,P2T) 之間的對齊。精確的像素到像素對齊能確保模型能分割輸出具有準確形狀和邊界的分割掩碼,而精確的像素到文本對齊能使模型能夠正確地將文本描述與其匹配的圖像區域進行合理的關聯。

實驗

在表 1 中,作者使用 oIoU 指標評估 MagNet,并與現有最先進的算法做性能比較。測試數據為 RefCOCO、RefCOCO + 和 G-Ref。在單一和多個 / 額外數據集的設置下,MagNet 的性能在這些數據集上全都是 SOTA。

表 1:實驗結果

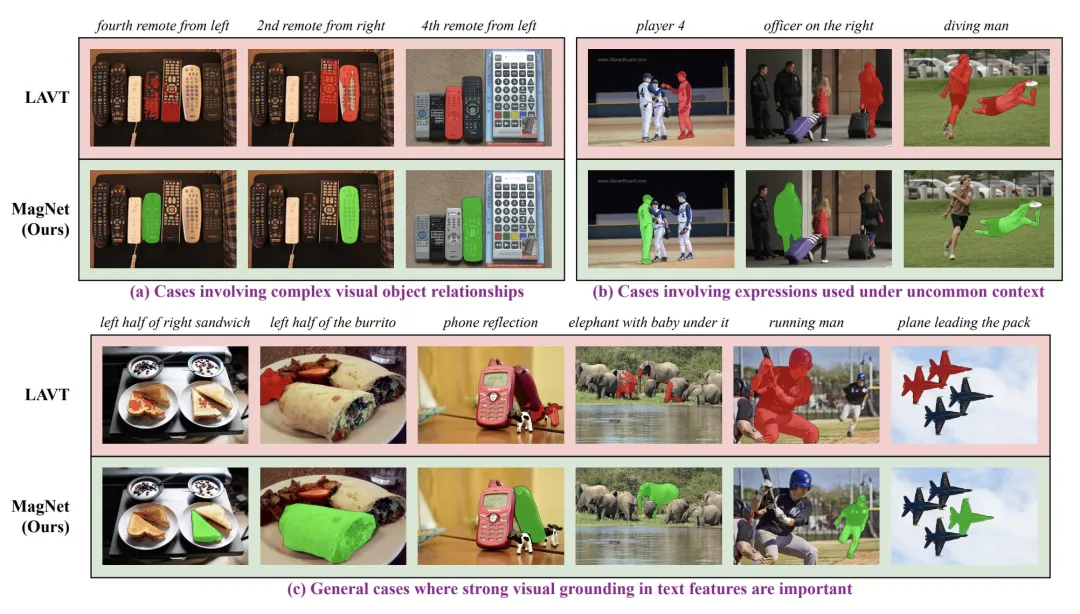

可視化結果

圖 6:MagNet 可視化結果

在圖 6 中,我們可以看到,MagNet 的可視化結果也非常突出,在許多困難的場景中都比對比基準 LAVT 強很多。

小結

這篇文章深入探討了指代分割(RIS)領域的挑戰和當前存在的問題,特別是在細粒度語言 - 圖像對齊方面的不足。針對這些問題,清華大學和博世中央研究院的研究人員提出了一種新的方法,名為 MagNet,通過引入輔助任務 Mask Grounding、跨模態對齊模塊和跨模態對齊損失函數,全面提升了語言和圖像之間的對齊效果。實驗證明,MagNet 在 RefCOCO、RefCOCO + 和 G-Ref 數據集上均取得了顯著優異的性能,超越了之前最先進的算法,表現出了強大的泛化能力。可視化結果也證實了 MagNet 在處理復雜場景和語言表達時的優越性。這一研究為指代分割領域的進一步發展提供了有益的啟示,有望推動該領域取得更大的突破。

團隊介紹

此論文來源于清華大學自動化系(https://www.au.tsinghua.edu.cn)和博世中央研究院(https://www.bosch.com/research/)。其中論文一作莊榮賢為清華大學在讀博士生,并在博世中央研究院實習;項目負責人為邱旭沖博士,任博世中央研究院資深研發科學家;通訊作者為清華大學自動化系黃高教授。

本文轉自 機器之心 ,作者:機器之心