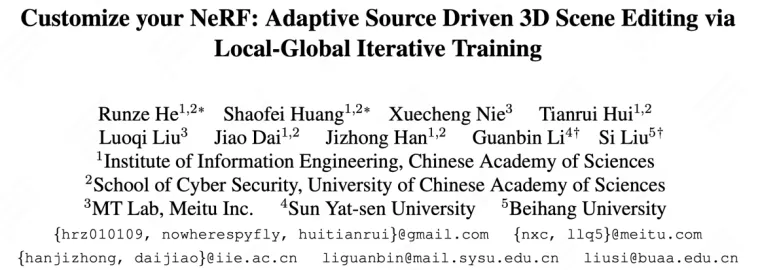

CVPR 2024 | 僅需文本或圖像提示,新框架CustomNeRF精準(zhǔn)編輯3D場(chǎng)景

自 2020 年神經(jīng)輻射場(chǎng) (Neural Radiance Field, NeRF) 提出以來(lái),將隱式表達(dá)推上了一個(gè)新的高度。作為當(dāng)前最前沿的技術(shù)之一,NeRF 快速泛化應(yīng)用在計(jì)算機(jī)視覺(jué)、計(jì)算機(jī)圖形學(xué)、增強(qiáng)現(xiàn)實(shí)、虛擬現(xiàn)實(shí)等領(lǐng)域,并持續(xù)受到廣泛關(guān)注。

有賴于易于優(yōu)化和連續(xù)表示的特點(diǎn),NeRF 在 3D 場(chǎng)景重建中有著大量應(yīng)用,也帶動(dòng)了 3D 場(chǎng)景編輯領(lǐng)域的研究,如 3D 對(duì)象或場(chǎng)景的紋理重繪、風(fēng)格化等。為了進(jìn)一步提高 3D 場(chǎng)景編輯的靈活性,近期基于預(yù)訓(xùn)練擴(kuò)散模型進(jìn)行 3D 場(chǎng)景編輯的方法也正在被大量探索,但由于 NeRF 的隱式表征以及 3D 場(chǎng)景的幾何特性,獲得符合文本提示的編輯結(jié)果并非易事。

為了讓文本驅(qū)動(dòng)的 3D 場(chǎng)景編輯也能夠?qū)崿F(xiàn)精準(zhǔn)控制,美圖影像研究院(MT Lab)與中國(guó)科學(xué)院信息工程研究所、北京航空航天大學(xué)、中山大學(xué),共同提出了一種將文本描述和參考圖像統(tǒng)一為編輯提示的 CustomNeRF 框架,可以通過(guò)微調(diào)預(yù)訓(xùn)練的擴(kuò)散模型將參考圖像中包含的特定視覺(jué)主體 V?嵌入到混合提示中,從而滿足一般化和定制化的 3D 場(chǎng)景編輯要求。該研究成果目前已被 CVPR 2024 收錄,代碼已開(kāi)源。

- 論文鏈接:https://arxiv.org/abs/2312.01663

- 代碼鏈接:https://github.com/hrz2000/CustomNeRF

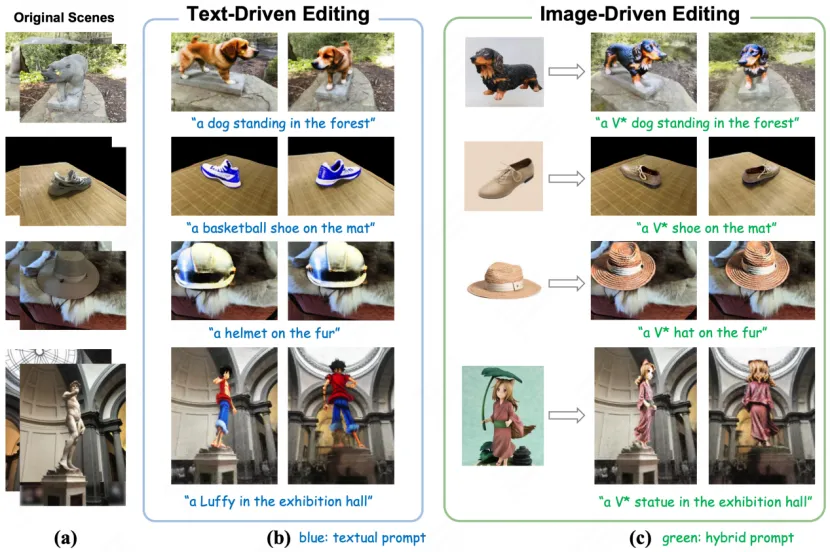

圖 1:CustomNeRF 在文本驅(qū)動(dòng)(左)和圖像驅(qū)動(dòng)(右)的編輯效果

CustomNeRF 解決的兩大挑戰(zhàn)

目前,基于預(yù)訓(xùn)練擴(kuò)散模型進(jìn)行 3D 場(chǎng)景編輯的主流方法主要分為兩類。

其一,是使用圖像編輯模型迭代地更新數(shù)據(jù)集中的圖像,但是受限于圖像編輯模型的能力,會(huì)在部分編輯情形下失效。其二,則是利用分?jǐn)?shù)蒸餾采樣(SDS)損失對(duì)場(chǎng)景進(jìn)行編輯,但由于文本和場(chǎng)景之間的對(duì)齊問(wèn)題,這類方法在真實(shí)場(chǎng)景中無(wú)法直接適配,會(huì)對(duì)非編輯區(qū)域造成不必要的修改,往往需要 mesh 或 voxel 等顯式中間表達(dá)。

此外,當(dāng)前的這兩類方法主要集中在由文本驅(qū)動(dòng)的 3D 場(chǎng)景編輯任務(wù)中,文本描述往往難以準(zhǔn)確表達(dá)用戶的編輯需求,無(wú)法將圖像中的具體概念定制化到 3D 場(chǎng)景中,只能對(duì)原始 3D 場(chǎng)景進(jìn)行一般化編輯,因此難以獲得用戶預(yù)期中的編輯結(jié)果。

事實(shí)上,獲得預(yù)期編輯結(jié)果的關(guān)鍵在于精確識(shí)別圖像前景區(qū)域,這樣能夠在保持圖像背景的同時(shí)促進(jìn)幾何一致的圖像前景編輯。

因此,為了實(shí)現(xiàn)僅對(duì)圖像前景區(qū)域進(jìn)行準(zhǔn)確編輯,該論文提出了一種局部 - 全局迭代編輯(LGIE)的訓(xùn)練方案,在圖像前景區(qū)域編輯和全圖像編輯之間交替進(jìn)行。該方案能夠準(zhǔn)確定位圖像前景區(qū)域,并在保留圖像背景的同時(shí)僅對(duì)圖像前景進(jìn)行操作。

此外,在由圖像驅(qū)動(dòng)的 3D 場(chǎng)景編輯中,存在因微調(diào)的擴(kuò)散模型過(guò)擬合到參考圖像視角,所造成的編輯結(jié)果幾何不一致問(wèn)題。對(duì)此,該論文設(shè)計(jì)了一種類引導(dǎo)的正則化,在局部編輯階段僅使用類詞來(lái)表示參考圖像的主體,并利用預(yù)訓(xùn)練擴(kuò)散模型中的一般類先驗(yàn)來(lái)促進(jìn)幾何一致的編輯。

CustomNeRF 的整體流程

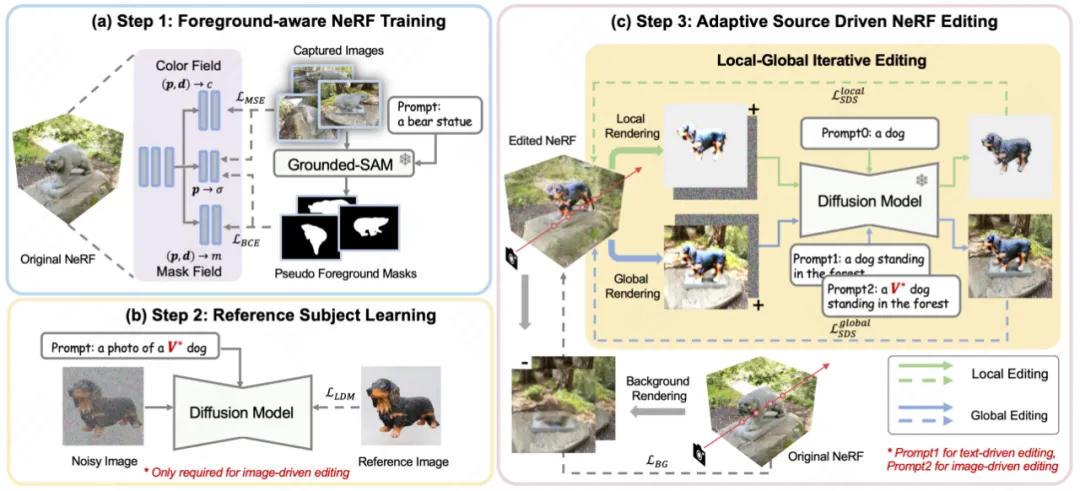

如圖 2 所示,CustomNeRF 通過(guò) 3 個(gè)步驟,來(lái)實(shí)現(xiàn)在文本提示或參考圖像的指導(dǎo)下精確編輯重建 3D 場(chǎng)景這一目標(biāo)。

圖 2 CustomNeRF 的整體流程圖

首先,在重建原始的 3D 場(chǎng)景時(shí),CustomNeRF 引入了額外的 mask field 來(lái)估計(jì)除常規(guī)顏色和密度之外的編輯概率。如圖 2(a) 所示,對(duì)于一組需要重建 3D 場(chǎng)景的圖像,該論文先使用 Grouded SAM 從自然語(yǔ)言描述中提取圖像編輯區(qū)域的掩碼,結(jié)合原始圖像集訓(xùn)練 foreground-aware NeRF。在 NeRF 重建后,編輯概率用于區(qū)分要編輯的圖像區(qū)域(即圖像前景區(qū)域)和不相關(guān)的圖像區(qū)域(即圖像背景區(qū)域),以便于在圖像編輯訓(xùn)練過(guò)程中進(jìn)行解耦合的渲染。

其次,為了統(tǒng)一圖像驅(qū)動(dòng)和文本驅(qū)動(dòng)的 3D 場(chǎng)景編輯任務(wù),如圖 2(b)所示,該論文采用了 Custom Diffusion 的方法在圖像驅(qū)動(dòng)條件下針對(duì)參考圖進(jìn)行微調(diào),以學(xué)習(xí)特定主體的關(guān)鍵特征。經(jīng)過(guò)訓(xùn)練后,特殊詞 V?可以作為常規(guī)的單詞標(biāo)記用于表達(dá)參考圖像中的主體概念,從而形成一個(gè)混合提示,例如 “a photo of a V? dog”。通過(guò)這種方式,CustomNeRF 能夠?qū)ψ赃m應(yīng)類型的數(shù)據(jù)(包括圖像或文本)進(jìn)行一致且有效的編輯。

在最終的編輯階段,由于 NeRF 的隱式表達(dá),如果使用 SDS 損失對(duì)整個(gè) 3D 區(qū)域進(jìn)行優(yōu)化會(huì)導(dǎo)致背景區(qū)域發(fā)生顯著變化,而這些區(qū)域在編輯后理應(yīng)與原始場(chǎng)景保持一致。如圖 2(c)所示,該論文提出了局部 - 全局迭代編輯(LGIE)方案進(jìn)行解耦合的 SDS 訓(xùn)練,使其能夠在編輯布局區(qū)域的同時(shí)保留背景內(nèi)容。

具體而言,該論文將 NeRF 的編輯訓(xùn)練過(guò)程進(jìn)行了更精細(xì)的劃分。借助 foreground-aware NeRF,CustomNeRF 可以在訓(xùn)練中靈活地控制 NeRF 的渲染過(guò)程,即在固定相機(jī)視角下,可以選擇渲染前景、背景、以及包含前景和背景的常規(guī)圖像。在訓(xùn)練過(guò)程中,通過(guò)迭代渲染前景和背景,并結(jié)合相應(yīng)的前景或背景提示,可以利用 SDS 損失在不同層面編輯當(dāng)前的 NeRF 場(chǎng)景。其中,局部的前景訓(xùn)練使得在編輯過(guò)程中能夠只關(guān)注需編輯的區(qū)域,簡(jiǎn)化復(fù)雜場(chǎng)景中編輯任務(wù)的難度;而全局的訓(xùn)練將整個(gè)場(chǎng)景考慮在內(nèi),能夠保持前景和背景的協(xié)調(diào)性。為了進(jìn)一步保持非編輯區(qū)域不發(fā)生改變,該論文還利用編輯訓(xùn)練前的背景監(jiān)督訓(xùn)練過(guò)程中所新渲染的背景,來(lái)保持背景像素的一致性。

此外,圖像驅(qū)動(dòng) 3D 場(chǎng)景編輯中存在著加劇的幾何不一致問(wèn)題。因?yàn)榻?jīng)過(guò)參考圖像微調(diào)過(guò)的擴(kuò)散模型,在推理過(guò)程中傾向于產(chǎn)生和參考圖像視角相近的圖像,造成編輯后 3D 場(chǎng)景的多個(gè)視角均是前視圖的幾何問(wèn)題。為此,該論文設(shè)計(jì)了一種類引導(dǎo)的正則化策略,在全局提示中使用特殊描述符 V*,在局部提示中僅使用類詞,以利用預(yù)訓(xùn)練擴(kuò)散模型中包含的類先驗(yàn),使用更幾何一致的方式將新概念注入場(chǎng)景中。

實(shí)驗(yàn)結(jié)果

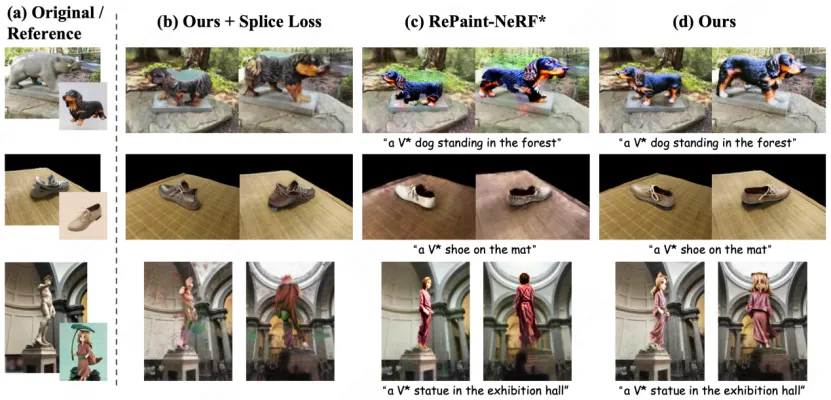

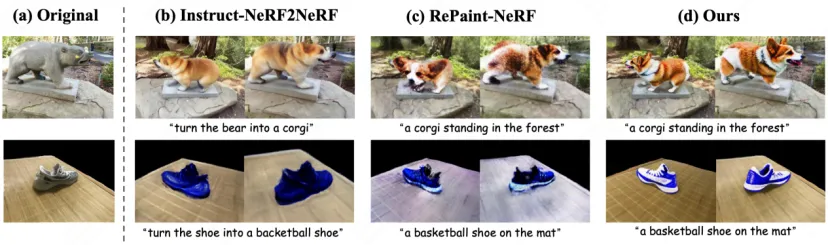

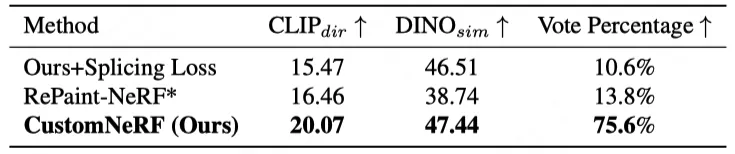

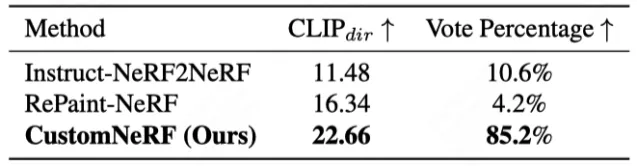

如圖 3 和圖 4 展示了 CustomNeRF 與基線方法的 3D 場(chǎng)景重建結(jié)果對(duì)比,在參考圖像和文本驅(qū)動(dòng)的 3D 場(chǎng)景編輯任務(wù)中,CustomNeRF 均取得了不錯(cuò)的編輯結(jié)果,不僅與編輯提示達(dá)成了良好的對(duì)齊,且背景區(qū)域和原場(chǎng)景保持一致。此外,表 1、表 2 展示了 CustomNeRF 在圖像、文本驅(qū)動(dòng)下與基線方法的量化比較,結(jié)果顯示在文本對(duì)齊指標(biāo)、圖像對(duì)齊指標(biāo)和人類評(píng)估中,CustomNeRF 均超越了基線方法。

圖 3 圖像驅(qū)動(dòng)編輯下與基線方法的可視化比較

圖 4 文本驅(qū)動(dòng)編輯下與基線的可視化比較

表 1 圖像驅(qū)動(dòng)編輯下與基線的定量比較

表 2 文本驅(qū)動(dòng)編輯下與基線的定量比較

總結(jié)

本論文創(chuàng)新性地提出了 CustomNeRF 模型,同時(shí)支持文本描述或參考圖像的編輯提示,并解決了兩個(gè)關(guān)鍵性挑戰(zhàn) —— 精確的僅前景編輯以及在使用單視圖參考圖像時(shí)多個(gè)視圖的一致性。該方案包括局部 - 全局迭代編輯(LGIE)訓(xùn)練方案,使得編輯操作能夠在專注于前景的同時(shí)保持背景不變;以及類引導(dǎo)正則化,減輕圖像驅(qū)動(dòng)編輯中的視圖不一致,通過(guò)大量實(shí)驗(yàn),也驗(yàn)證了 CustomNeRF 在各種真實(shí)場(chǎng)景中,能夠準(zhǔn)確編輯由文本描述和參考圖像提示的 3D 場(chǎng)景。

本文轉(zhuǎn)自 機(jī)器之心 ,作者:機(jī)器之心