數字人動畫革命!全球首創4D運動建模技術,超越第二名65%的爆款黑科技MTVCrafter來了

論文鏈接:https://arxiv.org/pdf/2505.10238

代碼鏈接:https://github.com/DINGYANB/MTVCrafter

亮點直擊

- MTVCrafter,首個直接建模原始4D動作(而非2D渲染姿態圖像)用于開放世界人像動畫生成的流程,實現了復雜三維世界中的動畫生成。

- 4DMoT,一種新穎的 4D 動作tokenizer,能夠將原始人體動作數據編碼為緊湊而富有表現力4D 動作token,相較于 2D 圖像表示提供了更穩健的時空引導。

- 設計了MV-DiT,一種具備運動感知能力的視頻 DiT 模型,配備了獨特的 4D 動作注意力機制和 4D 位置編碼,從而實現了由 4D 動作 token 有效引導的動畫生成。

- MTVCrafter 在 TikTok 基準上實現了SOTA性能,在 FID-VID 指標上超越第二名達65%。

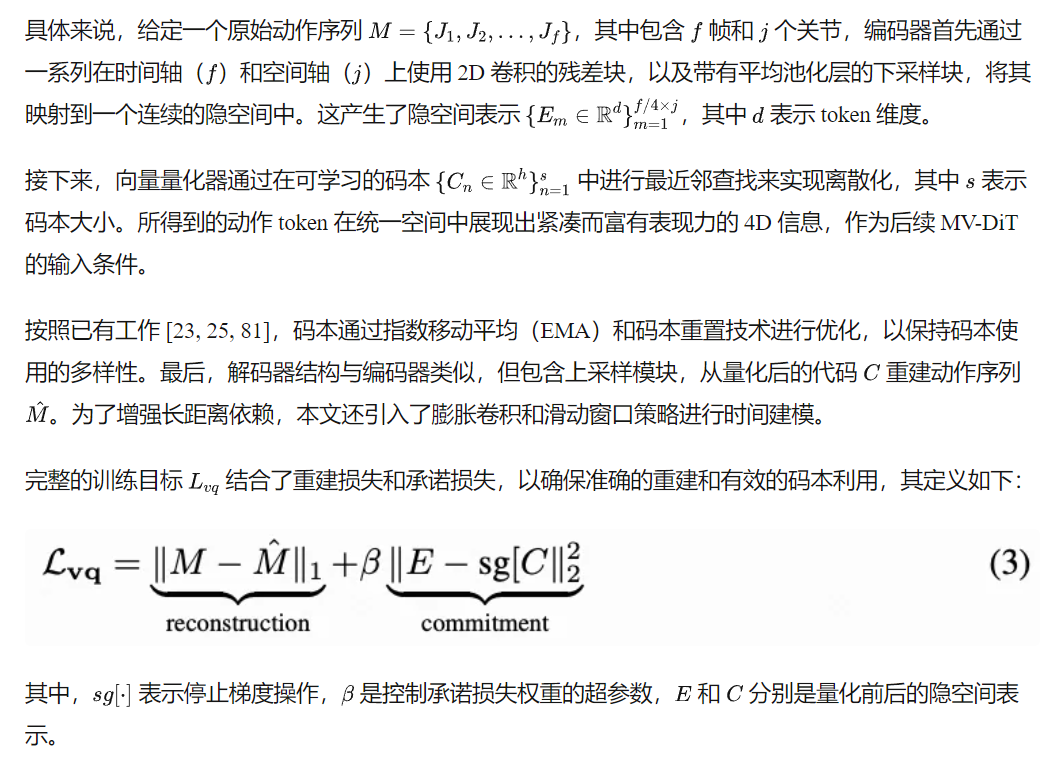

圖1,MTVCrafter 還具有良好的泛化能力,能夠適應未見過的動作和角色,包括單人或多人、全身或半身角色,覆蓋多種風格和場景。

總結速覽

解決的問題

現有人像動畫方法的局限性:當前方法主要依賴于二維渲染的姿態圖像進行動作引導,這種方式存在兩個主要問題:

- 泛化能力差:二維圖像難以適應多樣化角色和開放世界場景。

- 三維信息缺失:忽略了真實動作中的三維結構,限制了動畫的真實感與表現力。

提出的方案

- MTVCrafter 框架:首個直接建模原始三維動作序列(即 4D 動作)的通用人像動畫生成框架,能夠在復雜的三維世界中生成高質量動畫。

- 核心思想:不再使用 2D 姿態圖像作為中間表示,而是引入更加緊湊且表達力強的4D 動作 token,從而提供更穩健的時空提示。

應用的技術

- 4DMoT(4D Motion Tokenizer):

- 將三維動作序列量化為 4D 動作 token。

- 提供更強的時空引導信息,避免像素級對齊問題,實現更靈活的控制。

- MV-DiT(Motion-aware Video DiT):

- 基于 DiT 架構的視頻生成模型。

- 引入4D 動作注意力機制 和 4D 位置編碼,有效融合動作 token,用于指導視頻生成。

達到的效果

- 生成質量領先:在 TikTok基準測試集上,MTVCrafter 在FID-VID 指標上達到 6.98,**超越第二名 65%**,實現當前SOTA性能。

- 強泛化能力:

- 支持單人/多人、全身/半身角色。

- 適用于多種風格和復雜場景,能夠處理未見過的動作和角色。

- 推動領域發展:首次實現基于原始 4D 動作的人像視頻生成,為姿態引導視頻生成開辟了新方向。

方法

概述

介紹了用于 4D 動作分詞的 4DMoT。所得到的 4D 動作 token 相較于 2D 渲染的姿態圖像展現出更強的時空提示能力。然后介紹MV-DiT,它在強大的 DiT 架構中利用 4D 動作 token 作為視覺上下文。該模型具有獨特的 4D 動作注意力機制,結合 4D 位置編碼和具備運動感知能力的無分類器引導(CFG),能夠實現由緊湊而富有表現力的 4D 動作 token 引導的開放世界動畫生成。

4D 動作分詞器

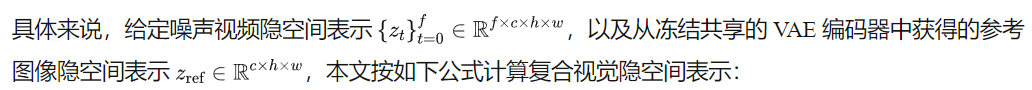

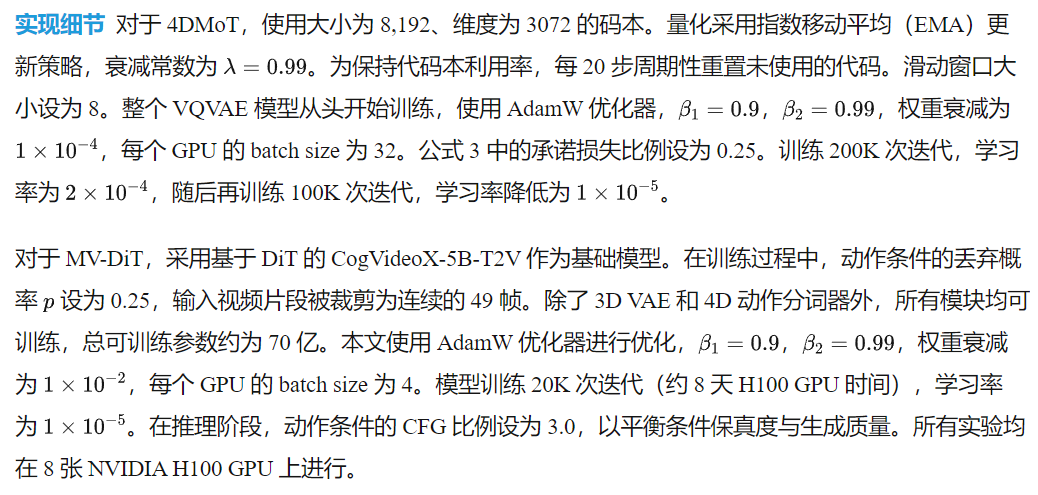

為了利用豐富的 4D 引導信息驅動人像圖像動畫,本文從驅動視頻中提取 SMPL序列作為條件輸入。盡管已有工作 [6, 8, 18] 也使用了 SMPL,但它們通常將 3D 網格簡單渲染為 2D 圖像作為條件,這種方式在開放世界動畫中常常導致運動表示不足,如下圖 2 所示。相比之下,本文直接將原始 SMPL 序列分詞為 4D 動作 token。首先,構建 SMPL 動作-視頻序列的訓練數據集。然后,設計了一個 4D 動作 VQVAE(見圖 3)來學習無噪聲的動作表示。

4DMoT 的模型架構 由于 VQVAE 架構被廣泛應用于下游任務中的離散分詞[24, 79, 80],采用并構建了其結構。如下圖 3 所示,4DMoT 包含一個用于動作序列重建的編碼器-解碼器結構,以及一個輕量級的量化器用于學習離散的動作 token。編碼器-解碼器在 4D 動作中保持時空一致性,而量化器則使得學習緊湊而富有表現力的 4D 動作表示成為可能。

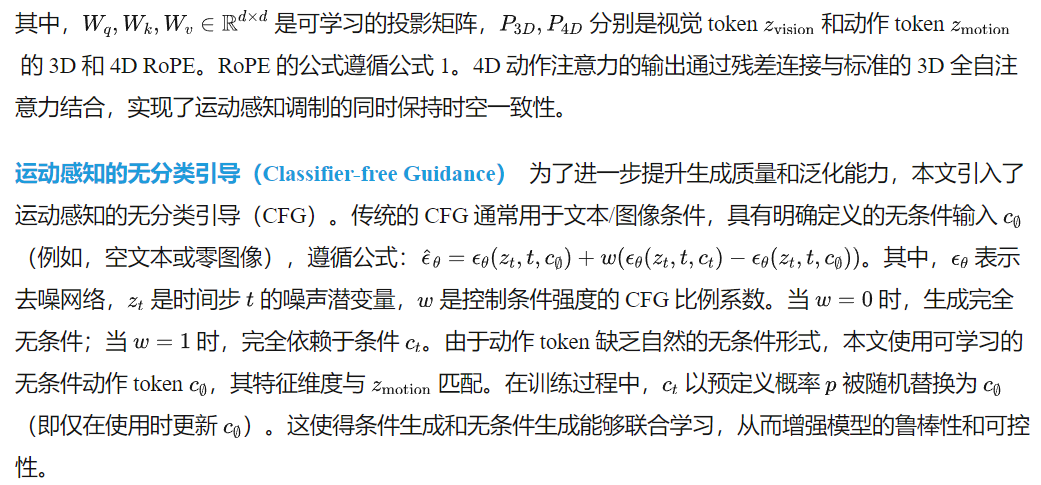

四維動作視頻擴散 Transformer

在獲得 4D 動作 token 后,目標是有效地利用它們進行人物圖像動畫生成。本節將介紹如何將 4D 動作 token 作為條件集成到視頻 DiT 模型中。設計包含四個關鍵組件:參考圖像保留、4D 位置編碼、4D 動作注意力以及具備運動感知的無分類器引導。

參考圖像保留 在人物圖像動畫中,保持視覺和時間一致性仍然是一項關鍵挑戰。與之前的方法 [2, 6, 7, 15, 19] 不同,這些方法使用與去噪模型結構相同的參考網絡來單獨學習參考圖像,本文的 MV-DiT 采用了一種簡單而有效的重復-拼接策略。

這些拼接后的隱空間表示隨后被劃分為小塊并投影,以匹配注意力 token 的維度。得益于 DiT 中的 3D 全自注意力機制,模型在生成過程中可以直接與參考圖像特征進行交互,從而無需額外的參考網絡即可高效地保留身份信息。

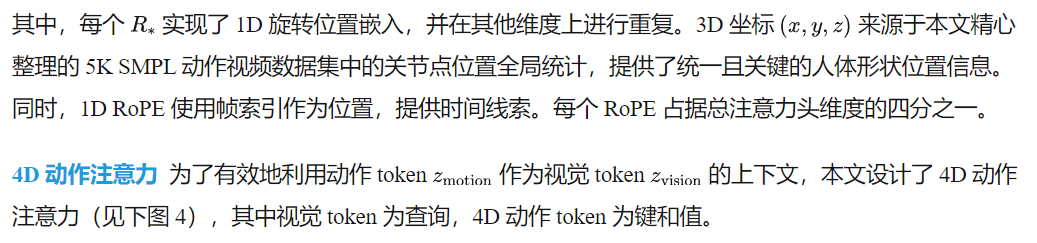

4D 位置編碼 為了增強 4D 動作 token 的時空信息,引入了簡潔的 4D RoPE,它結合了 1D 時間和 3D 空間的 RoPE。與標準的3D表達形式[30, 33]不同,4D RoPE 能夠捕捉到更優的4D動作位置信息:

注意力機制的公式如下:

4 實驗

數據集與指標 遵循先前的工作 [2, 21, 62],使用 TikTok 數據集中的序列 335 到 340 進行測試。評估基于六個指標:圖像級指標包括峰值信噪比(PSNR)、結構相似性指數(SSIM)、感知圖像補丁相似性(LPIPS)、Fréchet Inception 距離(FID);視頻級指標包括視頻級 FID(FID-VID)和 Fréchet 視頻距離(FVD)。

SOTA 對比

本文進行了與現有方法的定性和定量對比。定性對比如上圖 1 和下圖 5 所示,MTVCrafter 在姿態準確性和身份一致性方面展現了最佳的動畫表現。此外,MTVCrafter 具有強大的泛化能力,能夠處理單人或多人、全身或半身的外觀,以及多樣的風格、動作和場景。更重要的是,即使目標姿態與參考圖像不對齊(例如下圖 5 中的牛仔),MTVCrafter 依然表現出穩健性,說明其能夠有效地將動作從驅動視頻中解耦。這一問題無法通過 Champ [18] 或 UniAnimate [63] 等簡單嘗試將姿態重定向以匹配參考圖像比例的方法從根本上解決。

在定量對比中,如下表 1 所示,MTVCrafter 在 TikTok 數據集上在所有指標上均取得了最優性能,尤其是在 FID 和 FID-VID 上表現突出。這突顯了直接建模動作序列而非渲染姿態圖像的優勢。對于 SSIM 和 PSNR,各方法結果相近,差異不大,因為這些是面向圖像超分辨等任務的低級指標。

消融實驗

為了驗證本文關鍵設計的有效性,本文對 4D 動作分詞器(MT)、4D 動作注意力(MA)和 CFG 進行了消融實驗。如下表 2 所示,本文通過修改或移除特定組件來評估不同變體,并測量它們在 TikTok 數據集上的影響。

動作分詞器(MT) 研究了移除向量量化器的影響。沒有量化時,VQVAE 退化為一個標準的自動編碼器,直接處理連續且不一致的動作特征,導致性能下降(例如,上表 2 中 FID-VID 從6.98上升到9.79 )。這證實了使用離散且統一的動作 token 對于穩定動作學習至關重要。此外,量化還有助于提升開放世界動畫的泛化能力。

動作注意力(MA) 探索了多種位置編碼(PE)設計用于動作注意力模塊:

- 動態 PE 使用第一幀的關節點坐標計算 RoPE,但由于不穩定性和訓練困難表現較差;

- 可學習 PE 難以收斂,未能提供可靠的位置提示;

- 一維時間 RoPE 僅在時間軸上應用 RoPE;

- 三維空間 RoPE 僅在空間軸上應用 RoPE。這兩種方式都未能建模完整的 4D 依賴關系,導致如身份漂移或抖動等視覺偽影;

- 無 PE 完全移除位置編碼,整體表現最差(FVD:235.57 對比140.60 ,SSIM:0.717 對比0.784 ),突出顯示了顯式位置信息的重要性。

為了更好地說明效果,在下圖 6 中提供了可視化消融。圖中生動展示了分詞器和 4D RoPE 的有效性,帶來了更好的動作質量和角色保真度。

運動感知的無分類引導(CFG) 下圖 7 展示了運動感知 CFG 比例w的定性和定量評估。在 TikTok 基準上,CFG 比例為3.0時表現最佳,尤其是在 FVD 指標上。對于 FID-VID 指標,該比例的影響較小。在右側的可視化對比中,增加 CFG 比例增強了姿態對齊,但也引入了更多偽影,并可能降低視頻質量。

結論

MTVCrafter,一個新穎的框架,直接對原始動作序列進行 token 化,而不是依賴于二維渲染的姿態圖像進行人物視頻生成。通過在 DiT 中集成 4D 動作 VQVAE 和動作注意力,MTVCrafter 有效地保持了時空一致性和身份保真度,同時實現了角色與動作的解耦。實驗顯示其在多樣角色與動作上的 SOTA 表現和強泛化能力,為該領域設立了新的范式。

本文轉自AI生成未來 ,作者:AI生成未來