突破Prompt瓶頸:鏈式思維+雙階段獎勵,港大等開源GoT-R1讓多物體合成更神準!

論文鏈接: https://arxiv.org/pdf/2505.17022 Git鏈接: https://github.com/gogoduan/GoT-R1

亮點直擊

- GoT-R1框架,該框架通過強化學習增強視覺生成中的語義-空間推理能力,使模型能夠自主發現有效的推理策略,而不僅僅依賴預定義的模式。

- 設計了一個全面的雙階段多維度獎勵框架,從多個角度評估中間推理過程和最終視覺輸出,有效應對視覺生成中強化學習所面臨的獨特挑戰。

- 在T2I-CompBench基準測試上展示了顯著的性能提升,尤其是在需要精確空間關系和屬性綁定的組合任務中表現出色。

總結速覽

解決的問題

視覺生成模型雖然在根據文本提示生成圖像方面取得了進展,但在應對包含多個對象、精確空間關系和屬性綁定的復雜提示時仍面臨挑戰。現有方法缺乏對語義內容與空間布局的顯式推理能力,難以生成結構合理、語義一致的圖像。

提出的方案

為應對上述挑戰,提出了GoT-R1 框架,該框架基于“生成思維鏈(Generation Chain-of-Thought)”理念,結合強化學習,引導模型在視覺生成過程中進行逐步推理,從而實現更高質量的圖像合成。

應用的技術

- 強化學習機制:用于訓練模型自主學習有效的推理策略,擺脫對預定義模板的依賴。

- 雙階段多維度獎勵框架:

- 第一階段:評估中間推理過程;

- 第二階段:評估最終圖像輸出。

- 評估維度涵蓋語義一致性、空間準確性和視覺質量。

- 多模態大模型(MLLMs)輔助評估:利用強大的多模態理解能力對推理過程和圖像質量進行綜合判斷。

達到的效果

在 T2I-CompBench 基準測試中,GoT-R1 在需要復雜組合推理的任務中表現優異,特別是在涉及精確空間關系和屬性綁定的圖像生成任務中取得了顯著性能提升,成功推動了視覺生成技術的發展。

方法

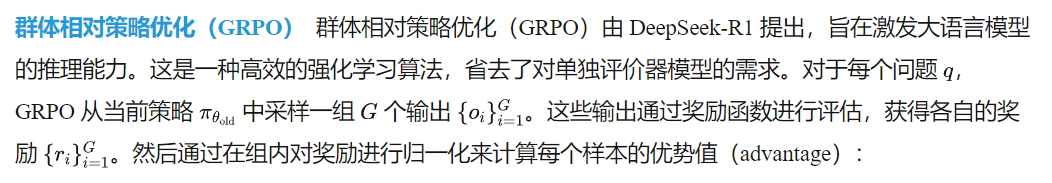

本節將介紹GoT-R1 框架的詳細內容。首先回顧前置知識,包括生成思維鏈(Generation Chain-of-Thought, GoT)范式和群體相對策略優化(Group Relative Policy Optimization, GRPO)算法。然后,描述 GoT-R1 框架的網絡架構和訓練策略。最后詳細闡述基于多模態大模型(MLLM)的雙階段多維度獎勵設計。該獎勵系統全面評估提示、推理過程與生成圖像之間的一致性,從而為強化學習提供全面的監督信號。

前置知識

生成思維鏈(GoT) 生成思維鏈(GoT)是一種在輸出圖像之前,通過顯式的視覺-語義鏈式推理過程來轉化視覺生成的方法。與傳統的文本到圖像生成方法直接將文本嵌入映射為視覺特征不同,GoT 將復雜提示拆解為包含語義描述和空間坐標的推理鏈。例如,給定提示 “一只狗和一只貓一起玩耍”,一個GoT推理鏈可能包括諸如 “一只頑皮的棕色狗” ,坐標為(100,200),(350,450) ,以及 “一只橘色虎斑貓”,坐標為(400,250),(650,500)的描述,明確指定每個對象的語義屬性和空間位置。這種顯式的鏈式推理使得對對象屬性、空間布局和對象間關系的精確控制成為可能,顯著提升了生成圖像的組合保真度。

為了賦予生成模型推理能力,GoT 構建了大規模的訓練數據,利用手工設計的模板標注推理鏈。GoT 框架通過監督方式在標注數據上進行訓練,以生成推理鏈和圖像。然而,這種方法本質上受到訓練數據中手工設計且固定推理模板的限制,阻礙了模型在多樣化場景中發現更有效推理策略的能力。此外,通過監督微調訓練的 GoT 框架容易生成模板化但有時不忠實的推理鏈,從而限制了后續視覺生成的效果。

策略隨后通過優化以下目標函數進行更新:

GoT-R1 框架

GoT-R1 基于文本到圖像生成的生成思維鏈(GoT)框架,通過引入強化學習來增強語義-空間推理能力。如前所述,盡管 GoT 為組合圖像生成提供了堅實的基礎,但其效果受限于訓練數據中預定義的推理模板。本文框架通過強化學習使模型能夠自主發現更優的推理策略,同時保持端到端的優化過程,從而克服這一限制。

網絡架構采用一個統一的多模態大模型(MLLM)作為基礎架構,該模型聯合建模文本和圖像 token。例如,Janus-Pro 能夠在單一模型中處理視覺理解和生成任務,將圖像作為離散 token 與文本 token 一起進行聯合自回歸建模。這一架構使我們能夠以端到端的方式生成文本推理鏈和視覺輸出,實現整個生成過程的全面優化。

訓練策略本文基礎模型在沒有思維鏈推理過程的文本到圖像生成任務上進行了預訓練。為了激發其推理能力,訓練過程分為兩個階段:

- 第一階段,使用 GoT 數據集 中的推理鏈和生成圖像標注對預訓練模型進行微調(SFT)。該階段建立了在生成圖像 token 之前生成模板化推理鏈的基本能力,為后續的強化學習提供了良好的初始化。

- 第二階段,應用強化學習引導模型探索自由形式且更有效的推理鏈。對于每個提示P ,我們采樣N個不同的推理鏈及其對應的圖像。這些樣本隨后通過我們設計的多維度獎勵函數進行評估,該函數同時考察推理質量和生成保真度。模型參數通過 GRPO 進行更新,以鼓勵高獎勵的推理策略和生成圖像,并抑制低獎勵的樣本。我們獎勵函數的具體設計將在下一小節詳細介紹,該函數旨在應對評估視覺推理質量的獨特挑戰。

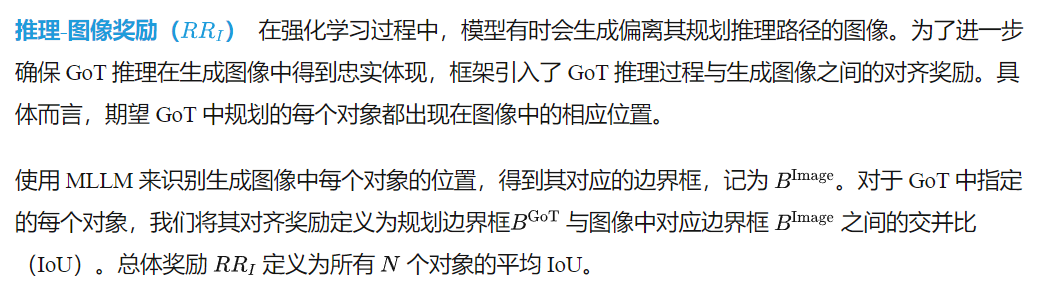

基于 MLLM 的雙階段多維度獎勵

GoT-R1 生成框架由兩個階段組成:從提示生成推理鏈,以及從推理鏈生成圖像。一個直接的強化學習集成方式是基于提示-圖像對齊的端到端獎勵。然而,如果不對中間的推理過程進行顯式約束,推理鏈可能無法忠實反映提示,或與最終圖像不一致,從而削弱生成流程的可解釋性和可控性。為了引導模型進行忠實且一致的生成,設計了一個結合結果與中間過程監督的雙階段獎勵機制。

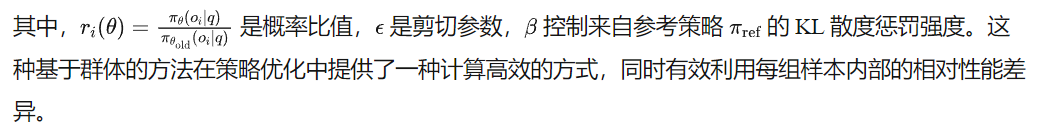

本文定義了三類獎勵:

MLLM 在該場景中作為獎勵模型具有獨特優勢,因為它們具備強大的跨模態理解和推理能力。經過大規模圖文對訓練,MLLM 能夠在語義一致性和空間布局等多個維度上,對推理鏈與生成圖像進行統一、可解釋且細粒度的評估。這使得它們非常適合作為強化學習中的獎勵函數,而傳統指標往往難以提供細致的多維反饋。獎勵機制如下圖 3 所示。

- 完整性(Completeness):推理鏈是否包含提示中提到的所有概念?

- 忠實性(Faithfulness):是否引入了與提示相矛盾的內容?

- 一致性(Consistency):推理是否在邏輯上與描述的場景一致?

- 清晰度(Clarity):內容是否連貫且格式正確?

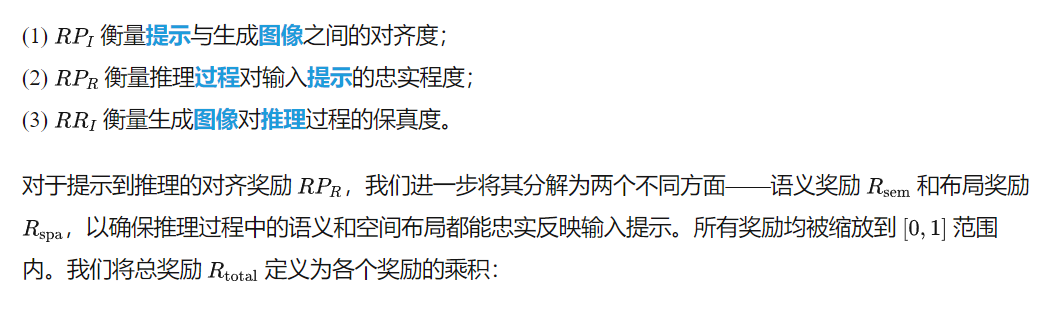

為彌補這一能力差距,提出了一種創新的基于 MLLM 的布局評估方法,其核心觀察是:MLLM 在處理視覺數據時展現出優于文本坐標的空間理解能力。因此,將文本坐標轉換為圖像,通過在空白畫布上渲染相應的邊界框來實現。采用這種視覺格式后,MLLM 展現出顯著更強的空間理解能力,并能對推理鏈的空間正確性提供清晰準確的評分。下圖 4 展示了該過程的示意圖。

實驗

訓練設置

分別基于 Janus-Pro-1B 和 Janus-Pro-7B 訓練了兩個模型。我們的訓練過程包含兩個階段:在 GoT-T2I 數據集上的預訓練,以及使用構造的提示集進行的在線 GRPO強化學習。使用 LAHR-GoT、JourneyDB-GoT和 FLUX-GoT數據集對模型進行預訓練,共進行 70000 步,然后進行 1000 步的 GRPO 訓練。

定量評估

下表 2 展示了在 T2ICompBench 上的文本到圖像(T2I)生成性能評估。將模型與三類主流方法進行比較:(1) 使用凍結編碼器直接將文本輸入映射為圖像的擴散模型;(2) 兩階段模型,先規劃結構化布局,然后據此生成圖像;(3) 融合 LLM 或 MLLM 的自回歸模型以增強生成能力。

GoT-R1 框架在組合式文本到圖像生成中建立了新的最先進水平。在僅進行 1000 步 GRPO 微調后,它在多個評估指標上提升了最多 15%。GoT-R1-7B 在六個評估類別中的五個中獲得最高分,并在復雜基準測試中表現出顯著優勢,該測試包含混合自然語言的組合提示。在形狀類別中,GoT-R1-7B 表現與 FLUX 相當。

本文的 7B 模型在所有類別中遠超其他布局引導模型。GoT-R1-1B 的性能也優于 Janus-Pro-7B,甚至在顏色屬性上超過了 FLUX。這些提升凸顯了將結構化推理過程與強化學習優化相結合在組合圖像合成中的有效性。

定性評估

下圖 5 展示了基礎模型 Janus-Pro-7B、GoT 微調后的模型 Janus-Pro-7B-GoT,以及我們通過 GRPO 增強的模型 GoT-R1-7B 之間的定性比較。我們展示了來自組合提示的生成示例,這些提示涉及多個屬性、相對空間關系和對象數量。

雖然 GoT 微調模型生成的圖像質量高于基礎模型,但在復雜組合生成方面仍存在困難。相比之下,GoT-R1-7B 展現出更強的提示對齊能力,即使是非自然提示也能準確反映在生成結果中。此外,GoT-R1-7B 能夠生成細節豐富且美學上令人滿意的視覺內容。

這些提升主要歸因于基于 MLLM 的獎勵設計,它指導模型在 GoT 推理過程與輸出圖像之間優化語義和空間對齊。通過利用 MLLM 的細粒度評估,獎勵機制使 GoT-R1-7B 不僅在視覺質量上表現出色,還能忠實捕捉復雜提示的意圖。

自探索生成推理鏈分析

為了評估推理質量,將 GoT-R1-7B 的自探索生成推理鏈與 Janus-Pro-7B-GoT 的預定義 GoT 進行了比較。GPT-4o對來自 T2I-CompBench 的 Color、Spatial 和 Complex 三個類別中每類隨機抽取的 100 個提示,以及來自 LAION-5B 的 100 個提示進行了 GoT 內容評估。

評判基于四個標準:與輸入提示的相關性、對象描述和邊界框的準確性、文本的清晰度和流暢性。 如下表 3 所示,GPT-4o 在所有評估類別中都更傾向于 GoT-R1-7B 的自探索推理。這一強烈偏好強調了 GoT-R1 在自主發現和生成更優推理路徑方面的能力,這是其提升組合生成能力的關鍵因素。

獎勵設計的消融研究

對基于 MLLM 的雙階段多維獎勵和關鍵訓練設置進行了全面的消融研究,以驗證其貢獻。所有消融實驗均在 T2I-CompBench 上進行,使用基于 Janus-Pro-1B-GoT 檢查點的 GRPO 訓練 1000 步,該模型作為我們的基線。結果顯示在上表 2 和下表 4 中,評估時使用的引導尺度為 5。

結論與討論

GoT-R1,一種通過將強化學習應用于語義-空間推理顯著提升視覺生成的新框架。基于 Generation Chain-of-Thought 方法,GoT-R1 使模型能夠自主發現有效的推理策略,突破了預定義模板的限制。一個關鍵創新是雙階段多維獎勵系統,它利用 MLLM 全面評估中間推理過程和最終視覺輸出,確保在整個生成流程中提供穩健的監督。該獎勵機制評估了諸如語義對齊和空間準確性等關鍵方面。

評估結果表明,GoT-R1 在 T2I-CompBench 上表現優越,尤其在需要精確空間關系和屬性綁定的復雜組合任務中表現出色。通過成功將自探索的復雜推理能力遷移到視覺生成領域,GoT-R1 推進了當前技術水平,并為創建更精確、具備上下文感知能力的視覺內容開辟了新路徑。然而,與所有強大的生成式AI一樣,負責任地開發和部署此類技術至關重要,以減輕潛在風險(如被濫用于虛假信息傳播),并確保其在倫理上的應用。

本文轉自AI生成未來 ,作者:AI生成未來