智能體設計新范式:從任務執行者到環境探索者,讓智能體像人類一樣成長 精華

當前大多數智能體框架沿襲自頂向下(Top-Down)的設計思路——人類事先定義目標、拆解任務,并構建工作流供智能體執行。這種方法在封閉環境中表現卓越,但當智能體需要在開放、非結構化環境中自主適應和學習時,它們往往力不從心。

問題的癥結在于傳統的智能體設計過于依賴人工干預,無法自主進化。在自頂向下工作流中,智能體的能力主要依賴預定義的API、任務提示和專家設計的執行路徑。但現實世界并非一個由任務明確、結構清晰的操作手冊所支撐的環境——相反,它充滿了不確定性、動態變化和復雜的交互模式。于是,一種新的范式逐漸被提出:自底向上(Bottom-Up)智能體設計,它模仿人類學習過程,讓智能體通過探索、推理和經驗積累逐步成長,而不再僅僅依賴人工設定的工作流。

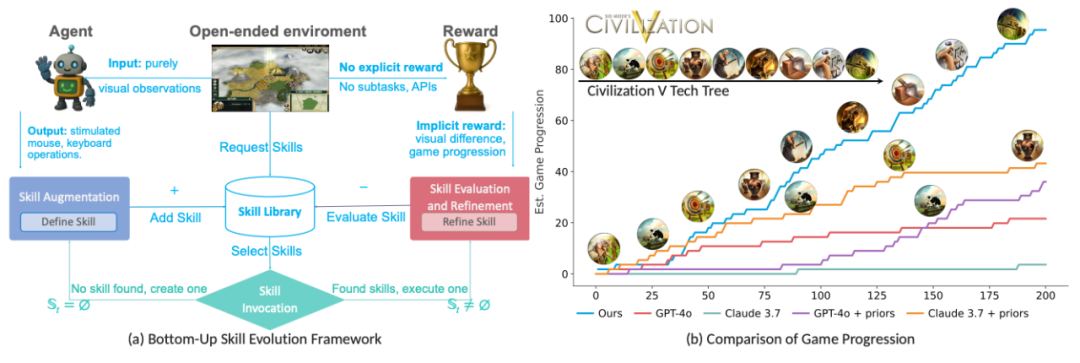

圖1:代理設計的兩種范式。大多數現有的代理框架可以歸類為自上而下的代理,它們依賴于預先設計的架構:它們從高級目標開始,將其分解為子任務,并使用特定于任務的API和工具執行工作流。相比之下,我們建議自下而上的智能體充當探索者:從零先驗知識開始,它們通過試驗和推理逐漸獲得技能,通過環境變化推斷出的隱性獎勵自主進化。

回溯人工智能的發展,我們不難發現自頂向下設計范式的合理性。早期的智能體系統,如ReAct、Plan-and-Solve、AutoGPT等,都遵循類似的模式:給定一個復雜任務,人類會將其分解為可執行的子任務,并設計對應的工作流。智能體的任務是遵循這些流程,高效執行,并在必要時進行調整。這一框架有三個核心問題:

1.靜態性:智能體的改進完全依賴于人類的更新,而不是基于自身經驗進行演化。

2.先驗依賴:必須依靠預定義的任務提示、API才能執行任務,而在開放環境中,這些先驗知識可能不存在或難以獲取。

3.令牌消耗:智能體的大部分計算資源被用于遵循預設流程,而非基于環境變化進行推理和調整。

對于標準化任務,如數據處理、自動化腳本執行,這種模式仍然十分有效。但在開放世界任務中,如游戲、自動駕駛、智能機器人等,這些智能體無法自主學習或適應新環境,必須依賴人工調整或重新設計工作流。

面對自頂向下方法的局限性,研究人員開始思考——能否讓智能體像人類一樣,從環境中自主學習技能,而非依賴預設流程? 這一設想與Silver和Sutton提出的“經驗時代(Era of Experience)”理念相契合。人類的技能并非通過固定的任務執行得來,而是經歷試錯、推理和技能歸納的過程。相比傳統的方法,自底向上智能體設計更強調探索、技能進化和適應能力。

圖2:左:自底向上代理僅對原始視覺輸入進行操作,并模擬低級鼠標和鍵盤操作。在沒有明確獎勵的情況下,它會根據視覺變化或游戲進度等隱含信號學習和改進技能。右圖:游戲進度由《文明V》的技術樹和視覺變化來衡量。我們的自底向上代理(藍色)的表現優于所有基線,包括那些具有任務相關先驗的基線。

該研究提出了一種新的智能體范式:

- 智能體從零開始,無需先驗知識。

- 通過環境交互,智能體自主學習新技能。

- 技能可共享與優化,使智能體群體得以持續演化。

這一方法的核心優勢在于,它避免了人為設定任務的局限性,讓智能體能夠在完全未知的環境中自主學習、進化,并適應挑戰。

本研究由來自多個知名機構的研究人員共同完成,他們在人工智能、智能體學習、強化學習與高性能計算等領域具有豐富經驗,他們是來自新加坡科技研究局(A*STAR)前沿人工智能研究中心(CFAR)、高性能計算研究所(IHPC)、新加坡國立大學(NUS)、清華大學、電子科技大學(UESTC)的Jiawei Du, Jinlong Wu, Yuzheng Chen, Yucheng Hu, Bing Li, Joey Tianyi Zhou。

這些研究人員的合作涉及智能體技能學習、強化學習優化、大型語言模型推理、計算機視覺等領域,他們共同推進了自底向上智能體設計的落地與驗證。

此外,他們已開源該研究的代碼,可在 GitHub 訪問。

論文鏈接:??https://arxiv.org/abs/2505.17673??

項目地址:??https://github.com/AngusDujw/Bottom-Up-Agent??

1.方法論(Meth?odology)

我們一直在思考如何讓智能體變得更智能、更自主、更適應復雜環境,自頂向下的設計方式強調任務規劃和結構化執行,但它的局限性在于,智能體只能嚴格按照預設的路徑工作,缺乏靈活性。而自底向上的方法則不同,它讓智能體從環境中學習,在試錯中進化,在經驗積累中找到高效的行動策略。這種范式的背后,是嚴謹的數學建模和理論支持。

圖3:自下而上技能演變概述。代理從沒有預定義技能開始,通過交互逐漸構建其庫S。左:新技能是通過用原子動作擴展現有例程而逐步組成的。中間:通過視覺語言模型(VLM)比較執行前和執行后的狀態來評估技能;無效的通過LLM推理進行改進或丟棄。右:在每個時間步,根據當前狀態xt選擇候選集St,并通過蒙特卡洛樹搜索(MCTS)進行評估[40],以選擇最有前途的技能。所有組件都在統一的推理框架下運行,沒有特權API,允許代理純粹從經驗中獲得能力。

為了讓智能體能夠真正從經驗中成長,研究團隊采用了部分可觀察馬爾可夫決策過程(POMDP)作為理論基礎。這一方法的核心思想是,智能體無法直接看到整個環境的狀態,而只能基于有限的觀測信息來做決策。環境由四個關鍵元素構成:觀察空間 X(智能體的視覺輸入)、動作空間 A(智能體可執行的原子操作,如鼠標點擊或鍵盤輸入)、未知的狀態轉換函數 T以及隱含獎勵 R。智能體的目標是通過不斷交互,從這些有限的信息中推測出最優的決策方式。

其中,智能體的技能被定義為一組可組合的原子動作,例如:

技能庫 S 記錄智能體已掌握的所有技能,并隨著時間逐步擴展。每個技能還具備一個語義描述dσ,它由LLM生成,幫助智能體理解技能的意圖并進行優化:

為了讓智能體自主形成技能并優化它們,研究團隊設計了技能演化機制。首先是技能增強(Augmentation),智能體從單步動作開始,嘗試不同的行為組合,并觀察哪些操作能帶來環境變化。智能體不會盲目探索,而是采用增量式構建:

也就是說,智能體會在一個已有的技能序列基礎上,嘗試添加一個新動作,并觀察它是否能帶來顯著環境變化。如果無法產生可見影響,該序列將被丟棄,確保智能體只學習有意義的行為。

在技能調用(Invocation)階段,智能體需要判斷當前環境適用哪些已有技能。它不會簡單地隨機選擇,而是采用蒙特卡洛樹搜索(MCTS)來評估候選技能集:

蒙特卡洛樹搜索通過模擬不同技能的執行結果,選擇最可能帶來長期收益的技能,確保智能體的行為更加高效。

技能庫不會一成不變,智能體需要不斷優化已學技能。在技能評估與優化(Refinement)過程中,研究團隊設計了一種隱式獎勵機制:

這個公式的三個部分分別對應:

- 行為多樣性,確保智能體的技能庫不被過度重復的技能填滿;

- 執行效率,避免智能體采用冗長的無效動作;

- 語義對齊,確保技能的意圖和實際執行效果一致。

智能體通過不斷調整技能庫,丟棄低效技能,并利用LLM生成優化后的語義描述,使技能庫不斷精煉。

研究團隊在Algorithm 1中詳細列出了技能學習與優化的完整步驟,并在圖3中展示了技能庫隨時間增長的過程。這一框架不僅賦予智能體自主學習能力,還確保它們能在復雜環境中快速適應,最終變得越來越智能。

2.實例化自底向上智能體

在人工智能不斷向更具適應性和自主性的方向演化時,如何證明一個智能體真正能夠在沒有明確指引的情況下學習、適應并進化?研究團隊選擇了兩個極具挑戰性的游戲環境——《殺戮尖塔》和《文明5》,作為自底向上智能體的測試場所。這兩款游戲的共同特點是,它們沒有固定的任務結構、沒有預設的獎勵機制,也不提供任務子目標或專用 API。

這意味著,智能體無法依賴傳統的任務規劃或預定義執行路徑,而必須完全基于環境反饋來調整行為。更重要的是,這兩款游戲都模擬了人類的操作方式:智能體只能通過像素級視覺輸入感知環境,并使用鼠標點擊和拖動執行動作,與人類玩家的交互方式完全一致。

在這樣的環境中,視覺感知成為智能體理解世界的唯一方式。這也是為什么研究團隊采用Segment Anything Model(SAM)作為視覺解析工具,使智能體能夠自動識別界面中的關鍵元素,如按鈕、菜單、資源信息等。SAM 賦予智能體一種類似人類的視覺處理能力,使它能夠區分不同的 UI 組件,并在交互過程中自主推理哪些元素可能是可點擊目標。

智能體不會事先知道游戲規則,而是必須通過視覺信息和試錯來建立自己的操作邏輯。例如,在《文明5》中,智能體需要理解如何移動單位、如何選擇科技發展,而在《殺戮尖塔》中,它必須學會如何拖拽卡牌攻擊敵人。沒有預設的 API,智能體只能通過觀察界面變化,推測自己的行為是否有效,這種方式極大地接近人類玩家的真實體驗。

一個關鍵問題是,如何保證同一架構能夠在不同環境中都正常工作?研究團隊刻意設計了一種環境無關的推理機制,使得智能體在《殺戮尖塔》和《文明5》中使用完全相同的架構,而不需要針對每個游戲進行特殊優化。這意味著,無論智能體處于何種游戲環境,它都會遵循同樣的技能發現、調用和優化邏輯,并在不同環境下不斷成長。

然而,當前技能庫仍然具有一定的環境特定性:在《文明5》中學會的單位移動策略,并不能直接遷移到《殺戮尖塔》卡牌拖拽任務中。未來,如何實現技能的泛化,使得智能體能夠在不同任務場景下復用已有技能,是進一步優化的關鍵。

這項實驗不僅展示了智能體如何在完全開放的環境中自主獲取技能,也為未來人工智能的發展提供了重要啟示。隨著技術進步,我們或許會看到智能體不僅能在不同游戲間學習,還能跨越虛擬世界與現實世界,在更復雜的環境中不斷進化。

3.實驗設計與評估分析

如果讓智能體完全從零開始學習技能,它們是否真的能夠像人類一樣,在經驗中成長,并不斷優化自己的行動策略?這是研究團隊通過實驗所要回答的核心問題。為了測試自底向上智能體的表現,他們選擇了兩個開放式游戲環境:《殺戮尖塔》和《文明5》。這兩款游戲的獨特之處在于,它們沒有預定義任務、沒有明確的獎勵機制,也沒有專門的API,智能體必須完全依靠環境交互來學習如何執行任務。

圖4:技能演變和重用分析。(a)隨著時間的推移,技能庫的大小會通過增加(+)和修剪(-)而增加。(b)《砍倒尖塔》中十大最常被調用的技能。(c)跨環境的組合技能繼承示例,展示了如何從原子動作構建更高級的例程。

在實驗設計上,研究團隊確保所有智能體在相同難度級別和回合制模式下運行,避免任何先驗知識的影響。為了觀察智能體的成長過程,每個智能體都被限制在1000步的最大交互次數,通常需要約 6.5 小時來完成一輪實驗。在這樣的限制下,智能體必須學會高效利用時間和交互數據,以便在有限的資源內最大化自己的進度和技能獲取。實驗中的主要評估指標包括:

游戲進度:在《殺戮尖塔》中衡量通過的層數,在《文明5》中計算完成的回合數

策略發展:累計游戲分數和已解鎖的科技數量

技能執行響應率:智能體執行動作后導致環境變化的成功率

令牌成本:計算 LLM 在整個實驗中的推理資源消耗,并轉換為美元成本

在兩款游戲中,自底向上智能體的表現遠遠優于所有基線智能體。尤其是在《殺戮尖塔》中,所有傳統方法在沒有任務先驗的情況下無法取得任何進展,而自底向上的智能體成功突破 13 層,游戲分數達到 81,并且執行響應率高達 98.56%。在《文明5》中,自底向上智能體完成 50 個回合,解鎖 8 項科技,展示了較強的探索和適應能力。相比之下,即便基線方法在有任務先驗的情況下稍微提升了性能,它們仍然無法像自底向上智能體那樣自主優化策略,在開放環境下持續學習。

進一步的分析表明,智能體的技能庫隨著時間增長,不僅新增了有用技能,同時也剪除了低效技能。在實驗的幾個輪次中,智能體的技能庫規模不斷擴大,新技能增強,同時無用的技能被剔除,使整體效率逐步提高。從技能調用頻率來看,最常使用的技能逐漸從基本交互(點擊、拖拽)演化為更復雜的策略性技能,這種技能繼承和優化過程與人類的學習模式非常相似。

圖5:自下而上代理的提示和執行可視化。(a)用于技能增強和調用的與環境無關的提示,使推理無需訪問游戲特定的API。(b)我們設計了一個GUI,在游戲過程中可視化代理的執行狀態,顯示候選動作、選定目標、推理元數據和相應的技能計劃樹。

消融實驗揭示了智能體學習機制中的幾個關鍵組件對整體性能的影響。其中,視覺變化過濾確保智能體不會學習無效技能,缺失這一組件會導致大量無用操作被保留,從而浪費計算資源。蒙特卡洛樹搜索(MCTS)是長時序決策中的關鍵機制,如果移除它,智能體幾乎無法取得任何進展,導致任務失敗率大幅上升。而LLM 生成的技能描述則幫助智能體整理和優化其行為,使技能庫更加系統化。任何一個組件的消除都會嚴重削弱智能體的學習能力,影響游戲進度、分數和執行效率。

實驗結果不僅展示了自底向上智能體的學習潛力,還提供了未來優化方向的思考。如何讓智能體在不同環境間遷移技能?是否可以進一步減少探索開銷,讓智能體更快地找到有效策略?這些問題在研究的下一階段將成為關注重點。

4.討論與廣泛影響

自底向上智能體設計的提出,標志著人工智能領域的一個重要突破。它的最大優點在于自主學習能力的提升,讓智能體可以不依賴人工定義的任務,而是通過探索環境來積累經驗。它不僅解決了傳統自頂向下方法的靜態性問題,還使得智能體能夠隨著環境變化不斷優化自身的決策邏輯。

通過試錯和推理,智能體可以逐步形成完整的技能庫,并在多智能體協作中實現知識共享。這種進化方式使得智能體更具適應性,能夠在開放世界任務中有效發揮作用,尤其適用于自動駕駛、智能機器人以及復雜策略模擬等領域。

自底向上方法仍然面臨一些技術挑戰,其中最主要的問題是探索開銷過高。由于智能體必須依賴試錯來發現有效技能,它需要進行大量無效交互才能找到最優策略。這不僅導致計算資源的消耗增加,也限制了智能體的實際部署效率。此外,技能泛化困難也是一個值得關注的問題。當前的技能庫往往受到環境限制,智能體在某個游戲或任務中學習到的技能并不能直接遷移到另一個任務環境。例如,在《殺戮尖塔》中掌握的卡牌拖拽技能,無法直接用于《文明5》的單位調度任務。

如何實現技能的通用化,使得智能體能夠在不同任務環境間復用已有技能,是未來研究的關鍵方向。除此之外,長時序策略不足也是一個問題。盡管智能體能夠學習短期技能并優化自身行動,它在長期戰略規劃上的能力仍然有限。現有的隱式獎勵機制更多依賴視覺變化作為反饋,但對于那些需要長期積累才能產生效果的決策,例如文明發展、資源管理等,智能體仍然難以準確識別并執行最優策略。

未來研究可以從多個方面展開,優化技能發現機制可以減少探索開銷,讓智能體在更短的時間內找到高效技能。這可能涉及強化學習技術的結合,使智能體能夠更快地識別哪些行為值得嘗試,而不是完全依賴試錯。探索跨環境遷移的方法,可以讓智能體在不同任務場景下共享技能。這可能涉及視覺語言模型(VLM)與知識圖譜的結合,使技能能夠以更高層次的抽象方式存儲和調用。此外,融合記憶機制也是一個可能的方向。當前智能體在每個任務環境中都是從零開始學習,如果能夠引入長期記憶,使得它可以依賴過去的經驗來調整當前行動,可能會極大提升學習效率。

在多智能體協同方面,異步探索可能會導致技能庫的不一致問題。多個智能體在不同環境下發現并優化技能,但這些技能如何協調更新,避免沖突或冗余?未來可以考慮去中心化協調策略,例如基于信任機制的技能共享模型,或者采用版本控制技術,使得智能體可以根據任務需求選擇最適合的技能版本。

此外在大規模智能體部署時,如何保證智能體在不同任務環境中自主優化,并保持共享技能庫的合理性?這可能涉及動態權重分配,讓智能體能夠優先學習那些被其他智能體驗證過有效的技能,而不是盲目嘗試新技能。

自底向上智能體設計雖然仍處于早期階段,但它展示了智能體從執行者向探索者轉變的可能性。這不僅推動了人工智能的發展,也讓我們開始重新思考智能體如何真正具備學習和進化能力。隨著計算資源的優化、新技術的融合以及跨環境遷移的突破,我們可能會看到越來越多的智能體具備真正的適應性,從游戲世界走向現實世界,最終成為自主智能系統的一部分。(END)

參考資料:???https://arxiv.org/pdf/2505.17673??

本文轉載自??獨角噬元獸??,作者:FlerkenS