首個(gè)自回歸文生圖風(fēng)格化!StyleAR突破AI繪圖新高度:單張圖+提示詞,完美復(fù)刻任意風(fēng)格!

論文鏈接:https://arxiv.org/pdf/2505.19874

項(xiàng)目鏈接:https://stylear.github.io/

代碼鏈接:https://github.com/wuyi2020/StyleAR

亮點(diǎn)直擊

- 提出了一種訓(xùn)練框架,使 AR 模型能夠利用二元文本到圖像數(shù)據(jù)執(zhí)行風(fēng)格對(duì)齊的文本到圖像生成,避免了在指令微調(diào)過程中擴(kuò)展文本-圖像-圖像三元組數(shù)據(jù)的困難。

- 提出了一種風(fēng)格增強(qiáng) tokens(style-enhanced tokens)技術(shù),有效解決了風(fēng)格對(duì)齊文本到圖像生成任務(wù)中的內(nèi)容泄露問題,并顯著提升了提示詞遵循性和風(fēng)格一致性。

- StyleAR在提示詞遵循性和風(fēng)格一致性方面均達(dá)到了SOTA性能,超越了現(xiàn)有的基于擴(kuò)散的方法。此外,StyleAR還能有效集成額外條件,如深度圖和其他結(jié)構(gòu)控制信息。

總結(jié)速覽

解決的問題

- 當(dāng)前多模態(tài)自回歸(AR)模型雖在視覺生成中表現(xiàn)優(yōu)異,但在風(fēng)格對(duì)齊的文本到圖像生成任務(wù)中仍面臨挑戰(zhàn)。

- 該任務(wù)需要構(gòu)建“文本-圖像-圖像”三元組數(shù)據(jù)(包含提示詞、參考風(fēng)格圖像和目標(biāo)圖像),但大規(guī)模獲取這類具有特定風(fēng)格的三元組數(shù)據(jù)十分困難。

- 現(xiàn)有方法在訓(xùn)練中容易出現(xiàn)內(nèi)容泄露問題,影響生成圖像的風(fēng)格一致性和語義對(duì)齊。

提出的方案

- 提出一種新方法StyleAR,通過結(jié)合特定的數(shù)據(jù)整理策略與自回歸模型,利用二元文本-圖像數(shù)據(jù)(而非三元組)實(shí)現(xiàn)風(fēng)格對(duì)齊的圖像生成。

- 使用參考風(fēng)格圖像和提示詞合成風(fēng)格化圖像,僅將合成圖像作為圖像模態(tài)參與訓(xùn)練,從而規(guī)避三元組數(shù)據(jù)構(gòu)建的困難。

- 將原始圖像與風(fēng)格化圖像混合使用,增強(qiáng)模型的風(fēng)格理解能力。

應(yīng)用的技術(shù)

- 數(shù)據(jù)整理方法:利用擴(kuò)散模型生成風(fēng)格化圖像,構(gòu)建高質(zhì)量的二元訓(xùn)練數(shù)據(jù)。

- CLIP 圖像編碼器 + Perceiver 重采樣器:將圖像輸入轉(zhuǎn)化為風(fēng)格 tokens (style tokens),與文本模態(tài)對(duì)齊。

- 風(fēng)格增強(qiáng)tokens 技術(shù)(Style-Enhanced Tokens):解決內(nèi)容泄露問題,提升風(fēng)格一致性。

- 訓(xùn)練框架設(shè)計(jì):使 AR 模型可以在無三元組數(shù)據(jù)的情況下完成風(fēng)格對(duì)齊的文本到圖像生成。

達(dá)到的效果

- 成功規(guī)避了依賴三元組數(shù)據(jù)的限制,降低了數(shù)據(jù)獲取成本。

- 實(shí)驗(yàn)表明,StyleAR 在提示詞遵循性和風(fēng)格一致性方面均超過現(xiàn)有擴(kuò)散方法,達(dá)到了當(dāng)前最先進(jìn)的性能。

- 能夠有效集成額外條件控制信息(如深度圖和結(jié)構(gòu)約束),具備良好的擴(kuò)展性和通用性。

- 大規(guī)模定量評(píng)估、定性實(shí)驗(yàn)與用戶研究驗(yàn)證了該方法的有效性和先進(jìn)性。

方法

預(yù)備知識(shí)

然后,這些圖像 tokens 會(huì)被展平成長度為h x w的序列,并與文本tokens 連接后輸入到基于 Transformer 的自回歸模型中進(jìn)行訓(xùn)練。

在推理階段,給定文本 tokens ,自回歸模型可以通過下一個(gè)tokens 預(yù)測來生成圖像tokens :

最后,生成的圖像tokens t通過圖像解碼器被轉(zhuǎn)換為像素空間。

數(shù)據(jù)整理

本方法的主要貢獻(xiàn)之一集中在數(shù)據(jù)整理部分。如果目標(biāo)是創(chuàng)建用于指令跟隨微調(diào)的三元組數(shù)據(jù),雖然可以使用 InstantStyle來生成此類數(shù)據(jù),但這些數(shù)據(jù)存在風(fēng)格一致性低的問題,并且使得擴(kuò)散模型的能力邊界成為 AR 模型的上限。相比之下,在數(shù)據(jù)生成過程中舍棄了參考風(fēng)格圖像,僅使用提示詞和生成的風(fēng)格化圖像來構(gòu)建二元數(shù)據(jù)。通過這種方式,獲得了高質(zhì)量的風(fēng)格化二元數(shù)據(jù),并避免了低風(fēng)格一致性的問題。

此外,通過實(shí)踐實(shí)驗(yàn)發(fā)現(xiàn),如果僅依賴此風(fēng)格化數(shù)據(jù)集進(jìn)行模型訓(xùn)練,模型在推理階段捕捉圖像特征的能力不盡如人意,這導(dǎo)致生成圖像與參考風(fēng)格圖像之間的風(fēng)格一致性仍然較低。此外,考慮到文本到圖像生成任務(wù)在預(yù)訓(xùn)練階段的模型特性,其訓(xùn)練集大多由未風(fēng)格化的原始圖像組成。如果我們只使用風(fēng)格化數(shù)據(jù)集進(jìn)行訓(xùn)練,領(lǐng)域差異會(huì)給模型訓(xùn)練過程帶來困難。鑒于此,在訓(xùn)練我們的 StyleAR 時(shí),我們同時(shí)使用原始圖像數(shù)據(jù)集和風(fēng)格化圖像數(shù)據(jù)集,并以一定比例作為訓(xùn)練數(shù)據(jù)集。

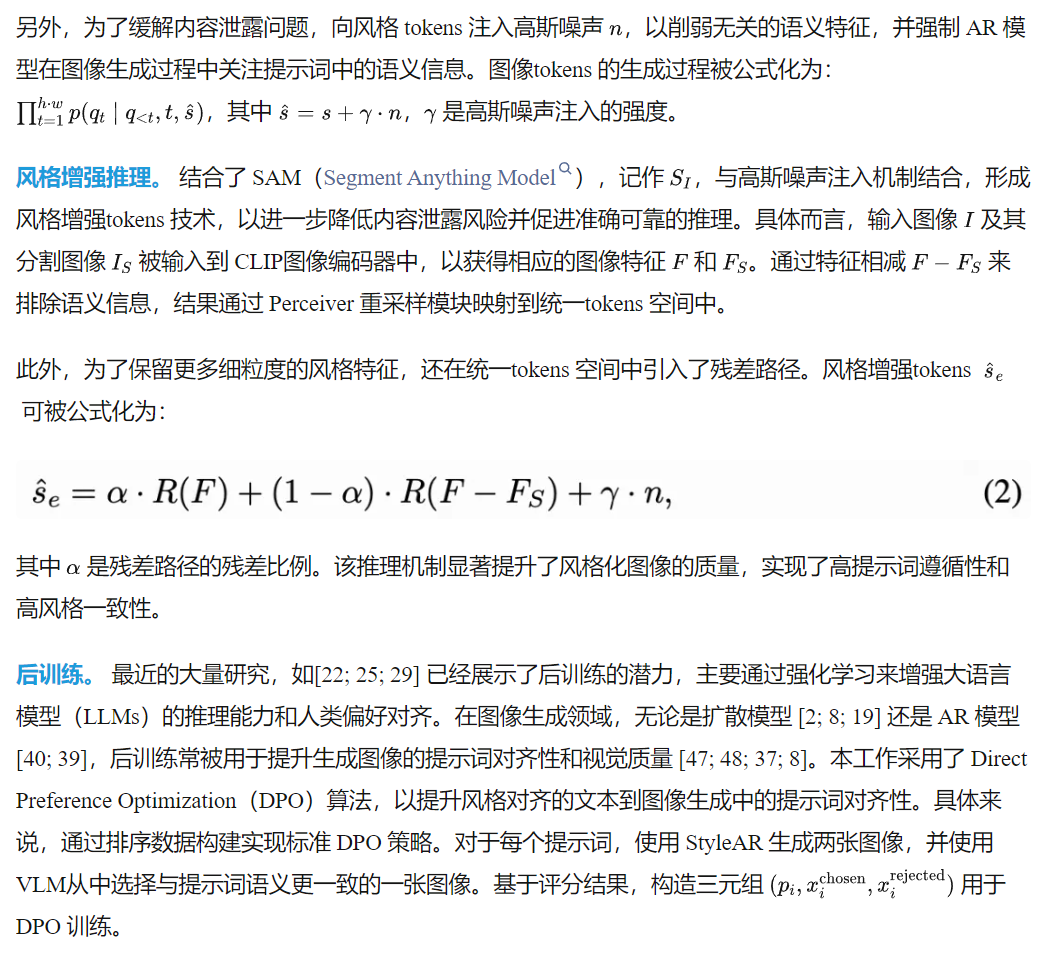

StyleAR 框架

實(shí)驗(yàn)

實(shí)驗(yàn)細(xì)節(jié)

評(píng)估指標(biāo)細(xì)節(jié)。 參考已有工作[10; 18; 30; 12],使用 CLIPT指標(biāo)評(píng)估提示詞遵循性,該指標(biāo)是輸入提示詞的 CLIP 文本嵌入與對(duì)應(yīng)生成圖像的 CLIP 圖像嵌入之間的余弦相似度。CLIP-I 和 DINO指標(biāo)用于評(píng)估風(fēng)格一致性,該指標(biāo)是參考風(fēng)格圖像與對(duì)應(yīng)生成圖像的圖像嵌入之間的余弦相似度。為了穩(wěn)健地衡量方法的性能與泛化能力,我們收集了 10 張多樣化的參考風(fēng)格圖像和 20 條多樣化的提示詞,涵蓋人類活動(dòng)、動(dòng)物、建筑、交通工具、樂器和家具等類別。在評(píng)估套件中,我們?yōu)槊糠N風(fēng)格和每條提示詞生成 4 張圖像,共計(jì) 800 張圖像。

對(duì)比實(shí)驗(yàn)

將所提出的基于 AR 的 StyleAR 與現(xiàn)有的基于擴(kuò)散的方法進(jìn)行了全面比較,包括 InstantStyle、IP-Adapter、StyleAligned、StyleCrafter和 StyleShot。除 StyleShot基于 Stable Diffusion 1.5實(shí)現(xiàn)外,其余方法均基于 Stable Diffusion XL 架構(gòu)。所有對(duì)比實(shí)驗(yàn)均使用基線方法的官方開源實(shí)現(xiàn),并嚴(yán)格按照其技術(shù)文檔中的超參數(shù)設(shè)置進(jìn)行。

定性比較。 定性對(duì)比如下圖 4 所示。根據(jù)結(jié)果,InstantStyle展現(xiàn)出優(yōu)越的提示詞遵循性,在輸入提示詞與生成圖像的語義對(duì)齊方面表現(xiàn)突出。然而,其在生成圖像與參考風(fēng)格圖像之間的風(fēng)格一致性較差。IP-Adapter經(jīng)常在提示詞遵循性方面出現(xiàn)失敗,生成圖像偏離輸入提示詞。如下圖 4 第一行所示,給定提示詞 “a train”,模型錯(cuò)誤地生成了一張飛機(jī)圖像。該偽影源于內(nèi)容泄露,即參考風(fēng)格圖像中的語義內(nèi)容(如飛機(jī))通過 IP-Adapter中解耦的交叉注意力層不適當(dāng)?shù)貍鞑サ綀D像生成過程中,覆蓋了輸入提示詞的語義內(nèi)容。

StyleAligned 由于其共享注意力層在內(nèi)容與風(fēng)格特征之間無法穩(wěn)定解耦的固有限制,導(dǎo)致生成結(jié)果不穩(wěn)定且語義混亂。StyleCrafter 和 StyleShot在提示詞遵循性方面表現(xiàn)良好,但在風(fēng)格一致性方面存在明顯不足。相比之下,StyleAR 表現(xiàn)出卓越的提示詞遵循性,并準(zhǔn)確捕捉了參考風(fēng)格的整體與細(xì)節(jié)特征。

定量比較。 定量比較結(jié)果如下表 1 所示。StyleAR 在提示詞遵循性與風(fēng)格一致性之間實(shí)現(xiàn)了優(yōu)越的平衡。一方面,StyleAR 在提示詞遵循性方面取得了第二高的表現(xiàn),略低于 InstantStyle,而 InstantStyle 的風(fēng)格一致性較差。另一方面,StyleAR 在 CLIP-I 和 DINO 指標(biāo)中排名第二,略低于 IP-Adapter。但 IP-Adapter的提示詞遵循性較差,且存在嚴(yán)重的內(nèi)容泄露問題(如上圖 4 的定性結(jié)果所示),導(dǎo)致其 CLIP-I 和 DINO 指標(biāo)異常升高。相比之下,我們的方法能夠有效提取參考風(fēng)格圖像的風(fēng)格特征,并在不發(fā)生內(nèi)容泄露的前提下生成目標(biāo)圖像。

用戶研究。 用戶研究結(jié)果如下圖 5 所示。在提示詞遵循性和圖像質(zhì)量方面,本文方法與 InstantStyle 表現(xiàn)相當(dāng),且顯著優(yōu)于其他方法。此外,在風(fēng)格一致性方面,本文方法遠(yuǎn)超所有其他方法。相比之下,InstantStyle方法的風(fēng)格一致性表現(xiàn)較差。可見,我們的方法不僅嚴(yán)格遵循輸入提示詞生成高質(zhì)量圖像,還確保了生成圖像與參考風(fēng)格圖像之間的高度風(fēng)格一致性。

額外結(jié)果。 在凍結(jié) AR 模型原始參數(shù)的前提下,StyleAR 仍可保留 AR 模型原有的生成能力,如結(jié)構(gòu)控制。與 IP-Adapter和 InstantStyle等基于擴(kuò)散的方法相比,StyleAR 方法在圖像質(zhì)量、條件保真度和風(fēng)格一致性方面表現(xiàn)更優(yōu),如下圖 6 所示。

消融實(shí)驗(yàn)

本節(jié)消融實(shí)驗(yàn),以檢驗(yàn)訓(xùn)練數(shù)據(jù)集的組成元素和設(shè)計(jì)模塊對(duì) StyleAR 結(jié)果的影響。

訓(xùn)練數(shù)據(jù)集的組成。 精心設(shè)計(jì)了不同組成的訓(xùn)練數(shù)據(jù)集以進(jìn)行消融實(shí)驗(yàn),從而探索訓(xùn)練數(shù)據(jù)集對(duì) StyleAR 的影響。具體來說,所比較的訓(xùn)練數(shù)據(jù)集包括純風(fēng)格化圖像數(shù)據(jù),以及風(fēng)格化圖像數(shù)據(jù)與原始圖像數(shù)據(jù)比例為 1:3、1:6 和 1:30 的組合。定性結(jié)果如下圖 7 所示,定量結(jié)果如下表 2 所示。根據(jù)結(jié)果,當(dāng)訓(xùn)練數(shù)據(jù)集中僅包含風(fēng)格化圖像數(shù)據(jù)時(shí),提示詞遵循性較好,但風(fēng)格一致性較差。相比之下,當(dāng)加入原始圖像,特別是當(dāng)風(fēng)格化圖像與原始圖像的比例為 1:3 時(shí),風(fēng)格一致性顯著提升,同時(shí)提示詞遵循性也保持在良好水平。然而,當(dāng)比例進(jìn)一步增加至 1:6 和 1:30 時(shí),出現(xiàn)了內(nèi)容泄露現(xiàn)象,生成圖像對(duì)參考風(fēng)格圖像產(chǎn)生“過擬合”,生成圖像中還出現(xiàn)了不相關(guān)的語義內(nèi)容,導(dǎo)致其語義不再遵循輸入提示詞。因此,我們得出結(jié)論,在風(fēng)格化任務(wù)中,除了風(fēng)格化圖像數(shù)據(jù)外,適當(dāng)?shù)丶尤胍恍┰紙D像數(shù)據(jù)可以提升風(fēng)格一致性,并不會(huì)降低提示詞遵循性。

風(fēng)格增強(qiáng) token 的影響。 為了評(píng)估我們提出的風(fēng)格增強(qiáng) token 技術(shù)的有效性,進(jìn)行了定量和定性的消融實(shí)驗(yàn),對(duì)比了使用風(fēng)格增強(qiáng) token 的 StyleAR 與不使用該技術(shù)的 StyleAR。結(jié)果如下圖 8 以及上表 2 的第六列所示。根據(jù)結(jié)果,當(dāng)不使用風(fēng)格增強(qiáng) token 時(shí),參考風(fēng)格圖像中的不相關(guān)語義特征會(huì)出現(xiàn)在生成圖像中,導(dǎo)致生成圖像不符合輸入提示詞的語義控制,出現(xiàn)生成混亂的情況。相比之下,當(dāng)采用風(fēng)格增強(qiáng)機(jī)制時(shí),提示詞遵循性和圖像質(zhì)量均有提升,該機(jī)制使風(fēng)格增強(qiáng) token 能夠輔助模型過濾參考風(fēng)格圖像中的無關(guān)語義信息,確保生成圖像與輸入提示詞高度一致,并顯著提升圖像質(zhì)量。

DPO 的影響。 為了評(píng)估 DPO 后訓(xùn)練在 StyleAR 中的有效性,進(jìn)行了定量消融實(shí)驗(yàn),對(duì)比使用 DPO 后訓(xùn)練的 StyleAR 與不使用該技術(shù)的 StyleAR。定量結(jié)果如上表 2 的第七列所示。DPO 后訓(xùn)練可以提升提示詞遵循性,并略微增強(qiáng) StyleAR 的風(fēng)格一致性。

結(jié)論與局限性

StyleAR,首個(gè)使用圖文二元數(shù)據(jù)驅(qū)動(dòng)多模態(tài)自回歸模型進(jìn)行風(fēng)格對(duì)齊文本到圖像生成的工作,而該任務(wù)此前主要由基于擴(kuò)散的方法主導(dǎo)。相比于以往自回歸模型在指令微調(diào)中使用的三元組數(shù)據(jù),使用圖文二元數(shù)據(jù)進(jìn)行訓(xùn)練,更易于擴(kuò)展訓(xùn)練數(shù)據(jù)集的規(guī)模,從而提升模型性能。此外,消融實(shí)驗(yàn)驗(yàn)證了我們模塊設(shè)計(jì)的有效性,包括風(fēng)格化-原始圖像混合訓(xùn)練策略以及風(fēng)格增強(qiáng) token 技術(shù),它們共同提升了風(fēng)格一致性與提示詞遵循性。然而,當(dāng)前的實(shí)現(xiàn)仍需通過深度圖提取進(jìn)行內(nèi)容控制,而無法直接輸入內(nèi)容圖像以實(shí)現(xiàn)風(fēng)格遷移。未來的研究將聚焦于利用自回歸模型的多模態(tài)輸入能力,實(shí)現(xiàn)風(fēng)格參考圖像與內(nèi)容特定視覺圖像輸入的同時(shí)集成,以進(jìn)一步實(shí)現(xiàn)條件圖像生成。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來