AI視覺重大突破!Meta等發布Pisces「雙腦架構」:一個模型通吃20+榜單

論文鏈接: https://arxiv.org/pdf/2506.10395

亮點直擊

- 解耦視覺編碼架構:首創分任務設計視覺編碼器,解決理解與生成的固有矛盾。

- 三階段漸進訓練:通過數據分層優化,實現細粒度多模態對齊與強指令跟隨能力。

- 任務協同效應:首次揭示圖像理解與生成在統一框架中的相互增強作用。

- 開源組件高效整合:巧妙結合CLIP、擴散模型和LLM,平衡性能與計算成本。

Pisces 在圖像生成和理解方面都表現出色

總結速覽

解決的問題

- 統一多模態模型的性能差距:現有的統一多模態模型在圖像理解和生成任務上表現不如專用模型,限制了實際應用。

- 視覺特征與訓練差異:圖像理解需要高分辨率、長序列視覺特征,而圖像生成需要短序列特征以保持一致性,現有方法難以兼顧。

- 編碼器不匹配問題:圖像理解和生成任務的最佳視覺編碼器通常不同,單一編碼器難以同時優化兩種任務。

提出的方案

- 解耦視覺編碼架構:采用獨立的視覺編碼器、投影層和特征長度,分別優化圖像理解(長序列)和生成(短序列)。

- 三階段訓練策略:

- 第一階段:基礎預訓練(高質量圖像-短標題對)。

- 第二階段:細粒度對齊預訓練(圖像-詳細標題對)。

- 第三階段:指令微調(多樣化任務指令數據)。

- 協同訓練框架:通過統一的多模態框架聯合訓練圖像理解與生成任務,利用任務間的協同效應提升性能。

應用的技術

- 預訓練組件:基于CLIP圖像編碼器(理解)、擴散模型(生成)和LLM(語言建模)。

- 自回歸多模態建模:統一處理圖像與文本的生成和理解。

- 數據優化:精心策劃的預訓練與微調數據集,覆蓋多樣任務和指令。

達到的效果

- 性能領先:在20+個圖像理解基準和GenEval生成基準上達到競爭性甚至超越專用模型的水平。

- 任務協同增益:發現圖像理解與生成任務相互促進,聯合訓練顯著提升雙方性能。

- 靈活高效:解耦編碼器降低推理成本,同時支持高分辨率理解與高質量生成。

模型架構

本文的模型設計受到近期多模態模型架構的啟發,這些模型通過有效利用預訓練模型實現了強勁性能。如下圖2所示,本文提出了一種新穎的解耦視覺編碼架構,用于支持自回歸多模態模型同時完成圖像理解和生成任務。該模型包含一個預訓練的大型語言模型(LLM)、一個專用于圖像理解的圖像編碼器、另一個專為圖像生成優化的圖像編碼器,以及一個擴散模型。

解耦視覺表示

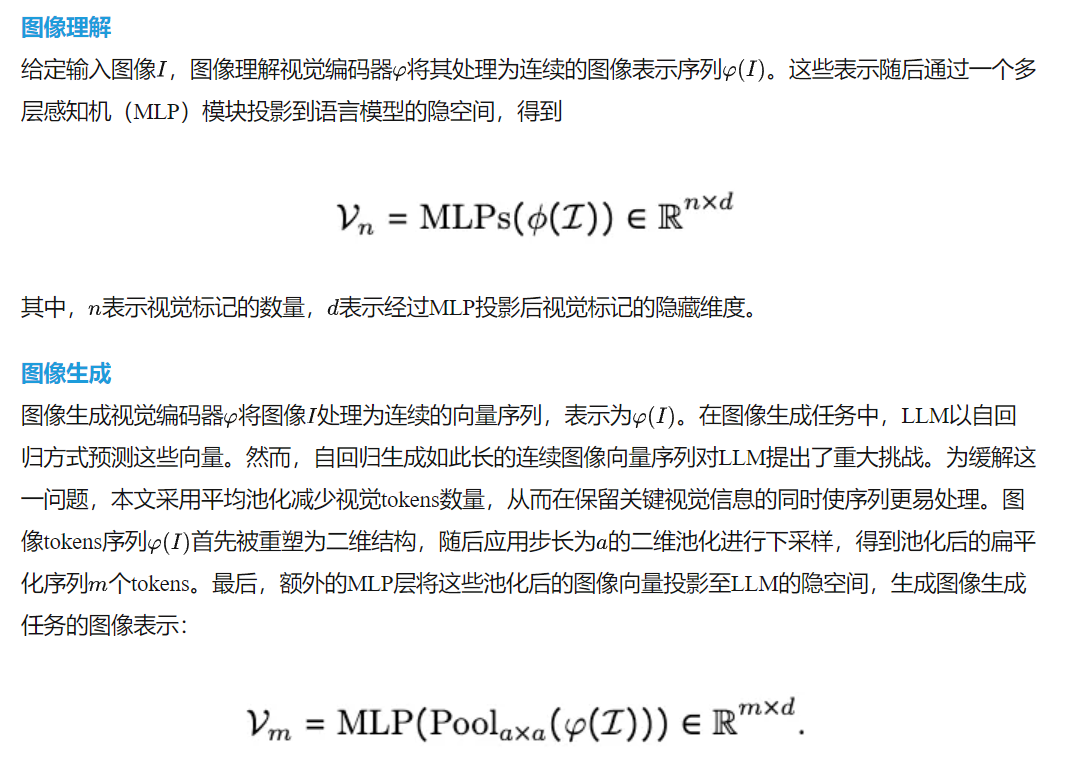

解耦視覺編碼架構的設計理念源于圖像理解與圖像生成任務對視覺表示的內在差異。圖像理解要求視覺編碼器從原始圖像中提取豐富且詳細的語義信息,以支持準確的分析與理解,因此需要較長的圖像向量序列。相比之下,圖像生成要求視覺編碼器將像素級信息壓縮為緊湊的向量序列,高效捕捉視覺外觀的核心特征,同時優化自回歸生成過程。后面分別介紹兩種視覺編碼過程的細節。

多模態大語言模型

為了有效管理圖像理解和圖像生成任務,精心設計的訓練目標至關重要。給定一個圖像-文本對:

- 對于圖像理解,本文的目標是根據圖像預測相應的文本

- 對于圖像生成,文本被用作條件提示來生成圖像

- 對于圖像理解,交叉熵損失函數減小預測文本token概率分布與真實分布之間的差異;

- 對于圖像生成,均方誤差(MSE)損失函數最小化預測圖像向量與圖像編碼器生成的真實圖像向量之間的差異。

基于擴散模型的圖像解碼

給定預測的視覺向量Vm,使用條件擴散模型作為解碼器從這些向量重建圖像。這個條件擴散模型使用CLIP圖像編碼器進行預訓練,根據CLIP模型的最后一層嵌入生成原始圖像。在預訓練期間,圖像編碼器保持凍結狀態,而擴散模型會被更新。

推理

在圖像生成的推理過程中,多模態大語言模型以自回歸方式預測所有m個圖像向量。這些向量隨后通過圖像生成頭映射回圖像編碼器的向量空間,并輸入到擴散模型中以指導去噪過程。遵循Sun等人(2024b)的方法,多模態模型使用空標題作為輸入提供無分類器指導。對于圖像理解,該過程遵循標準語言建模,使用下一個token預測來生成文本輸出。

模型訓練與數據

訓練階段1:多模態預訓練

在預訓練階段,同時優化模型的圖像描述和圖像生成能力。對于圖像生成,使用來自內部Shutterstock數據集的1.5億個高質量圖像-標題對,應用提示"請根據以下標題生成圖像:<caption>?[IMG]<image>?[/IMG]"。對于圖像理解,使用相同的1.5億張圖像,但使用Llama 3.2模型生成的詳細標題。在描述任務中使用的提示是"[IMG]<image>?[/IMG]請提供給定圖像的詳細描述。<caption>"。

訓練階段2:細粒度多模態預訓練

在細粒度多模態預訓練階段,繼續在7000萬個圖像和詳細標題對上對Pisces進行預訓練,同時用于生成和理解任務。與第一階段使用的詳細標題類似,這些詳細標題由Llama 3.2模型生成。這個階段旨在增強生成圖像中文本token與視覺特征之間的對齊,同時避免圖像理解性能的下降。圖像生成和理解使用的提示與第一階段相同。

訓練階段3:圖像理解與生成的指令調優

在指令調優階段,進一步優化Pisces在圖像理解和生成方面的能力和泛化性。對于圖像理解,精心策劃了來自兩個綜合數據集的大量圖像理解任務,最終得到800萬個高質量的圖像-文本對。對于圖像生成,從預訓練使用的Shutterstock數據集中隨機抽取400萬個圖像和簡短標題對,以及400萬個圖像和詳細標題對。通過混合使用簡短和長標題的實例,保留了更廣泛的輸入格式分布。圖像生成和理解數據集被合并,在每個訓練步驟隨機采樣實例以促進平衡有效的學習過程。

實現細節

在Pisces中,使用LLaMA-3.1-Instruct 8B初始化多模態語言模型,采用siglip-so400m-patch14-384作為圖像理解的視覺編碼器,并使用同時結合MAE重建損失和對比損失訓練的CLIP模型作為圖像生成的視覺編碼器(記為gen-CLIP)。理解和生成投影層均為兩層MLP,圖像生成輸出頭也是兩層MLP。對于圖像解碼,訓練SDXL作為圖像解碼器,用于從gen-CLIP圖像嵌入重建圖像。使用4x4池化核將gen-CLIP嵌入池化為64個連續向量。在所有三個階段中,訓練多模態LLM和兩個用于圖像理解與生成的MLP,同時保持兩個圖像編碼器凍結。學習率設為2e-5,并使用帶warm-up的恒定學習率調度器,warm-up比例為0.03。前兩個階段的batch size為2048,第三階段為1024。

評估

圖像理解

基線模型:評估了模型與近期開源的統一模型(兼具圖像理解和生成能力)以及專精于圖像理解的強基線模型的對比。統一模型包括EMU2 Chat、Chameleon 7B和34B、Seed-X、CM3Leon、DreamLLM、Show-o和EMU3。與專用模型的比較中,使用專攻圖像理解任務的LLaVA 1.5(7B和13B)。

評估基準:在四大類基準上評估不同MLLM模型的性能:通用多模態基準(VQAv2、GQA、MMBench(EN和CN)、VisWiz、POPE、MM-Vet、MME Perception、MME Cognition、SeedBench、HallusionBench、LLaVA in the Wild和MMStar);OCR與圖表基準(TextVQA、OCRBench、DocVQA和InforVQA);基于知識的基準(AI2D、MathVista、MMMU和ScienceQA);以視覺為中心的基準(MMVP、RealworldQA和CV-Bench)。

圖像生成

基線模型:本文與最先進的統一模型(兼具圖像理解和生成能力)進行比較,包括CoDI、LWM、SEED-X、EMU、Chameleon、Transfusion、Show-o、EMU3和Janus。此外,還與專精于圖像生成的模型進行基準測試,如SDv1.5、DALL-E 2、PixArt-alpha、Llama Gen、LDM、SDv2.1、SDXL和SDv3。

評估基準:在廣泛采用的圖像生成基準GenEval上評估Pisces的圖像生成性能,使用GenEval官方實現的評估指標。

主要結果

圖像理解

綜合評估基準:如下表1b(a)所示,與開源統一模型相比,Pisces在大多數綜合評估基準上實現了最先進的性能。它甚至超越了參數規模2-4倍的統一模型(如Seed-X 17B和Chameleon 34B),凸顯了其作為通用視覺聊天助手的強大能力。此外,本文的模型大幅超越近期所有模型,如在MMBench上比EMU3高26.3%,在MME-P上比Seed-X高8.6%,在MM-Vet上比EMU3高34.4%。

以視覺為中心、基于知識及OCR與圖表基準:在表1b(b)中展示了Pisces在領域特定基準上的結果。可以看出,與開源統一模型相比,本文的模型在大多數任務上實現了最佳性能,甚至與專精于理解的強模型相比也取得了相當的性能。

條件圖像生成

下表2中展示了Pisces在GenEval基準上的表現。值得注意的是,Pisces在GenEval上實現了與統一理解和生成模型相競爭的性能,突顯了其在圖像生成中強大的指令跟隨能力。下圖3中展示了Pisces與具有圖像生成能力的統一模型之間的定性比較。可以看出,Pisces能夠遵循復雜的用戶提示生成高質量圖像。

討論

圖像理解與圖像生成的協同關系

在統一模型架構中圖像理解與圖像生成是否能相互促進。由于計算資源限制,從訓練階段1使用的數據中采樣1500萬圖像-詳細標題對用于預訓練。指令調優階段使用LLaVA-Instruct-150K數據集。本文在三種不同數據設置下訓練模型變體:

如下表3所示,在受限訓練數據設置下,圖像理解顯著提升圖像生成能力,反之亦然。這證實了兩種任務間的協同關系。

解耦視覺編碼器的優勢

本文通過消融實驗驗證解耦編碼器的有效性:

- 使用gen-CLIP同時處理圖像理解(1024個視覺token)和生成(池化為64個視覺token)。結果顯示Pisces-gen-CLIP在生成任務上與原模型相當(FID 40.5 vs 38.2),但理解性能下降(下表4);

- 嘗試使用SigLIP處理雙任務時,盡管用3000萬Shutterstock圖像訓練SDXL解碼SigLIP特征,但由于SigLIP預訓練缺少MAE損失,其重建性能不及Gen-CLIP+SDXL組合。這印證了為不同任務采用獨立編碼器的必要性。

圖像生成視覺token數量的影響

在圖像生成任務中,LLM以自回歸方式預測連續圖像向量。實驗采用SigLIP ViT-L/16@384,比較完整序列長度(729個token)與兩種池化策略(步長3得81個token,步長9得9個token)。如下圖4所示,完整序列訓練損失最高,步長3取得平衡,而步長9雖損失最低但信息丟失嚴重導致生成質量下降。

詳細標題對圖像生成的影響

本文對比了兩種第二階段預訓練設置:

- 使用7000萬詳細標題同時增強生成和理解能力;

- 生成任務使用7000萬簡短標題,理解任務使用詳細標題。

下表5顯示MSCOCO-30K的FID分數表明,長標題能持續提升生成性能,而增加短標題則無進一步改善。

本文轉自AI生成未來 ,作者:AI生成未來