沒有指數級數據就沒有Zero-shot!生成式AI或已到達頂峰 精華

生成式人工智能已經觸及峰頂了嗎?

在大模型正火的時候提這個問題,似乎不合時宜。

畢竟,隨著數據和模型規模的增大、計算能力的增加,我們似乎不再懷疑擁有超強人工智能的未來。

——但是!來自University of Tübingen、劍橋和牛津大學的最新研究,用實驗告訴我們:沒有指數級數據,就沒有Zero-shot!

論文地址:https://arxiv.org/pdf/2404.04125

換句話說,模型要想達到AGI水平,所需的訓練數據量是我們無法提供的。

根據實驗數據,模型未來的性能提升將越來越緩慢,最終會因為拿不到指數級的數據而觸及瓶頸。

——所以,你以為大模型真的實現了zero-shot,真的在吸收和記憶的基礎上,涌現了推理甚至創新,實際上都是人家見過千萬次,早已倒背如流的答案。

你以為是素質教育出英才,其實人家走的是題海戰術、應試教育路線。

?

Youtube上239萬訂閱的Computerphile頻道,根據這篇文章的結果發表了類似的看法和擔憂,立時受到廣泛關注。

視頻地址:https://www.youtube.com/watch?v=dDUC-LqVrPU

對數魔咒

當前,由于大模型展現出的zero-shot learning能力,人們樂觀地預計大模型的性能可以相對于訓練數據呈指數級增長,——這也是人們對AGI抱有期望的原因。

就算再退一步,兩者呈線性關系,我們也能接受,畢竟只要多花時間、多花錢、多喂數據,到達了某個臨界值之后,大模型就將無所不能。

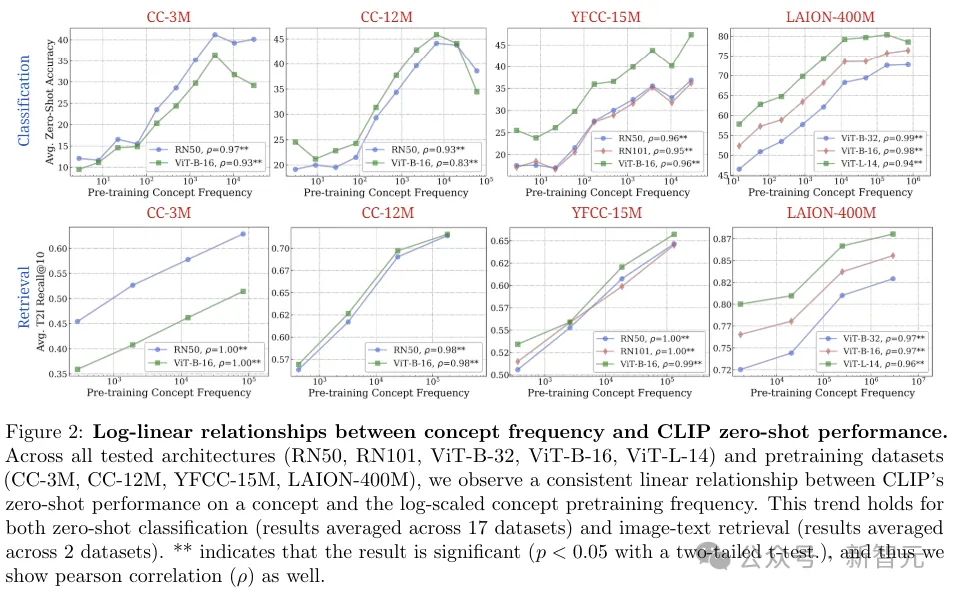

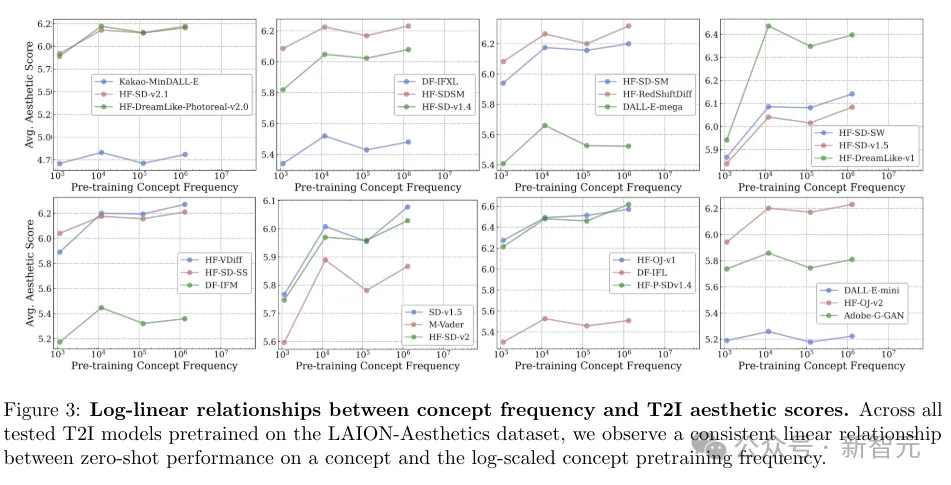

但是,這篇論文指出,實際上訓練數據(樣本或概念的數量)和性能(在下游任務上對應概念的表現)呈對數關系。

也許現下的模型還能在一段時間內快速提升,但以后會越來越難,付出的代價也會越來越大,

——比如萬億token換來1%的性能,比如GPT-5,6,7的性能可能沒啥差別。

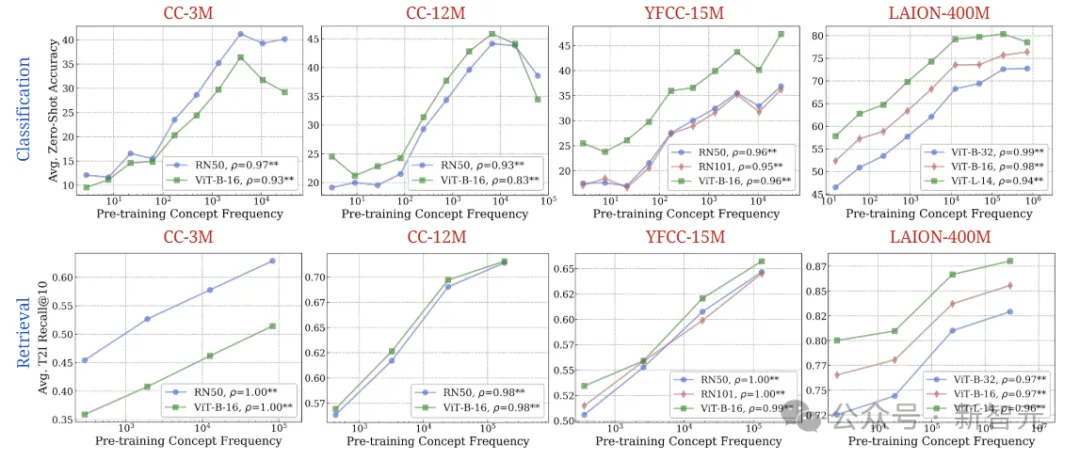

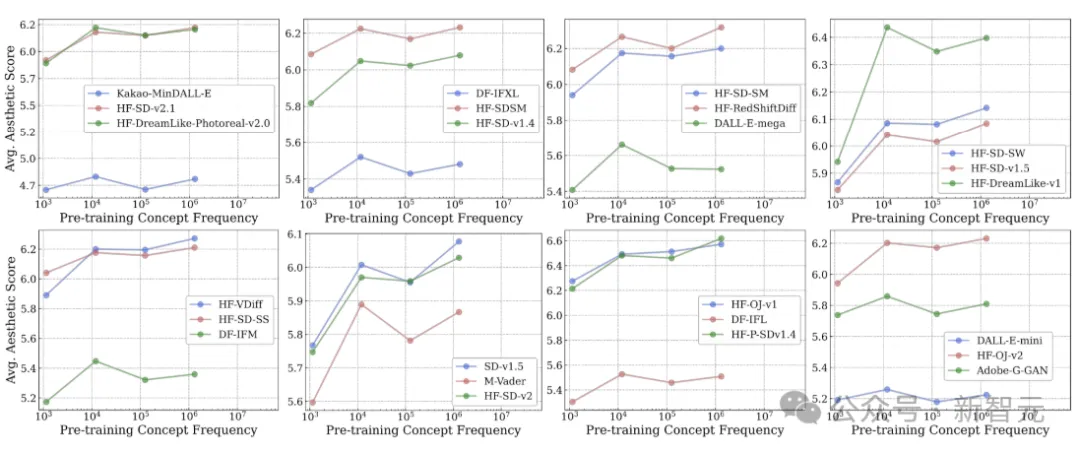

文章通過大量的實驗得到了類似的數據和圖表,

這些曲線的走向一致,證明了在當前的情況下,無論用什么樣的訓練方法、什么樣的數據集、執行什么樣的下游任務,都難逃對數關系的魔咒。

而且,雖然這篇工作針對于多模態模型,但LLM也會有相同的問題,比如我們熟知的幻覺就是一種表現形式,面對訓練數據中沒有的東西,LLM就開始胡編。

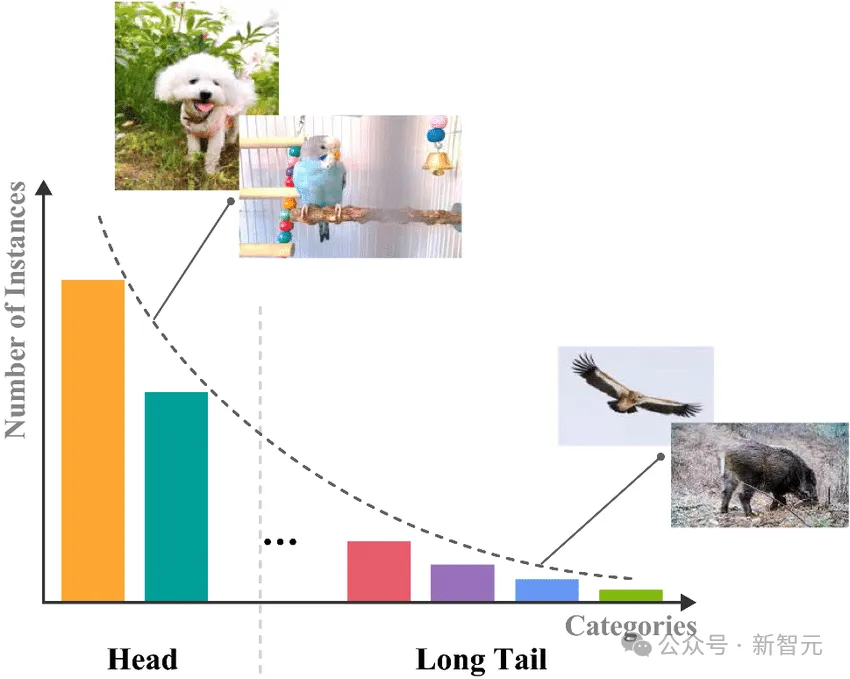

另一方面,訓練數據的分布往往都是不均勻的,有些種類的數據頻度高,那么對應到推理結果上的表現自然就好。

這種情況被稱為長尾分布(Long-Tail Distribution),指在分類任務中,訓練數據的分布呈現長尾形狀,少數類別擁有大量樣本,而大多數類別只有很少的樣本。

這種現象在現實世界中很常見,也就加劇了前面提到的指數級數據的難題。

當下模型的訓練數據主要來自于互聯網,咱也不知道數據是不是已經被吃得差不多了,反正這種指數級關系總會有無法滿足的一天。

未來,我們可能需要「something else」,比如新的方法、新的數據表示、或者是不同于Transformer的新架構。

網友熱議

除了油管上一天23萬的播放量,Hacker News上也是熱鬧非凡。

「這感覺像是當前人工智能炒作的最壞結果」。

網友表示,我們基本上已經把整個互聯網都喂給模型了,這幾乎是目前能得到的最大的數據集,而且由于AI生成的垃圾數據也在不斷進入互聯網,以后可能也不會有更大更好的數據集了。

給大模型喂這些數據花費了數十億美元,卻只得到了有一些用處,又沒有太大用處的人工智能。——如果這些人力物力財力花在別的地方,我們可能會過得更好。

對于人工智能產生垃圾數據所帶來的影響,網友們表示贊同。

也有網友認為,數據還是有的,但是很多人正在利用技術手段,拒絕人工智能爬取自己的數據。

「這意味著谷歌搜索變得更糟,生成式AI變得更糟,互聯網變得更糟」。

還有網友表示,相比于互聯網上那點數據,現實世界要復雜幾個數量級。

不過,對于Computerphile在視頻中表達的略顯悲觀的結論,有大佬表示質疑。

前谷歌高級工程師、現任RekaAI CMO的Piotr Padlewski認為:

首先,縮放定律告訴我們,模型越大,獲得相同性能所需的樣本就越少。

其次,這篇論文研究的是零樣本學習(zero-shot),而不是in-context learning。即使是訓練數據中不常見/不存在的主題,只要在上下文中提供示例和說明,LLM也能理解。

「我認為沒有人期望LLM能在zero-shot的情況下證明出P=NP,可能發生的情況是利用Agent找到所有相關文件并從中學習。」

「首先需要開發更好的算法和智能體,但我們也需要更好的基礎模型。」

沒有指數級數據,就沒有Zero-shot。

目前,人們對于AI發展的一個主要爭論是,規模的擴大能帶來真正的泛化能力嗎?看了一輩子貓狗的大模型真的能認識大象嗎?

——大模型的zero-shot似乎已經為自己正名。

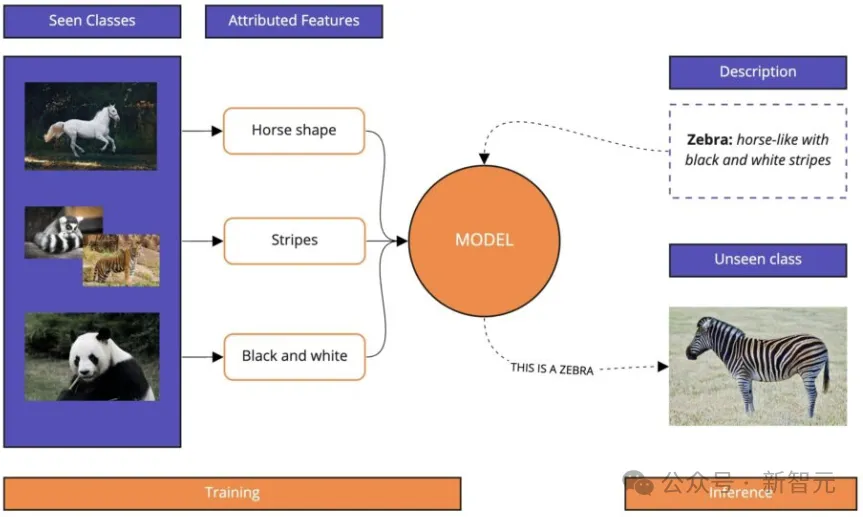

Zero-shot learning (ZSL) is a fascinating machine learning scenario. In ZSL, an AI model is trained to recognize and categorize objects or concepts without having seen any examples of those categories or concepts beforehand.

不需要在訓練集中出現某個分類的樣本,憑借已經學到的語義信息,就可以識別從來沒有見過的類別。

比如下面這個例子,模型在之前的訓練中學到了馬的形狀、老虎的條紋和熊貓的黑白色,

這時你再告訴模型:斑馬長得像馬,并且有黑白相間的條紋,模型就可以在從沒有見過斑馬的情況下對其進行分類。

當前,CLIP模型是零樣本圖像識別,和圖像文本檢索的事實標準,而Stable Diffusion則是零樣本文生圖的事實標準。

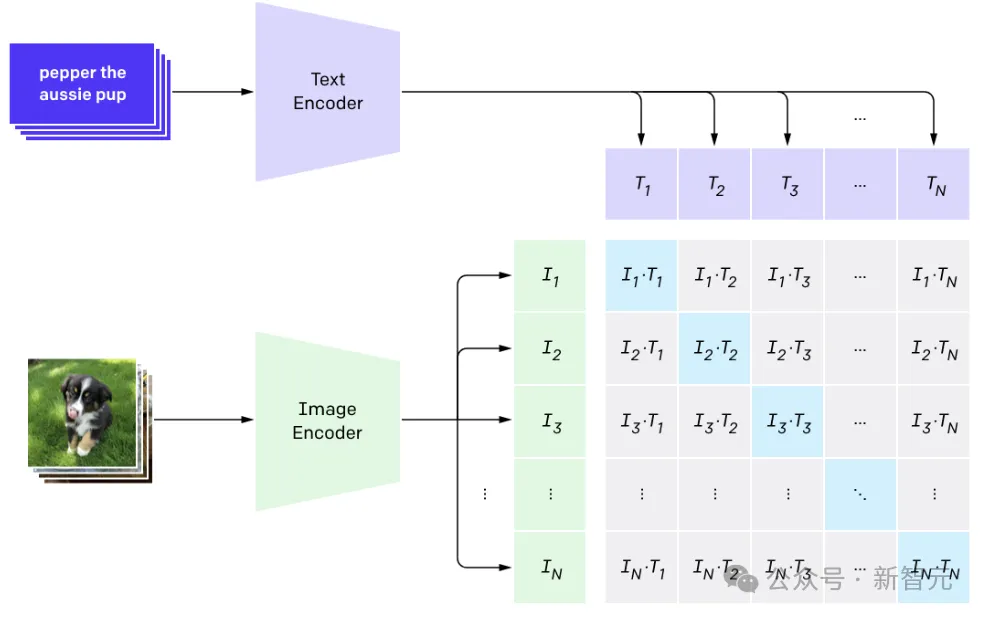

CLIP:把文本decoder和圖像decoder(VIT)對應到同一個嵌入空間

——不過這種zero-shot的泛化能力,究竟在多大程度上是靠譜的?或者說:這種能力的代價是什么?

實驗

為了回答這個問題,研究人員決定用實驗數據說話。

首先,問題涉及兩個主要因素的比較分析:

(1)模型在各種下游任務中的性能

(2)測試概念在其預訓練數據集中的頻率

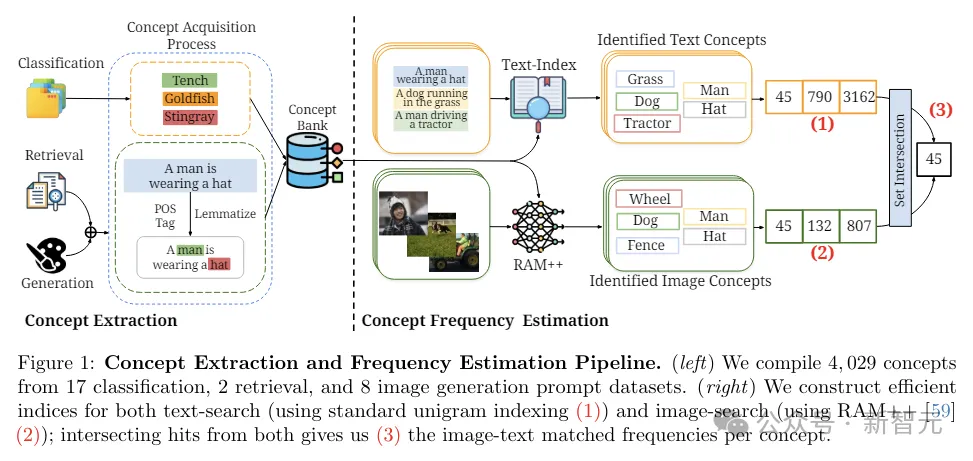

研究人員從涵蓋分類、檢索和圖像生成的27個下游任務中,提取出4029個概念,根據這些概念來評估模型性能。

概念:定義為試圖在預訓練數據集中分析的特定對象或類別。

對于零樣本分類任務,概念表示類名,例如ImageNet中的1000個類別(金魚、黃貂魚等)。

對于圖像文本檢索和圖像生成任務,概念表示測試集標題或生成提示中出現的所有名詞,比如在標題「一個男人戴著帽子」中,提取出「男人」和「帽子」作為相關概念。

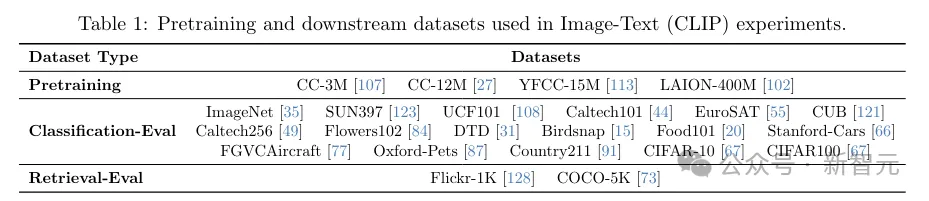

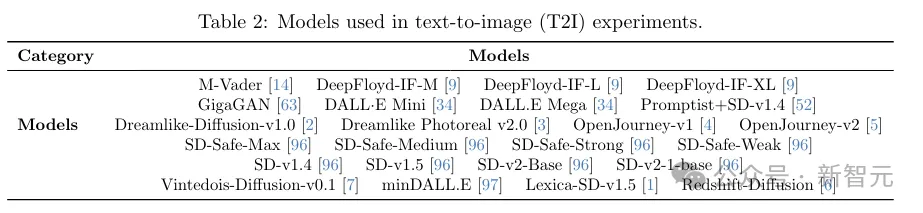

實驗選取了五個具有不同尺度、數據管理方法和來源的大規模預訓練數據集(CC-3M、CC-12M、YFCC-15M、LAION-Aesthetics、LAION-400M),以及具有不同架構和參數大小的10個CLIP模型,和24個文生圖(T2I)模型。

評估指標

對于分類任務,計算平均零樣本分類精度。對于檢索,使用文本到圖像和圖像到文本檢索任務的傳統指標來評估性能(Recall@1,Recall@5,Recall@10)。

而在文生圖這邊,評估包括圖像-文本對齊和美學分數(aesthetic score)。

使用預期和最大CLIP分數來衡量圖像-文本對齊,并使用預期和最大美學分數來衡量美觀度。

在以上的16個圖中,我們可以觀察到概念頻率和zero-shot性能之間,存在明顯的對數關系。

實驗考慮了多個不同的維度:

(i)判別模型與生成模型,

(ii)分類與檢索任務,

(iii)模型架構和參數尺度,

(iv)不同方法和尺度的預訓練數據集,

(v)不同的評估指標,

(vi)零樣本分類的不同提示策略,

(vii)僅從圖像或文本域中分離的概念頻率

而結果表明,對數線性縮放趨勢在所有七個實驗維度上都持續存在。

因此,CLIP和Stable Diffusion等多模態模型令人印象深刻的zero-shot性能,在很大程度上歸因于其龐大的預訓練數據集,而并不是真正的零樣本泛化。

恰恰相反,這些模型需要一個概念的數據呈指數級增長,才能以線性方式提高它們在與該概念相關的任務上的性能,——極端的樣本低效率。

本文轉自 新智元 ,作者:新智元