WWW'24 文本增強實現統一跨域時間序列預測

今天給大家介紹一篇WWW 2024中,由于新嘉博國立大學和香港科技大學聯合發表的多模態時間序列預測模型UniTime,通過文本信息實現統一跨域時間序列預測。

論文標題:UniTime: A Language-Empowered Unified Model for Cross-Domain Time Series Forecasting

下載地址:??https://arxiv.org/pdf/2310.09751v1.pdf??

1、背景

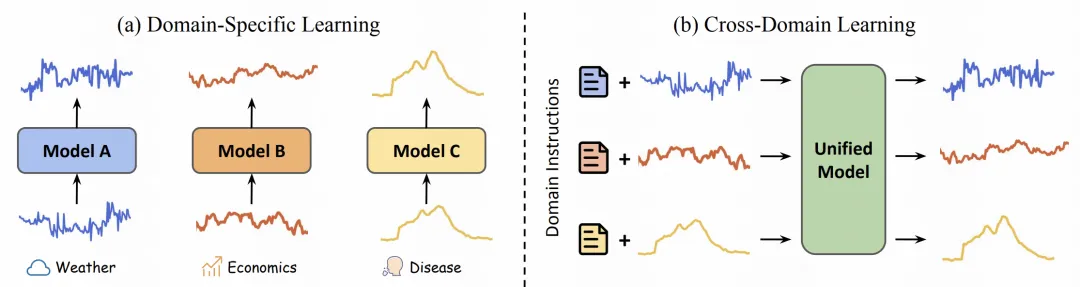

在很多時間序列預測場景中,會涉及到跨域學習,即有多個領域的時間序列數據,不同領域的數據分布、特征都可能不同,需要對這些領域都進行預測。解決這種問題的一個基礎方法為,為每個domain獨立訓練一個模型。這種方法的問題在于資源占用多,無法共享不同domain時間序列數據的信息。

Cross Domain相關的方法研究如何將多個不同domain的數據聯合到一起訓練一個模型。這其中需要面臨的問題包括,如何讓模型兼容不同類型的數據、如何有效區分不同domain的數據等問題。本文就建立在這個問題之上,希望建立一個能夠聯合訓練不同domain時間序列數據的統一時間序列模型。

2、實現方法

針對上述問題,本文提出了一種使用文本信息增強時間序列cross domain學習能力的方法。

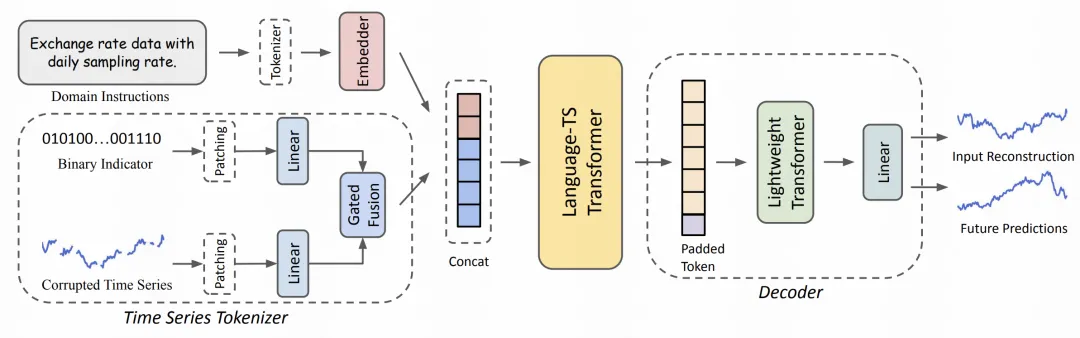

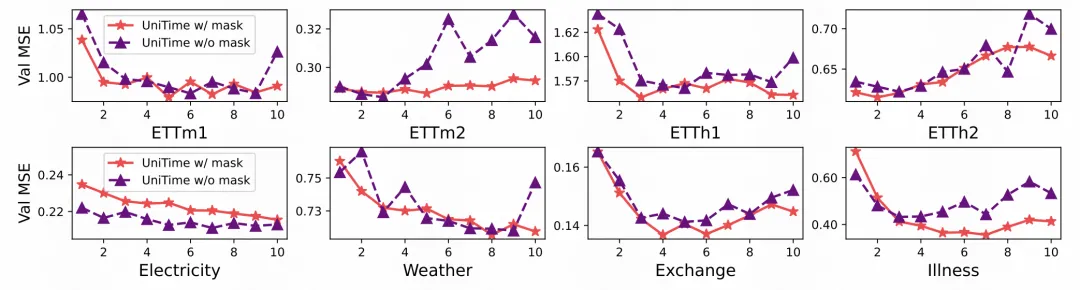

首先,整體的模型結構采用了Patch+Linear的基礎方式,對于每個時間序列,使用patch的方式將序列轉換為token embedding。由于不同domain的學習速率不同,為了防止那些學習快的domain出現過擬合,文中采用了一種mask的思路,將時間序列隨機mask掉一部分點,讓模型不能只根據domain數據自身的特征進行簡單預測導致過擬合。這一步的輸出為mask標記和被mask序列的Gate融合結果。

接下來,文中引入了文本信息輔助跨域學習。對于每個domain的數據,使用一個文本描述,輸入到Transfomer中生成表征,描述這個domain的樣本,以此作為一個domain的標識信息。這部分信息和時間序列本身的輸出結果拼接到一起后,整體再過一個Transfomer融合文本和時序的信息。

最后,上述Transformer結果會輸入到Decoder中,為了適配不同domain的序列長度可能不同的問題,使用一個可學習的padding向量對Encoder的輸出結果進行補全。補全結果輸入到Transformer Decoder中得到最終預測結果。

3、實驗效果

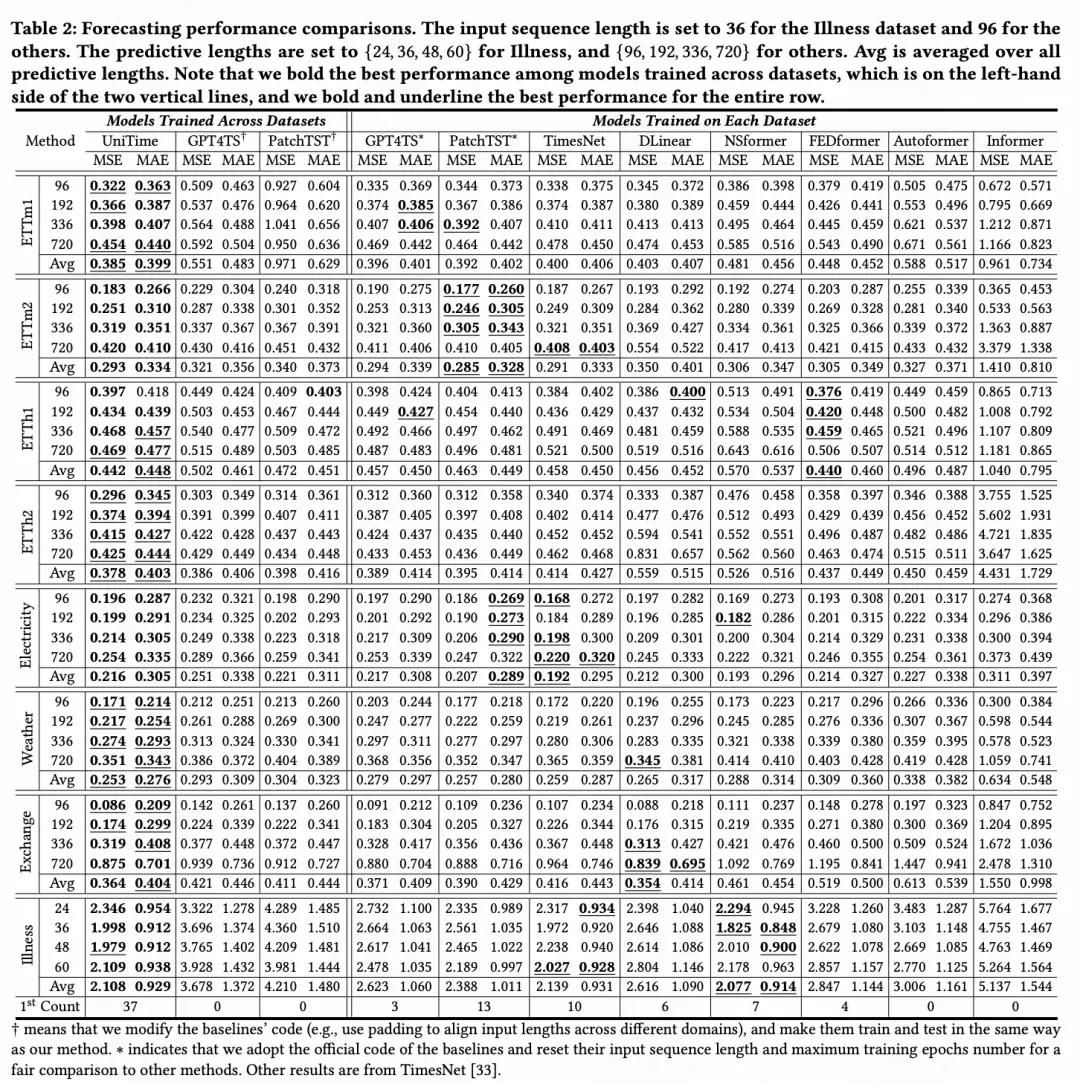

在實驗中,文中對比了多個數據集中,不同預測窗口的預測效果。對比的模型包括在所有數據集上聯合訓練的方法,也包括在單獨數據集上訓練的方法。可以看到,UniTime在多個數據集的不同配置上都取得了比較明顯的效果提升。

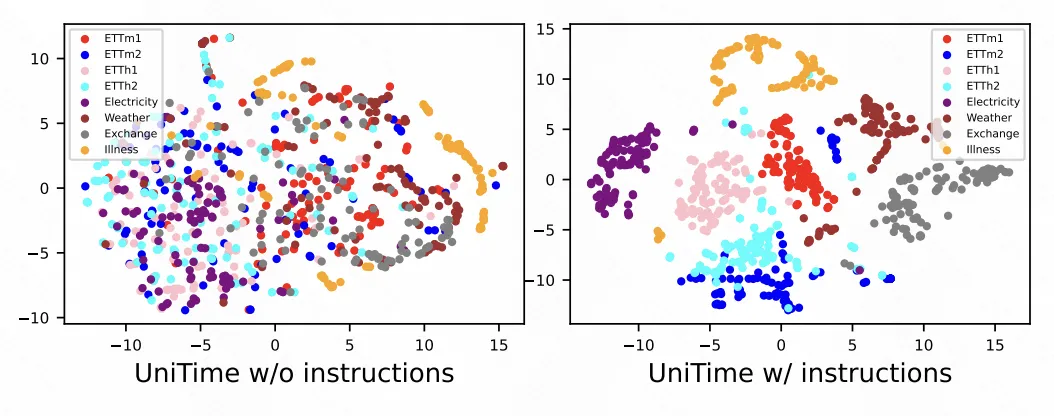

同時,通過下圖可以看出,通過引入instruction,可以讓各個domain數據的表征學習的更加合理,各個domain在表征空間區分的更分散。

本文轉載自 ??圓圓的算法筆記??,作者: Fareise