時序+圖像+文本,多模態增強的時序預測模型

今天給大家介紹一片最新的多模態時間序列預測工作。這篇文章采用了時間序列、圖像、文本三種模態的數據形式,進行時間序列預測,增強底層信息的輸入,提升時序預測效果。

論文標題:Time-VLM: Exploring Multimodal Vision-Language Models for Augmented Time Series Forecasting

下載地址:??https://arxiv.org/pdf/2502.04395??

1.研究背景

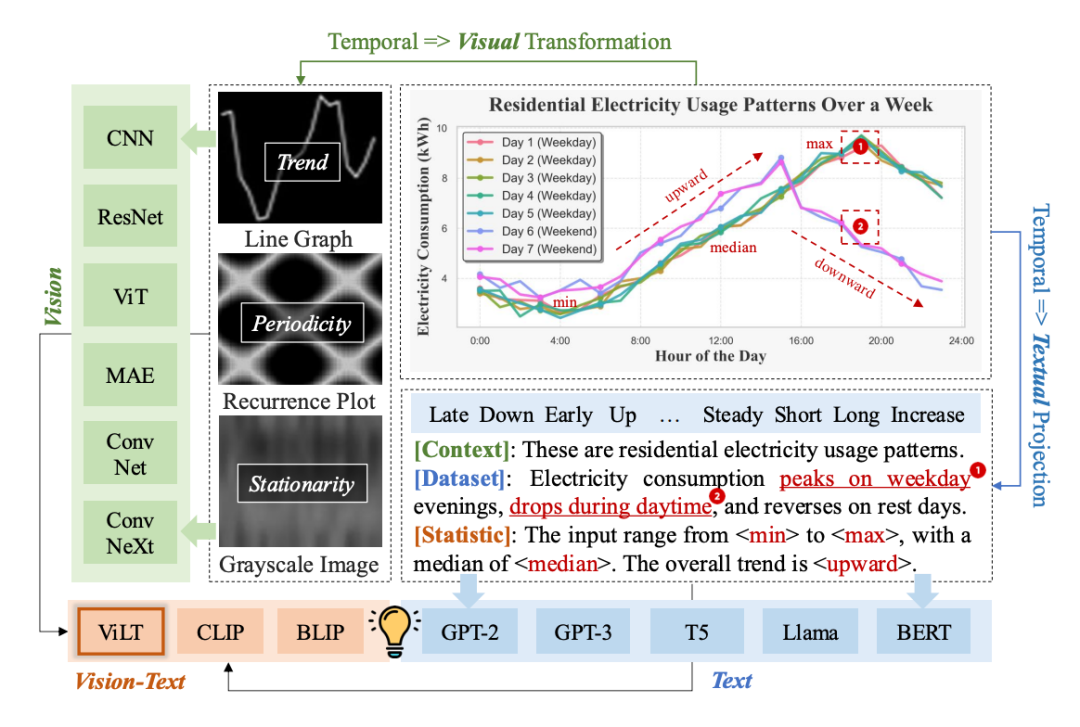

傳統的時間序列預測方法,都是最基礎的時間序列形式數據進行建模的。然而,最近一些工作將文本信息、圖像信息等模態引入時間序列建模中。例如,將時間序列轉換成文本形式輸入到LLM,或者將時間序列轉換成圖像數據輸入圖像模型。

文本和圖像數據各有優勢。文本形式可以提供豐富的上下文語義信息,而圖像形式可以非常直觀的提升時間序列的形狀信息。如何融合不同模態的信息實現時間序列預測,在目前的多模態大模型階段是一個值得深入研究的優化點。

這篇文章就提出了一種融合時間序列、圖像、文本等3種模態信息的時間序列預測模型,利用各個模態的輸入進行優勢互補,提升時間序列預測整體的效果。

圖片

圖片

2.建模方法

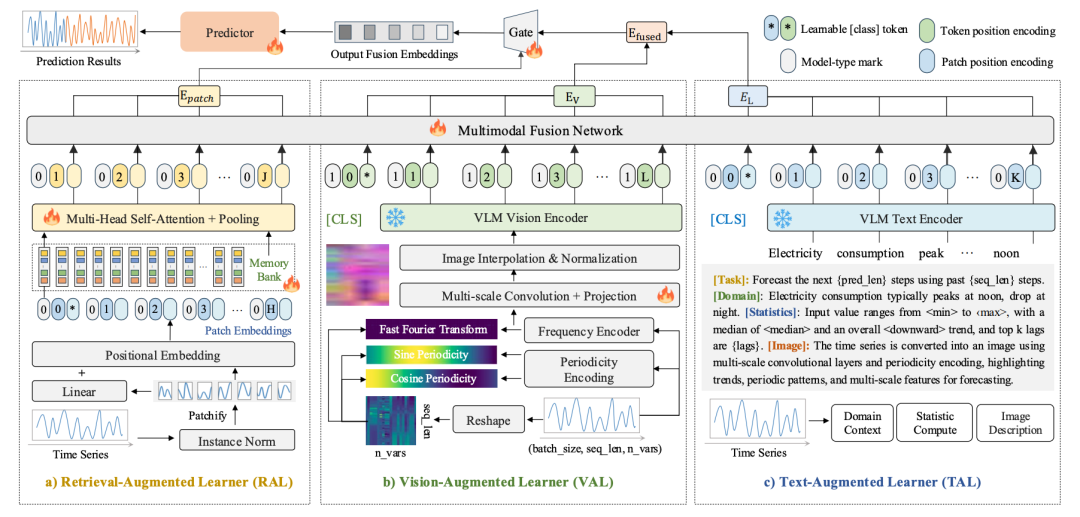

本文的核心建模方法可以分為4個部分:時間序列模態建模、圖像模態建模、文本模態建模、多模態融合。下面對這4個主要模塊展開進行介紹。

時間序列模態輸入:本文采用了Patch+檢索的時序表征抽取方式。首先將時間序列分割成patch,然后使用多個可學習的query向量,和各個patch或者patch內部表征計算attention,相當于用可學習query去提取各個patch以及patch內部的重要信息,得到對應的時間序列表征。Patch間attention檢索表征和patch內attention檢索表征使用加權求和的方式進行融合。

圖像模態輸入:在圖像模態部分,會使用傅里葉變換將原始時間序列映射到頻域,并且使用三角函數構建每個時間步的相對位置關系。再加上原始的時間序列,共得到有3個channel的張量,維度為Batch_size、序列長度、變量數量、3(3為原始序列、傅里葉變換結果、三角函數位置信息)。接下來使用層次的卷積分別進行不同維度的信息提取。最后,將卷積輸出的表征通過resize和插值的方法轉換成目標尺寸的圖片上,得到最終的圖像模態輸入。再輸入到多模態視覺模型中,得到表征。

文本模態輸入:對于文本模態,文中主要以數據集的描述為輸入,結合相應的prompt,經過一層多模態文本模型,得到文本表征。

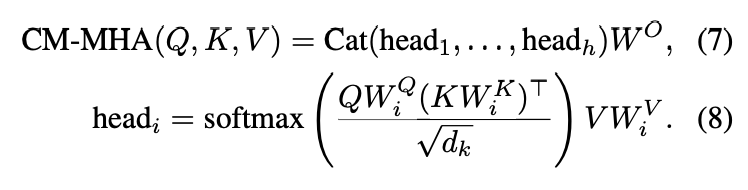

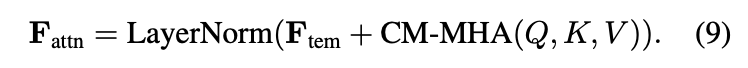

多模態融合:對于上述3種類型模態的輸入,分別使用一個Encoder提取最終表征。時間序列模態使用self-attention和pooling進行提取。圖像和文本模態使用預訓練的圖文模型(如CLIP等)分別提取圖像和文本表征,模型參數凍結。在上層使用一個Multimodal Fusion Network進行多模態信息的融合。MFN的核心是使用時序模態的表征作為query,多模態保證作為key和value,進行跨模態attention。最后,再使用一個gate網絡,對時序表征和多模態表征進行加權融合。整體計算過程如下:

圖片

圖片

圖片

圖片

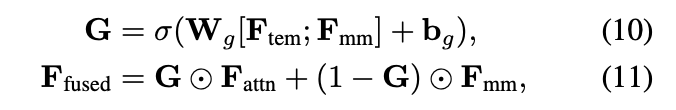

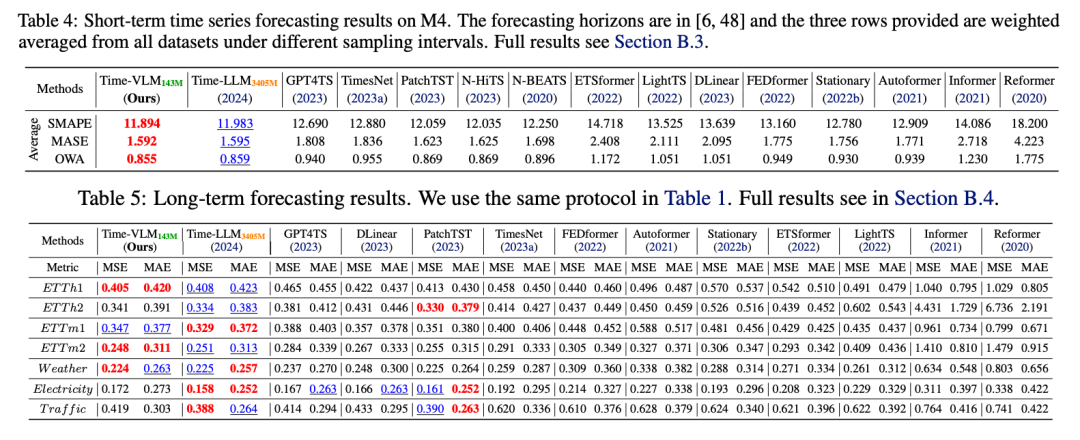

3.實驗效果

通過在長期、短期時間序列預測上的效果對比可以發現,本文提出的方法取得了顯著的效果提升,驗證了多模態信息引入的有效性。

圖片

圖片

本文轉載自??圓圓的算法筆記??