Meta AI的首席執行官LeCun:不要從事LLM工作

出品 | 51CTO技術棧(微信號:blog51cto)

在巴黎舉行的初創企業年度技術大會VivaTech上,Meta AI的首席執行官Yann LeCun建議希望在AI生態系統中工作的學生不要從事LLM(大型語言模型)方面的工作。

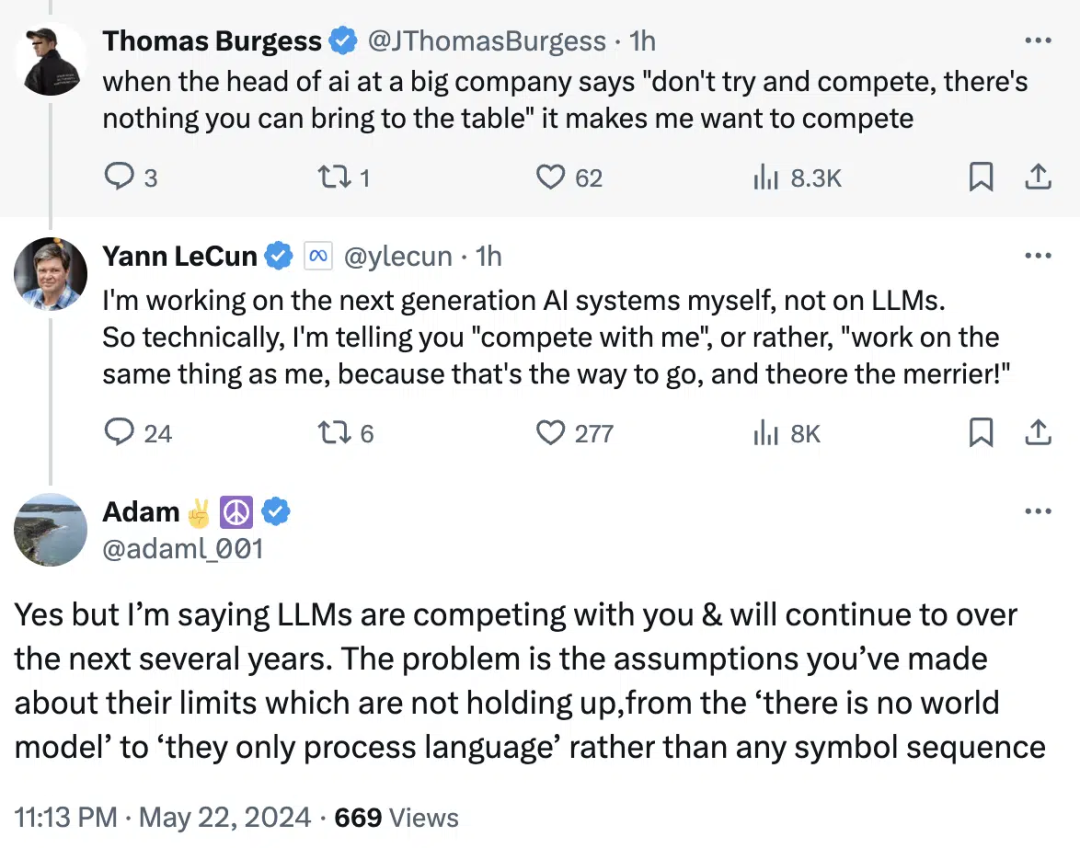

“如果你是對構建下一代AI系統感興趣的學生,請不要從事LLM方面的工作。這是大公司的事情,你們無法對此有所貢獻,”LeCun在會議上表示。

他還說,人們應該開發能夠克服大型語言模型局限性的下一代AI系統。

1.遠離LLM

有趣的是,關于LLM(大型語言模型)替代品的討論已經持續了一段時間。最近,Devika的年輕創始人Mufeed VH(Devika是Devin的替代品)談到了人們應該如何遠離Transformer模型并開始構建新的架構。

“每個人都在做同樣的事情,但如果我們專注于不同的架構,比如RMKV(一種RNN架構),那將是非常好的,”Mufeed說,他接著解釋了這種特定架構的無限上下文窗口和推理能力。

他還認為,通過這種方法,甚至有可能構建出與GPT-4一樣令人印象深刻的東西。

圖片

圖片

2.但是,LLM 仍在不斷進步

盡管LeCun反對一股腦全部研究LLM,但Transformer訓練模型仍在不斷發展。AI/ML顧問Dan Hou談到了GPT-4o,并強調了其訓練模型。

當文本被認為是所有復雜模型的基礎時,GPT-4o被設計用來原生地理解視頻和音頻。這影響了未來版本可以訓練的數據量。

“AI能變得多聰明?有了原生的多模態架構,我猜測答案是非常、非常好,”Hou說。

此外,Sam Altman在最近的一次采訪中也談到了數據將不再是問題,從而解決了訓練LLM的擔憂。可以試想,如果數據問題能夠得以解決,LLM的尺度定律將繼續存在。

本文轉載自??51CTO技術棧??