ChatGPT-4o有何特別之處?

大家已經知道,OpenAI 在 GPT-4 發布一年多后終于推出了一個新模型。它仍然是 GPT-4 的一個變體,但具有前所未見的多模態功能。

有趣的是,它包括實時視頻處理等強大功能,這一關鍵功能最終可以讓我們創建強大的虛擬助手,實時支持我們的日常生活。然而,這樣的功能應該很昂貴且緩慢,考慮到該模型速度極快且免費使用(有限免費),這不合情理。

那么,到底發生了什么事呢?

OpenAI 一定已經意識到了一些我們尚未意識到的事情,即我們今天討論的智能設計決策可以以極低的價格創建出更智能的模型。

那么,這一切有何意義?它對你未來意味著什么?

多模態輸入,多模態輸出

那么,ChatGPT-4o 有什么特別之處呢?它是有史以來第一個真正的“多模態輸入/多模態輸出”前沿模型。

但我們這樣說到底是什么意思呢?

在真正的多模態模型中,您可以向模型發送音頻、文本、圖像或視頻,模型將根據需求使用文本、圖像或音頻(還不是視頻)進行響應。

但我知道你在想什么:ChatGPT 或 Gemini 的先前版本不是已經處理和生成圖像或音頻了嗎?是的,但有一個需要注意的點是:

他們是通過獨立的外生組件來實現的。

之前的模型和現在模型對比

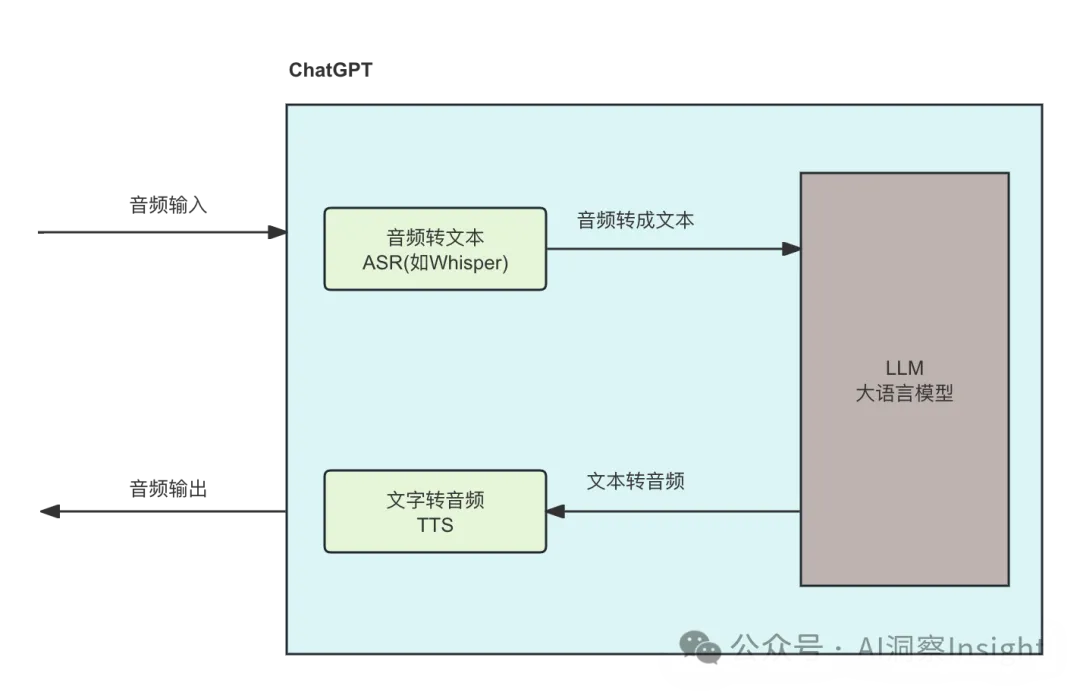

以前,每當你向大模型發送音頻時,都是這樣的標準流程:

輸入輸出過程:用戶發出的語音請求經過自動語音識別(ASR)轉為文本(這里用的Whisper),文本經過大語言模型處理生成響應文本,響應文本再經過文本轉語音(TTS)模塊轉換為語音,最終以語音形式返回給用戶。

Whisper 是由 OpenAI 開發的一種自動語音識別(ASR)系統。它利用深度學習技術和大規模語音數據進行訓練,能夠將語音信號轉換為文本。Whisper 系統具有高準確性和多語言支持,能夠處理各種音質和背景噪聲的語音輸入。

在此過程中,自然語音中的聲調、節奏、韻律、傳達的情感和關鍵停頓都會丟失,因為語音轉文本組件Whisper會將音頻轉錄為 LLM 可以處理的文本。

然后,LLM 將生成文本響應并將其發送到另一個組件(即文本到語音模型),該模型將生成最終傳達的語音。

自然,由于人類通過語音傳達的信息遠不止文字,許多重要信息也因此丟失, 而且由于信息必須在不同的組件之間發送,造成的延遲并不理想。

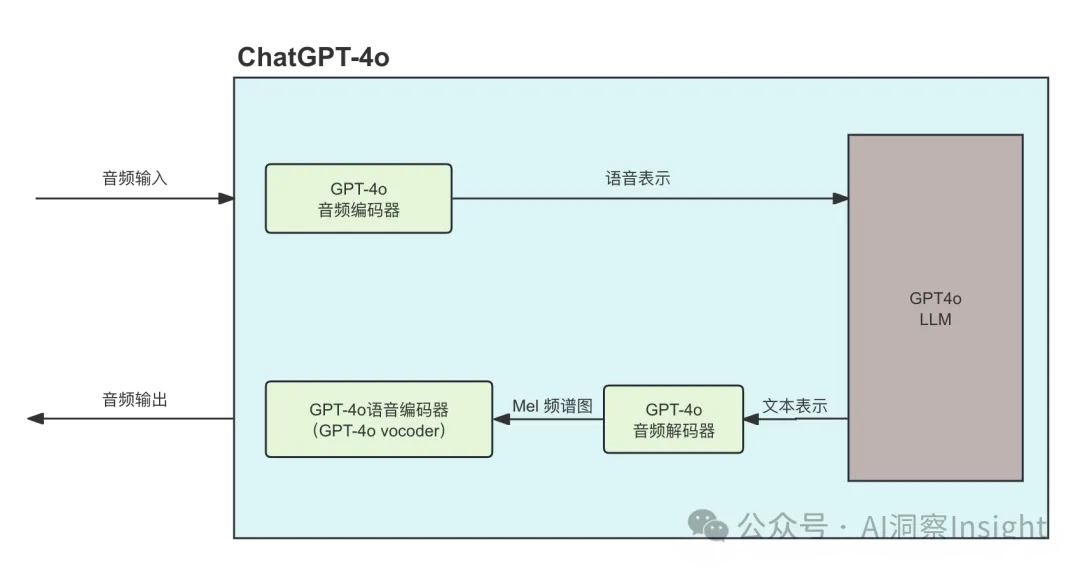

但是在 ChatGPT-4o 中,一切都相似但又完全不同;因為一切都發生在同一個地方。

乍一看,似乎變化不大。盡管組件幾乎沒有變化(vocoder和音頻解碼器是我們之前展示的文本轉語音模型的一部分),但這些組件如何共享信息,完全改變了信息丟失的程度。

具體來說,LLM 現在看到的是語音的語義表示,而不是原始文本。通俗地說,模型現在不僅能看到“我想殺了你!”這句文字,還能接收到以下信息:

{

轉譯的文字: "我想殺了你!";

情緒: "高興";

語氣: "喜悅";

}這里雖然使用了 JSON 示例來說明,但語音編碼器實際上為 LLM 生成的是一組向量嵌入(Vector Embeddings),除了實際文本之外,它們還捕捉語音的情感、語調、節奏和其他線索。

向量嵌入 是一種將離散的數據(如單詞、句子、圖像等)映射到連續的低維向量空間的方法。這些向量捕捉了數據的語義關系,使得相似的數據在向量空間中更接近。

因此,LLM 生成的響應更加基于實際情況,除了文字之外,還能捕捉信息中的關鍵特征。

然后將該響應發送到音頻解碼器,音頻解碼器使用它來生成梅爾頻譜圖(很可能),最后將其發送到聲碼器以生成音頻。

您可以將頻譜圖視為“查看”聲音的一種方式。頻譜圖 是一種將音頻信號的頻率成分展示在二維圖表上的工具。頻譜圖顯示了音頻信號在不同時間點的頻率分布及其強度

那么梅爾頻譜圖是什么?梅爾頻譜圖 是一種特殊類型的頻譜圖,它通過 Mel 頻率尺度對頻率軸進行變換,更符合人耳對聲音的感知

順便說一句,所有這些也適用于圖像處理和生成或視頻處理,因為它們將所有組件打包成一個單一模型,而不僅僅是音頻。

總而言之,ChatGPT-4o 現在可以從文本以外的其他形式捕獲信息,包括關鍵音頻、圖像或視頻提示,以生成更相關的響應。簡而言之,它不再關心數據如何進入并適應上下文,而是需要決定必須以何種方式回復。

這個改變有多么重要

OpenAI 實現的真正多模態向世界傳遞了一個鮮明的信息:

在不使模型的主干(LLM)本身更加智能的情況下,能夠跨多種模態進行推理的模型必然會更加智能,因為該模型不僅具有更多功能,而且還能夠在不同數據類型之間傳遞知識。

人類運用所有感官的能力被認為是智能的關鍵部分,而人工智能也旨在掌握這種能力。

作為一個很大的好處,它還使模型在推理方面變得更加高效(撇開它們本可以應用的特定效率不談)。