實時深度學習的推理加速和連續學習

在本技術分析報告的***部分《研學社·系統組 | 實時深度學習的推理加速和持續訓練》,我們介紹了最近一些用于 DNN 推理加速的硬件和算法技術。在這第二部分,我們將基于最近一篇論文《在連續學習場景中對深度神經網絡進行微調(Fine-Tuning Deep Neural Networksin Continuous Learning Scenarios)》探討 DNN 連續學習,該論文的作者為 Christoph Kading、Erik Rodner、Alexander Freytag 和 Joachim Denzler。

要將深度學習系統投入生產,有一個方面很重要,就是要能應對輸入和輸出數據的分布隨時間的變化。和任何統計機器學習模型一樣,深度神經網絡的可行性和有效性嚴重取決于一個假設——輸入和輸出數據的分布不會隨時間發生顯著變化,否則會使得模型原本學習到的模式和復雜關系表現不佳或甚至完全不可用。但是,在真實世界中,這樣的假設很少能夠成立,尤其是在信息安全等領域,其中基礎數據生成機制的快速演變已然是一種常態(在安全領域的案例中,這是因為防御方和對手這兩方都要不斷努力改變自己的策略以超越對方,從而利用對手未加防備的漏洞。因此,隨著我們在這些領域中應用深度學習來更好解決許多曾經無法解決的問題,深度神經網絡的連續學習問題也就得到了機器學習即服務(MLaaS)提供商和應用架構師的越來越大的關注——我們該怎么很好地執行連續學習,而不會損害生產質量或提高資源消耗。

在本報告的第二部分,我們將會形式化連續學習場景并介紹一種增量式的微調方法(incremental fine-tuning approach)。然后我們會給出有多個實證研究支持的三大重要發現。本文的目的不是全面調查和描繪連續學習的現狀全景,而是為了啟發更多不同專業背景的人加入到我們的討論中,并與我們交流知識。

第二部分:連續學習

連續學習場景和增量式微調

微調(fine-tuning)原本一直是指預訓練一個帶有生成式目標(generative objective)的 DNN 的過程,后面跟著帶有一個鑒別式目標(discriminative objective)的額外訓練階段。早期關于預訓練和微調深度信念網絡和深度堆疊自動編碼器的研究成果全都遵循這種方法。研究者期望這種生成式訓練階段能讓網絡學習到數據域的良好分層表征,而鑒別式階段則能利用這種表征,并希望它能在該表征空間中學習到一個更好的鑒別器功能。

最近,研究者已經在使用微調來在 ImageNet 這樣的大型通用數據集上預訓練復雜精細、當前***的 DNN 了,然后又在更小的相關數據集上對模型進行微調。這有助于緩解醫療診斷或地理探測等領域內有標簽訓練數據不足的問題,因為在這些領域中,獲取有標簽數據需要密集的勞動或成本高昂。研究者的基本假設是:在大型訓練數據集上得到的相當好的結果已經使該網絡接近參數空間中的局部***了,所以即使新數據的數據量很小,也能快速將該網絡引導至***點。

從連續學習的觀點來看,上面兩種方法都是網絡只接受兩次訓練(初始預訓練和一次更新)的極端案例。連續學習的更一般形式是迭代式地訓練和更新,這就帶來了一個問題:應該怎樣穩健又高效地執行一系列持續的更新?對于生產系統來說,穩健性是很重要的,因為一個實時系統通常不能容忍模型表現突然下降,而該系統的實時本質又必需對資源和時間的高效率利用。為此,在下面的討論中,我們的重點關注場景是每個更新步驟僅使用少量新數據的情況(相比于原來的完全的訓練數據集),但要求更新后的模型是即時可用的。

1. 連續學習場景

連續學習的最一般形式是整個訓練數據集都會隨時間演變。但是,為了讓學習可行,我們設置了一個限制,即輸入域保持不變。這并不意味著輸入域中的數據分布是恒定不變的——相反,我們允許多種多樣的數據分布會發生變化的案例,但這些變化總是定義在同一域中。另一方面,我們假設輸入域可以變化。這是為了配合當系統持續運行了相當長時間后出現新標簽的案例。比起輸入域變化的情況,這個假設更有可能實際出現,因為在自動駕駛汽車等大多數生產系統中,如果輸入視頻或激光雷達圖像急劇改變(由于極端天氣、光照、地形或路況),那我們就不能期望系統還能遠程工作;但我們希望該系統能在連續學習過程中適應新型的不可碰撞的目標,并且能夠應對這種新標簽的類別。因此,我們將我們的連續學習場景中的數據定義為按時間 t 索引的數據集![]() 的序列。我們的目標是為每個時間步驟 t 學習一個網絡

的序列。我們的目標是為每個時間步驟 t 學習一個網絡![]() 。根據

。根據![]() 的變化方式,我們有兩種可能場景:

的變化方式,我們有兩種可能場景:

1) 我們不會隨時間獲得新類別,但是我們的數據集不斷增長。

2) 我們會隨時間獲得新類別的樣本。

在每個時間步驟 t,我們需要使用新出現的可用信息更新我們的網絡;這些新信息即為更新集(update set):![]() 。因為我們假設更新集很小,為了避免欠擬合,在時間步驟 t 我們使用上一步收斂的

。因為我們假設更新集很小,為了避免欠擬合,在時間步驟 t 我們使用上一步收斂的![]() 熱啟動(warm-start)優化。這種技術的可行性取決于一個假設,即

熱啟動(warm-start)優化。這種技術的可行性取決于一個假設,即![]() 在數據集擴展時會平滑地改變——因此我們要假設更新步驟小且輸入域恒定。在實際情況中,就算這些假設(部分地)屬實,我們仍還依賴于一個預期:通過在之前一個局部***點的初始化,帶有不同參數空間情況的新優化問題可以快速且穩定地收斂到一個新的局部***點。但是,大多數現代 DNN 都太復雜了,所以難以保證這一點——它們的目標函數是高度非線性和非凸的,有時候參數空間中還都是些糟糕的局部條件數(local condition numbers)。即便如此,熱啟動仍然是目前***的方法之一,肯定比從頭開始更好,而且在實驗上也表現出了***的潛力。對于場景 2,在每個時間步驟,我們都可能需要為***的輸入層添加額外的神經元以及與前一層的連接權重。

在數據集擴展時會平滑地改變——因此我們要假設更新步驟小且輸入域恒定。在實際情況中,就算這些假設(部分地)屬實,我們仍還依賴于一個預期:通過在之前一個局部***點的初始化,帶有不同參數空間情況的新優化問題可以快速且穩定地收斂到一個新的局部***點。但是,大多數現代 DNN 都太復雜了,所以難以保證這一點——它們的目標函數是高度非線性和非凸的,有時候參數空間中還都是些糟糕的局部條件數(local condition numbers)。即便如此,熱啟動仍然是目前***的方法之一,肯定比從頭開始更好,而且在實驗上也表現出了***的潛力。對于場景 2,在每個時間步驟,我們都可能需要為***的輸入層添加額外的神經元以及與前一層的連接權重。

但還存在三個問題。一,每個更新步驟需要多少個 SGD 步驟?二,在每個更新過程中,我們使用多少前一步驟的數據,又使用多少當前步驟的數據?三,這個更新流程是否穩健,能應對標注噪聲嗎?對于生產系統來說,這些問題都很重要,因為正如我們前面談到的,穩健性和效率是很重要的。

實證研究

在實驗中,我們使用了在 ImageNet ILSVRC-2010 上預訓練的 BVLC AlexNet 作為示例網絡。我們將學習率固定為 0.001,L2 權重衰減固定為 0.0005,動量固定為 0.9;并且更新集的大小也固定為![]() ,其中的樣本來自同一類別。對于評估,我們使用了 MS-COCO-full-v0.9 和 Stanford40Actions。相比 ImageNet,這兩個數據集都很小,因為我們想使用比初始預訓練小的更新來評估連續學習的表現。對于 MS-COCO,我們使用了 15 個類別,其中每個包含 500 到 1000 個樣本;每個樣本都僅保留 ground truth 邊界框,且寬和高都至少是 256 像素。為了進行評估,我們隨機選擇了 10 個類來對 CNN 進行初始化微調。從剩余的數據中,我們再隨機選擇 5 個類別用作全新數據(在每個更新步驟輸入的新數據),并且從每個類別隨機選擇了 100 個樣本。每個更新步驟使用的度量都是分類準確度。為了得到無偏差的比較,我們進行了該實驗 9 次。

,其中的樣本來自同一類別。對于評估,我們使用了 MS-COCO-full-v0.9 和 Stanford40Actions。相比 ImageNet,這兩個數據集都很小,因為我們想使用比初始預訓練小的更新來評估連續學習的表現。對于 MS-COCO,我們使用了 15 個類別,其中每個包含 500 到 1000 個樣本;每個樣本都僅保留 ground truth 邊界框,且寬和高都至少是 256 像素。為了進行評估,我們隨機選擇了 10 個類來對 CNN 進行初始化微調。從剩余的數據中,我們再隨機選擇 5 個類別用作全新數據(在每個更新步驟輸入的新數據),并且從每個類別隨機選擇了 100 個樣本。每個更新步驟使用的度量都是分類準確度。為了得到無偏差的比較,我們進行了該實驗 9 次。

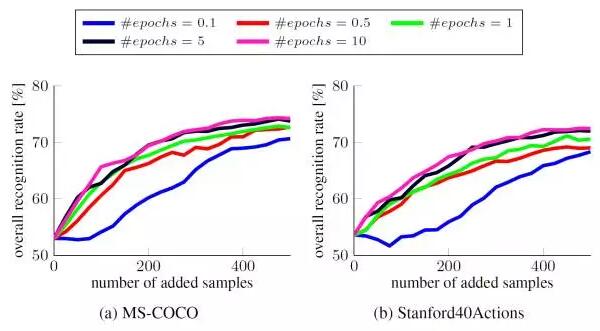

1. 每個更新步驟的 SGD 迭代次數

SGDminibatch 的大小固定為 64,但我們改變了每個更新步驟中 SGD 迭代執行的次數。我們將 SGD 迭代次數表示成了一個相對于總訓練數據大小(即 epoch 數)的比例,以補償不斷增長的訓練數據大小。

讓人驚訝的是,即使每次更新的 SGD 迭代少了很多,分類準確度依然穩健,除了那些僅使用了十分之一數據的案例,很可能是因為在這樣小的 epoch 中一些類別代表不足。事實上,我們可以直接將 SGD 迭代的次數固定為一個小常量(比如更新集大小![]() ),表現也不會顯著下降。

),表現也不會顯著下降。

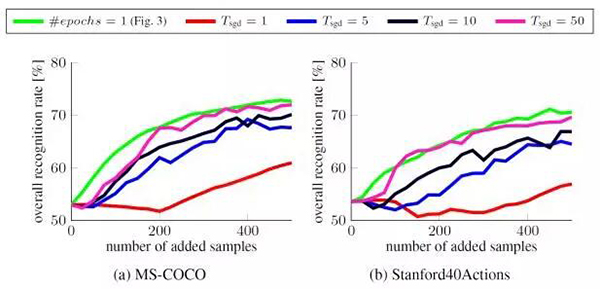

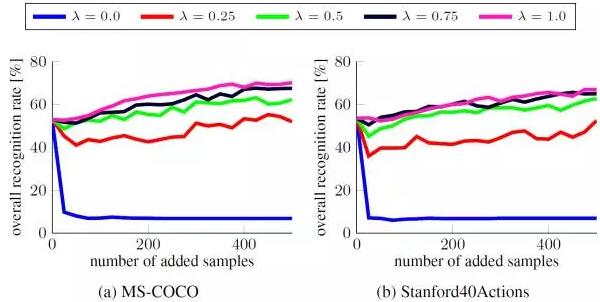

2. 每個更新步驟中舊數據與新數據的比例

對于增量式的學習算法,舊數據與新數據的影響的比例是最重要的超參數之一。在 SGD 迭代中,我們根據概率![]() 對每個樣本 i 進行了采樣,其中 0≤λ≤1。在極端情況下,λ=0 意味著之前的數據完全被忽視了,而 λ=1 則表示新數據的影響推遲到了下一個更新步驟,因為這是它們在

對每個樣本 i 進行了采樣,其中 0≤λ≤1。在極端情況下,λ=0 意味著之前的數據完全被忽視了,而 λ=1 則表示新數據的影響推遲到了下一個更新步驟,因為這是它們在![]() 中結束的時候。

中結束的時候。

我們看到,為了防止在更小的更新集上過擬合,就必需舊數據。我們觀察到一個有趣的結果:因為新的更新集數據被認為是下一步驟 t 中![]() 的一部分,因此 λ=0.75 和 λ=1 的表現差不多。

的一部分,因此 λ=0.75 和 λ=1 的表現差不多。

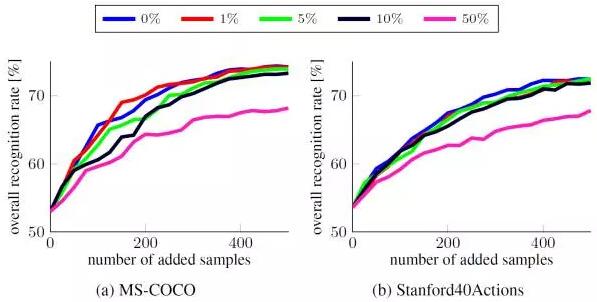

3. 在有標注噪聲時保持穩健

在生產場景中,新數據的標簽很少是無噪聲的——由于實時性需求,人類判斷者往往需要做出快但并不準確的決定,而三到五位判斷者之間的不一致率可能會高達 75%。因此,在有標注噪聲時保持穩健對于連續學習方案而言至關重要。

我們使用 64 的 minibatch 大小在每個更新步驟執行了 10 epoch,并隨機污染固定比例的新可用數據——用剩余類別的樣本替換這些數據,但同時保持它們的標簽不變。如預期一樣,標注噪聲會降低準確度,但我們的連續學習方案對此相對穩健,在存在 10% 的噪聲時準確度僅下降了 2%。

作者 Yanchen 畢業于普林斯頓大學機器學習方向,現就職于微軟Redmond總部,從事大規模分布式機器學習和企業級AI研發工作。

【本文是51CTO專欄機構“機器之心”的原創文章,微信公眾號“機器之心( id: almosthuman2014)”】