6個高效的語言處理Python庫,你用過幾個?

最近一段時間Python已經成為數據科學行業中大火的編程語言,今天技術學派收集了一些較為高效的語言處理Python庫。下面分享給大家。

1.NLTK

NLTK是構建Python程序以處理人類語言數據的領先平臺。它提供了易于使用的界面,以及用于分類、標記化、詞干化、標記、分析和語義推理的一套文本處理庫。用于工業強度NLP庫的包裝器。

項目地址:http://www.nltk.org/

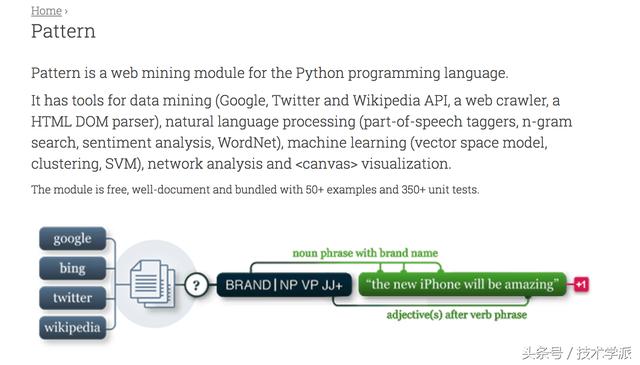

2.Pattern

Pattern是Python編程語言的Web挖掘模塊。它多有用于數據挖掘、自然語言處理、機器學習網絡分析和<canvas>可視化。

3.Jieba

“結巴”中文分詞:做***的 Python 中文分詞組件。精確模式,試圖將句子最精確地切開,適合文本分析;全模式,把句子中所有的可以成詞的詞語都掃描出來, 速度非常快,但是不能解決歧義;搜索引擎模式,在精確模式的基礎上,對長詞再次切分,提高召回率,適合用于搜索引擎分詞。

4.TextBlob

TextBlob是一個用于處理文本數據的Python庫。它提供了一個簡單的API用于常見的自然語言處理(NLP)任務,如詞性標注,名詞短語提取,情感分析,分類,翻譯等。

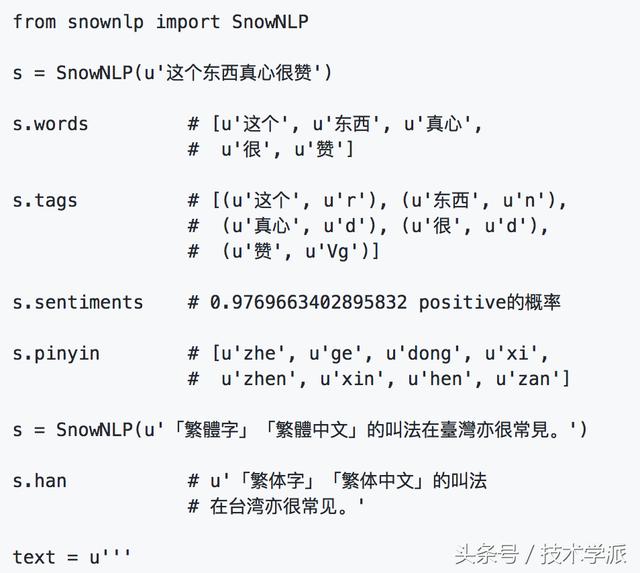

5.SnowNLP

SnowNLP是一個python寫的類庫,可以方便的處理中文文本內容,是受到了TextBlob的啟發而寫的,由于現在大部分的自然語言處理庫基本都是針對英文的,于是寫了一個方便處理中文的類庫,并且和TextBlob不同的是,這里沒有用NLTK,所有的算法都是自己實現的,并且自帶了一些訓練好的字典。注意本程序都是處理的unicode編碼,所以使用時請自行decode成unicode。

6.TextGrocery

TextGrocery是一個基于LibLinear和結巴分詞的短文本分類工具,特點是高效易用,同時支持中文和英文語料。