量化評估、算法拓展:強化學習研究的10大原則

大數據文摘出品

編譯:蔣寶尚

今年9月份舉辦的深度學習Indaba2018峰會的干貨確實不少,昨天文摘菌給大家整理了27位大咖關于自然語言處理的精彩問答。今天文摘菌再給大家整理一份關于強化學習的10個原則,不僅在強化學習中有用,在機器學習研究中也能夠提供一些參考。

這10個原則是一位來自Insight數據分析研究中心的博士生Sebastian Ruder在參會期間對David Silver報告進行的整理,除了Ruder自己的解析外,也把他自己拍的照片分享了出來。

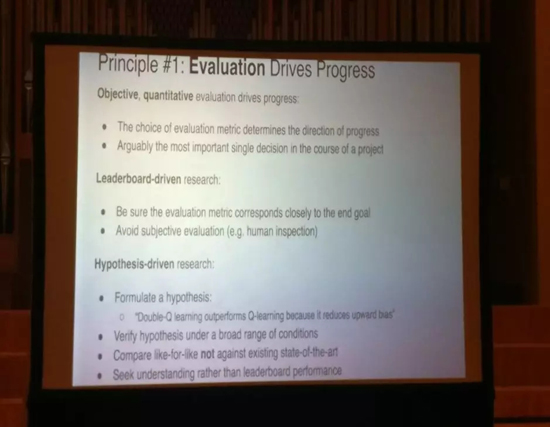

1. 評估推動進步

量化的評估才能推動進步。評估獎勵的選擇決定了進步的方向,要確保評估指標與目標密切相關,避免主觀評價(例如人類學科)。還有一點,雙Q學習優于單Q學習,因為后者能減少偏見。

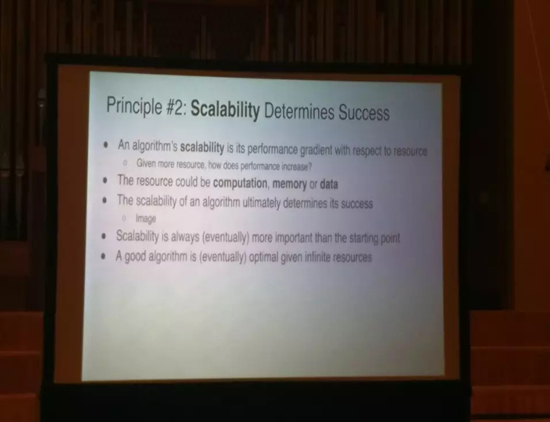

2. 算法的可擴展性決定成功

算法如何擴展非常重要,要避免性能上限。深度學習非常棒,因為它可以有效地擴展,但是樣本效率同樣重要。

算法的可擴展性的表現取決于資源,而算法的可擴展性決定是否成功:那么給予更多資源,性能如何提高?值得一提的是,這里的資源指的是計算,內存或數據。

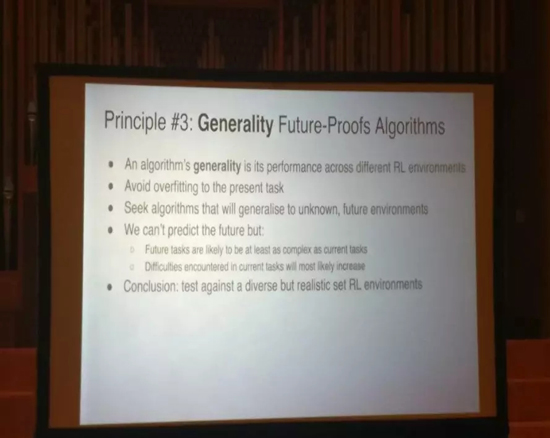

3. 通用性,即算法在其他任務上的表現非常重要

關鍵是要設計一系列具有挑戰性的任務,即應該對不同的新任務進行評估。避免過度使用當前的任務。

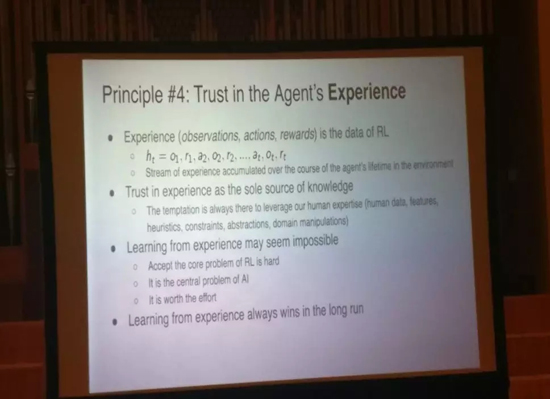

4. 相信Agent的經驗

不要依賴人類的專業知識,不要依賴于工程特征。在數據有限時,領域專業知識和歸納偏差非常重要。

一些任務可能看起來不太可能完成,但是,你確實能在其中學到很多經驗。這種任務或者項目,通常滿足這三點:

- 很難接受RL的核心問題。

- 是AI的核心問題

- 非常值得你去努力

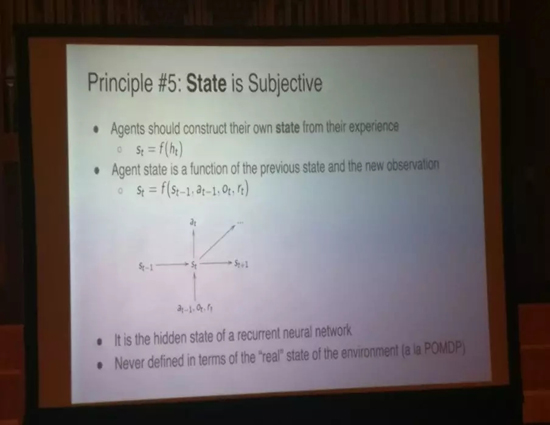

5. 狀態應該是主觀的

應將狀態建立為模型的狀態,即RNN的隱藏狀態,而不是根據環境定義。只有agent對世界的主觀看法才是重要的。不要推理外部現實,因為達到的效果非常有限。

6. 控制流

Agent影響數據流和體驗。Agent應該有能夠訪問控制環境的功能。重點不僅在于***化獎勵,還在于建立對流的控制。

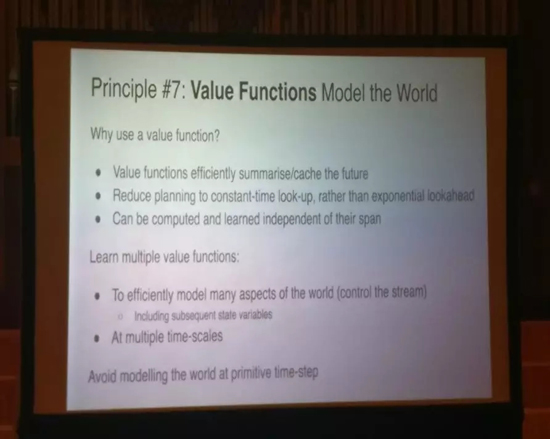

7. 價值函數塑造世界

價值函數有效地總結了當前和未來的狀況。多值函數允許我們模擬世界的多個方面。可以幫助控制流。

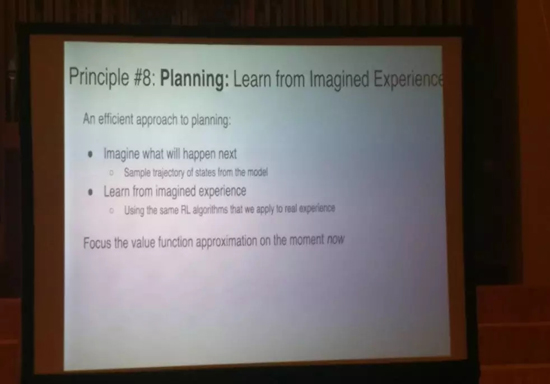

8. 從想象的經驗(imagined experience)中學習

接下來該怎樣規劃?同樣的,RL算法可以從想象的經驗(imagined experience)中學習,如Alphago中使用MCTS和值函數。

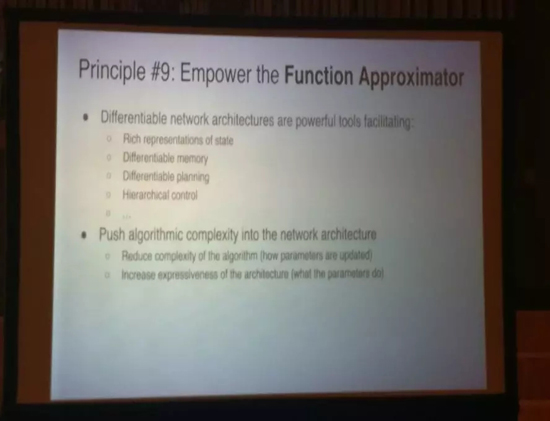

9. 利用函數逼近器

可以將算法復雜度揉進神經網絡架構,甚至MCTS,分層控制等也可以用NN建模。然后要真正理解:我們從模型學到了什么。

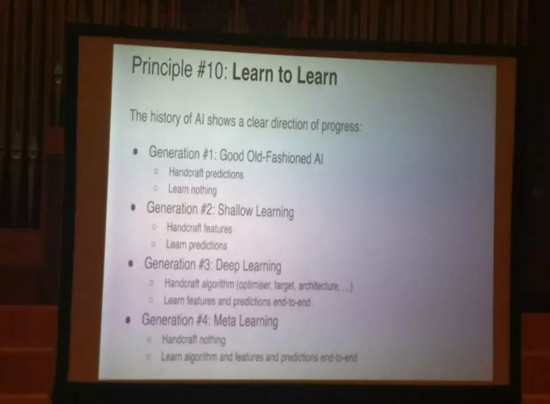

10. 學會學習

必須精通元學習,然后,你可能不再需要手工設置網絡架構,一切都是端到端學習。總而言之,神經網絡要通過盡可能少的人工干預來處理事情。但是,歸納偏差應該仍然有用。

相關報道:

https://twitter.com/seb_ruder/status/1040235236284669952?utm_campaign=NLP%20News&utm_medium=email&utm_source=Revue%20newsletter

【本文是51CTO專欄機構大數據文摘的原創譯文,微信公眾號“大數據文摘( id: BigDataDigest)”】